python爬虫入门--Beautiful Soup库介绍及实例

整理自:北理工嵩天老师的网络课程。

1、Beautiful Soup库基础知识

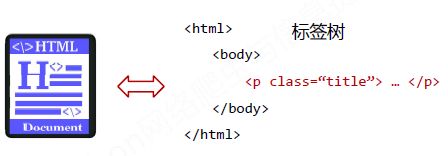

(1)Beautiful Soup库的理解

Beautiful Soup库是解析、遍历、维护“标签树”的功能库。

BeautifulSoup对应一个HTML/XML文档的全部内容。

(2)Beautiful Soup库解析器

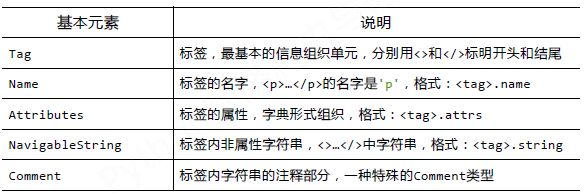

(3)BeautifulSoup类的基本元素

a. Tag 标签.

任何存在于HTML语法中的标签都可以用soup.

当HTML文档中存在多个相同

示例代码如下:

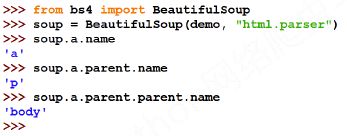

b. Tag的name.

每个

示例代码如下:

c. Tag的attrs.

一个

示例代码如下:

d. Tag的NavigableString.

NavigableString可以跨越多个层次。

示例代码如下:

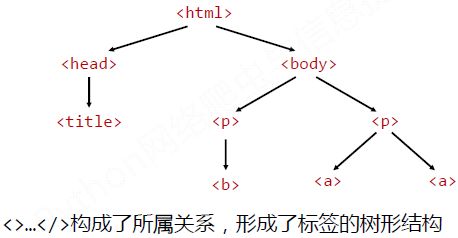

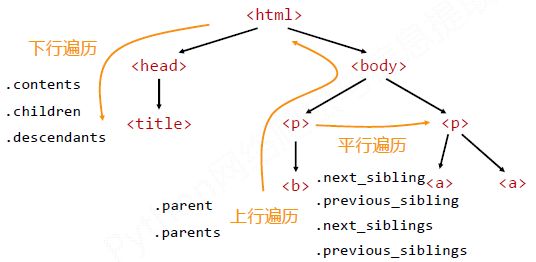

(4)基于bs4库的HTML内容遍历方法

a. HTML基本格式

b. 标签树的下行遍历

遍历儿子节点:

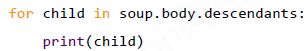

遍历子孙节点:

c. 标签树的上行遍历

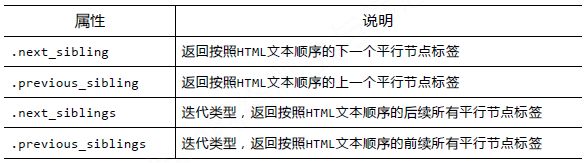

d. 标签树的上行遍历

总结如下图:

(5)bs4库的prettify()方法--让HTML内容更加“友好”的显示

prettify()为HTML文本<>及其内容增加更加'\n'

显示效果如下:

2、信息标记与提取方法

(1)信息标记的三种方式

a. XML实例

b. JSON实例

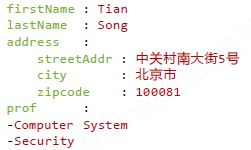

c. YAML实例

三种信息标记形式的比较:

XML最早的通用信息标记语言,可扩展性好,但繁琐。Internet上的信息交互与传递。

JSON信息有类型,适合程序处理(js),较XML简洁。 移动应用云端和节点的信息通信,无注释。

YAML信息无类型,文本信息比例最高,可读性好。 各类系统的配置文件,有注释易读。

(2)信息提取

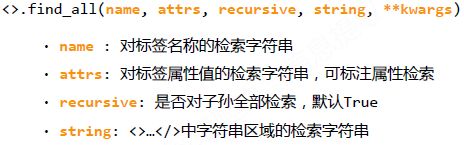

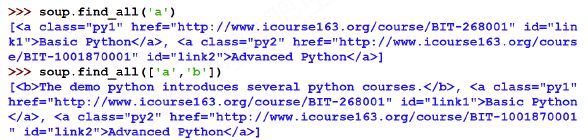

Beautiful Soup库提供了<>.find_all()函数,返回一个列表类型,存储查找的结果。

示例代码如下:

扩展方法如下:

3. Beautiful Soup库实例--&&中文对齐问题的解决

功能描述:

输入:大学排名URL链接

输出:大学排名信息的屏幕输出(排名,大学名称,总分)

技术路线:requests‐bs4

定向爬虫:仅对输入URL进行爬取,不扩展爬取

程序的结构设计:

步骤1:从网络上获取大学排名网页内容 getHTMLText()

步骤2:提取网页内容中信息到合适的数据结构 fillUnivList()

步骤3:利用数据结构展示并输出结果 printUnivList()

输出结果如下:

源代码如下:

import requests

from bs4 import BeautifulSoup

import bs4

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

def fillUnivList(ulist, html):

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children: #遍历表签树

if isinstance(tr, bs4.element.Tag):

tds = tr('td') #简写,等价于下一行代码

#tds = tr.find_all('td')

ulist.append([tds[0].string, tds[1].string, tds[2].string,tds[3].string])

def printUnivList(ulist, num):

tplt = "{0:^10}\t{1:{4}^8}\t{2:6}\t{3:10}"

print(tplt.format("排名","学校名称","城市","总分",chr(12288)))

for i in range(num):

u=ulist[i]

print(tplt.format(u[0],u[1],u[2],u[3],chr(12288)))

def main():

uinfo = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html'

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 20) # 20 univs

main()

中文对齐问题的原因:

当中文字符宽度不够时,采用西文字符填充;中西文字符占用宽度不同。

解决方法:

采用中文字符的空格填充chr(12288)