Ubuntu16.04 CUDA8.0+caffe+gpu运行环境配置

完成win10+ubuntu 16.04双系统的安装后,开始在ubuntu16.04系统上安装nVidia驱动,配置cuda,cudnn运行环境,并完成caffe成功配置+MNIST数据库测试。现在写下博客记录安装配置过程,以及对配置过程中遇到的错误提供解决办法,避免今后再配置caffe时又踩坑。

电脑配置

系统:Ubuntu16.04

GPU:NVIDIA GTX1070

一、安装nVidia驱动,配置cuda,cudnn运行环境

1.安装相关依赖项

sudo apt-get install libprotobuf-dev libleveldb-dev libsnappy-dev> libopencv-dev libhdf5-serial-dev protobuf-compiler

sudo apt-get install --no-install-recommends libboost-all-dev

sudo apt-get install libopenblas-dev liblapack-dev libatlas-base-dev

sudo apt-get install libgflags-dev libgoogle-glog-dev liblmdb-dev如果安装错误,重新运行代码即可,保证网络畅通。

2.安装NVIDIA驱动

(1)查询NVIDIA驱动

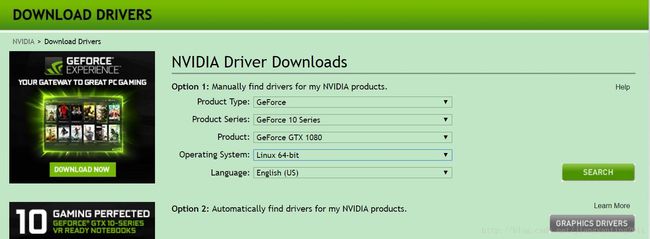

首先去官网(http://www.nvidia.com/Download/index.aspx?lang=en-us)查看适合自己显卡的驱动:

驱动文件后缀名应当是以.run结尾的。把这个文件移动到home目录下。

我的显卡型号是GTX1070,系统是linux 64位,按照要求选择后点击search.,点击下载就好了。我下载后的驱动文件是:NVIDIA-Linux-x86_64-384.98.run。

更新:后面测试MNIST数据库时发现报了一个错,怀疑是驱动版本太新的问题,因此我又卸载了384.98,重新安装了375.82。在www.geforce.cn/drivers 下可以选择适合GTX1070的不同驱动版本,我选择了375.82。

(2)安装驱动

在终端下输入:sudo gedit /etc/modprobe.d/blacklist.conf

输入密码后在最后一行加上 blacklist nouveau 。这里是将Ubuntu自带的显卡驱动加入黑名单。

在终端输入:sudo update-initramfs -u

重启电脑~ 这里要尤其注意,安装显卡驱动要先切换到文字界面,(按Ctrl+Alt+F1~F6)。所以,启动电脑后,先进入文字界面。

然后,输入命令sudo service lightdm stop,关闭X-Win窗口。

现在可以安装驱动了,先进入家目录 cd ~ ,然后:sudo ./NVIDIA-Linux-x86_64-384.98.run,按照提示一步步来。若是没能安装,可能是权限问题, chmod 777NVIDIA-Linux-x86_64-384.98.run 修改权限后再安装。

完成后,再次重启电脑。(或者输入命令sudo service lightdm start,打开X-Win窗口,然后ALT+CTRL+F7切换回图形界面即可。)

安装完成之后输入以下指令进行验证:sudo nvidia-smi,若列出了GPU的信息列表则表示驱动安装成功。

tips:

按ALT+CTRL+F1切换到字符界面(Linux实体机)

按ALT+CTRL+F7切换到图形界面(Linux实体机)

3.安装CUDA

CUDA是NVIDIA的编程语言平台,想使用GPU就必须要使用cuda。

(1)下载CUDA

首先在官网上(https://developer.nvidia.com/cuda-downloads)下载CUDA,选择自己合适的版本。

该链接界面只显示最新版本。若需要下载以前的版本,可在页面下方点击Legacy Releases,选择自己需要的其他版本。

图2.CUDA下载

(2)安装CUDA

下载完成后执行以下命令:

sudo chmod 777 cuda_8.0.44_linux.run

sudo ./cuda_8.0.44_linux.run(注意:执行后会先出现一个声明,需要阅读到100%,同意声明后才会开始安装。)

安装时首先会有一系列提示让你确认,但是注意,有个让你选择是否安装nvidia361驱动时,一定要选择否:

Install NVIDIA Accelerated Graphics Driver for Linux-x86_64 361.62?因为前面我们已经安装了更加新的nvidia384,所以这里不要选择安装。其余的都直接默认或者选择是即可。

可能出现的错误:

安装cuda时可能有下面的信息

Installing the CUDA Toolkit in /usr/local/cuda-8.0 …

Missing recommended library: libGLU.so

Missing recommended library: libX11.so

Missing recommended library: libXi.so

Missing recommended library: libXmu.so

原因是缺少相关的依赖库,安装相应库就解决了:

sudo apt-get install freeglut3-dev build-essential libx11-dev libxmu-dev libxi-dev libgl1-mesa-glx libglu1-mesa libglu1-mesa-dev再次安装,就不再提示了。

(3)环境变量配置

打开~/.bashrc文件: sudo gedit ~/.bashrc 将以下内容写入到~/.bashrc尾部:

export PATH=/usr/local/cuda-8.0/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-8.0/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}(4)测试CUDA的samples

cd /usr/local/cuda-8.0/samples/1_Utilities/deviceQuery

make

sudo ./deviceQuery如果显示一些关于GPU的信息,则说明安装成功。

4.配置cuDNN

注意:首次配置cuDNN时我是下载的cuDNN6.0版本,但是后来在编译fast rcnn及SSD时发现有很多问题是由于cuDNN版本不匹配引起的,因此后来又手动删除掉了cuDNN6.0的include和lib文件,重新下载cuDNN5.1版本并重新编译caffe。

cuDNN是GPU加速计算深层神经网络的库。 首先去官网https://developer.nvidia.com/rdp/cudnn-download 下载cuDNN,需要注册一个账号才能下载。

下载cuDNN5.1 之后进行解压:

sudo tar -zxvf ./cudnn-8.0-linux-x64-v5.1.tgz进入cuDNN5.1 解压之后的include目录,在命令行进行如下操作:

cd cuda/include

sudo cp cudnn.h /usr/local/cuda/include #复制头文件再进入lib64目录下的动态文件进行复制和链接:

(这里的libcudnn.so.5.1.10是固有文件,而libcudnn.so.5是libcudnn.so.5.1.10链接得到的动态文件,libcudnn.so是libcudnn.so.5链接得到的动态文件。)

cd ..

cd lib64

sudo cp lib* /usr/local/cuda/lib64/ #复制动态链接库cd /usr/local/cuda/lib64/

sudo rm -rf libcudnn.so libcudnn.so.5 #删除原有动态文件sudo ln -s libcudnn.so.5.1.10 libcudnn.so.5 #生成软衔接(注意这里要和自己下载的cudnn版本对应,可以在/usr/local/cuda/lib64下查看自己libcudnn的版本)

sudo ln -s libcudnn.so.5 libcudnn.so #生成软链接注意:下面这个步骤不能缺少!!否则可能链接失败!

执行

sudo ldconfig -v #必须在/usr/local/cuda/lib64/目录下执行,否则可能会报libcudnn.so.5: cannot open shared object file: No such file or directory或者

sudo ldconfig /usr/local/cuda/lib64至此,cudnn就配置完成了。

5.安装opencv3.3.0

从opencv官网找到GitHub的下载链接,下载Opencv,并将其解压到你要安装的位置,假设解压到了~/opencv。

安装前准备,创建编译文件夹:

cd ~/opencv

mkdir build

cd build 配置:

sudo apt install cmake

sudo cmake -D CMAKE_BUILD_TYPE=Release -D CMAKE_INSTALL_PREFIX=/usr/local .. 编译:

sudo make -j8-j8表示并行计算,根据自己电脑的配置进行设置,配置比较低的电脑可以将数字改小或不使用,直接输make。

安装: 以上只是将opencv编译成功,还没将opencv安装,需要运行下面指令进行安装:

sudo make install二、安装Anaconda*

python好用,但是python不同版本和各种包管理很让人头疼。Anaconda是一个python的一个包装,它将一些python常用的package打包,方便pythoners直接使用。不但如此,他还有自己的安装方式conda,这里有提供各种pip里面找不到的包。

anaconda安装参照官网下载安装即可https://www.anaconda.com/download/,傻瓜式安装非常方便

安装之后在命令终端输入

$ python

Python 2.7.14 |Anaconda custom (64-bit)| (default, Oct 16 2017, 17:29:19)

[GCC 7.2.0] on linux2

Type "help", "copyright", "credits" or "license" for more information.

>>> 出现上述信息,说明安装成功

重要提示:有一些软件需要py2.7的环境,比如XX-Net, 最好是先安装Anaconda2,这样系统默认的环境是py2,然后再安装Anaconda3。需要py3环境时,用 下面命令切换。

source activate py3三、配置caffe*

(1)将终端cd到要安装caffe的位置。

(2)从github上获取caffe:

git clone https://github.com/BVLC/caffe.git注意:若没有安装Git,需要先安装Git:

sudo apt-get install git(3)因为make指令只能make Makefile.config文件,而Makefile.config.example是caffe给出的makefile例子,因此,首先将Makefile.config.example的内容复制到Makefile.config:

sudo cp Makefile.config.example Makefile.config(4)打开并修改配置文件:

sudo gedit Makefile.config #打开Makefile.config文件根据个人情况修改文件:

a.若使用cudnn,则

将

#USE_CUDNN := 1

修改成:

USE_CUDNN := 1b.若使用的opencv版本是3的,则

将

#OPENCV_VERSION := 3

修改为:

OPENCV_VERSION := 3c.若要使用python来编写layer,则

将

#WITH_PYTHON_LAYER := 1

修改为

WITH_PYTHON_LAYER := 1d. 重要的一项 :

将# Whatever else you find you need goes here.下面的

INCLUDE_DIRS := $(PYTHON_INCLUDE) /usr/local/include

LIBRARY_DIRS := $(PYTHON_LIB) /usr/local/lib /usr/lib

修改为:

INCLUDE_DIRS := $(PYTHON_INCLUDE) /usr/local/include /usr/include/hdf5/serial

LIBRARY_DIRS := $(PYTHON_LIB) /usr/local/lib /usr/lib /usr/lib/x86_64-linux-gnu /usr/lib/x86_64-linux-gnu/hdf5/serial 这是因为ubuntu16.04的文件包含位置发生了变化,尤其是需要用到的hdf5的位置,所以需要更改这一路径。

这里贴出我修改后的Makefile.config文件:

## Refer to http://caffe.berkeleyvision.org/installation.html

# Contributions simplifying and improving our build system are welcome!

# cuDNN acceleration switch (uncomment to build with cuDNN).

USE_CUDNN := 1 #使用cuDNN

# CPU-only switch (uncomment to build without GPU support).

# CPU_ONLY := 1

# uncomment to disable IO dependencies and corresponding data layers

# USE_OPENCV := 0

# USE_LEVELDB := 0

# USE_LMDB := 0

# uncomment to allow MDB_NOLOCK when reading LMDB files (only if necessary)

# You should not set this flag if you will be reading LMDBs with any

# possibility of simultaneous read and write

# ALLOW_LMDB_NOLOCK := 1

# Uncomment if you're using OpenCV 3

OPENCV_VERSION := 3 #使用openCV3

# To customize your choice of compiler, uncomment and set the following.

# N.B. the default for Linux is g++ and the default for OSX is clang++

# CUSTOM_CXX := g++

# CUDA directory contains bin/ and lib/ directories that we need.

CUDA_DIR := /usr/local/cuda #CUDA路径

# On Ubuntu 14.04, if cuda tools are installed via

# "sudo apt-get install nvidia-cuda-toolkit" then use this instead:

# CUDA_DIR := /usr

# CUDA architecture setting: going with all of them.

# For CUDA < 6.0, comment the *_50 through *_61 lines for compatibility.

# For CUDA < 8.0, comment the *_60 and *_61 lines for compatibility.

# For CUDA >= 9.0, comment the *_20 and *_21 lines for compatibility.

CUDA_ARCH := -gencode arch=compute_20,code=sm_20 \

-gencode arch=compute_20,code=sm_21 \

-gencode arch=compute_30,code=sm_30 \

-gencode arch=compute_35,code=sm_35 \

-gencode arch=compute_50,code=sm_50 \

-gencode arch=compute_52,code=sm_52 \

-gencode arch=compute_60,code=sm_60 \

-gencode arch=compute_61,code=sm_61 \

-gencode arch=compute_61,code=compute_61 #计算能力

# BLAS choice:

# atlas for ATLAS (default)

# mkl for MKL

# open for OpenBlas

BLAS := atlas #使用哪种BLAS:atlas or mkl or openblas

# Custom (MKL/ATLAS/OpenBLAS) include and lib directories.

# Leave commented to accept the defaults for your choice of BLAS

# (which should work)!

# BLAS_INCLUDE := /path/to/your/blas

# BLAS_LIB := /path/to/your/blas

# Homebrew puts openblas in a directory that is not on the standard search path

# BLAS_INCLUDE := $(shell brew --prefix openblas)/include

# BLAS_LIB := $(shell brew --prefix openblas)/lib

# This is required only if you will compile the matlab interface.

# MATLAB directory should contain the mex binary in /bin.

# MATLAB_DIR := /usr/local

# MATLAB_DIR := /Applications/MATLAB_R2012b.app

# NOTE: this is required only if you will compile the python interface.

# We need to be able to find Python.h and numpy/arrayobject.h.

# PYTHON_INCLUDE := /usr/include/python2.7 \

# /usr/lib/python2.7/dist-packages/numpy/core/include

# Anaconda Python distribution is quite popular. Include path:

# Verify anaconda location, sometimes it's in root.

ANACONDA_HOME := $(HOME)/anaconda2 #使用anaconda,anaconda的路径

PYTHON_INCLUDE := $(ANACONDA_HOME)/include \

$(ANACONDA_HOME)/include/python2.7 \

$(ANACONDA_HOME)/lib/python2.7/site-packages/numpy/core/include #anaconda的python头文件路径

# Uncomment to use Python 3 (default is Python 2)

# PYTHON_LIBRARIES := boost_python3 python3.5m

# PYTHON_INCLUDE := /usr/include/python3.5m \

# /usr/lib/python3.5/dist-packages/numpy/core/include

# We need to be able to find libpythonX.X.so or .dylib.

# PYTHON_LIB := /usr/lib

PYTHON_LIB := $(ANACONDA_HOME)/lib #anaconda的python库目录

# Homebrew installs numpy in a non standard path (keg only)

# PYTHON_INCLUDE += $(dir $(shell python -c 'import numpy.core; print(numpy.core.__file__)'))/include

# PYTHON_LIB += $(shell brew --prefix numpy)/lib

# Uncomment to support layers written in Python (will link against Python libs)

WITH_PYTHON_LAYER := 1 #使用python层

# Whatever else you find you need goes here.

INCLUDE_DIRS := $(PYTHON_INCLUDE) /usr/local/include /usr/include/hdf5/serial #头文件路径

LIBRARY_DIRS := $(PYTHON_LIB) /usr/local/lib /usr/lib /usr/lib/x86_64-linux-gnu /usr/lib/x86_64-linux-gnu/hdf5/serial #库路径

# If Homebrew is installed at a non standard location (for example your home directory) and you use it for general dependencies

# INCLUDE_DIRS += $(shell brew --prefix)/include

# LIBRARY_DIRS += $(shell brew --prefix)/lib

# NCCL acceleration switch (uncomment to build with NCCL)

# https://github.com/NVIDIA/nccl (last tested version: v1.2.3-1+cuda8.0)

# USE_NCCL := 1

# Uncomment to use `pkg-config` to specify OpenCV library paths.

# (Usually not necessary -- OpenCV libraries are normally installed in one of the above $LIBRARY_DIRS.)

# USE_PKG_CONFIG := 1

# N.B. both build and distribute dirs are cleared on `make clean`

BUILD_DIR := build

DISTRIBUTE_DIR := distribute

# Uncomment for debugging. Does not work on OSX due to https://github.com/BVLC/caffe/issues/171

# DEBUG := 1

# The ID of the GPU that 'make runtest' will use to run unit tests.

TEST_GPUID := 0 #GPU编号

# enable pretty build (comment to see full commands)

Q ?= @(5)修改makefile文件

打开makefile文件,做如下修改:

将:

NVCCFLAGS +=-ccbin=$(CXX) -Xcompiler-fPIC $(COMMON_FLAGS)

替换为:

NVCCFLAGS += -D_FORCE_INLINES -ccbin=$(CXX) -Xcompiler -fPIC $(COMMON_FLAGS)(6)编辑/usr/local/cuda/include/host_config.h

将其中的第115行注释掉:

将

#error-- unsupported GNU version! gcc versions later than 4.9 are not supported!

改为

//#error-- unsupported GNU version! gcc versions later than 4.9 are not supported!(7)编译

make all -j8 #-j根据自己电脑配置决定编译过程中可能会出现如下错误:

错误内容1:

"fatal error: hdf5.h: 没有那个文件或目录"解决办法:

step1:在Makefile.config文件的第85行,添加/usr/include/hdf5/serial/ 到 INCLUDE_DIRS,也就是把下面第一行代码改为第二行代码。

将:

INCLUDE_DIRS := $(PYTHON_INCLUDE) /usr/local/include

替换为:

INCLUDE_DIRS := $(PYTHON_INCLUDE) /usr/local/include /usr/include/hdf5/serial/stept2:在Makefile文件的第173行,把 hdf5_hl 和hdf5修改为hdf5_serial_hl 和 hdf5_serial,也就是把下面第一行代码改为第二行代码。

将:

LIBRARIES += glog gflags protobuf boost_system boost_filesystem m hdf5_hl hdf5

改为:

LIBRARIES += glog gflags protobuf boost_system boost_filesystem m hdf5_serial_hl hdf5_serial错误内容2:

"libcudart.so.8.0 cannot open shared object file: No such file or directory"解决办法是将一些文件复制到/usr/local/lib文件夹下:

#注意自己CUDA的版本号!

sudo cp /usr/local/cuda-8.0/lib64/libcudart.so.8.0 /usr/local/lib/libcudart.so.8.0 && sudo ldconfig

sudo cp /usr/local/cuda-8.0/lib64/libcublas.so.8.0 /usr/local/lib/libcublas.so.8.0 && sudo ldconfig

sudo cp /usr/local/cuda-8.0/lib64/libcurand.so.8.0 /usr/local/lib/libcurand.so.8.0 && sudo ldconfig(8)测试

make runtest可能遇到的错误:

"libprotobuf.so.14 cannot open shared object file: No such file or directory"输入 protoc –version 发现可以输出libprotoc的版本号,说明protobuf已经安装成功,因此应该是安装路径没有加入到配置中,找不到链接库的路径。查看发现libprotobuf.so.14已经安装在/usr/local/lib里。

注意:库搜索路径的设置有两种方式:在环境变量 LD_LIBRARY_PATH 中设置以及在 /etc/ld.so.conf 文件中设置。

一般有几种解决办法:

a. sudo gedit /etc/ld.so.conf,在文件末尾添加:

/usr/local/lib

然后:sudo ldconfig

b. sudo gedit /etc/profile,在文件末尾添加:

LD_LIBRARY_PATH=/usr/local/lib:$LD_LIBRARY_PATH

然后:sudo ldconfig

c. 用ln将需要的so文件链接到/usr/lib或者/lib这两个默认的目录下边:

ln -s /where/you/install/lib/*.so /usr/lib

sudo ldconfig

若是尝试了这些方法后问题还没解决,重启电脑。

如果运行之后出现下图,说明caffe配置成功。

图6.caffe测试结果

到此caffe配置完毕!

四、MNIST数据集测试

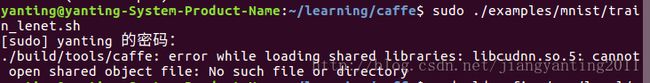

配置caffe完成后,最好利用MNIST数据集对caffe进行测试,以确定caffe是否配置好能正常运行了,再去运行其他深度学习代码。MNIST数据集测试过程如下:

1.将终端定位到Caffe根目录

cd ~/learning/caffe2.下载MNIST数据库并解压缩

./data/mnist/get_mnist.sh3.将其转换成Lmdb数据库格式

./examples/mnist/create_mnist.sh4.训练网络

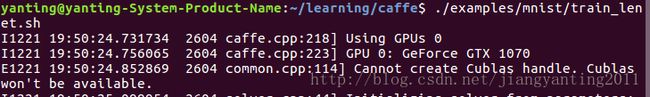

./examples/mnist/train_lenet.sh关于这个错误,上网搜索后发现,有人说“是因为显卡驱动版本不匹配导致的。也有可能是因为没有权限,加上sudo后重试若问题仍没有解决,则要重装低版本的驱动”。

不确定是驱动问题还是cudnn链接库问题,我的解决办法是:

卸载所有驱动,然后重装375.82.版本驱动,如前面安装显卡驱动部分所说。然后再测试MNIST,发现同样的问题。最后,看到博客里有人的评论,尝试命令

sudo ldconfig /usr/local/cuda/lib64 #重要!!指明了lib的路径问题解决。得到MNIST训练结果。

原因猜测:这个问题应该不是驱动版本的问题,而是cudnn没有找到链接库的问题。虽然前面都按照要求把cudnn的include文件和lib文件加入到/usr/local/cuda/里了,但是执行 sudo ldconfig -v 时命令没有在/usr/local/cuda/lib64目录下执行,因此没能找到cudnn的链接库。

训练的时候可以看到损失与精度数值,如下图:

图7.MNIST数据集训练

可以看到最终训练精度是0.9914。

至此,运行环境配置完成。下次我们就可以开始安装运行一些最近的深度学习代码了!