Event Detection via Gated Multilingual Attention Mechanism(中文翻译)

通过门控多语言注意机制的事件检测

事件检测(ED)的目标是在纯文本中识别特定类型的事件实例。具体来说,给定一个句子时,ED需要决定该句子是否包含感兴趣的事件。如果是这样,它还需要识别特定的事件类型,并为每个事件定位事件触发器。以下面的句子为例:

In Baghdad, a cameraman died when an American tank fired on the Palestine hotel.

在巴格达,一名摄影师在美军坦克向巴勒斯坦酒店开炮时死亡。

根据ACE 2005注释指南,这里提到了两个事件:一个由“死亡”触发的Die事件,以及由“触发”触发的攻击事件。一个ED系统应该能够识别所有的。建立一个强健的ED系统具有挑战性。根据(Ji和Grishman 2008),人类注释者在ACE 2005评估任务中只能获得大约73%的F1得分。

到目前为止,许多方法(Li,Ji和Huang,2013; Chen等,2015; 2017; Nguyen和Grishman,2015; 2016; Liu等,2016; 2017; Feng等,2016)已经提出并获得了最先进的性能。然而,这些方法中的大多数都是单语的方法,并且只关注于在单语数据中挖掘文本线索。我们认为,至少有两个问题阻碍了他们的表现:

单语歧义。单语歧义是在ED任务中出现的另一个问题。一方面,相同的事件可以用完全不同的表达方式来描述,它们有不同的触发词。另一方面,同一个词可以表达完全不同的事件。为了说明这一点,请考虑以下句子:

s1: An American tank fired on the Palestine hotel.

s2: Two airline pilots were reportedly fired for stripping down.

s1:一个美国坦克向巴勒斯坦旅馆开火。

s2:据报道,两名航空公司飞行员被解雇。

s1和s2都包含一个单词“触发”,表示事件正在发生。然而,在s1中,“开火”的意思是“放枪(或其他武器)”并触发攻击事件。在s2中,“解雇”意味着“解雇(员工)”,这触发了终止职位的事件。具体的事件类型是完全不同的。歧义是英语文学中的一个普遍现象。对于定量测量,我们研究了ACE 2005中的注释事件,并观察到57%的触发词含糊不清,这使识别和分类事件具有挑战性。

本文提出了一种新颖的多语言方法,即“门控多语言”(GMLATT)框架,同时解决上述两个问题。我们认为,与单语方法相比,多语言方法可以利用两种类型的信息:

1.多语言的一致性。在不同的语言中表达相同想法的句子通常有相同或相似的语义成分(McDonald等人,2013)。例如,s1的平行汉语句子是:“一辆美国坦克向巴勒斯坦旅馆开火,其中“美国坦克”是英文表达“美国坦克”的对应对应词,它指的是一种军事武器。无论在英语或汉语中,武器词往往与攻击事件一起出现,这为识别攻击事件提供了重要线索。不同语言之间的证据是一致和连贯的。增强线索可以用来缓解源语言中的数据稀缺性。

2.多语种互补。不同的语言通常有不同的特点和习语。一种语言的含糊表达可能在其他语言中具有非歧义性,这可以为消除歧义提供补充信息(Lin、Liu和Sun 2017)。例如,当将s1和s2映射到中文时,“fired”的对应翻译分别是“开火”和“解雇”。这两个汉字不具有共同的特征或语义,并且没有模棱两可的表达Attack事件和End-Position事件。中文的信息有助于消除英语中事件类型的歧义,我们称之为多语言互补。

在这些动机的指导下,我们的框架,GMLATT使用两种关注机制来利用这两种信息来识别和分类事件:

(1) 为了利用不同语言之间的一致证据,我们只对每种语言进行单语语境的关注。很直观的是,句子中的单词具有不同的重要性。例如,在s1中,“美国坦克”提供了一个更重要的线索,即冲突情景中可能发生的事件比其他词语更为重要。在s2中,“航空公司飞行员”和“剥离”是暗示终端事件发生的重要部分。这些话应该比其他词更受关注。在此基础上,我们采用上下文注意机制围绕候选触发器的上下文文本来建模。注意权重表明句子中不同单词对预测事件类型的重要性。

(2) 为了利用补充信息,我们采用了门控的跨语言注意。来自其他语言的文本确实提供了有价值的线索。然而,如何将它们与源特性结合起来是一个问题。我们使用门控跨语言注意力来模拟其他语言提供的功能的可信度。注意门作为一个哨兵来控制从其他语言到源端的信息流。从而控制各种语言的信息集成。

我们的主要贡献有三个方面:(1)我们提出了一个新颖的多语言ED任务框架,可以同时解决数据稀缺和单语歧义问题。(2)该框架包含两种关注机制:单语环境注意和门控跨语言注意。在我们最好的情况下,这是第一个引入对多语言数据建模的注意机制的工作在ED任务中。(3)我们对ACE 2005语料库进行了广泛的实验,实验结果表明,我们的方法比现有方法取得了显着的改进,并在此评估任务中设置了新的先进技术。

在ACE 2005中,一个事件被定义为涉及一个或多个参与者的特定事件。标准事件提取(EE)任务需要特定类型的事件,这些事件在源语言文本中被提及。

我们引入了一些ACE术语来促进对任务的理解:

实体:在兴趣的语义范畴之一中的对象。实体提及: 对实体的引用(通常是名词短语)。事件提及:描述事件的短语或句子,包括触发器和参数。事件触发:这个词最清楚地表达了事件的提及,通常是一个动词或名词。事件论证:一个实体提及、时间表达式或值(例如,职位名称)作为参与者或属性,在事件提及时具有特定的角色。一个实体提及时间表达或价值(例如职务 - 标题)作为参与者或属性在事件提及中具有特定角色。

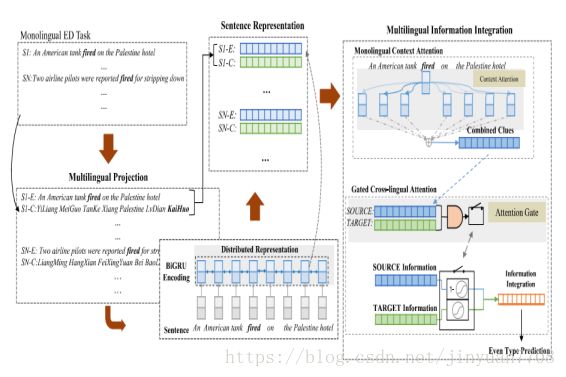

在本节中,我们将说明GMLATT框架的细节。GMLATT的表示如图2所示。GMLATT有四个步骤:

多语言投影 —— 将单语言文本项目并行化为多语言文本。 我们利用机器翻译(MT)来引导源数据。

图2:GMLATT框架的整体架构。在多语言投射之后,框架利用BiGRU编码器将句子编码为分布式表示。单语的注意力和门控的跨语言注意力被用于多语言信息整合

循环神经网络(RNN)被用来对每种语言的句子进行建模。

多语言信息集成 —— 从不同的语言中收集信息。它指的是:(1)使用单语上下文注意在每种语言中汇集信息。(2)使用门控跨语言注意力整合不同语言的信息。

事件类型预测 —— 做细粒度的事件类型分类。

在本文中,我们将重点放在英语事件检测上,即源语言被设置为英语。我们使用中文作为唯一的目标语言来引导源数据。请注意,在理论上,我们的框架不受特定语言的限制,甚至可以同时使用各种语言作为目标语言,我们将在未来的工作中使用这些语言。

多语言投影

由于ACE 2005仅对单语事件进行了注释,为了应用我们的框架,我们首先使用在线机器翻译服务3来获得目标语言中的并行文本。

对于触发投影而言,我们不采用启发式规则或外部字典,而是以一种无监督的方式学习对齐。我们使用GIZA ++ 4——这是MT中常用的工具——来学习多语言对齐。GIZA ++将单词对齐视为隐藏变量,并使用EM算法无监督地找到最佳对齐方式(Och and Ney 2003)。我们将翻译后的多语言数据与(Eisele 和Chen 2010)发布的200k平行英汉语语料库5连接在一起,以学习它们的排列组合。

句子表示

循环神经网络(RNN)在序列建模中显示出有希望的结果。我们采用一种称为门控循环单元(GRU)的RNN的特殊实现(Chung等2014)来对单词序列进行建模以表示句子。

一种更先进的模型是双向GRU(Bi-GRU)。它在每一个时间步骤t中保持两个隐藏状态,一个用于从左到右的传播另一种是右向左传播。它将这两个状态合并为当前状态:。

我们采用Bi-GRU来编码句子。 首先通过三个查找表将句子中的每个标记转移到词法特征:

词嵌入表:词嵌入能够捕获词的有意义的语义规则(Turian,Ratinov和Bengio,2010)。我们使用词嵌入作为基本特征。我们使用Skip-gram模型来学习不同语言的单词嵌入——英文的NYT语料库和中文的CN维基百科。

实体嵌入表:根据现有的工作(Li,Ji和Huang,2013; Chen等,2015; Nguyen和Grishman,2015; Liu等,2016),我们利用注释的实体信息作为附加特征。我们随机地为每个实体类型(包括NA类型)初始化嵌入向量,并在训练过程中更新它们。 实体嵌入表由不同的语言共享。

位置嵌入表:在关系抽取任务中,(Zeng等人,2014)使用位置嵌入来表示上下文词与实体之间的距离,这带来了巨大的性能提升。类似地,我们也使用上下文词汇和候选触发器之间的相对距离指定的位置嵌入。我们随机初始化嵌入向量并在训练过程中更新它们。

我们将以上三个特性连接作为Bi-GRU的输入。在Bi-GRU中隐藏的状态序列被用作句子的表示。我们将源端表示句子表示为,在目标方面为,其中L和N分别是句子长度。

多语言信息集成

这是GMLATT框架的核心部分。该框架利用单语上下文的关注,利用不同语言之间的一致证据,对模型上下文文本进行分析。它利用门控的跨语言注意力来模拟TARGET方面提供的互补线索的信心,TARGET方面控制着来自各种语言的信息整合。

单语语境注意机制

单语语境关注机制是在每一方面进行的。我们只使用SOURCE方来说明,以避免重复。给出一个源句和它的表示,我们首先将每个标记作为候选触发器,其表示形式为。然后,我们利用注意机制利用其周围的上下文文本来找到证据来确定其类型。每个标记在上下文文本中的重要性计算如下:

(5)

其中mi是候选触发表示hc src与上下文标记表示hsi之间的相关性,以双线性注意为模型:

(6)

其中是权重矩阵,而是偏置项。给定所有重要性权重,就候选触发器传达的综合信息通过加权和得到:

(7)

门控跨语言注意机制

给定和,下一步是将它们组合起来以获得综合信息。我们提出了两种组合策略:

STG1:平均总和。我们假设来自源端和目标端的信息具有相同的重要性。综合信息的计算如下:

(8)

STG2:加权和。我们假设来自源端和目标端的信息具有不同的重要性。我们利用门控跨语言注意力来模拟目标方提供的线索的信心。注意门的值被计算为:

(9)

其中是权重矩阵,是偏置项。是多元函数接受向量作为输入,并计算输出为:

我们使用和作为源端和目标端的组合权重来组装和。由于我们的初衷是在源端实施ED,所以注意门可以被看作是控制从目标端到源端的信息流的标志。请注意,注意门的尺寸与和相同,综合信息通过加权和计算得出:

(11)

事件类型预测

按照以前的工作,我们将ED定义为一个多类分类问题。对于源句中的每个标记,我们都可以预测它是否是事件触发器,并为它确定事件类型。我们将,和组合作为softmax分类器的输入:

(12)

其中,是权重矩阵,而是偏置项。输出O是一个实值矢量,表示不同类型的预测概率。候选触发器t的概率属于类型j:

(13)

训练和优化

这里我们介绍GMLATT框架的学习和优化细节。 优化目标函数被定义为多类交叉熵损失:

(14)

数据集和评价指标

我们在广泛使用的ACE 2005数据集上进行实验。这个语料库包含599个注释了8个类型和33个事件子类型的文档。继之前的研究(Liao和Grishman,2010; Li,Ji和Huang,2013; Chen等,2015; Nguyen和Grishman,2015; Liu等,2016),我们简单地将它们视为33个独立的事件类型并忽略分层结构。我们使用与以前的作品相同的数据分离:40个特定的文章被用作盲测试集; 使用30篇文章作为开发集; 其余529篇文章用于训练。

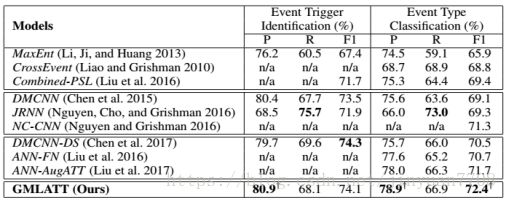

与现有的方法比较

我们将我们的模型与许多最先进的方法进行比较。 我们将这些方法分为三种类型:

基于特征的方法。MaxEnt:(Li,Ji和Huang 2013)中的方法,它只使用人为设计的特征。CrossEvent:(Liao and Grishman 2010)中的方法,利用文档信息获取复杂的功能。组合-PSL:(Liu等人,2016)中的方法,其使用概率性软逻辑模型来开发全局信息,即最佳报告的基于特征的系统。

基于表示的方法。DMCNN:(Chen等,2015)中的方法,它使用CNN自动完成特征提取。 JRNN:(Nguyen,Cho和Grishman 2016)中的方法,它使用更复杂的结构来为事件相互依赖关系建模。 NC-CNN:(Nguyen and Grishman,2016)中的方法,它模拟非连续n元组以实现更高性能。

基于外部资源的方法。DMCNN-DS:(Chen et al。2017)中的方法,它使用FreeBase通过Distance Supervision标注新的训练数据。 ANN-FN:(Liu et al。2016)中的方法,它利用FrameNet中的事件来引导训练。 ANN-AugATT:该方法(Liu et al。2017),它利用了额外的参数信息和FrameNet。

性能如表1所示。从结果中,我们有几个观察结果:

在所有这些方法中,基于表示的方法击败基于特征的方法(平均占F1的1.9%)和基于外部资源的方法达到最佳效果(基于代表性方法的F1平均值为1.0%)。这种现象并不奇怪。基于表示的方法通过避免复杂的特征工程来实现更好的性能,并自动学习数据中的显着特征。虽然基于外部资源的方法将特征学习与来自外部资源的更多数据结合起来,以实现进一改进。

此外,在所有的方法中,我们的方法表现最好。它在事件类型分类方面取得了最好的成绩(F1的72.4%),并且在F1上击败了最好的外部资源基于方法ANN-AugATT的0.7%。对于事件类型识别,与最佳系统相比,它实现了比较性能(74.1%vs 74.3%)。

详细分析

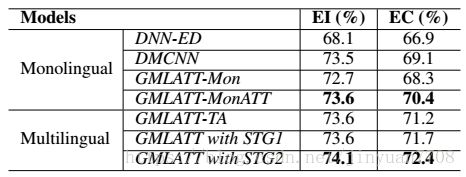

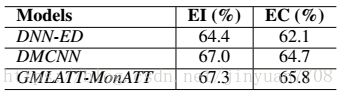

我们进行额外的实验来做详细的分析。 EI和EC分别代表事件触发识别和事件类型分类的F1分数。

不同注意策略的影响

我们提出了五种模型,比较两种基本线,以利用不同注意力策略的效果。

单语设置

DNN-ED是(Liu et al.2016)提出的基本快速前向神经网络模型。DMCNN是(Chen et al.2015)利用CNN自动进行功能捕捉的模型。 GMLATT-Mon是没有任何注意机制的GMLATT。 GMLATT-MonATT只有GMLATT才具有单一语境的关注。

多语言设置

GMLATT-TA是没有门控跨语言注意力的GMLATT,但将对齐的候选触发器用作多语言信息。 前面已经描述了STG1和STG2两种不同的策略。

表2:不同注意力策略的表现。

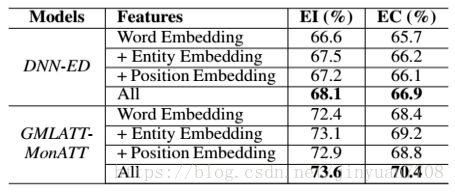

特征组合的影响

表3:特性组合的性能。

根据结果,实体嵌入和位置嵌入在简单模型和复杂模型中都提供了补充改进。 看起来,实体嵌入比位置嵌入更有效(平均为0.2%)。 直觉解释是:当使用RNN编码句子时,位置信息可能在某种程度上被编码为分布式表示。 这减少了添加位置嵌入的影响。

预测数据的性能

我们研究了预测数据的性能。结果如表4所示。

表4:预计的中国数据的性能。

与英语中的ED相比,中文投射数据的表现相对较低。 我们将不良表现归因于MT引入的噪音。噪音包括翻译错误和对齐错误。尽管如此,它仍然显示了英语ED的一致性表现——GMLATT与注意力机制的表现优于两个基线。

注意可视化

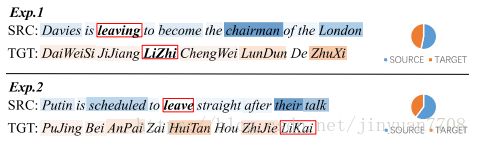

图4中显示了两个例子的注意权重。

图4:注意可视化。热图显示了上下文的注意。蓝色用于源语言,橙色用于目标语言。

饼图表示门控跨语言注意力的平均值

在实验1中,SOURCE方面的“主席”和“伦敦”以及TARGET方面的“祝喜”和“伦敦”具有较高的关注权重。这意味着与职业变化相关的事件并且决定“离开”的事件类型是终止位置。在实验2中,“预定”和“他们的谈话”是源语方面很受关注的词语。它们意味着共同的生活场景,并产生一次“离开”运动事件。 请注意,实验2的TARGET方面的注意力量是凌乱的。这与TARGET侧的平均门控跨语言注意力权重的较低值与Exp.1。

我们抽出100个例子来利用门控跨语言注意力,发现SOURCE与TARGET的比值为0.59:0.41。 TARGET方面的重量较低意味着 - 由MT引发的噪音使得TARGET方面不如SOURCE方面可靠。

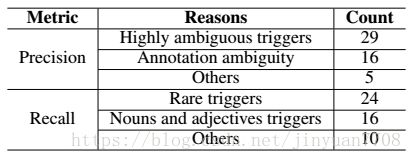

误差分析

为此,F1分数是精确度和召回率的折衷,对于每个度量标准,我们抽取50个例子来检查原因。 我们在表5中给他们一个简短的总结。

表5:对精度和回忆的错误分析

为了精确,高度模糊的触发(词触发太多事件,特别是支持动词,如“走”,“走”)是影响性能的主要原因。 注释歧义也是一个严重的问题。 例如,“黑客入侵”是否表示攻击事件或死亡事件? ACE 2005只为每个提及的事件分配一个事件,这会导致注释歧义。

对于召回,罕见的触发(训练实例少于5个),基于名词和形容词的触发是主要原因。其他原因包括间接触发因素,如“this”,“what”,这需要对句子进行深层语义分析才能识别出来。

已经为ED提出了各种方法。基于特征的方法依赖于判别性特征来建立统计模型。 (Ahn 2006)利用了词汇特征和句法特征。更高级的功能包括交叉文档特征(Ji和Grishman 2008),跨事件特征(Gupta and Ji 2009; Liao and Grishman 2010)等(Li,Ji和Huang 2013)提出了一种基于结构感知器和波束搜索的联合框架来做事件触发和事件论证预测。(Liu et al。2016)使用基于概率软逻辑的方法来结合局部和全局特征。基于表示的方法已经有了最近引入了ED。它包括使用卷积神经网络(CNN)(Chen等,2015; Nguyen和Grishman,2015)来避免复杂的特征工程,建模非连续跳跃模型(Nguyen和Grishman,2016)。基于表示的方法由于其自动特征捕获和建模数据中复杂的隐藏交互的能力而获得相对较高的性能。但是,正如我们之前提到的,ED中的数据稀缺限制了他们的进一步表现。基于外部资源的模型通过利用附加信息来解决数据稀缺问题。 (Chen等2017)使用FreeBase通过距离监督标记新的训练数据。(Liu et al。2016)利用FrameNet中的事件获取更多可用数据。(Liu et al。2017)利用来自参数和FrameNet的附加信息来检测事件,从而获得更好的性能。

对于多语言方法,(Ji 2009; Li et al。2012; Wei et al。2017)是优秀的作品,属于传统的基于特征的方法。 (Agerri等2016; Danilova,Alexandrov和Blanco 2014; 冯等人。 2016)阐明了构建多语言事件抽取系统的技术,然而,其作品中的“多语言”确实意味着“与语言无关”,这与我们的工作正交。

等应用于注意模型的各种领域。我们的知识,这是第一次采取注意神经网络来解决教育署的任务。

总之,我们在一个新颖的多语言框架中利用两种注意机制来解决ED中同时出现的数据稀缺和单语歧义问题。实验结果表明,我们的方法比现有方法取得了显着的改进,并设置了一个新的最先进的性能。

该研究工作得到国家重点科技攻关计划资助项目2017YFB1002101和国家自然科学基金资助项目61533018的支持。该项工作也得到了蚂蚁金融服务集团的支持,并得到了阿里巴巴集团通过阿里巴巴创新研究(AIR)项目的支持。