【若泽大数据实战第十天】Hadoop用户启动hdf三个进程

前言:

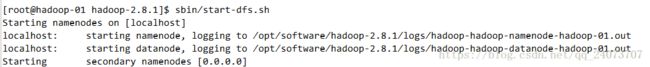

再上次的课程中我们配置了root用户来启动了hdfs,hdfs-site.xml内的参数都是官方默认的参数,所以启动项没有整理比较乱,为了做生产标准统一规范使用,我要用hadoop用户启动hdfs进程的启动显示全部为hadoop-01的主机名,先看看root用户下启动的情况

可以看到namenodes datanode sercondary namenodes 进程启动的名称都不相同,接下来会详细描述整个过程。

详细的修改步骤:

启动的三个进程:namenode: hadoop-01 bin/hdfs getconf -namenodes

datanode: localhost datanodes (using default slaves file) etc/hadoop/slaves

secondarynamenode: 0.0.0.0

[hadoop@hadoop-01 ~]# cd/opt/software/hadoop

[hadoop@hadoop-01 hadoop]# echo "hadoop-01" > ./etc/hadoop/slaves

[hadoop@hadoop-01 hadoop]# cat./etc/hadoop/slaves

hadoop-01

[hadoop@hadoop-01 hadoop]# vi./etc/hadoop/hdfs-site.xml

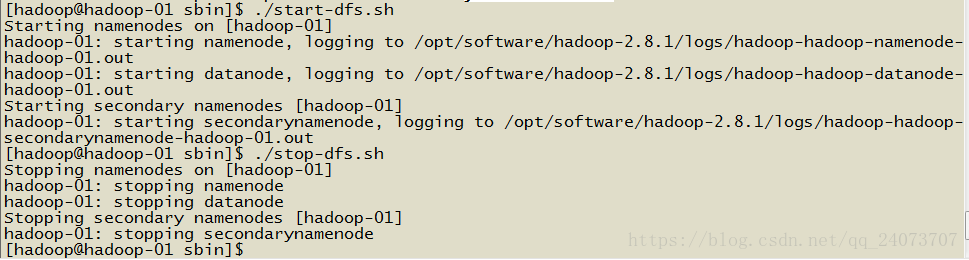

# 重启

[hadoop@hadoop-01 hadoop]#sbin/stop-dfs.sh

[hadoop@hadoop-01 hadoop]#sbin/start-dfs.sh

关于步骤做一个详细的解析:

namenode : hadoop-01

datnaode : localhost

seondarynamenode : 0.0.0.0

对于这三个进程我们要查看如何修改这些参数

1. namenode 他读取的文件是 core-site.xml,所以我们要对这个文件进行修改

namenode进程启动就改为了hadoopp-01

[hadoop@hadoop-01 hadoop-2.8.1]$ cat/etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4localhost4.localdomain4

::1 localhost localhost.localdomain localhost6localhost6.localdomain6

192.168.137.30 hadoop-01 (查看了我们的机器名已经配置了相关的ip地址信息了)

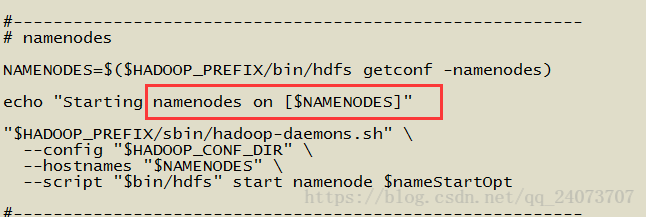

需要查看hdfs启动这三个进程究竟是一个怎样的过程,它写的是一个shell脚本

cat sbin/start-dfs.sh

如下图:

文件显示namenodes on 就等于 [root@hadoop-01 hadoop-2.8.1]$ sbin/start-dfs.sh

Starting namenodes on [localhost],所以启动的是本地的机器名

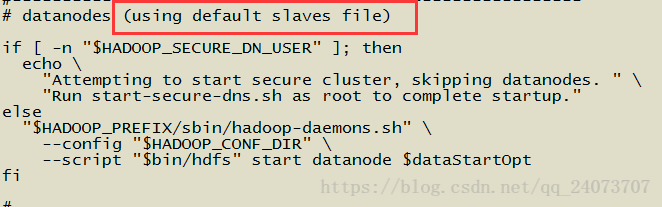

2.datenode调用的是 slaves file文件

查找下slaves用的是什么,发现是localhost,我们要对其进行修改

覆盖slaves文件,让它变成hadoop-01

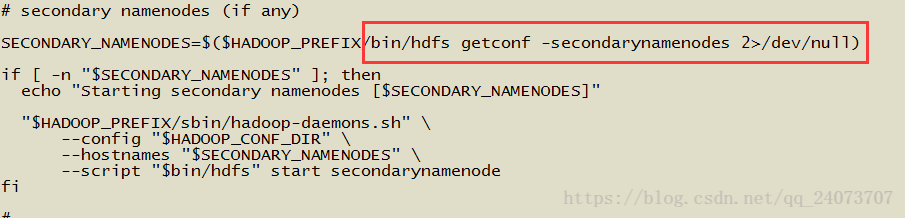

3.seondarynamenode 查看shell信息

我们通过命令查看相应的结果:

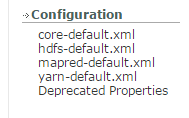

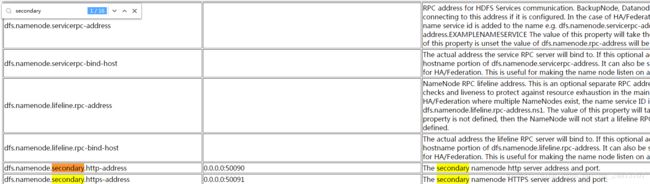

打开官网查看官网给出的信息

http://hadoop.apache.org/docs/r2.8.3/hadoop-project-dist/hadoop-common/SingleCluster.html

把网站信息往下拉,可以看到下图,点击 hdfs-default.xml

再上节课中我们的hdfs-deault.xml使用的是默认的配置

然后 Ctrl + F 查找 secondary ,第一个就是我们所需要的信息

这里的htpps,带安全认证的意思

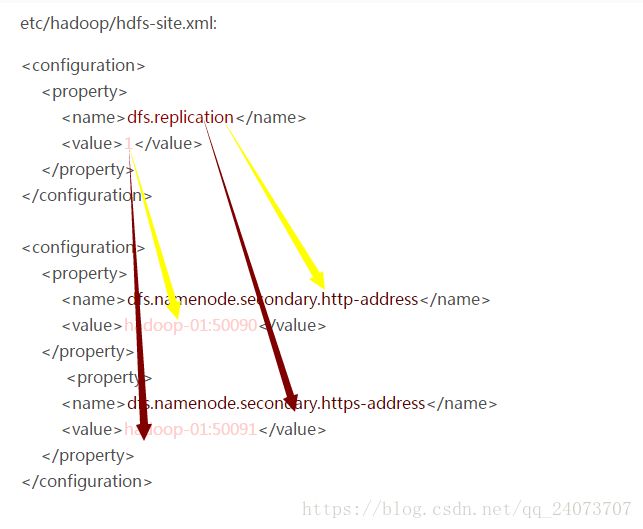

把以下的信息进行替换到原来的hdf-site.xml

dfs.namenode.secondary.http-address 0.0.0.0:50090

dfs.namenode.secondary.https-address 0.0.0.0:50091

按课程需求将0.0.0.0 替换成 hadoop-01

按颜色进行替换:

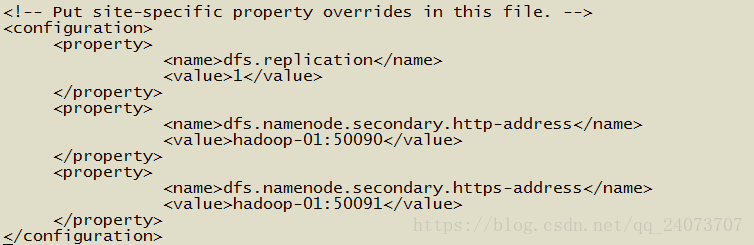

实战替换的结果:

需要自行调整排序

4.查看是否都是以hadoop-01启动停止:

结果没有任何报错,正常

大数据课程推荐: