本文参考李大辉大神的博客以及JavaDoop

Map也是我们常用的数据结构之一:键值对结构

接下来我们会针对JDK 1.8中的 HashMap,HashTable,conCurrentMap等键值对结构的集合框架进行原理总结

HashMap

- 概述: HashMap是基于哈希表的Map接口的非同步实现。此实现提供所有可选的映射操作,并允许使用null值和null键。此类不保证映射的顺序,特别是它不保证该顺序恒久不变。

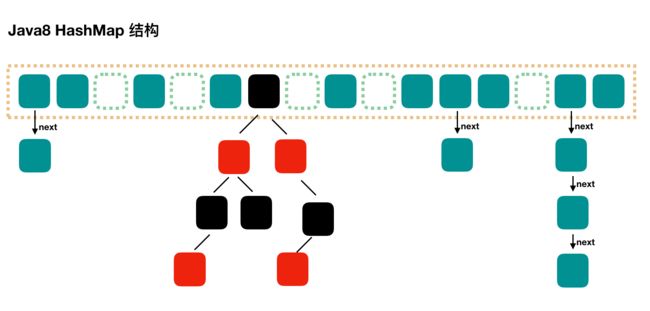

HashMap实际上是一个“链表散列”的数据结构,即数组和链表,红黑树的结合体。

我们先看HashMap的初始化(JDK 1.8):

public HashMap(int initialCapacity, float loadFactor) {

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

this.threshold = tableSizeFor(initialCapacity);

}

在构造函数中,我们能看到这么几个变量:

- initialCapacity 初始化容量

- loadFactor 加载因子

恩 , 并没有什么数组什么的初始化 , 只是加载了几个变量 , 这些变量用于初始化数组以及扩容。

2. put操作

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

首先针对key值进行一次哈希操作

static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

当key值为空时,吧哈希值默认设置为0,否则。。。就一通哈希,这边的算法我也看不太懂- -最终返回哈希值。

在看方法之前我们也要注意一下HashMap中用到的数据结构:

static class Node implements Map.Entry {

final int hash;

final K key;

V value;

Node next;

Node(int hash, K key, V value, Node next) {

this.hash = hash;

this.key = key;

this.value = value;

this.next = next;

}

public final K getKey() { return key; }

public final V getValue() { return value; }

public final String toString() { return key + "=" + value; }

public final int hashCode() {

return Objects.hashCode(key) ^ Objects.hashCode(value);

}

public final V setValue(V newValue) {

V oldValue = value;

value = newValue;

return oldValue;

}

public final boolean equals(Object o) {

if (o == this)

return true;

if (o instanceof Map.Entry) {

Map.Entry e = (Map.Entry)o;

if (Objects.equals(key, e.getKey()) &&

Objects.equals(value, e.getValue()))

return true;

}

return false;

}

}

我们可以看到这个内部的数据结构有四个参数: key,hash,value,next,通过泛型来指定其类型,最后的这个next属性的类型为bean对象,说明这个就是一个链表结构了。但是这个只是链表的结构,红黑树的结构为TreeNode,只是比上面多了一个指针,分别为left指针与right指针

再回到putVal方法

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node[] tab; Node p; int n, i;

// 第一次 put 值的时候,会触发下面的 resize(),类似 java7 的第一次 put 也要初始化数组长度

// 第一次 resize 和后续的扩容有些不一样,因为这次是数组从 null 初始化到默认的 16 或自定义的初始容量

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

// 根据哈希值找到具体的数组下标,如果此位置没有值,那么直接初始化一下 Node 并放置在这个位置就可以了

if ((p = tab[i = (n - 1) & hash]) == null)

//节点为空,直接创建节点作为链表的头

tab[i] = newNode(hash, key, value, null);

else {

//如果有数据,先检测key值是否冲突,冲突则进行覆盖

Node e; K k;

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

//如果不冲突并且为树节点, 开始进行红黑树插入, 在putTreeVal方法中完成树的旋转以保持红黑树平衡.

else if (p instanceof TreeNode)

e = ((TreeNode)p).putTreeVal(this, tab, hash, key, value);

else {

//如果是普通链表,插入到链表的最后面

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

// TREEIFY_THRESHOLD 为 8,所以,如果新插入的值是链表中的第 9 个,会触发下面的 treeifyBin,也就是将链表转换为红黑树

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

//如果超过阈值, 进行扩容

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

这边的操作略复杂,大体上我来总结一下:

当我们往HashMap中put元素的时候

- 先根据key的hashCode重新计算hash值

- 根据hash值得到这个元素在数组中的位置(即下标)

- 如果数组该位置上已经存放有其他元素了,那么在这个位置上的元素将以链表的形式存放,新加入的放在链表末尾。如果数组该位置上没有元素,就直接将该元素放到此数组中的该位置上。后续是一大部分普通链表以及自平衡树的操作

所以,当系统决定存储HashMap中的key-value对时,完全没有考虑Entry中的value,仅仅只是根据key来计算并决定每个Entry的存储位置。我们完全可以把 Map 集合中的 value 当成 key 的附属,当系统决定了 key 的存储位置之后,value 随之保存在那里即可。

前面说过HashMap的数据结构是数组和链表的结合,所以我们当然希望这个HashMap里面的 元素位置尽量的分布均匀些,尽量使得每个位置上的元素数量只有一个,那么当我们用hash算法求得这个位置的时候,马上就可以知道对应位置的元素就是我们要的,而不用再去遍历链表,这样就大大优化了查询的效率。

那么HashMap的长度是多大呢,我们在resize()方法中可以看到

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

我们能看到左移操作,也就是每次重新测量都是2的n次方

在resize方法中的执行过程:

- 数组扩大一倍,阈值也扩大一倍

- 初始化新的数组

- 遍历原数组并进行数据迁移:

- 如果是单条节点,直接迁移;

- 如果是红黑树,将数拆为高树和矮树,并对两棵树进行处理:如果高度很小,退化为链表;否则重新生成红黑树

- 如果为链表,将链表拆分两条链表,

这里引用大神博客的测试以及解读

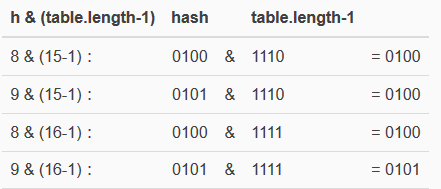

假设数组长度分别为15和16,优化后的hash码分别为8和9,那么&运算后的结果如下:

当它们和15-1(1110)“与”的时候,产生了相同的结果,也就是说它们会定位到数组中的同一个位置上去,这就产生了碰撞,8和9会被放到数组中的同一个位置上形成链表,那么查询的时候就需要遍历这个链 表,得到8或者9,这样就降低了查询的效率。同时,我们也可以发现,当数组长度为15的时候,hash值会与15-1(1110)进行“与”,那么最后一位永远是0,而0001,0011,0101,1001,1011,0111,1101这几个位置永远都不能存放元素了,空间浪费相当大,更糟的是这种情况中,数组可以使用的位置比数组长度小了很多,这意味着进一步增加了碰撞的几率,减慢了查询的效率!而当数组长度为16时,即为2的n次方时,2n-1得到的二进制数的每个位上的值都为1,这使得在低位上&时,得到的和原hash的低位相同,加之hash(int h)方法对key的hashCode的进一步优化,加入了高位计算,就使得只有相同的hash值的两个值才会被放到数组中的同一个位置上形成链表。

所以说,当数组长度为2的n次幂的时候,不同的key算得得index相同的几率较小,那么数据在数组上分布就比较均匀,也就是说碰撞的几率小,相对的,查询的时候就不用遍历某个位置上的链表,这样查询效率也就较高了。

- 总结一下put方法:

根据上面 put 方法的源代码可以看出,当程序试图将一个key-value对放入HashMap中时,程序首先根据该 key 的 hashCode() 返回值决定该 Node的存储位置:如果两个 Node 的 key 的 hashCode() 返回值相同,那它们的存储位置相同。如果这两个 Node的 key 通过 equals 比较返回 true,新添加 Node的 value 将覆盖集合中原有 Node 的 value,但key不会覆盖。如果这两个 Node 的 key 通过 equals 比较返回 false,新添加的 Node将与集合中原有 Node形成 table链,而且新添加的 Node位于 table链的尾部;如果链表长度超过8,则将该条链表转化为红黑树(JDK 1.8加入,这样可以优化链表的查找速度)

3. get方法

看完了put方法后,与之对应的get方法就要简单太多太多了

public V get(Object key) {

Node e;

return (e = getNode(hash(key), key)) == null ? null : e.value;

}

首先这个方法返回值为null或者e.value. 在刚开始时,对key值进行哈希计算,再调用getNode方法获取节点,赋值给e。

final Node getNode(int hash, Object key) {

Node[] tab; Node first, e; int n; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & hash]) != null) {

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k))))

return first;

if ((e = first.next) != null) {

// 如果节点为树, 则在树中查找

if (first instanceof TreeNode)

return ((TreeNode)first).getTreeNode(hash, key);

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

计算出哈希值之后 , 再根据key值找到node的位置, 最后将整个节点返回. 也就是说,当且仅当hash值与key值都相同时,才能取到value值

3. 扩容

我们在put函数中,有resize()这个函数,函数过程就不贴出来了,较为复杂。

当HashMap中的元素越来越多的时候,hash冲突的几率也就越来越高,因为数组的长度是固定的。所以为了提高查询的效率,就要对HashMap的数组进行扩容,而在HashMap数组扩容之后,原数组中的数据必须重新计算其在新数组中的位置,并放进去,这就是resize。

那么HashMap什么时候进行扩容呢?当HashMap中的元素个数超过数组大小loadFactor时,就会进行数组扩容,loadFactor的默认值为0.75,这是一个折中的取值。也就是说,默认情况下,数组大小为16,那么当HashMap中元素个数超过160.75=12的时候,就把数组的大小扩展为 216=32,即扩大一倍,然后重新计算每个元素在数组中的位置,而这是一个非常消耗性能的操作,所以如果我们已经预知HashMap中元素的个数,那么预设元素的个数能够有效的提高HashMap的性能。这也验证了我们在初始化时就设定了loadFactor值的意义。当然了,HashMap是先插入数据,再验证是否需要扩容。

4. HashMap的性能参数

还记得初始化里面的两个参数么

initialCapacity 初始化容量

loadFactor 加载因子

负载因子loadFactor衡量的是一个散列表的空间的使用程度,负载因子越大表示散列表的装填程度越高,反之愈小。对于使用链表法的散列表来说,查找一个元素的平均时间是O(1+a),因此如果负载因子越大,对空间的利用更充分,然而后果是查找效率的降低;如果负载因子太小,那么散列表的数据将过于稀疏,对空间造成严重浪费。

其实也就是设置扩容的一个时机。而初始化容量也限制了列表的增长方式,因为map的增长都是成倍的增长。

5. 其他HashMap的细节

- HashMap接受null的键和值

- HashMap非线程安全,有Fail-Fast机制,根据迭代器中的modCount和expectModCount来验证多线程的访问,不相等时抛出ConcurrentModificationException异常

- map存储数据时发生哈希碰撞, 会使用链表的方式解决

- hashMap的大小调整:n*2^x 即2的指数次

HashTable

emmm 笔者是没用过HashTable的, 但是这个数据结构和HashMap也是大同小异. 简单来看看重要的方法吧

1. 构造函数

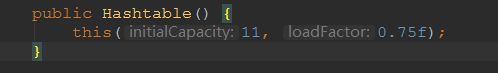

为了将方法参数展示出来,这里直接上截图了,同样也是需要一个初始化容量和加载因子,默认的初始容量为11,加载因子和HashMap一样为0.75。带参的构造方法和HashMap类似,不再赘述了。

2. put方法

public synchronized V put(K key, V value) {

// Make sure the value is not null

if (value == null) {

throw new NullPointerException();

}

// Makes sure the key is not already in the hashtable.

HashtableEntry tab[] = table;

int hash = key.hashCode();

int index = (hash & 0x7FFFFFFF) % tab.length;

@SuppressWarnings("unchecked")

HashtableEntry entry = (HashtableEntry)tab[index];

for(; entry != null ; entry = entry.next) {

if ((entry.hash == hash) && entry.key.equals(key)) {

V old = entry.value;

entry.value = value;

return old;

}

}

addEntry(hash, key, value, index);

return null;

}

首先我们可以发现,方法的定义中加入了线程锁,也就是说put方法是线程安全的(其实HashTable本身就是线程安全的)

接下来当value为null是会抛出异常,不会存储value为null的情况

在接下来就是和HashTable一样,校验hash值, 找到指定位置放置节点。如果节点处的链表有和key值相同的节点,name就更新该节点的值,否则将节点插入到链表尾部。

最后的addEntry校验了长度是否满足条件,不满足就自动扩容。

3. get方法

和HashMap的过程一模一样,我这里偷个懒哈,大家自己看。

HashTable总结:

- Hashtable 的函数都是同步的,这意味着它是线程安全的。

- 它的key、value都不可以为null。key值的哈希使用object的hash方法。

- HashMap仅支持Iterator的遍历方式,Hashtable支持Iterator和Enumeration两种遍历方式。因为HashTable直接继承自Dictionary

ConCurrentHashTable

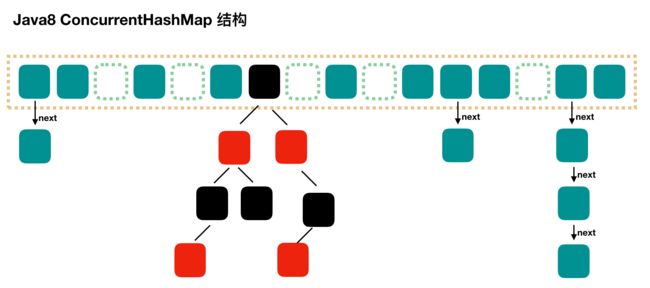

和HashMap的基本结构是一样的,

首先来看看构造函数:

public ConcurrentHashMap() {

}

public ConcurrentHashMap(int initialCapacity) {

if (initialCapacity < 0)

throw new IllegalArgumentException();

int cap = ((initialCapacity >= (MAXIMUM_CAPACITY >>> 1)) ?

MAXIMUM_CAPACITY :

tableSizeFor(initialCapacity + (initialCapacity >>> 1) + 1));

this.sizeCtl = cap;

}

默认的构造函数什么也不做的, 1参数的构造函数中针对传入的初始长度做了一些初始化的操作。我们要注意一下sizeCtl这个变量。

即:sizeCtl=initialCapacity +0.5*initialCapacity+1,再向上取整到2的指数。

2. put方法

首先,同样是调用了putVal方法,具体过程较为复杂,直接在代码中备注一下。

public V put(K key, V value) {

return putVal(key, value, false);

}

final V putVal(K key, V value, boolean onlyIfAbsent) {

if (key == null || value == null) throw new NullPointerException();

// 得到 hash 值

int hash = spread(key.hashCode());

// 用于记录相应链表的长度

int binCount = 0;

for (Node[] tab = table;;) {

Node f; int n, i, fh;

// 如果数组"空",进行数组初始化

if (tab == null || (n = tab.length) == 0)

// 初始化数组,后面会详细介绍

tab = initTable();

// 找该 hash 值对应的数组下标,得到第一个节点 f

else if ((f = tabAt(tab, i = (n - 1) & hash)) == null) {

// 如果数组该位置为空,

// 用一次 CAS 操作将这个新值放入其中即可,这个 put 操作差不多就结束了,可以拉到最后面了

// 如果 CAS 失败,那就是有并发操作,进到下一个循环就好了

if (casTabAt(tab, i, null,

new Node(hash, key, value, null)))

break; // no lock when adding to empty bin

}

// hash 居然可以等于 MOVED,这个需要到后面才能看明白,不过从名字上也能猜到,肯定是因为在扩容

else if ((fh = f.hash) == MOVED)

// 帮助数据迁移,这个等到看完数据迁移部分的介绍后,再理解这个就很简单了

tab = helpTransfer(tab, f);

else { // 到这里就是说,f 是该位置的头结点,而且不为空

V oldVal = null;

// 获取数组该位置的头结点的监视器锁

synchronized (f) {

if (tabAt(tab, i) == f) {

if (fh >= 0) { // 头结点的 hash 值大于 0,说明是链表

// 用于累加,记录链表的长度

binCount = 1;

// 遍历链表

for (Node e = f;; ++binCount) {

K ek;

// 如果发现了"相等"的 key,判断是否要进行值覆盖,然后也就可以 break 了

if (e.hash == hash &&

((ek = e.key) == key ||

(ek != null && key.equals(ek)))) {

oldVal = e.val;

if (!onlyIfAbsent)

e.val = value;

break;

}

// 到了链表的最末端,将这个新值放到链表的最后面

Node pred = e;

if ((e = e.next) == null) {

pred.next = new Node(hash, key,

value, null);

break;

}

}

}

else if (f instanceof TreeBin) { // 红黑树

Node p;

binCount = 2;

// 调用红黑树的插值方法插入新节点

if ((p = ((TreeBin)f).putTreeVal(hash, key,

value)) != null) {

oldVal = p.val;

if (!onlyIfAbsent)

p.val = value;

}

}

}

}

// binCount != 0 说明上面在做链表操作

if (binCount != 0) {

// 判断是否要将链表转换为红黑树,临界值和 HashMap 一样,也是 8

if (binCount >= TREEIFY_THRESHOLD)

// 这个方法和 HashMap 中稍微有一点点不同,那就是它不是一定会进行红黑树转换,

// 如果当前数组的长度小于 64,那么会选择进行数组扩容,而不是转换为红黑树

// 具体源码我们就不看了,扩容部分后面说

treeifyBin(tab, i);

if (oldVal != null)

return oldVal;

break;

}

}

}

//

addCount(1L, binCount);

return null;

}

put 的主流程看完了,比较复杂,但是至少留下了几个问题,第一个是初始化,第二个是扩容,第三个是帮助数据迁移,这些我们都会在后面进行一一介绍。

3. initTable初始化数组

初始化方法中的并发问题是通过对 sizeCtl 进行一个 CAS 操作来控制的.

private final Node[] initTable() {

Node[] tab; int sc;

while ((tab = table) == null || tab.length == 0) {

// 初始化的"功劳"被其他线程"抢去"了

if ((sc = sizeCtl) < 0)

Thread.yield(); // lost initialization race; just spin

// CAS 一下,将 sizeCtl 设置为 -1,代表抢到了锁

else if (U.compareAndSwapInt(this, SIZECTL, sc, -1)) {

try {

if ((tab = table) == null || tab.length == 0) {

// DEFAULT_CAPACITY 默认初始容量是 16

int n = (sc > 0) ? sc : DEFAULT_CAPACITY;

// 初始化数组,长度为 16 或初始化时提供的长度

Node[] nt = (Node[])new Node[n];

// 将这个数组赋值给 table,table 是 volatile 的

table = tab = nt;

// 如果 n 为 16 的话,那么这里 sc = 12

// 其实就是 0.75 * n

sc = n - (n >>> 2);

}

} finally {

// 设置 sizeCtl 为 sc,我们就当是 12 吧

sizeCtl = sc;

}

break;

}

}

return tab;

}

4. 链表转红黑树: treeifyBin

前面我们在 put 源码分析也说过,treeifyBin 不一定就会进行红黑树转换,也可能是仅仅做数组扩容。

private final void treeifyBin(Node[] tab, int index) {

Node b; int n, sc;

if (tab != null) {

// MIN_TREEIFY_CAPACITY 为 64

// 所以,如果数组长度小于 64 的时候,其实也就是 32 或者 16 或者更小的时候,会进行数组扩容

if ((n = tab.length) < MIN_TREEIFY_CAPACITY)

// 后面我们再详细分析这个方法

tryPresize(n << 1);

// b 是头结点

else if ((b = tabAt(tab, index)) != null && b.hash >= 0) {

// 加锁

synchronized (b) {

if (tabAt(tab, index) == b) {

// 下面就是遍历链表,建立一颗红黑树

TreeNode hd = null, tl = null;

for (Node e = b; e != null; e = e.next) {

TreeNode p =

new TreeNode(e.hash, e.key, e.val,

null, null);

if ((p.prev = tl) == null)

hd = p;

else

tl.next = p;

tl = p;

}

// 将红黑树设置到数组相应位置中

setTabAt(tab, index, new TreeBin(hd));

}

}

}

}

}

5. 扩容:tryPresize

这里的扩容也是做翻倍扩容的,扩容后数组容量为原来的 2 倍。

// 首先要说明的是,方法参数 size 传进来的时候就已经翻了倍了

private final void tryPresize(int size) {

// c:size 的 1.5 倍,再加 1,再往上取最近的 2 的 n 次方。

int c = (size >= (MAXIMUM_CAPACITY >>> 1)) ? MAXIMUM_CAPACITY :

tableSizeFor(size + (size >>> 1) + 1);

int sc;

while ((sc = sizeCtl) >= 0) {

Node[] tab = table; int n;

// 这个 if 分支和之前说的初始化数组的代码基本上是一样的,在这里,我们可以不用管这块代码

if (tab == null || (n = tab.length) == 0) {

n = (sc > c) ? sc : c;

if (U.compareAndSwapInt(this, SIZECTL, sc, -1)) {

try {

if (table == tab) {

@SuppressWarnings("unchecked")

Node[] nt = (Node[])new Node[n];

table = nt;

sc = n - (n >>> 2); // 0.75 * n

}

} finally {

sizeCtl = sc;

}

}

}

else if (c <= sc || n >= MAXIMUM_CAPACITY)

break;

else if (tab == table) {

// 我没看懂 rs 的真正含义是什么,不过也关系不大

int rs = resizeStamp(n);

if (sc < 0) {

Node[] nt;

if ((sc >>> RESIZE_STAMP_SHIFT) != rs || sc == rs + 1 ||

sc == rs + MAX_RESIZERS || (nt = nextTable) == null ||

transferIndex <= 0)

break;

// 2. 用 CAS 将 sizeCtl 加 1,然后执行 transfer 方法

// 此时 nextTab 不为 null

if (U.compareAndSwapInt(this, SIZECTL, sc, sc + 1))

transfer(tab, nt);

}

// 1. 将 sizeCtl 设置为 (rs << RESIZE_STAMP_SHIFT) + 2)

// 我是没看懂这个值真正的意义是什么?不过可以计算出来的是,结果是一个比较大的负数

// 调用 transfer 方法,此时 nextTab 参数为 null

else if (U.compareAndSwapInt(this, SIZECTL, sc,

(rs << RESIZE_STAMP_SHIFT) + 2))

transfer(tab, null);

}

}

}

这个方法的核心在于 sizeCtl 值的操作,首先将其设置为一个负数,然后执行 transfer(tab, null),再下一个循环将 sizeCtl 加 1,并执行 transfer(tab, nt),之后可能是继续 sizeCtl 加 1,并执行 transfer(tab, nt)。

所以,可能的操作就是执行 1 次 transfer(tab, null) + 多次 transfer(tab, nt),这里怎么结束循环的需要看完 transfer 源码才清楚。

5. 数据迁移:transfer

下面这个方法很点长,将原来的 tab 数组的元素迁移到新的 nextTab 数组中。

虽然我们之前说的 tryPresize 方法中多次调用 transfer 不涉及多线程,但是这个 transfer 方法可以在其他地方被调用,典型地,我们之前在说 put 方法的时候就说过了,请往上看 put 方法,是不是有个地方调用了 helpTransfer 方法,helpTransfer 方法会调用 transfer 方法的。

此方法支持多线程执行,外围调用此方法的时候,会保证第一个发起数据迁移的线程,nextTab 参数为 null,之后再调用此方法的时候,nextTab 不会为 null。

阅读源码之前,先要理解并发操作的机制。原数组长度为 n,所以我们有 n 个迁移任务,让每个线程每次负责一个小任务是最简单的,每做完一个任务再检测是否有其他没做完的任务,帮助迁移就可以了,而 Doug Lea 使用了一个 stride,简单理解就是步长,每个线程每次负责迁移其中的一部分,如每次迁移 16 个小任务。所以,我们就需要一个全局的调度者来安排哪个线程执行哪几个任务,这个就是属性 transferIndex 的作用。

第一个发起数据迁移的线程会将 transferIndex 指向原数组最后的位置,然后从后往前的 stride 个任务属于第一个线程,然后将 transferIndex 指向新的位置,再往前的 stride 个任务属于第二个线程,依此类推。当然,这里说的第二个线程不是真的一定指代了第二个线程,也可以是同一个线程,这个读者应该能理解吧。其实就是将一个大的迁移任务分为了一个个任务包。

transfer 这个方法并没有实现所有的迁移任务,每次调用这个方法只实现了 transferIndex 往前 stride 个位置的迁移工作,其他的需要由外围来控制。

6. get方法

- 计算 hash 值

- 根据 hash 值找到数组对应位置: (n – 1) & h

- 根据该位置处结点性质进行相应查找

- 如果该位置为 null,那么直接返回 null 就可以了

- 如果该位置处的节点刚好就是我们需要的,返回该节点的值即可

- 如果该位置节点的 hash 值小于 0,说明正在扩容,或者是红黑树,后面我们再介绍 find 方法

如果以上 3 条都不满足,那就是链表,进行遍历比对即可