一文读懂简化的图卷积网络GCN(SGC)| ICML 2019

GCN vs MLP

Feature propagation 特征传播

Feature transformation and nonlinear transition

分类器

线性化

逻辑回归

优化细节

Performance

Efficiency

这种简化了的线性SGC模型在很多任务上比GCN和一些其他GNN网络更高效,并且参数更少

并且在效率方面,在Reddit数据集上比FastGCN快两个数量级

SGC在文本分类、用户地理定位、关系提取和zero-shot图像分类任务方面,即使不能超越基于GCN的方法,但至少也是竞争对手

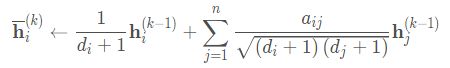

特征传播

线性转换

逐点非线性激活

S表示添加自循环“normalized”的邻接矩阵(实际上并没有归一化)

A˜=A+1是A \mathbf{A}A的度矩阵

D˜是A的度矩阵

一个固定的(没有参数,parameter-free)的特征提取器(或平滑器smoothing component)

特征提取器后是一个线性逻辑回归分类器

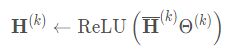

Spectral networks and locally connected networks on graphs,ICML 2014-首次提出了一个扩展到图上的基于谱图理论的CNN网络

Convolutional neural networks on graphs with fast localized spectral filtering,NIPS 2016-通过使用切比雪夫多项式近似消除了拉普拉斯矩阵分解带来的巨大的计算开销,定义了图卷积

Semi-supervised classification with graph convolutional networks,ICLR 2017-通过使用预先定义的传播矩阵S SS进行一阶切比雪夫近似,极大的降低了图卷积的计算,正式提出GCN

Inductive representation learning on large graphs(GraphSAGE),NIPS 2017-Hamilton等人提出了一个inductive的图卷积,使用固定邻居size采样,然后进行邻居特征聚合

Diffusion-convolutional neural networks,NIPS 2016;;NGCN: Multi-scale graph convolution for semi-supervised node classification,2018;Lanczosnet: Multi-scale deep graph convolutional networks,ICLR 2019-利用多尺度信息,将邻接矩阵S SS提升到更高的阶

How powerful are graph neural networks?,ICLR 2019-研究L图神经网络对任意两个图的区分能力,并引入图同构网络,证明其与图同构的Weisfeiler-Lehman检验同样强大

Predict then propagate: Graph neural networks meet personalized pagerank,ICLR 2019-利用神经网络和个性化随机游走将非线性变换与传播分离

Attention-based graph neural network for semisupervised learning,2018-提出了基于注意力机制的GCN

A simple yet effective baseline for non-attribute graph classification,2018-提出了一种有效的基于节点度统计信息进行图分类的线性baseline

Bootstrapped graph diffusions: Exposing the power of nonlinearity,2018-结果表明,使用线性特征/标签传播步骤的模型可以从自训练策略中提升效果

Label efficient semi-supervised learning via graph filtering,CVPR 2019-提出了一种广义的标签传播,并提供了一个类似谱分析的renormalization trick

Graph Attention Networks,ICLR 2018;Attention-based graph neural network for semisupervised learning,2018;Gaan: Gated attention networks for learning on large and spatiotemporal graphs,2018;Rethinking knowledge graph propagation for zero-shot learning,2018-这些基于注意力机制的模型为不同的边分配了权重,但是注意力机制也带来了内存的使用和巨大的计算开销

一篇基于图上的注意力模型的综述文章:Attention models in graphs: A survey,2018

DeepWalk:它依赖于截断的随机游走,并使用一种skip-gram来生成节点表示

Deep Graph Infomax (DGI),2019:用非监督策略学习图的节点表示,DGI通过最大化相互信息来训练一个图形卷积编码器

…

表2中,可以看出SGC和GCN的性能相当,并且在Citeseer数据集上比GCN高1%。性能提升的原因可能是由于SGC的参数更少较少了过拟合GCN中的过拟合的情况。

GIN中就有严重的过拟合。

LNet and AdaLNet在引文网络上不稳定。

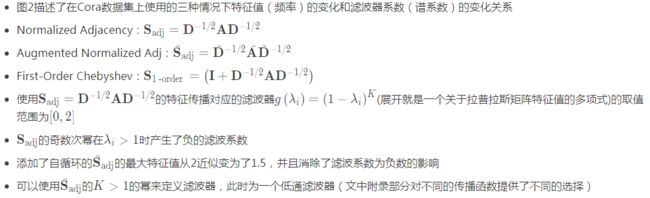

表3是在Reddit社交网络数据集上的实验。

SGC比基于GCN的变种GraphSAGE和FastGCN高1%。

DGI论文中表示随机初始化的DGI编码器的性能几乎与经过训练的编码器的性能相匹配;然而,这两种模型在Reddit上的表现都不如SGC。这个结果可能表明,额外的权重和非线性激活在DGI编码器中是多余的。

图3是在Pubmed和Reddit数据集上的效率对比图

显然,SGC是效率最高的

SGC中是预先计算的,SGC训练的时候只需要学习一个权重矩阵Θ,减少了内存的使用。

由于S通常是稀疏的,而K通常比较小,因此,可以用稀疏稠密矩阵乘法进行计算

无法在Reddit上对GaAN和DGI的训练时间进行基准测试,因为实验没有发布

GPU:NVIDIA GTX 1080 Ti

在大图上由于内存要求不能进行GCN的训练。FastGCN和GraphSAGE等方法使用采样的方法减少邻居数量来处理这个问题。Deep Graph InfoMax(ICLR,2019)通过限制模型的size来解决这个问题

SGC训练的时候比使用快速采样的FastGCN快两个数量级,并且性能几乎没有损失

text classification

semi-supervised user geolocation

relation extraction

zero-shot image classification

graph classification

(Graph convolutional networks for text classification,2019)使用2层的GCN来实现了一个state-of-the-art的结果,创建了一个语料库图,该图将文档和单词都视为图中的节点。

Word-word边的权值为点信息的互信息(point twise mutual information, PMI), word-document边的权值为标准化的TF-IDF socre。

如表4显示,一个SGC (K = 2)在5个基准数据集上与他们的模型竞争,同时达到了83.6倍的速度。

半监督用户地理定位(Semi-supervised user geolocation)根据用户发布的帖子、用户之间的关系以及少数被标记的用户,来定位用户在社交媒体上的“家”的位置。

表5显示,SGC在GEOTEXT、TWITTERUS和TWITTER-WORLD 的高速公路连接方面优于GCN,同时在TWITTER-WORLD上节省了30多个小时。

关系抽取包括预测句子中主语和宾语之间的关系。

C-GCN采用LSTM,后面接着GCN和MLP层。实验将GCN替换为SGC (K = 2)将得到的模型称为C-SGC

zero-shot image分类包括学习一个图像分类器,不需要从测试类别中获取任何图像或标签。

GCNZ使用GCN将类别名称映射到图像特征域,并查找与查询图像特征向量最相似的类别 - 表7显示,使用MLP替换GCN,然后使用SGC可以提高性能,同时将参数数量减少55%。

为了将预先训练好的GloVe向量映射到由ResNet-50提取的视觉特征空间,需要一个MLP特征提取器。

同样,这个下游应用证明了学习图卷积滤波器是多余的。

◆

公开课推荐

◆