Intel graphics HD 4600 核芯显卡 对比 nVIDIA Geforce GTX 750 2GB GDDR5 独立显卡 参数比较,3D Mark 性能测试

下面列出的这些比较项目与参数,来自于使用 CPU-Z 与 GPU-Z 工具,对相应的硬件进行检测的结果,

后面会给出使用 3D Mark 进行基准测试的软件版本以及相应硬件的得分,FPS(每秒帧数,可以作为对显卡或显示芯片性能进行综合判断的依据)

**********************************************************************

**********************************************************************

比较项目:GPU 内部代号

项目含义:

这是指生产商在开发该 GPU 时,公司内部使用的开发代号;

以 nVIDIA 而言,通常这与 GPU 的核心架构代号(一般使用物理学家的名字,例如 GM107 是"麦克斯韦"架构)有某种程度的关联;

图形显示芯片生产商在开发时,可以使用相同的内部代号(或核心架构代号),然后通过调整,更改流处理器的数量,显示核心的时钟频率,显存时钟频率,显存类型,显存数量以及位宽等可控因素,来衍生出一系列用于最终销售的不同型号的产品,

这不仅能丰富自己的产品线,而且有利于厂商在低,中,高端等不同市场需求下的销售策略布局,减少开发成本;

另外,同一个内部开发带号通常意味着相同的 GPU 核心架构,可以使用相同类型的驱动程序,这为显卡驱动程序开发人员编写驱动,以及用户通过内部带号查找,更新,下载,安装驱动等等,都提供了很大的便利.

| Intel HD 4600 | nVIDIA Geforce GTX 750 |

| GT2 | GM107 (Maxwell) |

***********************************************************************

***********************************************************************

比较项目: GPU 版本号(Revision)

项目含义:

该项目仅适用于 nVIDIA ,对于 ATI 与 Intel 的图形处理器而言,其没有 "GPU 版本号"的概念.

| Intel HD 4600 | nVIDIA Geforce GTX 750 |

| N/A | A2 |

***********************************************************************

***********************************************************************

比较项目: 制造工艺(Technology,制程技术,生产工艺)

项目含义:

制造工艺是衡量构成图形处理器内部的集成电路(Intergrated Circuit,IC)的各种电路,电子组件,元器件的特征尺寸大小,以及导线间连接的精度的重要指标;

制造工艺的精度在早期通常在微米(μm)量级;现在已经提升到纳米量级(nm),其数值越小,表示生产 GPU 时的精度越高,在相等面积的芯片上可以集成更复杂的电路,更多的元器件,最重要的是(从用户角度看),芯片的功耗也就更低;

1 mm(毫米)=0.001μm ; 1μm=0.001 nm

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 22 nm |

28 nm |

***********************************************************************

***********************************************************************

比较项目: (硅)芯片面积(Die Size)

项目含义:

对于 Intel HD 4600 而言,由于是集成在一个封装的 CPU 硅芯片的内部,因此这意味着整个 CPU 芯片的面积;

对于 nVIDIA 与 ATI 的 GPU 而言,这就是真实的图形处理器硅芯片的大小;

(硅)芯片面积以平方毫米(m㎡)为单位.

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 177 m㎡ |

148 m㎡ |

***********************************************************************

***********************************************************************

比较项目: 晶体管数量(Transistors)

项目含义:

晶体管数量以百万个(M)为单位;

对于 Intel HD 4600 而言,其有两种含义:整个封装的 CPU 硅芯片内的晶体管数量;或者是 CPU 硅芯片内部的 Intel HD 4600 显示芯片部件内的晶体管数量;目前尚无法确定,由 GPU-Z 给出的数字是表示哪一种.

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 1400 M |

1870 M |

***********************************************************************

***********************************************************************

比较项目: 显卡生产商 ID(Subvendor ID) 与 设备 ID(Device ID)

项目含义:

依照 GPU-Z 的解释,设备 ID 是指由图形处理器(GPU) 生产商自行指派的一组字符串标识符,前面的4个字符代表生产商 ID;后面的4个字符代表该设备(GPU)的 ID ;

我们知道,由于制造技术,经验,以及研发能力等诸多因素,桌面型 PC 使用的图形处理器市场份额一直被像 nVIDIA, AMD/ATI, Intel 这样的几家厂商所垄断;

上述这3家厂商虽然也自行生产所谓"公版"显卡,但多数情况下,他们仅生产,并销售

图形处理器芯片给一些第三方的"显卡制造商",例如 asus,gigabyte,elsa,msi 等等,由这些第三方厂商负责将图形处理器显示芯片集成在 PCB 版上,并添加显示存储器(显存),导热金属片,散热风扇,设计符合主流 PCI-Express 规范的显卡接口,以及

向显示器输出信号使用的接口类型等等;

而显卡生产商 ID 就是指这些第三方显卡制造商的 ID ,根据 GPU-Z 的解释,这个 ID 是由 PCI-SIG (PCI 特别兴趣小组,一个制定或审核 PCI 标准的国际化组织)分发给各个显卡制造商的 ID ,可以用来唯一地标识显卡制造商;

注意,有些显卡制造商并不会乖乖地在显卡 BIOS 中提供这个由 PCI-SIG 小组指派给他们的 ID (或者修改成其他 ID),而 GPU-Z 是读取显卡 BIOS 来显示某些信息,

这样,用户通过 GPU-Z 看到的这个 ID 可能不准确;一般情况下,对于绝大多数"一线显卡品牌大厂",这个值是可信的.在下面的例子中可以看出, PCI-SIG 分发给 gigabyte 的 ID 为 1458.

另外,对于 Intel 核芯显卡, 由于不存在第三方显卡制造商的概念,因此 GPU-Z 会将该项目显示成"与主板制造商相同的显卡制造商 ID",例如 asus 的 ID 为 1043.

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

|

| Device ID |

8086-0412 | 10DE-1381 |

| Subvendor ID |

asus(1043) |

gigabyte(1458) |

***********************************************************************

***********************************************************************

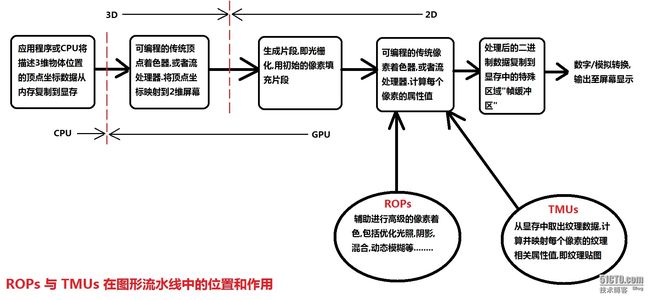

比较项目: ROPs/TMUs

(Raster Operations Units,光栅处理单元数量/Texture Mapping Units,纹理贴图单元数量)

项目含义:

ROPs 表示 GPU 中负责光栅处理的单元数量; TMUs 表示 GPU 中负责纹理贴图(也翻译成纹理映射,材质贴图等等)的单元数量;

总的来讲, GPU 中的这些单元数量越多,显卡的性能就越强劲;

我们知道,屏幕上的三维图像是用大量的小块二维多边形来模拟并填充的;

在传统的 GPU 渲染流水线模型中,首先顶点渲染管线(着色器)处理每个多边形的顶点数据(x,y,z 坐标),将3维顶点坐标转换为能在2维屏幕上显示的数据(几何转换),并生成线框多边型;然后填充这些顶点间的所有片元,即光栅化;

最后由像素渲染管线(着色器)计算片元中,每个需要最终在屏幕上显示的像素颜色,亮度,以及用于模拟其他特效,如光照,阴影,粒子物理系统等的高级像素属性,同时还要根据纹理数据再对每个像素作进一步处理;

而随微软的 DirectX 10 图形 API 提出的新一代的统一渲染架构(shader model 4.0)指出,顶点渲染与像素渲染都可以由一种叫做"流处理器"的硬件来完成,不需要依赖特定的着色器;

(着色器,即 shader ,实际上就是 GPU 内执行并行计算的上百个微型处理单元,传统的图形流水线模型规定:进行顶点坐标几何计算的 shader 为顶点着色器;进行片段颜色计算,即像素属性值计算的 shader 为片段或像素着色器;按照传统图形流水线设计的 GPU 内部渲染架构,其内部的顶点 shader 与 像素 shader 数量与功能都是固定的;也就是说,顶点 shader 不支持对像素的操作,反之亦然,

这意味着,当执行三维场景中需要生成大量的多边形的建模任务时,顶点 shader 全负载工作,而像素 shader 则闲着没事干;反之亦然,所以传统的渲染架构造成 GPU 内大量的并行计算资源的浪费)

光栅处理单元与纹理贴图单元就是在 GPU 渲染流程中(在光栅化之后),用于辅助传统的像素着色器或者现代的流处理器进行渲染计算,对像素属性进行高级操作的硬件,两者的区别以及作用,参考下图:

上图中"可编程的着色器或流处理器"含义是指,这些并行处理单元的功能不是固定的;

用户通过图形学 API (例如 OpenGL )内置的"着色语言"或者 GPU 计算语言(最显著的例子是 CUDA ,Compute Unified Device Architecture ,计算统一设备架构)

编写自定义的算法,可编程的图形硬件能识别并执行这些算法,从而改变原来固定的功能,实现更强大,更复杂的图形渲染方式,这也是如今多数复杂的三维动画或游戏特效的原理.

*****关于 CUDA 的介绍,请参考结尾的补充资料*****

从游戏玩家的角度看, ROPs 的数量影响着游戏画面的光照,阴影,雾,火焰爆炸特效,抗锯齿的级别(从1倍到32倍)等效果开启下,其流畅性,主要以每秒的帧率,即 FPS 来衡量;

而 TMUs 的数量则影响着游戏中三维物体的真实程度,表面的细节,贴图的二线性,三线性,各向异性过滤的级别(从1倍到16倍),以及是否支持环境凹凸贴图,多重纹理等高级纹理效果;

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 4/8 (ROPs/TMUs) |

32/32 (ROPs/TMUs) |

***********************************************************************

***********************************************************************

比较项目: 流处理器(shaders)数量

项目含义:

关于流处理器的信息请参考上一个项目中相关的介绍,流处理器既可以执行顶点渲染;也可以执行像素渲染,具备更广泛意义的通用计算功能(其 "Unified" 字段就是这一层含义);

例如, nVIDIA 的流处理器,每一个都是支持 CUDA 计算架构的可并行计算单元;

另外,Intel HD 4600 的流处理器不支持 CUDA 计算架构.

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 20 Unified | 512 CUDA core Unified |

***********************************************************************

***********************************************************************

比较项目: 像素填充速率(Pixel Fillrate)

项目含义:

正如这个听起来很前卫的术语所暗示的,它衡量 GPU 每秒能够生成多少"初始"像素来填充构成多边形的片段,通常以每秒十亿个像素(GPixel/s) 为单位;

GPU 内部微架构(或渲染模型)以及流处理器的数量,都会影响到像素填充速率的大小;

例如,从前一个比较项目我们知道, Intel HD 4600 有 20 个流处理器,因此它的像素填充速率为: 每秒14亿个像素;

nVIDIA Geforce GTX 750 有 512 个流处理器,因此它的像素填充速率为: 每秒339亿个像素,如下所示;

另外,常常可以听见一个容易与此混淆的术语: 多边形生成速率(以每秒百万个多边形为单位),GPU-Z 并没有将它列为检测并衡量显卡的技术参数之一,因为它不是 GPU "原生"的性能参数;我们可以粗略的认为,将像素填充速率除以多边形生成速率,就得出构成每个多边形的平均像素个数.

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 1.4 GPixel/s | 33.9 GPixel/s |

***********************************************************************

***********************************************************************

比较项目: 纹理填充速率(Texture Fillrate)

项目含义:

正如这另一个在显卡发烧友间经常论及的术语所暗示的,它衡量 GPU 每秒能够对多少个像素进行纹理映射(贴图)操作,即赋予像素与纹理相关的属性值,通常以每秒十亿个纹理元素(GTexel/s) 为单位;

在最简单的情况下,一个纹理元素映射到一个像素,有关纹理元素和纹理映射的更多细节,请阅读与计算机图形学相关的书籍;

GPU 内的 TMUs 数量与流处理器数量,共同决定了该 GPU 的纹理填充速率和质量;

| Intel HD 4600 | nVIDIA Geforce GTX 750 |

| 2.8 GTexel/s |

33.9 GTexel/s |

***********************************************************************

***********************************************************************

比较项目: 支持的 DirectX/Shader Model 版本

项目含义:

DirectX 与 Shader Model 分别是微软推出的图形 API 与渲染模型;

DirectX 包含一系列在 windows 平台下开发多媒体应用的接口组件: Direct3D 用于实现三维特效,被绝大多数游戏厂商使用;

DirectSound,DirectInput,DirectOutput 等组件 API ,也是开发,增强其它多媒体应用的音效与用户交互体验时不可或缺的;

游戏厂商想要实现更复杂,炫目的效果,就必须尽可能地使用最新版本的 DirectX 中的 API 函数来开发游戏(游戏厂商日益依赖于 DirectX 来实现特效,或是节省开发成本);而 GPU 制造厂商为了支持更多最新游戏的特效,就等同于需要支持最新版的 DirectX;

在桌面型 PC 娱乐市场,游戏与 GPU 开发厂商似乎都不得不跟随这个由微软制定的"游戏规则",才能保证自己的产品有较高的市场份额与利润;

与此相反,在学术研究以及工业绘图领域,类似 OpenGL 这样开源的图形 API 则是行业标准,它不是由一家公司所垄断,而且没有强制与任何操作系统"捆绑";

任何第三方机构,团体都可以向其中添加新的特性,功能,只是要经过标准委员会的审核---这总比微软一手遮天,然后其它厂商被牵着鼻子走要强.

Shader Model 是微软提出的渲染模型,类似 OpenGL 的图形流水线概念,不同之处在于,Shader Model 4.0 版本提出了统一渲染架构,它要求 GPU 制造商将原来功能分立的顶点与像素着色器,改为以通用的处理单元来实现,其目的无非是为了巩固自己在桌面 PC 娱乐市场的图形 API 垄断地位,于是,AMD/ATI 与 nVIDIA 分别提出了符合微软统一渲染架构的新版 GPU 渲染架构;例如,流处理器就是符合微软统一渲染架构的 nVIDIA 版本.

以纯粹游戏玩家的角度而言,GPU 支持的 DirectX/Shader Model 版本越新,才能实现更多的游戏特效,然而,默认情况下,DirectX/Shader Model 的版本取决于 windows 的版本,例如,windows XP 仅"捆绑"了 DirectX 9.0c ,windows 7 则支持

DirectX 11 , DirectX/Shader Model 的当前最新版为 11.1/5.0 ,可以通过在 windows 的 "开始"-> "运行" 对话框中,执行 dxdiag 命令,查看你的系统上的

DirectX 版本,许多以光盘形式发售的游戏,以及显卡厂商提供的显卡驱动程序,都提供可以作为独立组件安装的最新版 DirectX ,用来替换系统上旧版的 DirectX.

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

| 11.1/SM5.0 |

11.0/SM5.0 |

***********************************************************************

***********************************************************************

比较项目: 显卡与外界(通常是主板芯片组或 CPU)交换数据的接口类型以及速度

| Intel HD 4600 |

nVIDIA Geforce GTX 750 |

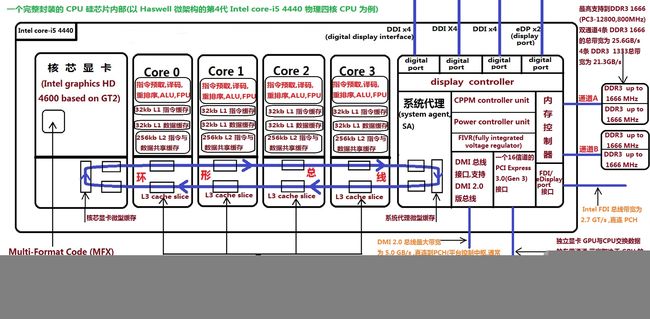

以桌面型第4代 intel core (酷睿) 处理器的 Haswell 微架构而言(请参考下方的示意图),由于核芯显卡直接集成在 CPU 硅芯片内部,所以没有接口类型的概念; 至于带宽,则取决于连接每个 CPU 核心与核芯显卡之间的"环形总线"带宽, 由于 Intel HD 4600 与各个 CPU 核心之间交换数据的总线是在 CPU 内部,因此是专用的,不像传统的主板(共享)系统总线,需要汇集并交换包含来自独立显卡,SATA 磁盘,网卡等在内的各种设备的数据,减少了显卡实际能使用的总线带宽,造成独立显卡与 CPU 之间数据传输的瓶颈。 这也是核芯显卡对比连接传统总线结构主板的独立显卡的唯一优势所在。 |

桌面型第4代 intel core (酷睿) 处理器的 Haswell 微架构直接在 CPU 硅芯片内部集成了支持 PCI Express 3.0 x16(PCI-E Gen 3)接口规范的"专用"通道,可以"直连"使用 PCI Express 3.0 接口的独立显卡(尽管从表面上看,独立显卡似乎是通过主板上的 PCI-E 3.0 x16 插槽,再经由主板芯片组与 CPU 通信) 这个在 Haswell CPU 与独立显卡之间的专用 PCI-E 通道的带宽,取决于两者支持的 PCI Express 规范版本,例如,独立显卡的接口支持 PCI Express 3.0 x16 规范 ;并且 Haswell CPU 内的 PCI-E 通道支持 PCI Express 3.0 x16 规范,那么这个专用通道在发送或接收方向的带宽就是 16GB/s 注意 一,取决于 PCI Express 3.0 规范自身定义的节能(电源管理特性), 如果 Haswell CPU 与独立显卡都实现(并开启)了这个特性,那么专用通道的带宽是动态变化的,例如,在 GPU 高负载工作时,其链路带宽为 16 GB/s(Gen 3) ;当 GPU 闲置时,其链路带宽会降低到与 Gen 1 (PCI Express 1.0 x16)相同,即 4 GB/s 二,不要忘记,还需要主板有支持 PCI Express 3.0 x16 规范的插槽 |

项目含义:

关于 intel Haswell 微架构的内部组织,与 PEG(PCI Express 显卡)通信的专用通道,以及各种版本的 PCI Express 规范的数据传输速率(带宽),请参考下面几张示意图:

从上图可以看到,Haswell 微架构的 CPU 内部由三个主要组件构成:核芯显卡,CPU核心,以及系统代理,环形总线连结这三个组件各自的缓存,实现数据在 CPU 内部组件之间的高速传输.

因此,按照上面的架构,将图形处理器集成在 CPU 内部,以及为独立的高性能图形处理器提供专用的 PCI Express 3.0 x16 高速通道,彻底解决了传统的平台架构中,

GPU 与 CPU 之间通信,需要经过 AGP/PCIe 总线,北桥芯片,共享系统总线....等低带宽,慢速总线的缺点;

Haswell 架构能满足 GPGPU 要求的高带宽,低延迟计算环境(可惜核芯显卡不支持当前最流行的 GPGPU 架构 CUDA ,因此只能使用 nVIDIA 图形处理器或其他支持 CUDA 的图形处理器)

关于 Haswell CPU 内部的 PCI Express* 接口特性,总结如下,其中部分内容是翻译自 Intel 网站上的原文文档中相关的介绍:

桌面型第4代 intel core (酷睿) 处理器上的 PCI Express* 接口,是单个 16 信道(x16)的端口,它也可以配置成窄带宽模式(一个8信道+2个4信道,1x8,2x4 ;

或者2个8信道,2x8),该接口完全兼容 PCI-SIG(PCI 特别兴趣组) 的 PCI Express Base Specification, Revision 3.0 规范,参考该规范的官方站点:

http://www.pcisig.com

第一代 PCI Express* 规范(PCI Express 1.0, Gen 1) 在数据针脚上的原始比特率为 2.5 GT/s,这导致每一对实际带宽为 250 MB/s的 PCI Express

信道提供 8b/10b 编码,用于通过该接口传输数据,这并没有将数据包的固有开销,以及链路维护信息计算在内;

该接口在单方向上(发送或接收)的理论最大带宽为同时 4 GB/s (250 MB * 16),因此,16信道的第一代PCI Express 规范 (x16 Gen 1) 的总带宽为:

每信道单向传输带宽*2(计算发送与接收的双向传输) * 信道数=250 MB/s * 2 *16 = 8 GB/s

实际的发送或接收吞吐量各自均为4 GB/s

第二代 PCI Express* 规范(PCI Express 2.0, Gen 2) 在数据针脚上的原始比特率为 5.0 GT/s,这导致每一对实际带宽为 500 MB/s 的 PCI Express

信道提供 8b/10b 编码,用于通过该接口传输数据,这并没有将数据包的固有开销,以及链路维护信息计算在内;

该接口在单方向上(发送或接收)的理论最大带宽为同时 8 GB/s(500 MB * 16) ,因此,16 信道的第二代 PCI Express 规范 (x16 Gen 2) 的总带宽为:

每信道单向传输带宽*2(计算发送与接收的双向传输) * 信道数=500 MB/s * 2 * 16 = 16 GB/s

实际的发送或接收吞吐量各自均为8 GB/s

第三代 PCI Express* 规范(PCI Express 3.0, Gen 3) 在数据针脚上的原始比特率为 8.0 GT/s,这导致每一对实际带宽为 984 MB/s 的 PCI Express

信道提供 128b/130b 编码,用于通过该接口传输数据,这并没有将数据包的固有开销,以及链路维护信息计算在内;

该接口在单方向上(发送或接收)的理论最大带宽为同时 16 GB/s (984 MB * 16) ,因此,16 信道的第三代 PCI Express 规范 (x16 Gen 3) 的总带宽为:

每信道单向传输带宽*2(计算发送与接收的双向传输) * 信道数 = 984 MB/s * 2 * 16 = 32 GB/s

实际的发送或接收吞吐量各自均为16 GB/s

Gen 3 PCI Express* (的配置架构) 使用 128b/130b 编码,它比使用 8b/10b 编码的 Gen 1 与 Gen 2 高出约 23% 的效率;

Haswell CPU 内部的 PCI Express* 接口,支持动态(增减)带宽功能,也就是说,配置成使用 16 信道与 CPU 通信的支持 Gen 3 的显卡,可以 2.5 GT/s, 5 GT/s, 或 8 GT/s 等速率运作(取决于显卡 GPU 的负载而定)

Haswell CPU 内部的 PCI Express* 接口不支持 PCI Express* 设备的热插拔;

PCI Express* 的基准时钟为 100-MHz 的差分时钟;

用于直连独立显卡的 PCI Express* 链路通过 Haswell CPU 内部的 PCI 到 PCI 桥接结构映射,参考下面这张图,它是处理器直接支持 PCI Express* 独立显卡的原理:

下面这张图引用自网络上广泛流传的 Haswell 架构图,这是一个简化的示意图,它并没有描述 CPU 内部组件的详细结构(面向用户的宣传版本),注意它与第一张图之间的联系,可以相互比较,验证:

注意,Haswell 架构仅仅为独立显卡这个在桌面 PC 市场最重要的外围设备提供了直通 CPU 内部的通道,

至于其它一些外围设备,例如 SATA 接口磁盘/光驱,USB 存储设备,PCI Express 1.0/2.0 网卡...等等,需要通过各自的总线连接到 PCH (例如 Intel B85 芯片组),由 PCH 通过共享带宽的 DMI 2.0 系统总线或者 FDI 总线与 CPU 交换数据;

在极端的情况下,各种外围设备"挤"四条各自只有 500 MB/s 峰值带宽的 DMI 2.0 信道与 CPU 通信,每个设备分到的可用带宽并不多;

(DMI 2.0 是同步,并行,全双工总线;

同步,并行指整个 DMI 2.0 总线由四条独立信道构成,可以同时并行传输数据;

每条信道又分为发送子信道与接收子信道,可以同时发送与接收数据,因此是全双工,每个子信道带宽为 500 MB/s,因此发送方向的总带宽为 500 MB * 4 = 2 GB/s ,接收方向总带宽也是 2 GB/s ,整个 DMI 2.0 总线的吞吐量理论值就是 4 GB/s )

你的计算机系统上安装的外围设备越多,数据在 DMI 2.0 系统总线上的"流动速度"就越慢.(参考下面来自于 Intel 官网的

Intel B85 芯片组与处理器芯片构成双芯片平台的架构示意图)

可以看到,和传统的南北桥芯片组架构相比,最明显的改善是, CPU 与 DDR3 SDRAM (第三代双倍数据速率同步动态随机访问存储器)之间的专用通道;

以及 CPU 与 PCI Express 3.0 x16 独立显卡之间的专用通道;

为了切合本篇博文与显卡相关的内容,对于双芯片平台架构的其余部分,也就是 PCH

内部集成的其它类型总线控制器,例如管理通用串行总线(USB,包括最新的 USB 3.0 标准)的 xHCI 主控制器;

管理串行 ATA 总线(SATA,包括最新的 SATA 3 标准,理论最大传输速率为 6.0 Gb/s ,SATA 2 标准的理论最大传输速率为 3.0 Gb/s ,SATA 1 ,通常是内置光驱使用的标准,理论最大传输速率为 1.5 Gb/s)的 SATA 主控制器(以及用于 SATA 总线的高级主控制器接口,Advanced Host Controller Interface, AHCI 规范);

集成的千兆以太网卡控制器,支持 10/100/1000 Mbps 的以太网标准,自动协商速率,支持通过 PCI Express 2.0 x1 总线连接独立网卡;

上述这些总线控制器,以及其它重要的 PCH 组成部分,以后会开辟专门的章节来讨论,并再次引用这张图表.

***********************************************************************

***********************************************************************

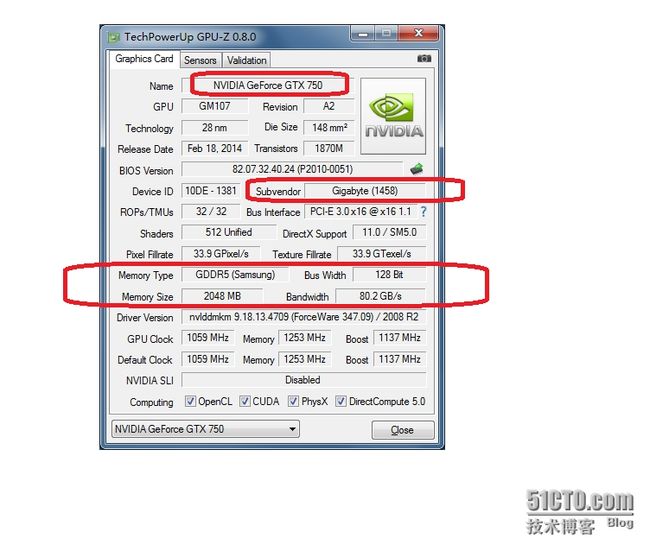

比较项目: 显存类型与制造商

项目含义:

只有独立显卡才有自己的显存,集成显卡(或核芯显卡)使用系统共享的内存,作为自己的显存;一般而言,在 BIOS 中可以调整给集成显卡使用的内存大小,多数上限为

1 GB ,例如,假设你的系统内存为 8 GB ,分配给集成显卡 1 GB ,那么在 windows

资源管理器中可以看到 "为硬件保留的内存",其中的 1GB 部分,就是系统预留给

集成显卡的,实际可用系统内存将为 7 GB ;

多数生产内存颗粒的厂商,也向显卡制造商供应显存颗粒.常见的内存/显存颗粒制造商有三星(Samsung),海力士(现代,Hynix)等.

GDDR5 显存是目前桌面 PC 市场主流,以三星生产的单颗 GDDR5 显存颗粒为例,

其位宽为 32 bits,容量为 512 MBytes ,时钟频率为 5GHz;

在下面这张截图中,使用 nVIDIA Geforce GTX 750 的技嘉显卡,集成了4个三星的

GDDR5 显存颗粒,因此,这张显卡的显存(总)位宽为 32 * 4 =128 bits;

显存容量为 512 * 4 =2048 MBytes;

由于单颗显存颗粒带宽 = 显存颗粒时钟频率 * 显存颗粒位宽,

所以这张显卡的显存带宽为 4 * (5GHz * 32bits/8) = 80 GBytes/s

***********************************************************************

*****补充资料*****

CUDA (Compute Unified Device Architecture ,计算统一设备架构)

大约与 nVIDIA Geforce 8000 系列显卡同时推出,与以往的图形学 API 着色语言/GPU 编程语言不同, CUDA 不再面向图形计算,而是一个完整的 GPU 通用计算框架;

CUDA 提供编译器和开发工具,让开发人员可以用一种类似 C 风格的编程语言来开发

GPGPU 程序,该程序能同时运行在 CPU 与 GPU 上,实现利用异构计算资源(CPU+GPU)

的协同计算.

CUDA 提供的专用 GPGPU 语言称为 CUDA C ,它提供给开发人员一个完整的接口,用来访问支持 CUDA 架构的 nVIDIA GPU 的本地命令集,存储器等并行计算元素,让它们变成像 CPU 一样的开放式,可访问的架构.

整个 CUDA 框架以 CUDA SDK 软件开发工具的形式实现与发布;提供了针对主流操作系统,如 windows , linux , Mac OS 等的不同版本;

CUDA C 是 C 语言的变种,不支持 C 的某些特性,例如函数指针,递归函数,同时扩展了一些简单的指令; CUDA 提供的 nvcc 编译器,负责编译 C 源文件中,与 CUDA C 语法相关的部分,并将传统的 C 代码交由 C 编译器编译;

CUDA 框架下的 GPU 通用计算(非图形渲染计算)大致分为下面4个步骤:

1. 把需要处理的数据从系统内存复制到显存

2. CPU 把程序指令发送给 GPU

3. GPU 内的计算单元从显存中读数据,并行计算,再将结果写入显存

4. 把显存中的计算结果复制到系统内存中