聊聊 VR 的「今生前世」,顺便给 Magic Leap 泼点冷水|原汁原创

~洪泰原汁原创~

洪泰新鲜出品,原汁原味

VR 的前途是光明的,光明到可以照瞎双眼;VR 的道路是曲折的,曲折到可以折断双腿。在通向终极 VR 的道路上,唯有踩着先烈们的遗体,舔舐着自己的伤口,不怕牺牲,艰苦奋斗,迈过一个又一个深不见底的大坑,才能最终到达顶点 。

踪视通,专注于视频压缩与通讯的技术公司。位于硅谷,成立于 2015 年 4 月,创始人中有三人来自谷歌,洪泰基金是其天使投资人。其旗舰产品「TrackView」(踪视通)是一款跨平台的移动安全监控软件。支持安卓、iOS 和Windows,可以把手机、平板、手表、电脑等智能器件动态连接起来,使之具有实时跟踪、监控、检测、报警、录像、对讲等一系列功能。踪视通已经在全球拥有近七百万用户,并且第一年就基本达到收支平衡。

最近VR很火,大火从美国烧到了中国,然后中国的火更旺,又烧回到了美国,一直火遍了全球。Facebook 的小扎于 2014 年以 20 亿美元收购了 Oculus, 为最近的 VR 点了第一把火,然后 Magic Leap 凭借一段被刷屏的 Magic 视频获得了谷歌及阿里巴巴超过十几亿美元的投资,又为 VR 火上浇了汽油。现在从国际超级大公司如 Google、Facebook、Apple、 Microsoft、Samsung,到国内的 BAT,再从 Magic Leap 到遍地的 Startups,都纷纷在这一领域布局。大量的 VC 投资也涌入这一领域。用「疯狂」来形容 VR 的火热程度毫不为过。难怪,许多激动的 AR/VR 粉丝们(其实主要是媒体朋友们)已经把 2016 年定义为 VR 元年。

著名的投行高盛还发布了洋洋洒洒数万言的 VR/AR 市场预测报告,称 VR/AR 将成为下一个计算平台,预计到 2025 年市场规模将达到 800 亿美元,其中 450 亿美元为硬件营收,350 亿美元为软件营收(标准预期)。高盛还列举了 VR/AR 主要的应用领域:视频游戏、事件直播、视频娱乐、医疗保健、房地产、零售、教育、工程和军事。

作为一个多年在视频领域摸爬的老兵,踪视通开发的视频技术也和 VR 有着许多紧密的联系。本文试图对 VR 技术及其应用做一些拆解和分析,算是给自己写个报告,同时希望能够对在这个领域打拼的技术帝、投资人有所帮助。纯属个人观点,错了不赔,仅供参考。

什么是 VR?

先定义一下什么是 VR。虽然有些可笑,但我相信很多人所理解的 VR 并不是同一回事。首先,VR 不是简单被动的双目 3D 视频。简单的双目 3D 视频已经存在 N 多年了,不是什么新鲜事,只是由于技术及其它因素的限制,没有成为一款大众产品。

VR 是一种全新的体验。首先 VR 有情景互动,观众可以根据自己的意愿随时改变观看的位置、角度和焦点等,并可以与 VR 中的人与物进行有效的互动。而不同的观众也可以从不同的位置、角度和焦距来观看,并选择进行不同的互动。所以,VR 不仅是一种全新的视觉体验,更是一种全新的互动体验。

其实早在 1935 年就有人在小说中幻想有一个魔力眼镜,戴上它就可以听到、看到、闻到、感触到各种东西,并且和故事中的人和物互动。这个对VR的描述一直到今天还是挺确切的。在一个成功的虚拟现实(Virtual Reality) 里,必须能够让观众看到、听到、感觉到一个接近真实(Real Reality)的现实,并可以与之互动 。这包含了我们身体感知世界的所有器官和部位:耳朵、眼睛、鼻子、嘴巴、手脚等。这个综合 VR 系统可以拆解为:声音 VR 、 视觉 VR 、嗅觉 VR 、 触觉/感觉 VR 。VR 系统另一个重要的概念是互动,只有有了互动,VR 才能有身临其境、沉浸式的渲染效果。

1 声音 VR

在这波 VR 大潮中,声音 VR 并不是一个热门的讨论话题。今天我们已经可以在家中通过多通道音箱系统模拟剧院的场景,就好像身临其境地听一场音乐会。通讯技术的发展也早已经使得人与人之间的语音互动成为现实,人的耳朵对声源的方向及距离并不敏感,而且目前的技术对声源及距离的模拟也有很有效的方法,所以,声音 VR 可以说是个基本解决的问题,这里不再讨论。

视频 VR 是今天几乎所有 VR 讨论的焦点。视频通讯在今天已经进入千家万户,视频聊天也成了很多人沟通的标配,电视、电影、网络视频、视频直播等也深入到生活的各个方面。我们今天看到的视频大都是平面的,没有身临其境的感觉,我们也无法选择不同的位置、不同的角度、不同的焦点来观看。视频 VR 技术的进步就是要解决这些问题,把眼睛看到的场景立体化,把选择权交给观众,无论从哪儿看,从哪个方向看,无论聚焦到哪个物体,都可以有身临其境的效果,并且给用户提供符合人性的、舒适的享受。

3 味觉/嗅觉 VR

不知道有没有研究嗅觉 VR 技术的小伙伴。貌似可以用一个味道检测器来检测味道,然后再做一个味道发生器来产生不同的味道,通过网络把检测到的味道编码传送到远端,然后通过味道发生器发出同样的味道。这个嗅觉 VR 系统是不是就 OK 了? 踪视通不是搞这个的,不再提了。

4 触觉/感觉 VR

我们的身体可以感觉到温度、湿度、力度、痛痒、劳累,甚至感觉到气氛,感觉到幸福,而且这些感觉可以是来自于身体的任何一个部位。在人与人、人与物的互动当中的这些因素是 VR 世界必不可少的,不过这一领域的研究目前基本还是在科幻小说里。也许一个可穿戴 VR 设备可以解决这些问题。这个 VR 衣服可以让你的身体感受到 VR 世界的环境,同时把你的感受检测出来,传递给 VR 世界中其他相关的人。你可以和 VR 里的人握手拥抱、拳打脚踢,并真实的感受这一切。设想一下吧,穿上一套 VR 衣服,戴上一副 VR 眼镜,就进入到了一个梦幻的 VR 世界。

一个包含声音、视频、味觉/嗅觉、触觉/感觉,并且可以互动的 VR 系统在今天依然是天方夜谭,很多的技术还远远不具备。人体动作的捕捉和各种互动技术还基本处于原始社会的水平,海量的视频数据所需要的处理、存储、传输等步骤也是必须解决的问题。我相信,只有当我们能够完美的解决掉这些问题,做出大众喜闻乐见,且价格合理的产品,辅以丰富多彩的内容,VR 才可能(只是可能)真正爆发。

视频 VR 系统

今天当大家谈论 VR 的时候,主要是聚焦在视频 VR 。下面就主要分析一下视频 VR 系统的技术难题,看看一个完美的视频 VR 系统离我们还有多远。

一个视频 VR 子系统包括几个大的模块:

根据应用的不同,VR 视频可能是电脑模拟产生的,也可能是传感器(摄像头)采集而来。当然,VR 的内容也可以是由电脑模拟和传感器/摄像头采集混合而成,还可以是不同传感器/摄像头在不同的地点、不同方向,或者不同时间拍摄的视频合成而成。有些专家马上就指出来了,这已经不是 VR,而是 AR 或者是 MR。我们在这里不谈术语,只谈应用场景。至于应该归入VR、AR 、MR, 还是留给语言学家去讨论吧。简单起见,我们在这里把 VR、AR、MR 统统归入一个范畴,并简称为 VR。

熟悉 VR 的人应该都知道拍摄 360 度全景视频的相机矩阵,简单的有几个、多的有几十个相机从不同的角度来拍摄视频,经过矫正、对接等算法,把多个相机拍摄的视频链接成一个 360 度(或者大角度)的视频序列。 由于 VR 沉浸式体验的要求,VR 视频对刷新率有较高的要求,一般至少要达到 60fps 甚至 120fps,同时对视频的分辨率也有很高的要求,一般成像的分辨率要达到 2K(1920x1080),有些要求更高的甚至达到 4K(3840x2160)。再加上多角度相机阵列(比如说 8 个), 其产生的数据量是海量的。和今天一般的单角度平面高清视频(1080p, 30fps)相比,360 度全景 VR 视频的数据量需要增加 128 倍甚至更高。

对于 Magic Leap 等公司宣扬的光场(Light field))VR,则需要把相关空间中的光场信息都采集下来,从而使得观众在不同的位置、不同的方向、不同的焦点,都能看到身临其境的 3D 效果。目前知道的光场相机大约有三种:微透镜阵列、相机阵列和掩膜及孔径处理。无论哪种方案,其需要采集的信息量都相当于用一个相机阵列从不同的距离来聚焦。 根据空间分辨率(采样率)的不同,其信息量大约相当于几十个甚至几百个相机采集视频的总和。和一般的 360 度全景视频比较,光场 VR 的数据量又大约增加了几十倍甚至几百倍,而和今天的单角度 2D 平面高清视频相比,数据量则猛增了数千倍甚至更多。

有了「虚拟现实」的视频内容,这些内容再通过媒介显示出来,最后被人的眼睛接收而传递给大脑。普通的双目 3D 显示目前技术已经较为成熟,如各个厂商推出的头显、3D 眼镜等都可以用来呈现 3D 视频。目前主要的问题是显示屏刷新率不高,分辨率也偏低。相信这些都可以较快得到提升,技术上已不是问题。

关于眩晕的问题,这应该是多种因素综合造成的。首先它和人的神经系统有关。比如,有的人坐车会晕,而有的人就不会。其主要是由眼睛看到的「虚拟现实」,与大脑预测的「现实」以及与身体其它部位感受到的「现实」,不协调或不匹配造成的。这些分裂的「现实」就必然会造成眩晕。Magic Leap 等公司倡导的光场 VR 有可能解决其中一个问题——聚焦问题,但这绝对不是造成眩晕的唯一问题。

当 VR 系统接近完美,可以以假乱真的时候,在很多场景下可能会造成更大的眩晕。比如说,当一个人现实中坐在沙发上,而在虚拟现实中开车狂奔时,产生眩晕大概就变得不可避免。虚拟现实和现实的脱节,可能是 VR 固有的硬伤。另外,佩戴头显在很多场合也是违反人性的。头显能不能成为一个大众愿意接受的产品形式,这个还需要时间来考验。

关于光场 VR 视频的呈现问题,目前还没有看到实际可行的解决方案。据说,可以用光纤直接把光场信号投射到眼睛的视网膜上,就可以让人看到逼真的光场 VR。从科研角度看,光场 VR 还是非常值得期待的,希望能有机会看到真正的光场 VR 成像产品。

根据应用的不同,许多视频 VR 的内容是远程传输而来。比如体育比赛直播,VR 的视频流需要从比赛场馆的摄像装置经过处理、压缩、传输到用户的接收设备上。ITU-T 和 ISO/IEC 已经开发了大约五代视频压缩编码标准,可以用来压缩 VR 视频。只是 360 度 VR 的海量数据的实时压缩成本还太高,可能需要一个强大的计算机阵列才能完成。

VR 的视频编码可以有两种不同的方法:

这个方案的优点是,目前的视频编码标准如 H.264/AVC、 HEVC, 或Google VP8、 VP9,中国的AVS-1、AVS-2 等都可以作为标准的 Codec 使用。由于所有的视频画面都一起压缩,一起传输,观众在接收端可以通过反馈选择观看不同的位置、角度、焦点等,反应速度快,互动体验好。然而,这样的传输方案对网络带宽资源有着极高的要求。前面讨论过,和今天的 1080p 30HZ 2D 平面视频相比,一个 360 度全景 VR 视频的数据量会增加百倍。如果是光场 VR 方案,那视频流的数据量会增加数千倍。无论从处理能力上,还是需要的带宽上,都是个大问题。

在一个特定的时刻,观众的眼睛会集中在某一个角度,而不是 360 度,那我们只需要传输需要观看的部分就可以满足要求, 这样可以节省大量的带宽资源。但是 VR 是一个用户可以参与互动的系统,观众可以随时改变观看的方向,聚焦自己感兴趣的部分,甚至转身,而且每一个观众可能会观看不同的方向或者不同的焦点。也就是说,每个人的视频流都可能是不一样的。并且,随着每个观众观看内容的变化,在远端的编码必须实时做出反应。这就对视频编码、传输系统的实时性提出了很高的要求,必须具有极低的延时。在这一点上,踪视通视频编码传输系统是目前世界上延时最低的系统。

同时这也意味着每个观众必须要有一个自己的实时转码器。想象一下,一个数百万观众的 VR 演唱会,那就需要数百万台转码器来支持。对视频编码不熟悉的朋友可以脑补一下:一台强悍的 PC 大约可以支持一路 VR 视频的实时编码。如果 VR 今天腾飞,硬件实时转码器绝对是个大生意。

当然从视频编码角度看,如果能够设计一个允许随机提取其中的一部分进行独立解码的视频压缩标准,那就不再需要实时硬件转码器来支持。目前还没有这样的视频编码标准,踪视通愿和其他在视频编码领域的同仁一起努力,开发适用于 VR 系统的编码标准。

VR 应用场景

鉴于 VR 技术的现状,我们回过头来再看一下高盛的 VR 报告中提到的几个主要应用场景。

VR 游戏可以完全由电脑模拟产生,并且和视频相关的全部内容都可以存储在局部电脑或游戏机上,从而不受网络带宽的限制。而电脑或游戏机也基本属于专用,处理能力技术上不是问题。对于游戏迷来说,在游戏过程中佩戴头盔似乎也不是什么问题,所以 VR 游戏的爆发是最有可能性的。

身体动作的精准扑捉以及游戏的互动可能是影响 VR 游戏发展的两个最大因素。由于游戏的互动对精确度要求很高,比如瞄准、拳击、握手、拥抱等,对动作的精准捕捉要求也非常高,因此应该还有很长的路要走。

另外,由于游戏的现实场景基本是在家里,而游戏的场景可以是千变万化,所以和游戏角色的互动也存在很大的限制,比如说奔跑、行走等。好的 VR渲染会逼近实际场景,如果玩家只有眼睛和大脑进入角色,但是身体却不行,那这是个悖论。VR 游戏的设计可能会有些局限性,但这可能挡不住游戏玩家进入 VR 世界。一些简单的互动游戏,加以绚丽生动的 VR 画面,应该是 VR游戏前期的主流。随着技术的进步,互动性更好、内容更丰富的游戏会渐渐出炉,从而又进一步推动 VR 游戏的发展。

综上所述,踪视通对 VR 游戏持乐观态度。但是,游戏一直不是大众市场,复杂的互动 VR 游戏可能属于小众中的小众。

事件直播需要把 VR 视频信号从远程传输到用户接收端。目前的互联网上 90% 的带宽都已经被视频占用,而一个渲染力较强的 VR 视频需要占用百倍以上的带宽,或者几乎是无限的计算资源。如果是光场 VR,那带宽的占用甚至会增加数千倍。随着网络技术、压缩技术,以及计算技术的发展,这一问题会逐步得到缓解。但是,一个消耗十倍、百倍、甚至千倍互联网资源的应用到底给用户带来了什么? 一个沉浸式 VR 体验是不是值得如此代价? 值得思考。

从实用出发,一个没有互动,或者具有较大限制的 VR 直播,甚至是简单的双目 3D 直播是不是就已经基本满足了直播的要求?或者说 VR 直播本来就是个伪命题?

这个是踪视通最看好的领域。原因是,视频娱乐可以在控制的环境中进行(比如电影院、家庭影院等),没有网络带宽问题。VR 给了导演一个全新的维度去展示其想象力,好的内容决定了 VR 视频娱乐的成败,让我们拭目以待。

由于光场 VR 所需要的海量数据处理、压缩、传输等问题,其复杂度和成本的增加已经远远超出了其所能带来的价值。 另外光场 VR 的显示问题目前还没有任何成熟方案。踪视通认为,未来 10 年,这一技术不可能达到实用。Magic Leap 终将转型或倒闭,没有其它选择。

鉴于 VR 视频所产生的海量视频数据,更先进、高效的压缩算法和标准成为必须。鉴于互联上 90% 的数据已经是视频,压缩效率每提高一倍,就相当于重新建造一个相同规模的互联网,其经济价值可想而知。假设今天 VR 视频的使用规模像普通视频一样,而压缩算法也完全不变,我们大约需要再建造数百个甚至数千个现在的互联网!

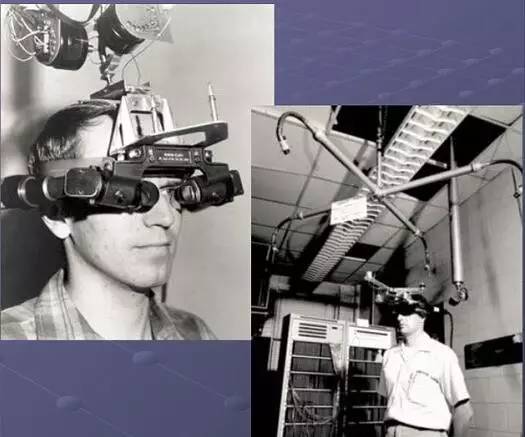

其实,VR 这事在历史上已经热闹过几次了。早在 1935 年就有人在幻想着前几年的 Google 眼镜,戴上它就可以听到、看到、闻到、感触到各种东东,并且和故事中的人和物互动。这不就是今天我们热炒的 VR 吗?VR 「头显」也不是什么新鲜事,在1963年一个 MIT 的博士生(Ivan Edward Sutherland)还真的把这个 VR 的「头显」给做出来了,只不过,这个「头显」后面连了几吨重的计算机。 当时这个研究是由美国军方资助的,为模拟飞行训练而设计。显然,美国军方并没有能够实际用上这个系统,但是却也为几十年后一拨又一拨的 VR 热潮提供了原形。

说起这个 Ivan Sutherland , 不得不多说几句,因为他基本就是世界计算机图形学之父。他本科毕业于 Carnegie Institute of Technology ,也就是Carnegie Mellon University 的前身,是美国计算机专业最好的大学之一,看来美国大学在早期也玩合并改名的勾当。本科毕业后到 CalTech 读硕士,后来又到 MIT 读博士。他的博士导师有个吓死人的名字,叫 Claude Shannon——就是信息论的鼻祖、著名的山农定律的 Shannon。从 Ivan Southerland 读的学校就可以看出,他是个典型的学霸级别的理工男。Ivan Southerland 后来在多所美国大学任教并从事科研活动,创办过自己的公司 Evans and Southerland,以及 Sutherland, Sproull and Associates,后者被 Sun Micro 收购,他从而进入 Sun Micro 担任 VP。 他得过的奖项也可以列一排,包括图灵奖、IEEE、 冯诺曼奖等。和许多最领先的技术一样,这个超前的研究是由美国军方资助的,为模拟飞行训练而设计。由于当时计算机的计算能力等各方面的限制,从实用角度而言,这无疑是个失败的项目。从研究角度看,他的研究开创了计算机图形学及人机交互的先河。他也以此获得了大量的殊荣,除了他已有的「计算机图形学之父」的佳冠外,把他称为 VR「头显」之父大概也毫不为过。

Ivan Southerland 博士论文之后,很久都没人再做 VR 了(包括 Ivan Southerland 自己),因为这实在是超前时代太多了。事实证明,在大学实验室由超级学霸搞科研搞出来的东西,一般会领先时代几十年,甚至几百年——只有这样才能显出他们的与众不同嘛。

20 年后, 1983 年美国 NASA 又重新开始考虑开发用于火星探测的虚拟环境显示器,用于宇航员太空工作训练 。这时候,计算能力大幅增强,计算机已经大规模商用,并且引领世界悄悄进入了 PC 时代。而就算在这一时代,VR 设备依然耗费数百万美元,并且效果非常不理想。这时候,又一个天才出现了,他的名字叫 Aron Zepel Lanier 。和 Ivan Southerland 这样接受精英教育的天才理工男相比,Aron 就是个另类。有兴趣的可以到 Wiki 上看看他的简历(https://en.wikipedia.org/wiki/Jaron_Lanier)。

Aron Zepel Lanier

此人基本没上过中小学,却在 13岁上了大学(新墨西哥州立大学,在美国排名第199。和 Ivan Southerland 上的大学比,这基本就是「垃圾学校」了)。没学什么正规大学课程,却学了一些研究生课程,并拿了个美国国家科学基金会的资助,研究数学并开始计算机编程,同时还在纽约的曼哈顿学习音乐。干过编程,写过曲子,还当过接生婆。话说他先在 Atari (电子游戏公司,曾在 80 年代和苹果及 IBM 同为电脑先驱)工作,当 Atari 在 1984 年被分拆的时候,Aron Lanier 失业了。这时他开始重新钻研在 New Mexico State 时的科研项目「数字图形学」,并和 Zimmerman 一起创立了 VPL (Visual Programming Language)公司,研究 VR 的商用。

值得一提的是 1984 年也是视频压缩编码的元年,一群在各国电信公司的研究人员开始在 CCITT (后来的 ITU-T)建立一个国际组织,尝试建立视频压缩国际标准 H.261,用于视频通讯。H.261 视频压缩国际标准于 1988 年制定完毕。ISO/IEC 下面的 MPEG 标准委员会则于 1988 年组建。从此 ITU-T H.26x 系列国际标准及 ISO/IEC 的 MPEG 国际开始了二十多年的合久必分、分久必合的爱恨情仇马拉松,直到今天,这些视频压缩国际标准已经融入到我们的日常生活的每一个角落。

回到 VR,VPL 的尝试大大降低了 VR 「头显」及 VR 系统的造价(从几百万美元到几十万美元),并发明了 Data Glove,用于人机交互的控制。今天的「头显」以及手势控制等很多 VR 器件都在 Aron 时期似曾相识。虽然 VPL 热闹红火了几年,但是最终无法将其技术形成一个可用的 VR 产品,在烧光了钱后,VPL 于 1990 年破产了。无独有偶,又是 Sun Micro于 1999年买下了 VPL 和 VR 相关的专利(还记得 Ivan 的公司被 Sun Micro 收购的事吗?)。在另外一个轨道上,1990 年 ISO/IEC 视频压缩专家组已经基本完成了 MPEG-1 视频压缩国际标准,以及相关的音频及系统国际标准。消费电子正式开始步入数字时代。

VR 的第二次尝试还是由于远远超前于时代而完败。如果说 VR 的第二次尝试有什么积极意义的话,那就是 VR 的概念从大学的研究室,军方的实验室走进了普通大众的视野。

一直到了 90 年代中后期,PC 开始普及,计算机的计算能力进入了一个崭新的阶段,半导体技术迅速发展,视频数字处理、图形处理、数字电视等一系列新兴工业进入飞速发展时期,形成了新的信息技术革命。VCD/DVD 播放器开始取代 VCR,数字相机开始取代传统的照相机,数字电视开始取代传统电视,视频会议系统进入商用,全球互联网开始形成。依托新一轮的信息技术革命,VR 又一次开始在游戏领域发力。这一次的 VR 好像比以往任何时候都更接近成功。首先,游戏是个大产业,有着走进千家万户的可能性,其次,VR 在技术上也有了更好的基础。众多公司推出了为游戏设计的 VR 「头显」,VR 也在 1996 年 5 月登上了 PC Gamer 杂志封面。但是,不幸的是,时间不长,VR 的热潮就又过去了,慢慢的淡出了人们的视线。内容贫乏、体验糟糕依然是一道迈不过去的坎。

当大家都快把 VR 忘记的时候,VR 又声势浩大的来到了大家的身旁。2016年,就是现在,信息技术的进步使得我们比以往任何一个时候都更接近一个真实的 VR:高清显示屏幕使得 VR 的显示更加逼真,高清摄像头阵列使得采集成为可能,高效的视频压缩技术和互联网的飞速发展使得 VR 视频的存储、传输成为可能,超级计算能力为 VR 的内容制作提够了强大的基础。VR 的新浪潮会不会再一次夭折? 各大巨头和满大街的初创公司会不会再一次集体踩空? 不得而知。五年以后再见!

小编:小煦 念衾

文章转载:请保留以上所有信息。

文章内容:本文仅代表作者个人观点,不代表“洪泰帮”及其运营方立场。

文章图片:本文可能有部分图文来自网络的情形,如涉及版权或其他民事权利问题,请与我们联系。

BP通道:[email protected]

投稿通道:[email protected]

简历通道:[email protected]

你可以试试回复这些关键词:洪哥 | 泰哥 | 投资人 | 创业者

往期内容推荐

~洪泰行研报告~

想要成为风口上的猪,先找到风口

~洪泰原汁原创~

洪泰新鲜出品,原汁原味

~洪泰特约观点~

特约行业专家,掷地有声的观点,让脑力一起激荡

Facebook和Airbnb的投资人告诉你:初创企业该如何成长?

~洪泰创业有知~

有了这些知识,你不一定成功;没有这些知识,你一定不成功

~洪泰新闻直达~

记录洪泰重要时刻

~洪泰真爱分享~

因为爱,舍不得不与你分享

~洪泰私房故事~

满足你对洪泰的所有想象

长按上面二维码,关注洪泰基金