对 AI 的关注不止于行业,不止于商业落地项目,还有实现 AI 的技术。

AI 技术在大多数技术人看来,目前的关键词除了对应的高薪,还有技术本身的门槛。针对后者,现在已经开始有线上线下教育平台,抓住类似于、更甚于 2011 年 iOS 技术市场带来的机遇,为非科班出身的在职、高校同学提供相对专业系统的培训。这些培训,正在弥补市场人才的空缺,同时降低入门或转型 AI 领域的门槛。对于想转型的同学,现在是一个不错的切入时间,不妨做一份计划,逐步进入。

噢~回到我自己的情况。过去四个月,把自己扔到了一个技术圈,所在平台恰好 All in AI,这使得我日常可以浸染在想了解的 AI 议题中,有时候是产品,更多时候是技术本身。深度学习、机器学习、自然语言处理、语音识别等等,都是其中的关键词。当我回顾这段时间接触到的内容,总觉得有些混乱,无法串成一条线:它们之间是什么关系,当它们出现在不同的文章时,应该如何判断 A 与 B 是包含还是被包含,是流程线的上游还是下游 ——我尝试从线上搜索寻找体系化的解答,无功而返,所以在此梳理我目前能接触到的 AI 技术术语,此番梳理应能帮助自己/初学者理清媒体文章中论述 AI 时频现的关键词与技术实现逻辑。

这一次的分享将分为三部分

一、AI 技术落地的大框架流程

二、AI 技术落地的具体流程:以语音交互为例

三、AI 为什么与我们所有人相关

嗯,对了,首先,在这里明确一个定义:人工智能。这是一个现在几乎每个人都听过的名词,但是当你随意问身边的朋友,应该如何解释这个名词的时候,其实大多数时候并没有一个清晰的答案。

那人工智能这个名词应该如何理解呢?

追溯人工智能最初定义,《人工智能:一种现代方法》的作者 Russell 提到:人工智能是对计算机展现出智慧的研究。人工智能探究如何在机器中创造智能意识,它不是一种特定的技术。

但这个解释,现在变成我们对人工智能广义上的理解。

当我们环顾出现在我们身边的文章、演说,不难发现,人工智能更多时候相对狭义地被划分成了一种基础技术。在 20 世纪 80、90 年代,人们将专家系统与人工智能混为一谈,现在人们常将机器学习深度学习、神经网络和人工智能等同。

定义的统一是为了人们在沟通上对议题同一层面的理解,不分绝对优劣。

在这篇文章,我主要分享的是狭义之下的人工智能:从实现人工智能的技术本身展开。

------------------

一、AI 技术落地的大框架流程

(1)人工智能技术是如何产生作用的:它能/要做什么、它通过什么方法来做,它需要什么基础。

在这一部分,你将了解到目前 AI 技术落地的流程:数据输入-计算分析-方案输出。

(2)在梳理这个流程的同时,会涉及到:媒体文章中常见到的深度学习、机器学习、神经网络都是些什么,它们之间的关系又是怎样的?

------------------

在说框架之前,需要清楚的是,人工智能这个被热捧的技术领域能做什么?

如上 Russell 提到的人工智能技术,要使机器获得类人的智能意识——使得机器像有智慧的人那样,对外界的信息进行吸收、内化/分析,形成自己的“思考框架”,然后对外界进行重新定义、解释、对话/输出。更通俗一些,就是:使得机器像人一样,看听读感受外界信息,然后像人一样,输出自己看听读感受到的外界。只不过,对于人而言,获取与输出的信息更多为自我需求服务,而人工智能机器的落地,是需要为第三方,即人,实现衣食住行及工作领域的服务。

好了,了解了人工智能通俗定义下“”能够做什么“”的一个核心逻辑,我们回到人工智能技术本身,它要通过什么方法/流程来实现“像人那样智能”呢?

嗯,三步走。

数据输入-计算分析-方案输出。

数据输入,可以类比人类接受的外界刺激。机器依靠特定载体(如传感器),接收“刺激”,这些“刺激”就是机器可以解读的数据,包括语音、文本、图像、手势、体感、虹膜等形式,最前沿的还有来自动物包括人类的大脑信号/刺激。

计算分析,可以类比接受刺激后,“神经中枢”(如底层芯片、云端算法等硬件软件),对输入的数据进行识别、理解、分析。在人工智能技术领域,这种对数据的计算分析,通常会用到:语音识别、文本翻译、计算机视觉/图像识别等关键词。

在计算分析的过程中,我们要实现的是对数据(语音、文本、图像、体感等)处理。处理的目的是使得机器智能(可以感知、学习、推理、规划、判断等)。学习是机器获得“知识”,实现智能行为如推理、规划、判断、再学习的基础——可以类比我们人类所有的分析判断决策依据,均基于我们已有的知识经验。

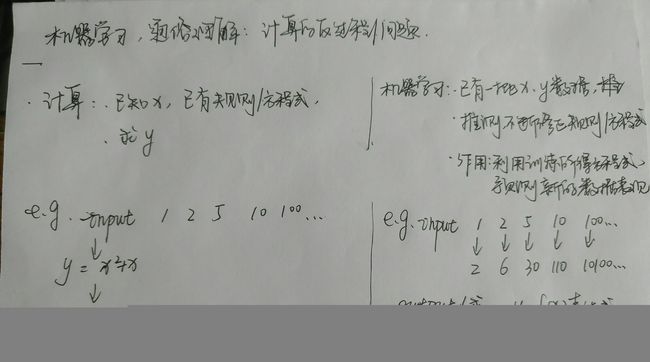

这个“学习”,正是目前人工智能技术领域主流关注的核心。这里涉及一个“机器学习”的专业术语。机器学习是人工智能技术的一种识别模式,相较“数据挖掘”(Data Mining)这个以商业视角来理解人工智能应用的方法,机器学习是以人工智能技术实现层面来定义,这一个术语可以被解释为:计算的相反过程/反问题。这是什么意思呢?计算的正过程是,我们给出一个方程式/规则,然后将数据代入方程式获得计算结果。相反的:过程是,我们现在有数据,但是没有方程式,机器要通过数据(训练数据)来给出方程式,然后再走下一步(根据推算的方程式预测新的数据结果)。

这其中,“机器如何学习”这个维度,衍生出了:全监督学习、半监督学习、无监督学习、强化学习、迁移学习等学习方式的划分。这一个维度的划分,区分了机器学习模式是否需要人为干预给予机器标签、机器是否可以基于数据与数据之间的关联自动学习或者触类旁通。

比如,监督学习,是需要预设“标签”,给机器当“老师”的角色,应用涉及医学诊断等;无监督学习是让机器自己来学习,不需要人为预设的答案;强化学习是机器可以在训练中自己学习,比如基于环境、动作、外界反馈进行自我迭代、博弈,比如 AlphaGo 可以基于外界的反馈,进行自我学习、博弈;迁移学习涉及更高级的智能,可以实现触类旁通,比如基于人的表情图+环境布置,来分析推断情节的发展等。

另外,对机器学习,行业还有一个二分式的划分维度:基于“学习”流程中是否“应用到多个隐含神经网络”这个维度,机器学习被划分为:深度学习、其他机器学习。这个维度,深度学习与其他机器学习,两个子集的一刀切,不难初步判断出,应用了隐含层神经网络的深度学习,区别于其他的机器学习存在,在机器学习中具备重要地位——事实上,深度学习在近年引领了语音与图像识别领域的重要突破,因而被越来越多地从机器学习这个“母体”独立区分开来。

对了,上面提到的“神经网络”,也是常出现在人工智能相关文章中的关键词。我们可以大致(但其实并不完全准确地)将“神经网络”类比为神经元,神经网络实现学习推理的过程中还有人们无法解释的环节,但神经网络的复杂度远没有人类的神经元复杂。

方案输出,是指机器接收了外界图文、语音等数据信息,经由计算分析流程,输出的内容。基于 AI 技术输出的信息,需要终端设备承接、需要交互界面与人/物进行交互。目前行业主流最为关注的,应算是智能音箱这样的终端设备。终端设备还与智能可穿戴产品相关。经由终端载体承接,AI 技术输出的方案,现在已经应用到金融、安防、营销、医疗、汽车、家居等领域。鉴于文章的重点在于理清 AI 技术落地流程,而不在行业与产品落地现状,就不在此展开后者,不过想了解更多,可以看一下我此前专门写的 AI 产品落地的两篇文章。(1.AI技术要比产品落地进展快得多:智能音箱只是第一步2.这个时代与我们有关:不止于AI定制化新金融、决策方案、智能出行)

不知道读者有没有留意到,上述三步,每一步都是涉及数据(外界信息语音、图文转化成的数据)。这其实是我在上面提到的: AI 技术的落地需要什么基础——是数据,是海量的数据。所以当我们提到 AI 技术,大数据是技术落地的“肉”,没有数据,技术只是一个无法运转的骨架。嗯,这延伸到技术领域的学习,你会发现,AI 技术中,会有算法与数据结构之类的关键词,算法与数据是落地 AI 绕不过的一环。

二、AI 技术落地的具体流程:以语音交互为例

文章到目前为止,梳理了 AI 技术在大框架流程的内容,厘清这些信息,算是初步了解 AI 技术落地的原理。在这一步之后,我们可以进一步解读 AI 技术本身是怎样形成具体 AI 产品的。接下来,我将拆解目前 AI 领域被热捧的智能音箱——实现语音交互的流程。

在这一部分,你将了解到:

语音交互实现流程,以及其中的难点是什么?

与之相较,延伸开来,当我们谈到计算机视觉、文本翻译、脑神经连接又可以聊些什么?

------------------

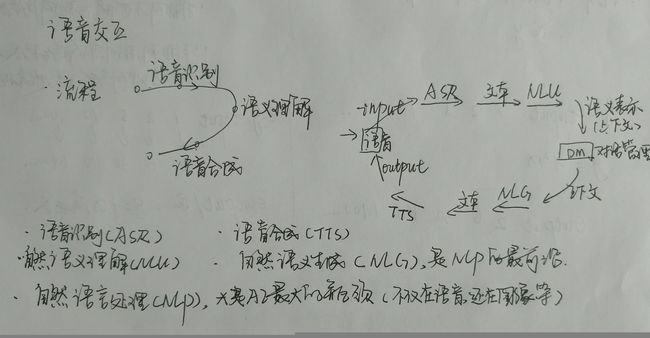

现在,我们来看一下语音交互实现的流程:语音输入→语音识别→语义理解→语音合成→语音输出。下图的左侧是简约版的流程,右侧是相对细化的流程。

从第一步输入语音,机器识别系统就要面对这样的问题:声音源距离是否合适、机器如何被声音激活。这两个问题,在 ASR 领域有对应的术语:远场识别、语音激活检测以及语音唤醒。(对这些词语的认知将有助于入门者更好理解没有背景介绍的文献资料。在此不作更细的展开,有兴趣深入的同学可以再作探究,或者关注我未来两个月的分享)

语音识别(Automatic Speech Recognition,ASR),是语音输入后,机器接收器下一步要做的事情。完成 ASR 流程要走三步,对输入的语音编码→解码→输出。

在 ASR 编码、解码过程中,机器会基于不同的声学模型:主要是利用隐马尔科夫模型实现的传统识别、利用深度神经网络实现的端到端识别两种识别模式,解决语音非标、环境嘈杂、声音无法打断等现实语音存在的问题。

语义理解,这里指的是自然语言处理(Natural Language Processing,NLP)。如图提到的,NLP 是目前人工智能领域最大的瓶颈。额外提一下,NLP 不仅适用于语言文字本身,还适用于图像等——更甚的发展是,现在 FaceBook 等企业已经尝试通过 NLP 打通文字、语音、图片的识别环节(比如看到图片可以解释出文字、输出语音),相较单一在文字或者语音、或者图片上进行 NLP ,这是更高层次的机器智能。回到语音交互领域的 NLP ,目前自然语言生成(Natural Language Generation,NLG)是 NLP 最前沿的研究领域。经过 ASR ,还有自然语言理解(Natural Language Understanding,NLU)流程,机器进行计算处理对话语音,那最后如何生成符合人类需要的语言(像人一样对外界问题给出答案)?问题的答案在于 NLG,其中,NLG 的水平,是未来语音交互的核心点之一——试想一下,你(C 端用户)和一台机器对话,你需要它输出什么回复给你?越是匹配你的需求,越能获得你的认可与信赖,不是吗?在 B 端亦然。只不过 C 端相对没那么重客观数据,而 B 端重客观信息。

关于 NLP 这个环节,在落地的过程中有更多值得深究的细节。对话应该如何理解,理解对话之后应该输出什么?现在的语音交互市场,比如智能音箱,就有基于不同的需求,比如个人助理、家居助理、购物助理、学习助理等等定位,经过不同的对话理解与设计,产出不同的落地音箱产品。这其中,不同的对话设计,尤其是面对 C 端用户,现在各创业项目,开始用“训机师”的角色,让机器获得更具备“人性、个性”特色的表现。比如 Amazon 的 Alexa,在原始对话组织上,就由具有创意写作硕士身份的米歇尔·里根·兰森负责,其手下还有一批剧作家、诗人、音乐家、小说家等,他们每周的作品都被整合到 Alexa 的人格设定中。

噢~对了,那机器学习、深度学习是如何在语音交互中产生作用的呢?就像你在上几段内容看到的,输入语音后,机器需要识别、理解、生成反馈的语言。怎样才能输出合适、或者说相对合适的语言(数据)呢?就需要机器从过去的数据(比如网络上的语料、人工输入的语料)进行训练,训练出一个相对最优的方程式/规则,这个方程式将为未来用户使用时输入的语音(数据)提供一个依据,产出相对匹配的对话信息。(所以啊,机器学习过程和效果直接影响输出的对话对用户的价值。)

语音合成(Text to Speech,TTS),是经过语音输入、语音识别、语义理解、自然语言生成后,机器形成语言文字(也可是其他形式的语言表达),转化成语音的过程。语音的合成,目前来看,落地产品会在语音形象上(产品面向的人群是谁,需要细腻温和的声音还是其他?需要保持平稳的语调还是基于人格化设置产出适合场景的个性化语调?)做出区别。嗯,在我看来,语音合成在语音形象上的设置,只有在 NLP、NLG 等环节匹配适合人们需求的解答,才可以作为锦上添花的角色,否则也不难基于这个单点形成产品竞争力。

好了,到这里,我们已经对 AI 领域语音交互具体实现流程做了一个较为详细的梳理:你可以从流程中,获得对 AI 技术产品落地的具象认识——也可以基于这个流程,设想如果自己来构建一个智能音箱,需要经过怎样的关键环节,在每个环节可能遇到的主要问题有哪些(更具体的还有待探究)。

上述是 AI 技术实现语音交互的分享。那谈到同样要基于 AI 技术去落地的计算机视觉(Computer Vision ,CV)(在此不严谨区分 CV、MV)、文本翻译,甚至是更前沿的脑机连接,我们又可以聊些什么呢?其实核心流程是相似的,都需要输入数据(图像、文字、神经元信号),然后通过计算分析,输出现实需要的解决方案/依据。比如在 CV 领域,目前最受关注的包括无人驾驶障碍物处理、安防人脸识别等,就要基于海量的图片数据,通过机器学习,计算分析图片的意义(此处还要 NLP ),输出帮助决策判断的信息。流程相似,同时意味着,有差异——不同领域的具体落地,会遇到不同的问题,比如计算机视觉中要解决摄像头信噪、对比度、光照、观察角度等问题。

三、讲完狭义之下专注的 AI 技术,我们回到广义之下的 AI :AI 与我们所有人相关

现在,从 AI 短期的影响来看,很多人说 AI 是程序员的新机遇。放长视线,我们不难发现,AI 给所有人提供了新的机遇。技术落地是 AI 给我们带来的第一层影响,而 AI 产品,需要懂人性、企业需求的人来架构,这会是未来几年 AI 引发的对我们的第二层影响,对人的了解、对商业运转的把握会给另一批人带来新的可能。AI 产品架构成型后,如何扩大影响力,这将是 AI 给我们带来的第三层影响,当这一层广泛涉及到每一个我们的日常生活、工作时,我们将进入一个类同现在互联网世界的 AI 世界,嗯,运营人在其中的作用不可忽视。

谈到 AI 与我们所有人相关,AI 带来的机遇是其中一个维度,如果说这一个维度满足了现实层面的功利需求,那么,我在这最后,想以“人文素养与精神境界”的维度,来分享为什么 AI 与我们所有人有关系:机器通过数据训练获得的“智能”,是人们主动的输入与设定,目前机器没有伦理道德的判断,只会针对数字分析、给予人类反馈。AI 产品最终的落地是对人类友好与否,由人来设定;AI 产品使人们向善、向积极生活进化与否,由人来设定。前者的落地,需要落地 AI 产品的人们具备人文素养,用匹配社会友好价值观的准则来设定是与非;后者的落地,依靠具备如哲学家素养的人们来为 AI 产品注入人类深层的思考。落地产品的人直接塑造 AI 产品本身,而接受这些 AI 产品的我们将可能被越来越像人的 AI 产品影响,甚至是塑造。

嗯,文章已经很长了,在此就不再展开说其他。希望读完此文,你能对狭义之下 AI 技术落地框架、 AI 领域语音交互技术的落地流程有一个相对具体的认识。最后是对广义之下的 AI 有更多人文探索的好奇心。

欢迎 AI 创业者和我进一步交流。

(感谢这个月能在黄钊老师主导的AI PM大本营学到相关内容,文中观点多来自黄钊老师及大本营小伙伴的分享与启发)