RedHat Linux Ent 5.6

安装手册

/RHCS

安装与配置手册

目 录

一、RHEL5.6系统安装...

二、RHEL5.6系统配置...

2.1

设置时间同步...

2.2

建立useradmin、sysoper、sysadmin用户管理用户与系统监控...

2.3

部署sysoper与useradmin维护脚本...

2.4

配置sudo.

三、RHEL5.6系统安全加固与系统优化...

四、RHEL5.6 YUM配置...

五、RHCS 5.6 安装与配置...

5.1

服务器设置...

5.2

安装Cluster软件 (linux1、 linux2)

5.3

在所有节点上配置CLUSTER(linux1、 linux2).

5.4

在所有节点上执行如下命令,启动CLUSTER服务...

5.5

查看集群状态...

5.6

手动切换集群服务...

一、RHEL5.6系统配置

2.1 设置时间同步

#ntpdate asia.pool.ntp.org

#mkdir /etc/sh

#echo ' /usr/sbin/ntpdate asia.pool.ntp.org' >/etc/sh/synctime.sh

#chmod +x /etc/sh/synctime.sh

#crontab –e

0 0 * * * /etc/sh/synctime.sh 2&>/tmp/synctime.log

保存退出

#service crond restart

2.2 建立useradmin、sysoper、sysadmin用户管理用户与系统监控。

|

User

|

user id

|

group

|

home directory

|

|

sysoper

|

1001

|

|

/home/sysoper

|

|

useradmin

|

1002

|

|

/home/useradmin

|

|

sysadmin

|

1003

|

|

/home/sysadmin

|

# useradd -d /home/sysoper -m -u 1001 sysoper; echo password|passwd --stdin sysoper

# useradd -d /home/

useradmin -m -u 1002 useradmin; echo password|passwd --stdin useradmin

# useradd -d /home/sysadmin -m -u 1003 sysadmin; echo password|passwd --stdin sysadmin

2.3 部署sysoper与useradmin维护脚本。

将

sh.tar以二进制形式上传到/etc/sh目录

#cd /etc/sh

#tar xvf sh.tar

2.4配置sudo

2.4.1、用root用户登陆系统,修改/etc/sudoers

#vi /etc/sudoers

在root

ALL=(ALL) ALL下面增加以下信息。

sysoper ALL=(ALL) NOPASSWD: /bin/sh /etc/sh/sysopermenu.sh

useradmin ALL=(ALL) NOPASSWD: /bin/sh /etc/sh/useradminmenu.sh

sysadmin ALL=(ALL) NOPASSWD: /bin/su -

保存退出

2.4.2、修改用户的

profile文件

#su – sysoper

$vi .brash_profile

在文件的最后添加以下内容:

if [ -x /etc/sh/sysopermenu.sh ] ; then

echo

sudo /bin/sh /etc/sh/sysopermenu.sh

exec kill -9 $$

echo

fi

保存退出

#su – useradmin

$vi .brash_profile

在文件的最后添加以下内容:

if [ -x /etc/sh/useradminmenu.sh ] ; then

echo

sudo /bin/sh /etc/sh/useradminmenu.sh

exec kill -9 $$

echo

fi

保存退出

三、RHEL5.6系统安全加固与系统优化

禁用adm, lp, sync, shutdown, halt, news, uucp, operator, games, gopher, ftp

#vi /etc/passwd

将上面的用户的

shell修改成/bin/false

保存退出。

四、RHEL5.6 YUM配置

4.1 YUM

配置(linux1

、 linux2)

4.1.1

、挂载

RHEL5.6

安装光盘至

/mnt

目录

mount /dev/cdrom /mnt

4.1.2

、修改

YUM

文件

vi /etc/yum.repos.d/rhel-debuginfo.repo

内容如下:

[Cluster]

name=Red Hat Enterprise Linux $releasever - $basearch - Cluster

baseurl=file:///mnt/Cluster

enabled=1

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release

[ClusterStorage]

name=Red Hat Enterprise Linux $releasever - $basearch - ClusterStorage

baseurl=file:///mnt/ClusterStorage

enabled=1

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release

[Server]

name=Red Hat Enterprise Linux $releasever - $basearch - Server

baseurl=file:///mnt/Server

enabled=1

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release

[VT]

name=Red Hat Enterprise Linux $releasever - $basearch - VT

baseurl=file:///mnt/VT

enabled=1

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release

4.1.3

、新建

rhel/

目录

mkdir -p /var/rhel/{Cluster,ClusterStorage,Server,VT}

4.1.

4

、安装

createrepo

rpm -ivh /mnt/Server/createrepo-0.4.11-3.el5.noarch.rpm

createrepo -o /var/rhel/Cluster -g /mnt/Cluster/repodata/comps-rhel5-cluster.xml /mnt/Cluster

createrepo -o /var/rhel/ClusterStorage -g /mnt/ClusterStorage/repodata/comps-rhel5-cluster-st.xml /mnt/ClusterStorage

createrepo -o /var/rhel/Server -g /mnt/Server/repodata/comps-rhel5-server-core.xml /mnt/Server

createrepo -o /var/rhel/VT -g /mnt/VT/repodata/comps-rhel5-vt.xml /mnt/VT

4.1.5

、挂载

mount --bind /var/rhel/Cluster/repodata /mnt/Cluster/repodata

mount --bind /var/rhel/ClusterStorage/repodata /mnt/ClusterStorage/repodata

mount --bind /var/rhel/Server/repodata /mnt/Server/repodata

mount --bind /var/rhel/VT/repodata /mnt/VT/repodata

mount --bind /var/rhel/ClusterStorage/repodata /mnt/ClusterStorage/repodata

mount --bind /var/rhel/Server/repodata /mnt/Server/repodata

mount --bind /var/rhel/VT/repodata /mnt/VT/repodata

4.1.6

、刷新

yum clean all

五、RHCS 5.6 安装与配置

5.1 服务器设置

5.1.1 Linux1服务器上设置

设置两张网卡IP地址分别为:

Eth0:IP:172.22.4.114 netmask:255.255.255.0 Default gatewary:172.22.4.126

Eth1:IP:192.168.0.10 netmask:255.255.255.0

设置主机名:

在/etc/hosts文件最后增加以下四行:

172.22.4.114

linux1.cnintra.itd.net linux1

192.168.0.10

linux1.cnintra.itd.net linux1

172.22.4.115

linux2.cnintra.itd.net linux2

192.168.0.11

linux2.cnintra.itd.net linux2

5.1.2 Linux2服务器上设置

设置两张网卡IP地址分别为:

Eth0:IP:172.22.4.115 netmask:255.255.255.0 Default gatewary:172.22.4.126

Eth1:IP:192.168.0.11 netmask:255.255.255.0

设置主机名:

在/etc/hosts文件最后增加以下四行:

172.22.4.114

linux1.cnintra.itd.net linux1

192.168.0.10

linux1.cnintra.itd.net linux1

172.22.4.115

linux2.cnintra.itd.net linux2

192.168.0.11

linux2.cnintra.itd.net linux2

5.2 安装Cluster软件 (linux1、 linux2)

Mount /dev/cdrom /mnt

yum groupinstall clustering

Transaction Summary

================================================================================

Install

35 Package(s)

Upgrade

0 Package(s)

Total download size: 50 M

Is this ok [y/N]:

y

Downloading Packages:

--------------------------------------------------------------------------------

Total

227 MB/s | 50 MB 00:00

warning: rpmts_HdrFromFdno: Header V3 DSA signature: NOKEY, key ID 37017186

Cluster/gpgkey

| 1.1 kB 00:00

Importing GPG key 0x37017186 "Red Hat, Inc. (release key) " from /etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release

Is this ok [y/N]:

y

5.3 在所有节点上配置CLUSTER(linux1、 linux2).

5.3.1设置CLUSTER服务自动启动

chkconfig cman on

chkconfig rgmanager on

5.3.2在所有节点上执行如下命令。修改操作系统以满足

RHCS的要求。

ln -s /sbin/cman_tool /usr/sbin/cman_tool

chkconfig acpid off

service acpid stop

chkconfig iptables off

service iptables stop

ln -s /sbin/cman_tool /usr/sbin/cman_tool

chkconfig acpid off

service acpid stop

chkconfig iptables off

service iptables stop

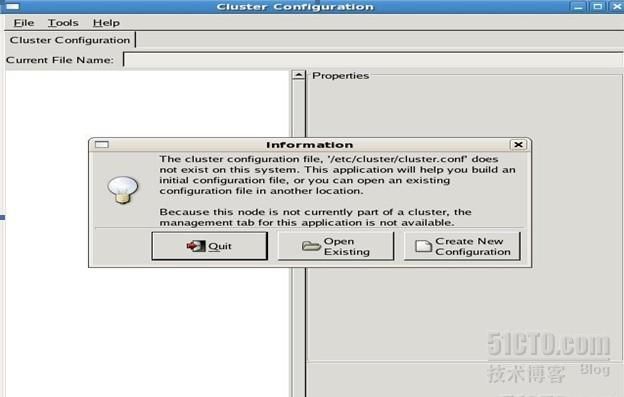

5.3.3 在一台节点上配置

CLUSTER (linux1)

system-config-cluster

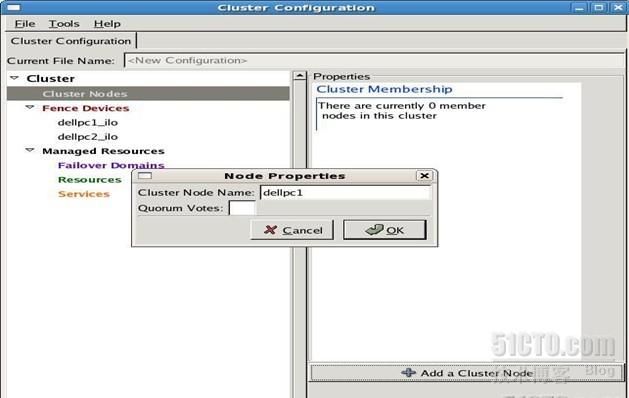

5.3.4 输入合适的

cluster name.选择OK

5.3.5选中

”Fence Devices”, 再选择”Add a Fence Device“, 创建fence设备,如果有多个fence设备,需要逐个添加。

5.3.6 添加节点服务器。选择左边视图中的

”Cluster Nodes”, 再选中右边视图下方的”Add a Cluster Node”, 在出现的对话框中输入节点名字。

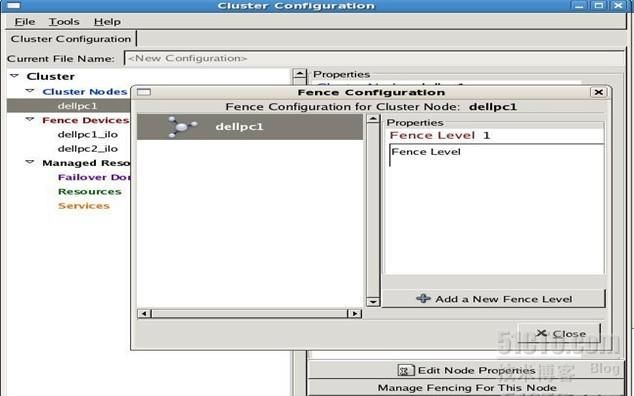

5.3.7 在左视图中选中刚添加的节点,再在右视图中选择

”Manage Fencing For This Node”, 在跳出的对话框中,单击”Add a New Fence Level“。添加该节点的Fence信息。

5.3.8 按照上面的步骤,依次添加所有的节点服务器到配置文件中。

5.3.9保存配置文件到

/etc/cluster/cluster.conf

5.3.10拷贝该配置文件到所有其他节点的

/etc/cluster/cluster.conf

5.4 在所有节点上执行如下命令,启动CLUSTER服务

service cman start

service rgmanager start

5.5 查看集群状态

clustat -i 2

每隔2秒钟更新集群的状态

5.6 手动切换集群服务

1、使用clustat 查看集群中应用服务正在哪一台机器上运行。

2、切换服务

clusvcadm -r 应用服务名称 -m 没有运行应用服务的节点名称

3、切换过后使用clustat 查看应用服务是否已经切换到另一节点上运行