朱海鹏

【嵌牛导读】深度学习作为新一代计算模式,近年来,其所取得的前所未有的突破掀起了人工智能新一轮发展热潮。深度学习模拟人类大脑运行机制,与传统计算模式迥异。深度学习的人工神经网络算法实际上是通过大量样本数据训练建立了输入数据和输出数据之间的映射关系,而传统计算架构计算资源有限,无法支撑深度学习的海量数据并行运算。因此,深度学习需要更适应此类算法的新的底层硬件来加速计算过程,目前主要的方式是使用已有的GPU、FPGA等通用芯片,同时IT 巨头争相开发专用计算芯片。

【嵌牛鼻子】深度学习硬件,FPGA,GPU,定制芯片

【嵌牛提问】GPU/FPGA运行深度学习算法都有什么优缺点?人工智能定制芯片(ASIC)相比前两者的优势?

【嵌牛正文】

目前以深度学习为代表的人工智能新计算需求,主要采用GPU、FPGA 等已有适合并行计算的通用芯片来实现加速。

在产业应用没有大规模兴起之时,使用这类已有的通用芯片可以避免专门研发定制芯片(ASIC)的高投入和高风险,但是,由于这类通用芯片设计初衷并非专门针对深度学习,因而,天然存在性能、功耗等方面的瓶颈。随着人工智能应用规模的扩大,这类问题将日益突出。

1、GPU 及其局限性

GPU 作为图像处理器,设计初衷是为了应对图像处理中需要大规模并行计算。因此,其在应用于深度学习算法时,有三个方面的局限性:

第一, 应用过程中无法充分发挥并行计算优势。深度学习包含训练和应用两个计算环节,GPU 在深度学习算法训练上非常高效,但在应用时一次性只能对于一张输入图像进行处理, 并行度的优势不能完全发挥。

第二, 硬件结构固定不具备可编程性。深度学习算法还未完全稳定,若深度学习算法发生大的变化,GPU 无法像FPGA 一样可以灵活的配置硬件结构。

第三, 运行深度学习算法能效远低于FPGA。学术界和产业界研究已经证明,运行深度学习算法中实现同样的性能,GPU 所需功耗远大于FPGA,例如国内初创企业深鉴科技基于FPGA 平台的人工智能芯片在同样开发周期内相对GPU 能效有一个数量级的提升。

2、FPGA 及其局限性

FPGA,即现场可编辑门阵列,是一种新型的可编程逻辑器件。其设计初衷是为了实现半定制芯片的功能,即硬件结构可根据需要实时配置灵活改变。

研究报告显示,目前的FPGA市场由Xilinx 和Altera 主导,两者共同占有85%的市场份额,其中Altera 在2015 年被intel以167 亿美元收购(此交易为 intel 有史以来涉及金额最大的一次收购案例),另一家Xilinx则选择与IBM进行深度合作,背后都体现了 FPGA 在人工智能时代的重要地位。

尽管 FPGA 倍受看好,甚至新一代百度大脑也是基于FPGA 平台研发,但其毕竟不是专门为了适用深度学习算法而研发,实际仍然存在不少局限:

第一,基本单元的计算能力有限。为了实现可重构特性,FPGA 内部有大量极细粒度的基本单元,但是每个单元的计算能力(主要依靠LUT 查找表)都远远低于CPU 和GPU 中的ALU模块。

第二,速度和功耗相对专用定制芯片(ASIC)仍然存在不小差距。

第三,FPGA 价格较为昂贵,在规模放量的情况下单块FPGA 的成本要远高于专用定制芯片。

3、ASIC定制芯片

人工智能定制芯片是大趋势,从发展趋势上看,人工智能定制芯片将是计算芯片发展的大方向:

第一, 定制芯片的性能提升非常明显。

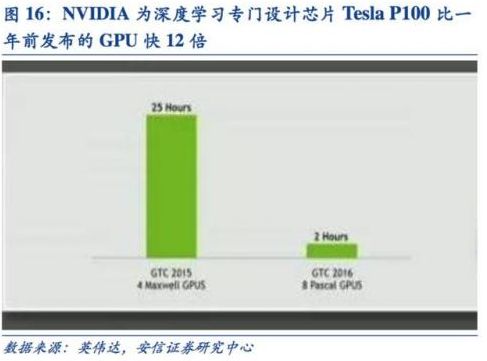

例如 NVIDIA 首款专门为深度学习从零开始设计的芯片Tesla P100 数据处理速度是其2014 年推出GPU 系列的12 倍。谷歌为机器学习定制的芯片TPU 将硬件性能提升至相当于按照摩尔定律发展7 年后的水平。需要指出的是这种性能的飞速提升对于人工智能的发展意义重大。

中国科学院计算所研究员、 寒武纪深度学习处理器芯片创始人陈云霁博士在《中国计算机学会通讯》上撰文指出:通过设计专门的指令集、微结构、人工神经元电路、存储层次,有可能在3~5 年内将深度学习模型的类脑计算机的智能处理效率提升万倍(相对于谷歌大脑)。提升万倍的意义在于,可以把谷歌大脑这样的深度学习超级计算机放到手机中,帮助我们本地、实时完成各种图像、语音和文本的理解和识别;更重要的是,具备实时训练的能力之后,就可以不间断地通过观察人的行为不断提升其能力,成为我们生活中离不开的智能助理。

第二, 下游需求量足够摊薄定制芯片投入的成本。

人工智能的市场空间将不仅仅局限于计算机、手机等传统计算平台,从无人驾驶汽车、无人机再到智能家居的各类家电,至少数十倍于智能手机体量的设备需要引入感知交互能力。

而出于对实时性的要求以及训练数据隐私等考虑,这些能力不可能完全依赖云端,必须要有本地的软硬件基础平台支撑。仅从这一角度考虑,人工智能定制芯片需求量就将数十倍于智能手机。

第三, 通过算法切入人工智能领域的公司希望通过芯片化、产品化来盈利。

目前通过算法切入人工智能领域的公司很多,包括采用语音识别、图像识别、ADAS(高级驾驶辅助系统) 等算法的公司。由于它们提供的都是高频次、基础性的功能服务,因此,仅仅通过算法来实 现商业盈利往往会遇到瓶颈。通过将各自人工智能核心算法芯片化、产品化,则不但提升了原有性能,同时也有望为商业盈利铺平道路。包括 Mobileye、商汤科技、地平线机器人等著名人工智能公司都在进行核心算法芯片化的工作。

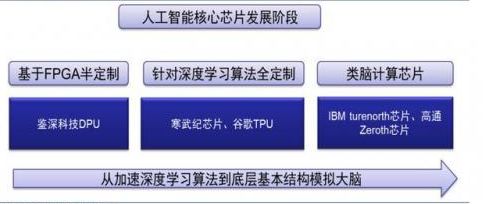

人工智能专用芯片的涌现表明从芯片层面开启的新一轮计算模式变革拉开帷幕,是人工智能产业正式走向成熟的拐点。人工智能芯片发展路线图: