文章链接:MAN

原作代码地址:pytorch

出处:SIGIR’18, July 8-12, 2018, Ann Arbor, MI, USA

推荐理由:

作者在introduction和related work中把前人的工作介绍得非常详细,诚意满满,至少在我眼里看来并不是在划水,比较适合入门。

作者想法比较新颖,利用动态记忆网络(DMNS)的思想进行建模,同时作者摒弃了在AS任务中用co-attention进行交互这种比较火的做法,坚持用one-way attention建模。

文章结构比较清晰易懂,并且有开源代码,但是也要吐槽一下文中代码的位置真的超级不明显,只是惊鸿一瞥读文章的同学大概是找不到的,作者的代码只是工程任务的代码,算不上是严格意义的代码,anyway,向开放源码的前辈致敬!

下面就开始详细的介绍论文了!

首先作者diss了以往注意力存在的缺点:以往基于注意力的方法的一个共同特点是,问题由一个特征向量表示,并应用一轮注意力来学习答案的表示。然而,在许多情况下,答案的不同部分可能与问题的不同部分有关。作者根据这一点展开本文的工作,构建一个attention,也就是标题说的multihop attention来获得问题的不同部分的语义,然后再通过sequentional attention获得答案的语义表示;进行多次匹配得出score,最后将score相加得到最终的score表示。

文章中介绍了四种Attention:

MLP Attention

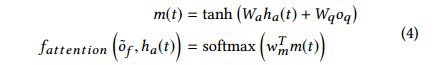

其实MLP Attention相当于一个加法注意力机制,这里将问题的表示和答案的表示进行相加然后再通过一个relu_mlp进行激活,然后用softmax进行归一化得到attention权重。至于这里为什么问题向量用

来表示,而答案向量用

来表示呢?因为文中

其实是表示问题的某一个部分,它的维度为(batch_size, 1, 2*dim),

则表示答案每个timestep的向量表示,它的维度也为(batch_size, 1, 2*dim)

Bilinear Attention

Bilinearl Attention就是我们常说的co-attention,也是在AS任务中比较火的attention,反正从一些出名的模型的消融实验分析可以看出这部分是很重要的,

其实就是在构建一个词级相似度矩阵,当然词级相似度矩阵还有这种简单的

形式。

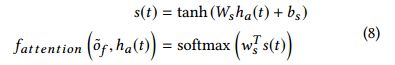

Sequential Attention

Sequential Attention最早用在阅读理解上,作者在本文中也证明了Sequential Attention在AS任务中的有效性。Sequential Attention主要是考虑了上下文的联系这样可以为向量表示带来语境信息,其实,看过Wang(IARNN)的同学可能会发现,Sequential Attention其实和IARNN-Word如出一辙,

是问题向量与答案向量的点积,然后再送入BiLSTM中,接着将lstm的输出进行一个softmax得到权重

,最后作者将权重与答案向量相乘求和得到经过attention后的答案向量。

Self-Attention

Self-Attention的作用是捕获句子的全局位置结构信息,从上面的公式我们可以很容易就知道所谓自注意力就是自己和自己玩,Self-Attention现在也是用的比较多的attention机制,在自然语言的各个领域都大放异彩,比较有名的比如说google那帮大佬的Attention is all you need,NLI领域的A Structured self attention等

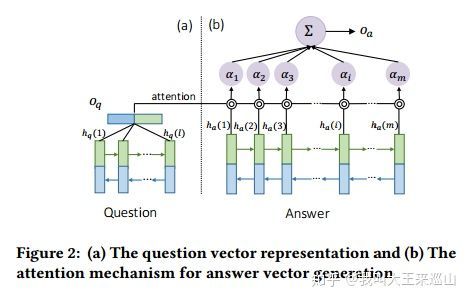

我们可以看到模型的总体结构图,图(b)是基于Sequential Attention的模型,图(d)是基于Self-Attention的模型,图(a),图(c)则是图(b),图(d)的局部表示。

相当于问题每个timestep的向量,(9)中的三个公式告诉我们三件事情,第一,

就是通过带tanh的前馈网络计算出来的;第二,

就是根据老套路,经过softmax得来的;第三,我们的重点在于更新

,求和相当于压缩成长度为1的向量了,也就是我们关注到了问题中的一个重要的部分了。那么这个流程是怎么启动的呢?看下面公式:

首先更新

,

相当于把lstm的输出做一个mean-pooling操作,而

就等于

,这样一来二去,这个流程就说得通了。细心的同学可以发现,这其实和NLI领域的A Structured self attention里面的做法很相似,但是明显本文的attention更加复杂。

计算出了问题向量,那如何得出答案向量呢?毕竟我们最后是要做一个相似度匹配的啊。看下图:

其实,这就是Sequential Attention的一个结构图,在本文中,我们只不过把图中的

替换成

了,这样我们也不难得到最后的

了,然后就是对应paper的中心——Multihop!

作者经过实验,发现K=2是最好的。

实验结果:

总结:

1.个人觉得直接把最后的结果相加是有点问题的,比如说,在AS任务中,我们希望凸显的是句子相似的部分,所以我们更希望9+1>5+5,但是在本文中9+1 = 5+5,我觉得这应该可以成为未来改进的地方。

2.用tensorflow实现了模型,发现运行速度很慢,我觉得应该是问题那部分的attention的原因吧,毕竟太复杂了。在wikiQA数据集上,实现了Multihop-self-LSTM的效果,但是Multihop-sequential-LSTM的效果一直没达到。

3.后续会放上github