其实大部分主流网站都不是静态的html,html和Javascript相结合已经是大势所趋。

本篇以花瓣网主页为例子。

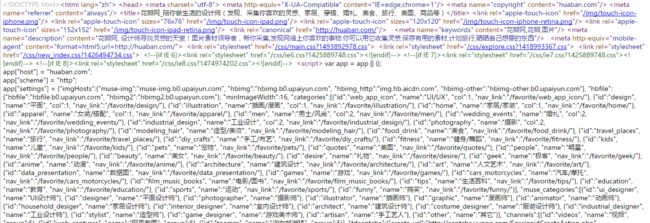

花瓣网主页,右键查看网页源代码,获得的页面是这样的:

如果还是用之前静态页面的那一套(用requests和urllib)。由于获得的是静态页面,这时动态JS都还没加载出来,那肯定是啥都挖不出来了。

这里讲讲几种解决方法:

(1)方法一:

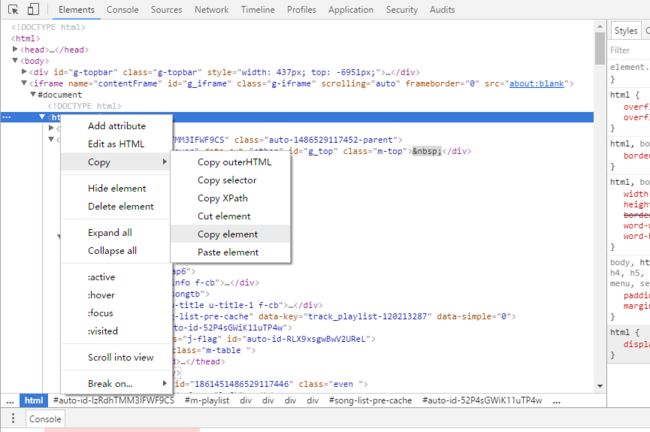

直接调出开发者工具,复制element的html代码,保存,用正则或BeautifulSoup或xpath提取信息。

办法很土,不过好处是绕开了模拟浏览器环境的坑。使用有较大局限性

注意:这里还可以复制Xpath和selector(对应BeautifulSoup中的select方法),这个能让我们无脑对进行单项定位。

(2)方法二:

我们可以先右键看下我们要采集的图片地址的格式:

大概格式就是' http://img.hb.aicdn.com/ '+'图片特有编号'+‘_sq320’

我们把编号直接在静态的网页源代码中搜一下,

发现图片的编号在JS中,用Xpath或BeautifulSoup是没有办法提取的,可以利用正则表达式来提取信息

但是这个页面非常恶心,实现起来会非常累。而且在首页中后缀是‘_sq320’,在其他页面还有'_sq236bl4',‘_fw658’,‘_fw236’的格式,还要对这些进行判断也非常麻烦,这种方法有较大局限性。

(3)方法三:

用谷歌插件web Scraper实现,无需编程。

不写代码的爬虫,10分钟搞定中有详细的介绍,还有视频可以学习。

对多数网站都挺适用的,我还没怎么用过,还在学习如何使用中。

(4)方法四:

分析JS源码 找出请求 自己模拟实现 难度比较高 。

这里有个今日头条的案例:http://www.jianshu.com/p/4fe8bb1ea984 ,讲的很棒很详细,但是有时API接口找不着或者是API接口地址随机变换,那还是得用万能的方法五。

(4)方法五(最有效):

模拟浏览器实现。比较常见的是 Selenium + PhantomJs ,基本上能解决大多数的爬虫问题,但是效率比较低,一般要配合多进程。

Selenium(点我查看中文文档,请务必先浏览一遍)是一个自动化测试框架。它能够模拟人工操作,比如能在浏览器中点击按钮、在输入框中输入文本、自动填充表单、还能进行浏览器窗口的切换、对弹出窗口进行操作。也就是说你能手动做的东西,基本都能用它来实现自动化!

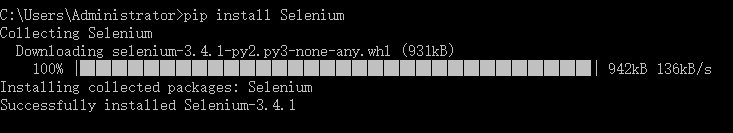

Selenium模块可以在cmd中进行安装。

Selenium当前支持的WebDriver有: Firefox, Chrome, IE and Remote等。

当然也包括Phantomjs。Phantomjs是一个“无头”浏览器,也就是没有界面的浏览器,但是功能与普通的浏览器无异,但占用较少的内存。

phantomjs-2.1.1官方下载地址

不知道为啥我下载时老出问题,所以再放一个CSDN的下载地址phantomjs-2.1.1CSDN下载地址

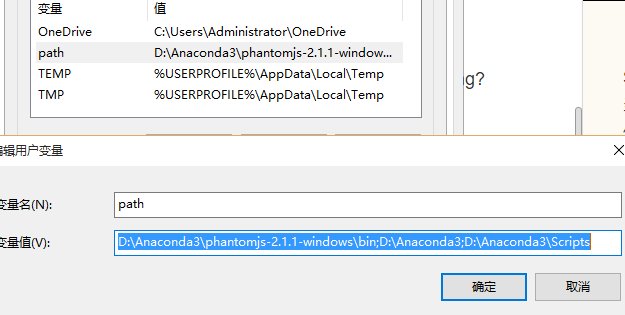

解压后可将phantomjs.exe的路径设置到环境变量中,以win10系统为例:我的电脑 -> 右键“属性” -> 点击“高级系统设置” -> 点击“环境变量”,可以看到当前path的一些路径, 为了方便,将phantomjs.exe放入到path的已有路径中。

当然,不进行环境变量设置也行,只不过是程序需要声明phantomjs.exe的位置罢了。

但是使用Phantomjs的时候,有时遇到问题的时候要卡壳很久,因为不是可视化界面,很多东西感觉像是空想。因此,一般可以使用chrome来进行编写程序,然后最后再换成Phantomjs就好了(小爬虫直接用chrome也就行了)。这里需要用到chromedriver(点击下载),然后根据需要设置环境变量,方法和phantomjs.exe的一样。chrome我用58版本的会报错,后来装了chrome52.0.2743.116版本(32位百度盘链接: http://pan.baidu.com/s/1c2t6Ei8 密码: k9y8),能够成功运行,建议不要选太新的版本。

我在实际编程中,Phantomjs有时莫名报错,就算没报错等待的时候也觉得很乏味2333,用chrome就没问题。所以还是更加推荐先用Selenium + Chrome。

以爬取花瓣网首页的图片地址为例:

from selenium import webdriver

from bs4 import BeautifulSoup

#打开一个浏览器,若phantomjs.exe或chromedriver.exe在环境变量中

#可精简为driver = webdriver.PhantomJS()或driver = webdriver.Chrome(),否则要表明路径

driver = webdriver.Chrome(executable_path="D:\\Anaconda3\\chromedriver.exe")

#窗口最大化

#driver.maximize_window()

#访问网站

driver.get('http://huaban.com')

#获得网页信息

soup = BeautifulSoup(driver.page_source, "lxml")

#利用开发者工具找到我们需要的图片地址

results = soup.select('img[data-baiduimageplus-ignore="1"]')

#for r in results时发现有最后两个列表元素不是我们需要的网址,用[0:-2]去除

for r in results[0:-2]:

print('http:'+r['src'])

#关闭浏览器

driver.quit()

运行结果:

关于Selenium还有好多其他的用法,比如点击登录,滚动页面等等,还有iframe框架怎么处理。先挖个坑,接下来还得再讲讲。

不错的简单案例:http://www.2cto.com/kf/201704/622848.html

PS:我本身也是python刚刚入门,很多东西也不太懂,也是一点一点在学,所以网友们的问题我大多也都答不上来,只是提供一个简单的模板,大家一起参考。