1、安装ruby,准备环境

redis cluster 集群搭建,要比使用中间件,简单的多,因为redis非常暖心的给我们准备ruby脚本,只要你把集群的环境搭建好了,组合这个集群你不用自己去敲,如果你自己去敲这些复杂的领命,可能特别麻烦,redis呢? 做了一个ruby脚本,你只要能执行这个ruby脚本, redis会自动把这个集群连接起来,但是问题是,你的先有这个执行ruby脚本的环境,默认是没有ruby环境的,需要我们来安装一下

(1)查看 yum源 是否有 ruby ,

考虑兼容问题,尽量从本地CentoS 镜像文件里面装。

[root@hadoop102 ~]# yum list | grep ruby

(2)执行安装包

依次执行在安装光盘下的Package目录(/media/CentOS_6.8_Final/Packages)下的rpm包

[root@hadoop102 Packages]# cd /media/CentOS_6.8/Packages/

[root@hadoop102 Packages]# pwd

/media/CentOS_6.8/Packages

[root@hadoop102 Packages]# rpm -ivh compat-readline5-5.2-17.1.el6.x86_64.rpm

[root@hadoop102 Packages]# rpm -ivh ruby-libs-1.8.7.374-4.el6_6.x86_64.rpm

[root@hadoop102 Packages]# rpm -ivh ruby-1.8.7.374-4.el6_6.x86_64.rpm

[root@hadoop102 Packages]# rpm -ivh ruby-irb-1.8.7.374-4.el6_6.x86_64.rpm

[root@hadoop102 Packages]# rpm -ivh ruby-rdoc-1.8.7.374-4.el6_6.x86_64.rpm

[root@hadoop102 Packages]# rpm -ivh rubygems-1.3.7-5.el6.noarch.rpm

(3)如果光盘需要挂载,查看下面连接

https://www.cnblogs.com/heihouzi/p/8662719.html

(4)拷贝redis-3.2.0.gem到/opt目录下

ruby本身不具备操作redis,我们可以在ruby中添加redis插件,这样就可以使ruby操作redis了

redis-3.2.0.gem 百度下载一个即可

(5)在ruby中安装redis插件

[root@hadoop102 opt]# gem install --local redis-3.2.0.gem

2、ruby环境准备好了,我们来看一下redis集群搭建步骤

(1)制作6个实例,6379,6380,6381,6389,6390,6391

(2)拷贝多个redis.conf文件

(3) 开启daemonize yes

(4)Pid文件名字

(5)指定端口

(6)Log文件名字

(7)Dump.rdb名字

(8)Appendonly 关掉或者换名字

3、配置 redis cluster 集群文件

(1)redis6379.conf

[root@hadoop102 redis-3.2.5]# vim redis6379.conf

include /myredis/redis.conf

port 6379

pidfile /var/run/redis_6379.pid

dbfilename dump6379.rdb

cluster-enabled yes

cluster-config-file nodes-6379.conf

cluster-node-timeout 15000

(2)创建80、81、89、90、91

[root@hadoop102 redis-3.2.5]# cp redis6379.conf redis6380.conf

[root@hadoop102 redis-3.2.5]# cp redis6379.conf redis6381.conf

[root@hadoop102 redis-3.2.5]# cp redis6379.conf redis6389.conf

[root@hadoop102 redis-3.2.5]# cp redis6379.conf redis6390.conf

[root@hadoop102 redis-3.2.5]# cp redis6379.conf redis6391.conf

(3)修改80、81、89、90、91 配置文件

[root@hadoop102 redis-3.2.5]# vim redis6380.conf

:%s/6379/6380

[root@hadoop102 redis-3.2.5]# vim redis6381.conf

:%s/6379/6381

[root@hadoop102 redis-3.2.5]# vim redis6389.conf

:%s/6379/6389

[root@hadoop102 redis-3.2.5]# vim redis6390.conf

:%s/6379/6390

[root@hadoop102 redis-3.2.5]# vim redis6391.conf

:%s/6379/6391

(4)Redis 集群模式,新增的配置

cluster-enabled yes 打开集群模式

cluster-config-file nodes-6379.conf 设定节点配置文件名

cluster-node-timeout 15000 设定节点失联时间,超过该时间(毫秒),集群自动进行主从切换

4、删除 RDB 和 AOF 文件

[root@hadoop102 redis-3.2.5]# rm -rf dump.rdb

[root@hadoop102 redis-3.2.5]# rm -rf appendonly.aof

5、查看redis进程并启动redis

[root@hadoop102 redis-3.2.5]# ps -ef | grep redis

[root@hadoop102 redis-3.2.5]# redis-server redis6379.conf

[root@hadoop102 redis-3.2.5]# redis-server redis6380.conf

[root@hadoop102 redis-3.2.5]# redis-server redis6381.conf

[root@hadoop102 redis-3.2.5]# redis-server redis6389.conf

[root@hadoop102 redis-3.2.5]# redis-server redis6390.conf

[root@hadoop102 redis-3.2.5]# redis-server redis6391.conf

[root@hadoop102 redis-3.2.5]# ps -ef | grep redis

6、运行ruby脚本,将六个节点,进行合体

[root@hadoop102 ~]# cd /opt/module/redis-3.2.5/src

[root@hadoop102 src]# ./redis-trib.rb create --replicas 1 \

192.168.31.211:6379 \

192.168.31.211:6380 \

192.168.31.211:6381 \

192.168.31.211:6389 \

192.168.31.211:6390 \

192.168.31.211:6391

yes

[ok] ALL 16384 slots covered

此处不要用127.0.0.1, 请用真实IP地址

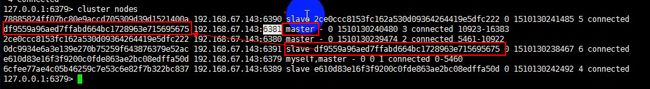

7、查看集群节点状态

[root@hadoop102 redis]# redis-cli

127.0.0.1:6379> cluster nodes

8、redis cluster 如何分配这六个节点?

(1)一个集群至少要有三个主节点

(2)选项 --replicas 1 表示我们希望为集群中的每个主节点创建一个从节点

(3)分配原则尽量保证每个主数据库运行在不同的IP地址,每个从库和主库不在一个IP地址上

9、什么是 slots ?

一个 Redis 集群包含 16384 个插槽(hash slot)

数据库中的每个键都属于这 16384 个插槽的其中一个, 集群使用公式 CRC16(key) % 16384 来计算键 key 属于哪个槽, 其中 CRC16(key) 语句用于计算键 key 的 CRC16 校验和 。

集群中的每个节点负责处理一部分插槽,槽主要左右是均衡分布数据,类似于hbase的预分区,hash分布

举个例子, 如果一个集群可以有主节点, 其中:

节点 A 负责处理 0 号至 5500 号插槽。

节点 B 负责处理 5501 号至 11000 号插槽。

节点 C 负责处理 11001 号至 16383 号插槽。

10、redis集群登录方式

[root@hadoop102 redis]# redis-cli -c

127.0.0.1:6379> set k1 v1

-> Redirected to slot [12706] located at 192.168.67.143:6381

ok

127.0.0.1:6379> get k1

"v1"

11、在集群中录入值

(1)在redis-cli每次录入、查询键值,redis都会计算出该key应该送往的插槽,如果不是该客户端对应服务器的插槽,redis会报错,并告知应前往的redis实例地址和端口。

(2)redis-cli客户端提供了 -c 参数实现自动重定向。

如 redis-cli -c -p 6379 登入后,再录入、查询键值对可以自动重定向。

集群客户端登录方式

[root@hadoop102 myredis]# redis-cli -c

127.0.0.1:6379> set k1 v1

-> Redirected to slot [12706] located at 192.168.67.143:6381

ok

127.0.0.1:6379> get k1

"v1"

(3)不在一个slot下的键值,是不能使用mget,mset等多键操作

192.168.67.143:6381> mset k1 v1 k2 v2 k3 v3

(error) CROSSSLOT Keys in request don't hash to the same slot

注:mset,mget 具有原子性不可切割,当时操作的键值 可能不在一个槽里面,所以失败

(4)可以通过{}来定义组的概念,从而使key中{}内相同内容的键值对放到一个slot中去

192.168.67.143:6381> mset k1{user} v1 k2{user} v2 k3{user} v3

-> Redirected to slot [5474] located at 192.168.67.143:6380

ok

192.168.67.143:6380> set user v100

ok

192.168.67.143:6380>

注:通过{} 的内容取模,使其放到一个槽里面,使用时,只需要重新规划键值

12、查询集群中的值

(1)CLUSTER KEYSLOT

192.168.67.143:6380> cluster keyslot user

(integer) 5474

192.168.67.143:6380> cluster keyslot abc{user}

(integer) 5474

注:查看key 在 那个槽的范围内

(2)CLUSTER COUNTKEYSINSLOT

192.168.67.143:6380> cluster countkeysinslot 5474

(integer) 4

注:查看5474 这个槽里面有多少个键值数量

(3)CLUSTER GETKEYSINSLOT

192.168.67.143:6380> cluster getkeysinslot 5474 10

(integer) 5474

1) "k1{user}"

2) "k2{user}"

3) "k3{user}"

4) "k4{user}"

5) "user"

注: 获取5474 这个槽 10个键

13、故障恢复

(1)制造 redis 集群一台master节点 宕机

[root@hadoop102 myredis]# redis-cli -c -p 6379

192.168.67.143:6379> cluster nodes

//登录主节点,shutdown

192.168.67.143:6379> shutdown

(2)登录redis集群其他节点,查看集群状态

[root@hadoop102 myredis]# redis-cli -c -p 6380

//失联15秒, 发现从机变成主机了

192.168.67.143:6380> cluster nodes

(3)死掉的主机又活 过来了

[root@hadoop102 redis-3.2.5]# redis-server redis6379.conf

[root@hadoop102 myredis]# redis-cli -c -p 6379

//发现死灰复燃的主机,活过来变成了从机

192.168.67.143:6379> cluster nodes

(4)如果主节点下限?从节点能否自动升为主节点?

能,在没有哨兵的情况下也是可以的

(5)主节点恢复后,主从关系会如何?

主从颠倒,主节点恢复后,变从节点

(6)如果所有某一段插槽的主从节点都当掉,redis服务是否还能继续?

看redis.conf配置文件中的参数设置

cluster-require-full-coverage 为yes ,集群下线

no就先凑合用,会有数据丢失

[root@hadoop102 redis]# vim redis.conf

cluster-require-full-coverage yes

这里主要看业务,数据的重要性, 特别重要,设置为yes