3.Hadoop集群测试

大家如果还没配置过Hadoop的可以看我前两篇文章。

验证Hadoop分布式集群

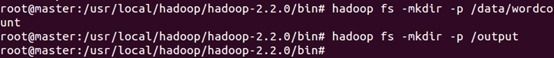

首先在hdfs文件系统上创建两个目录,创建过程如下所示:

hadoop fs –mkdir /data/wordconut

hadoop fs –mkdir /output

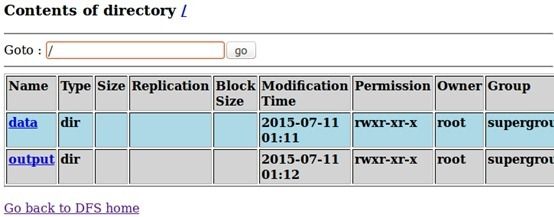

hdfs中的/data/wordcount用来存放Hadoop自带的WordCount例子的数据文件,程序运行的结果输出到/output/wordcount目录中,透过Web控制(http://master:50070)可以发现我们成功创建了两个文件夹:

接下来将本地文件的数据上传到HDFS文件夹中:

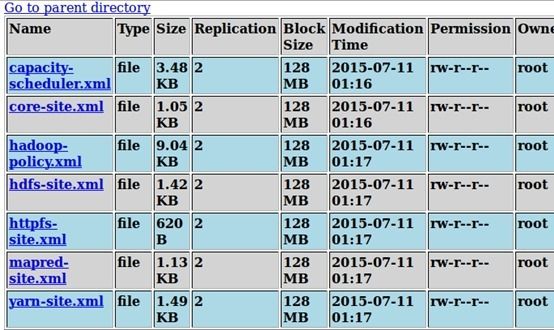

透过Web控制可以发现我们成功上传了文件:

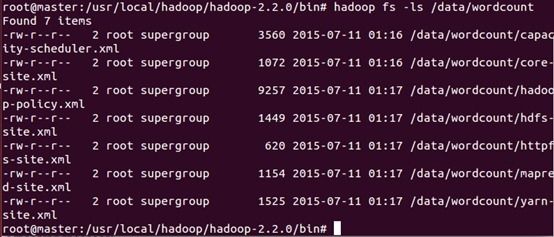

也可通过hadoop的hdfs命令在控制命令终端查看信息:

hadoop fs –ls /data/wordcount

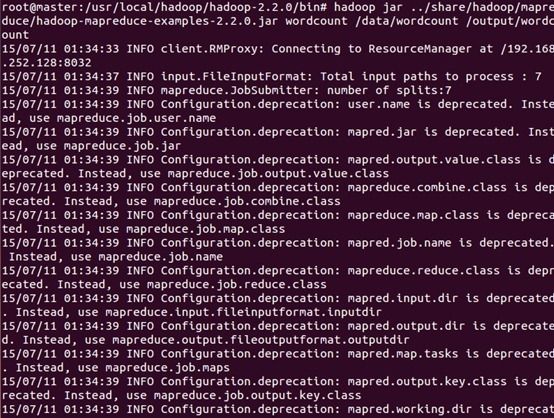

运行Hadoop自带的WordCount例子,执行如下命令:

hadoop jar ../share/hadoop/mapreduce/hadoop-mapreduce-xeamples-2.2.0.jar wordcount /data/wordcount /output/wordcount

(即hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.2.0-sources.jar org.apache.hadoop.examples.WordCount /input /output)

运行过程如下:

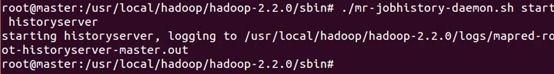

接下来使用“mr-jobhistory-daemon.sh”来启动JobHistory Server:

./mr-jobhistory-daemon.sh start historyserver

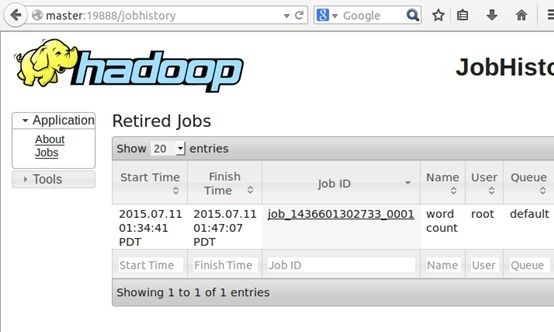

启动后可以通过http://master:19888 在Web控制台上看到JobHistory中的任务执行历史信息:

点击最近运行的WordCount作业进入历史作业详情

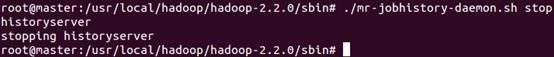

结束historyserver的命令如下所示:

./mr-jobhistory-daemon.sh stop historyserver

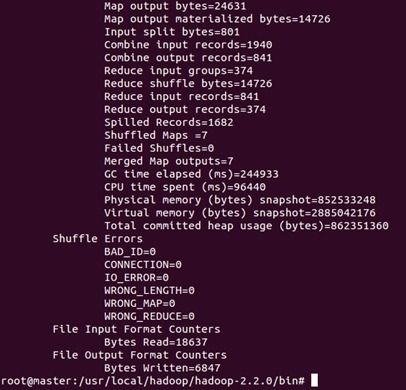

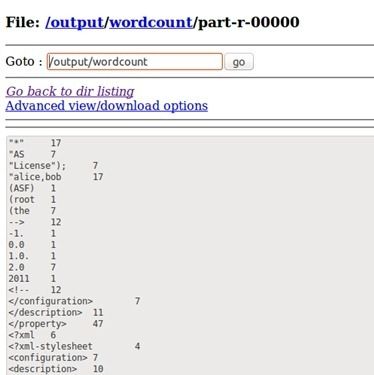

程序运行结束后我们可以执行一下命令查看运行结果:

也可通过HDFS控制台查看运行结果:

发现我们成功运行了WordCount作业。

至此,我们成功构建了Hadoop分布式集群并完成了测试!