Win10配置pyspark环境

需要下载jkd spark hadoop

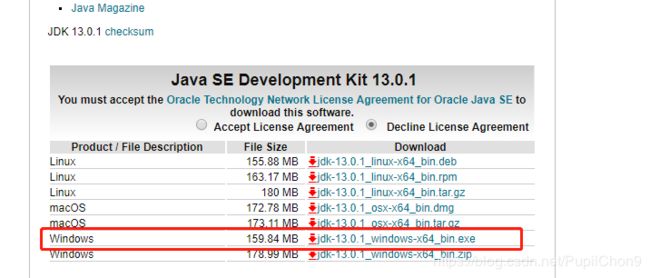

1、jkd

https://www.oracle.com/technetwork/java/javase/downloads/jdk13-downloads-5672538.html

版本你可以下最新的问题不大 不过好像推荐jkd8

直接安装后

(1)创建系统变量名"JAVA_HOME",变量值 D:\Java\jdk-13.0.1(即JDK的安装路径)

(2)在系统变量名Path 上加

%JAVA_HOME%\bin

%JAVA_HOME%\jre\bin

(3)创建系统变量名“CLASSPATH”,变量值为

.;%JAVA_HOME%\lib;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar

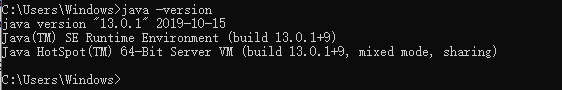

测试一下

2、Spark

http://spark.apache.org/downloads.html

直接下就好了 问题不大

然后解压到某个文件夹

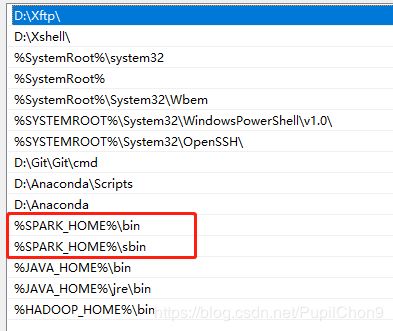

(1)新建系统变量SPARK_HOME,值为Spark安装路径

(2)在系统变量PATH上加

%SPARK_HOME%\bin

%SPARK_HOME%\sbin

3、Hadoop

https://archive.apache.org/dist/hadoop/common/

这里有hadoop上的所有历史版本,你注意看你的spark后面支持什么版本的hadoop就下哪个版本

我的是2.7我就下了这个

https://archive.apache.org/dist/hadoop/common/hadoop-2.7.7/hadoop-2.7.7.tar.gz

和Spark一样解压到某个文件夹

(1)新建系统变量HADOOP_HOME,值为Hadoop安装路径

(2)在系统变量PATH上加

%HADOOP_HOME%\bin

最后需要添加的系统变量和修改的PATH为这些

在cmd中输入spark-shell,前面的warning不用管 应该是jkd版本太高

然后把D:\Spark\spark-3.0.0-preview-bin-hadoop2.7\python下有个叫pyspark的文件夹

复制到你python 安装路径下site-packages下

我是用anaconda的D:\Anaconda\Lib\site-packages下即可

然后再在cmd中输入pyspark,出现和上图一样的

如果报错一般是没安装py4j 装一下就好了

搞定!

ps:

在Pycharm中运行报这个错

py4j.protocol.Py4JError: org.apache.spark.api.python.PythonUtils.getEncryptionEnabled does not exist in the JVM

可以用

import findspark

findspark.init()

或者直接设置

PYTHONPATH= S P A R K H O M E / p y t h o n : SPARK_HOME/python: SPARKHOME/python:SPARK_HOME/python/lib/py4j-0.10.4-src.zip:$PYTHONPATH