python 爬虫如何使用代理IP

python3 爬虫如何使用代理IP

前言

众所周知,爬虫速度过快,频繁访问都会被封IP,怎么解决这个问题呢?再去换一台设备?先不说数据是否同步,仅仅换个设备的成本就不低,这个时候就需要代理IP了。以蘑菇(http://www.moguproxy.com/)代理为例,代理IP在python的使用.

正文

蘑菇官网提供两种方式进行代理,

1.私密API代理:请求API接口,直接返回IP与端口

2.HTTP隧道代理:接入固定代理服务器,动态转发请求,无须切换IP,连接上代理服务器后,每一个请求都是一个随机IP,按并发数/转发数计费。

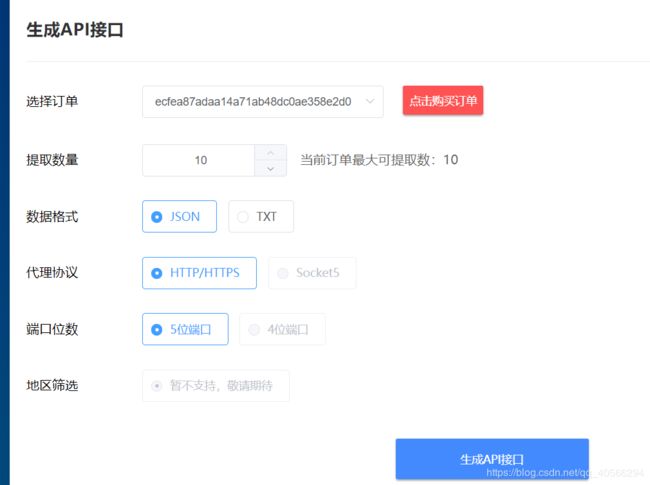

1. 先获取API 链接

从上到下依次执行,拿到API链接

很好接下来就该

import requests

# 生成的API链接

url = 'http://piping.mogumiao.com/proxy/api/get_ip_bs?appKey=ecfea87adaa14a71ab48dc0ae358e2d0&count=10&expiryDate=0&format=1&newLine=2'

resp = requests.get(url=url)

if resp.status_code == 200:

data_json = resp.text

for d in data_json['msg']:

port = d['port']

ip = d['ip']

full_ip = ip + ':' + port

print(full_ip)这就拿到一条条的代理IP了,把IP拼到请求的参数里就行了