基于动态路由的胶囊网络在文本分类上的探索

- 摘要

- 简介

- 模型

- 2.1 N-gram 卷积层

- 2.2 初级胶囊层

- 2.2.1 孩子-父母(部分-整体)关系

- 2.3 动态路由

- 孤立类别

- Leaky-Softmax

- 参数修正

- 实验

- 3.1 实验数据集

- 3.2 实施细节

- 3.3 基本方法

- 实验结果

- 4.1 定量评估

- 4.2 模型简化测试

- 单标签到多标签的分类迁移

- 5.1连接强度的可视化

- 相关工作

- 结论

原文:https://arxiv.org/pdf/1804.00538.pdf

翻译有参考paperweekly上的对原文的翻译。

对概念的理解还不到位,有些地方难免生硬,翻译有问题的话希望能指出,转载请注明谢谢!

摘要

在这项研究中,我们用基于动态路由的胶囊网络来探索文本分类。我们提出了三种策略来稳定动态路由过程,以减少一些可能包含环境信息或尚未成功训练的噪声胶囊的干扰。在六个文本分类的基准文本集上对胶囊网络进行了一系列实验。胶囊网络作为基本方法时可以对其中的4个有最好的效果,这些都体现了胶囊网络对文本分类的有效性。我们另外发现,在单标签到多标签迁移的任务上,胶囊网络显示出显着的改进。 据我们所知,这是胶囊网络在实际建模过程中所做的第一项工作。

简介

对文章和句法的建模是自然语言处理领域里的一大主题。这项任务可以和关键词/语法匹配一样简单,但如果考虑文本的组成、层次和结构,就会成为一个复杂的问题。比如,一篇提到“美国大选”这一个词的文章有很有可能被分类到政治新闻中去。但是,很难判断出作者更为支持哪一位总统候选人,或者作者在文中的观点是偏自由还是偏保守。

早期对文本建模的成果,已经在文本分类方面取得了一些成功,使用简单的词袋子分类器(Joachims,1998;McCallum等,1998),意味着理解独立单词或N-gram词组的含义是研究复杂模型的必要步骤。因此,这也不奇怪出现了分布式的词语表示法,也就是词嵌入/词向量,已经得到NLP社区的高度关注,解决了在基本层面上应该对什么(词义)建模的疑问(Mikolov等,2013;Pennington等,2014).。为了对文本中的更高层次的概念和事实建模,NLP研究人员必须思考这个问题:除了词义实际上还需要对什么建模。这个问题的一个常见方法是将文本视为序列并关注其空间模式,其代表包括卷积神经网络(CNN)(Kim,2014;Zhang等,2015;Conneau等,2017)和长短记忆网络(LSTM)(Taietal,2015;Mousa与Schuller,2017)另一种常见的方法是完全忽略单词的顺序,而将这些单词作为一个集合,其代表包括概率主题模型(Blei等,2003;Mcauliffe与Blei,2008)和Earth Mover的基于距离的建模(Kusner等,2015; Ye等,2017)。

这两类方法尽管与计算观点有很大不同,但实际上遵循了一种常见的方法来判断他们对“什么”问题的答案。在神经网络方法中,较低层面的空间格局集中有助于表示更高层次的概念。在这里,他们形成一个递归过程来阐明要建模的内容。例如,CNN构建卷积特征检测器以从矢量序列的窗口中提取局部模式,并使用最大池化来选择最显着的那个。然后,它在多个层次上分层构建这种模式并汇集到一起。作为一种空间敏感模型,CNN为网格上复制特征探测器的低效性付出了代价。正如在(Sabour等,2017)中所论述的,人们必须在大小随维数增加指数增长的复制检测器和以类似指数方式增加标记训练集的体积之间进行选择。另一方面,空间不敏感的方法在判断的场景中是完全有效的,而不管任何单词或局部模式的顺序如何。但是,它们不可避免地受限于特征序列中呈现的丰富结构。因此,提高编码序列空间顺序的效率,同时保持代表能力的灵活性是一个主要问题。

(Sabour等,2017)最近引入的一种称为胶囊网络的方法具有这种潜力,可用于上述问题。他们引入了迭代路由过程来决定低层和高层节点之间的指向。他们提出的一个隐喻(也是一个论点)是,人类视觉系统在推断时智能地将部分分配给整体,而不需要把整体都看遍并理解到位。作为结果,他们的模型可以编码部分和整体之间的内在空间关系,从而构成基于已有的知识从看到的局部自动生成看到新的东西。

在我们的工作中,我们遵循类似的精神来使用这种技术来建模文本。提出了三种策略来稳定动态路由过程,以防止某些可能含有环境信息(如停用词和与特定类别无关的词)的噪音胶囊的扰动。我们在六个文本分类基准文本集的预先训练的单词向量之上进行了一系列胶囊网络实验。更重要的是,相较基准方法中将单标签转换为多标签文本分类时,胶囊网络是可以显着改进。

模型

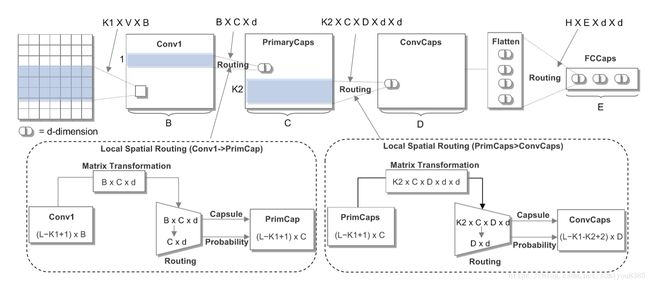

我们的胶囊网路如图1,是在 (Sabour等,2017)发表的胶囊网络的变种。包含了四层:N-gram 卷积层、初级胶囊层、卷积胶囊层、及全连接胶囊层。实际上我们探索了两种胶囊框架,用不同方法来整合这四个组成部分。在这部分,我们来详细阐述一下重要组成部分。

2.1 N-gram 卷积层

这一层是一个标准的卷积层,它通过各种卷积滤波器在句子的不同位置提取N-gram特征。假设 x∈R(L×V) x ∈ R ( L × V ) 表示一句句子的输入(其中 L L 是句子的长度, V V 是词向量的维度)。 xi∈RV x i ∈ R V 为句子中的第 i i 个词语所对应的 V V 维的词向量。 Wa∈RK1×V W a ∈ R K 1 × V 为卷积运算过滤器,里面 K1 K 1 是N-gram的长度,在句子上的滑动窗口的长度,用于在句子的不同位置抽取特征。一个过滤器 Wa W a 在每个位置(步长为1)用词窗口 xi:i+K1−1 x i : i + K 1 − 1 生成一个列特征映射 ma∈RL−K1+1 m a ∈ R L − K 1 + 1 这个特征集中的每一个元素 mai∈R m i a ∈ R

由公式

得出。其中 ▫ ▫ 是单元乘法, b0 b 0 是偏置项, f f 是非线性激活函数(如ReLU)。我们已经描述了从一个过滤器中提取一个特征的过程。因此,对于 a=1,...,B, a = 1 , . . . , B , 一共有 B B 个拥有相同的N-gram尺寸的滤波器,可以生成 B B 个特征映射,可以重新排列为

2.2 初级胶囊层

这是第一个胶囊层,其中胶囊用矢量输出胶囊代替CNN的标量输出特征检测器以保留实例化参数,例如词的本地顺序和词的语义表示。

假设 pi∈Rd p i ∈ R d 表示胶囊的实例化参数集合,其中 d d 是胶囊的尺寸。

设 Wb∈RB×d W b ∈ R B × d 是不同窗口共享的滤波器。对于每个矩阵乘法,我们有一个窗口滑动每个N-gram向量,表示为 Mi∈RB M i ∈ R B ,然后产生胶囊形式的对应N-gram短语。过滤器 Wb W b 将N-gram向量 Mi M i 逐步以1的步幅相乘以产生胶囊的列表 P∈R(L−K1+1)×d P ∈ R ( L − K 1 + 1 ) × d ,列表中的每个胶囊 pi∈Rd p i ∈ R d 被计算为

其中g是通过整个向量的非线性压缩函数,b1是胶囊偏置项,对于所有的C个滤波器,生成的胶囊特征映射可以重新排列为

在P中一共有 (L−K1+1)×C ( L − K 1 + 1 ) × C 个 d d 维向量作为“胶囊”。

图1:用于文本分类的胶囊网络体系结构,下半部分显示的是层与层之间动态路由的过程。

2.2.1 孩子-父母(部分-整体)关系

胶囊网络试图解决与变换矩阵卷积的限制和指数低效率问题。它允许网络自动学习孩子-父母(或者说部分-整体)关系。

在本文中,我们探索两种不同类型的变换矩阵,从它的子胶囊i到父胶囊j生成预测向量 û j|i∈Rd u ̂ j | i ∈ R d 。第一种方法,在下面的图层中的孩子胶囊之间共享 Wt1∈RN×d×d W t 1 ∈ R N × d × d 的权重,其中N是上面图层中父级胶囊的数量。形式上,每个相应的预测向量可以通过以下来计算:

û j|i=Wt1jui+b̂ j|i∈Rd......(5) u ̂ j | i = W j t 1 u i + b ̂ j | i ∈ R d . . . . . . ( 5 )

其中 ui u i 是下图层中的子囊,而 b̂ j|i b ̂ j | i 是胶囊偏置项。在第二种设计中,我们用非共享权重矩阵 Wt2i,j W i , j t 2 代替共享权重矩阵 Wt1j W j t 1 ,其中权重矩阵 Wt2∈RH×N×d×d W t 2 ∈ R H × N × d × d 和 H H 是下面图层中子数据包的数量。

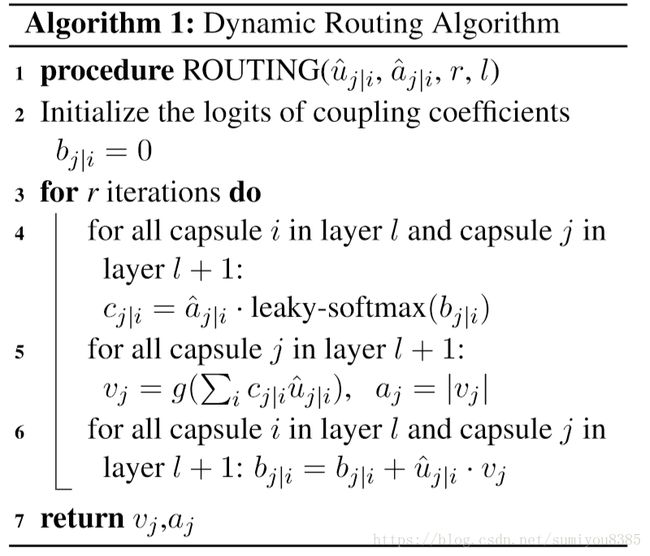

2.3 动态路由

动态路由的基本目的就是设计一个这样的非线性映射:

非线性映射以迭代的方式构造,确保每个胶囊的输出被发送到后续层中的适当父代。对于每个潜在的父节点,胶囊网络可以通过动态路由来增加或减少连接强度,这比CNN中的基本路由策略更有效,例如CNN中的最大池化技术,其基本上检测特征是否存在于文本的任何位置,但丢失了关于该特征的空间信息。我们探讨了三种策略,通过减轻一些噪音胶囊的干扰来提高路由过程的准确性:

孤立类别

受到(Sabour等,2017)的启发,在网络中增加了一个额外的孤立类别,它可以捕捉一些背景知识,比如停用词或与特定类别无关的词。在文本中添加“孤立”类别比在图像更有效,因为图像中没有单一的一致环境对象,而文本中是一致的,比如停用词中的谓词、代词词语。

Leaky-Softmax

我们在标准softmax的基础上探索Leaky-Softmax(Sabour等,2017),同时更新孩子胶囊与其父母之间的连接强度。尽管最后一个胶囊层中存在孤立类别,但我们还需要在两个连续层之间采用轻量化方法,以便将噪声子胶囊引到额外的维度,而无需任何额外的参数和计算量。

算法1:动态路由算法

参数修正

传统的路由参数,通常用均与分布进行初始化,忽略了下层胶囊的概率。相反,我们把下层胶囊的概率当成路由参数的先验,改进路由过程。 在模型简化测试中,我们对改进的路由和原始路由方法进行对比,如下:

我们也尝试使用前一层中孩子胶囊的存在概率来反复修正连接强度,如公式6所示。

给定每个预测向量 û j|i u ̂ j | i 及其存在的概率 â j|i a ̂ j | i ,其中 â j|i=â i a ̂ j | i = a ̂ i ,每个连接强度的迭代耦合系数 cj|i c j | i 用式

来更新,其中 bj|i b j | i 是耦合系数的对数。这层中的每个父胶囊 vj v j 是对所有预测矢量 û j|i u ̂ j | i 的加权和:

其中 aj a j 是父胶囊的概率,g是整个向量的非线性压缩函数(Sabour等,2017)。一旦产生了所有的母胶囊,每个耦合系数 bj|i b j | i 被更新为:

为了简化符号,父胶囊及其在层中的概率以上表示为

其中 û u ̂ 表示前一层中的所有子胶囊, v v 表示所有父胶囊及其概率 a a 。我们的动态路由算法在算法1中进行了总结。

2.4 卷积胶囊层

在这一层中,每个胶囊仅连接到下面一层空间上的局部区域K_2×C。该区域中的那些胶囊将乘以变换矩阵来学习孩子 - 父母关系,然后通过协议路由以在上述层中生成父胶囊。假设 Wc1∈RD×d×d W c 1 ∈ R D × d × d 且 Wc2∈RK2×C×D×d×d W c 2 ∈ R K 2 × C × D × d × d 分别表示共享权重和非共享权重,其中 K2×C K 2 × C 是下一层局部区域中子囊的数量,D是子胶囊被发送到的父胶囊的数量。当变换矩阵在孩子胶囊中共享时,每个潜在的父胶囊 û j|i u ̂ j | i 由其产生

其中 b̂ j|i b ̂ j | i 是胶囊偏置项, ui u i 是局部区域 K2×C K 2 × C 中的子囊, Wc1j W j c 1 是张量 Wc1 W c 1 中的第 j j 个矩阵。然后,我们使用协议路由在该层中生成父胶囊特征映射 (L−K1−K2+2)×D ( L − K 1 − K 2 + 2 ) × D 维胶囊。

当在子胶囊中使用非共享权重时,我们用 Wc2j W j c 2 来代替式(10)变换矩阵中的 Wc1j W j c 1

2.5 全连接胶囊层

下一层的胶囊被放入了一个胶囊列表中,并输入到全连接的胶囊层中,胶囊与胶囊乘以变换矩阵 Wd1∈RE×d×d W d 1 ∈ R E × d × d 或 Wd2∈R(H×E×d×d) W d 2 ∈ R ( H × E × d × d ) ,然后通过协议路由产生最终的胶囊 vj∈Rd v j ∈ R d 及其概率 aj∈R a j ∈ R 为每个类别。这里, H H 是子胶囊的数量, E E 是类别加上一个额外的孤立类别的数量。

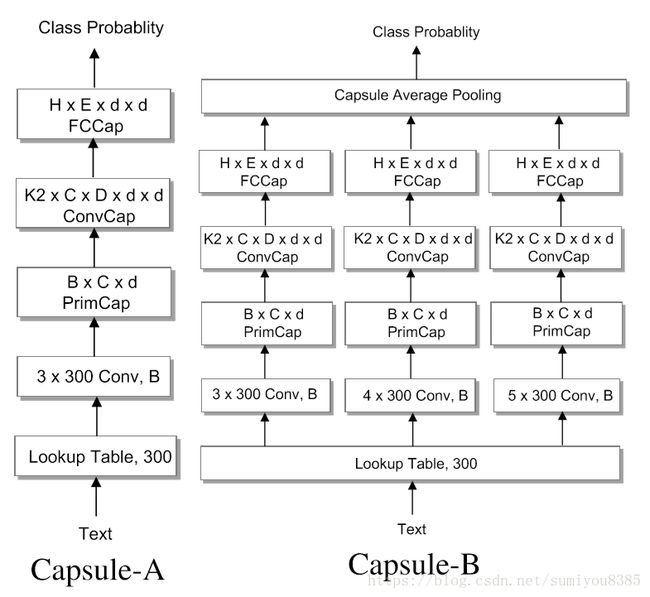

2.6胶囊网络的架构

我们探索了两种胶囊架构(表示为Capsule-A和Capsule-B),以不同的方式将这四个组件整合在一起,如图2所示。

Capsule-A从嵌入层开始,将语料库中的每个单词转换为300维(V = 300)词向量,后面是3-gram的(K1 = 3)具有32个滤波器(B = 32)的卷积层,滑动步长为1,ReLU非线性激活函数。所有其他层都是胶囊层,起始于具有32个滤波器(C = 32)的B×d初级胶囊层,接着是具有16个滤波器(D = 16)的3×C×d×d(K2 = 3)卷积胶囊层和一个全连接胶囊层。每个胶囊具有16维(d = 16)实例化参数,并且它们的长度可以描述胶囊存在的概率。胶囊层之间通过变换矩阵连接,并且每个连接也乘以路由系数,该路由系数通过协议路由机制动态计算得到。Capsule-B的基本结构与Capsule-A类似,不同之处在于我们在N-gram卷积层中采用了滤波窗口(N)为3,4,5的三个并行网络(见图2)。完全连接的胶囊层的最终输出被馈送到平均池中以产生最终结果。这样,Capsule-B可以学习更有意义和更全面的文本表示。

图2:两种胶囊网络的架构

实验

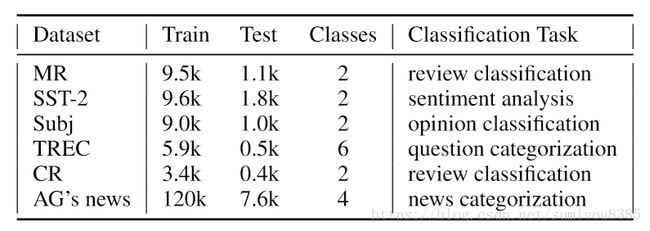

3.1 实验数据集

为了评估我们的模型的有效性,我们对六个标准数据集进行了一系列的实验,包括:movie reviews (MR) (Pang and Lee,2005),Stanford Sentiment Treebankan extension of MR (SST-2) (Socher等,2013), Subjectivity dataset (Subj) (Pang and Lee, 2004), TREC questiondataset(TREC)(LiandRoth,2002),customer review (CR) (Hu and Liu, 2004), and AG’s news corpus (Conneau等,2017). 这些标准数据集涵盖了几种文本分类任务,如情感分类,问题分类,新闻分类。详细的统计数据见表1。

表1:数据集的统计

3.2 实施细节

在实验中,我们使用300维的word2vec(Mikolov等,2013)向量来初始化嵌入向量。我们为AG的新闻进行规模为50的小批次划分,其他数据集的规格为25。

3.3 基本方法

在实验中,我们评估和比较了我们的模型与几种效果比较好的基本方法,包括:LSTM / Bi-LSTM(Cho等,2014),树型LSTM(Tree-LSTM)(Tai等,2015),通过语言知识正则化的 LSTM (LR-LSTM) (Qian等,2016)CNNrand/CNN-static/CNN-non-static(Kim等,2014),深层卷积网络(VD-CNN)(Conneau等,2016)和字符级卷积网络(CL-CNN)(Zhang等,2015)。

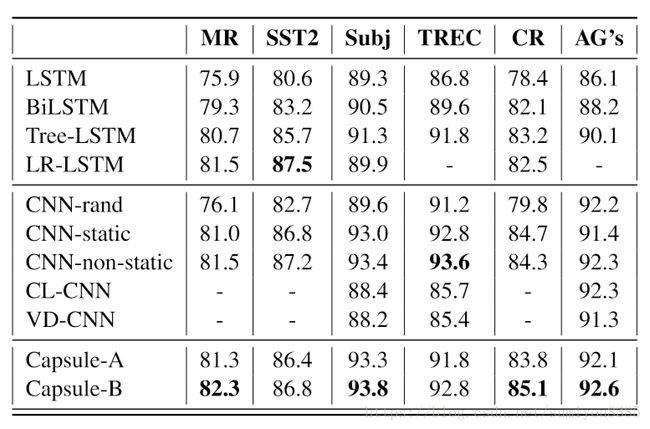

表2:在六个文本分类数据集上比较胶囊网络和其他基本方法

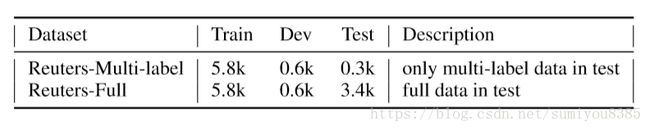

表3:路透社21578条语料库的统计

实验结果

4.1 定量评估

在我们的实验中,评估指标是分类的精度。我们实验结果总结到了表2中。从结果中,我们观察到胶囊网络在6个数据集中有4个达到最佳结果,这验证了胶囊网络的有效性。

具体而言,我们的模型在所有实验数据集上都明显优于简单的深层神经网络,如LSTM,Bi-LSTM和CNN-rand。与LR-LSTM,Tree-LSTM,VC-CNN和CL-CNN等更复杂的深度学习模型相比,胶囊网络也可以获得有相当竞争性的成果。值得注意的是,Capsule-B始终比Capsule-A效果更好,因为Capsule-B允许学习更有意义和更全面的文本表示。例如,N-gram卷积层与{3,4,5}滤镜窗口的组合,可以捕捉在文本建模中起关键作用的3/4/5-gram的文本特征。

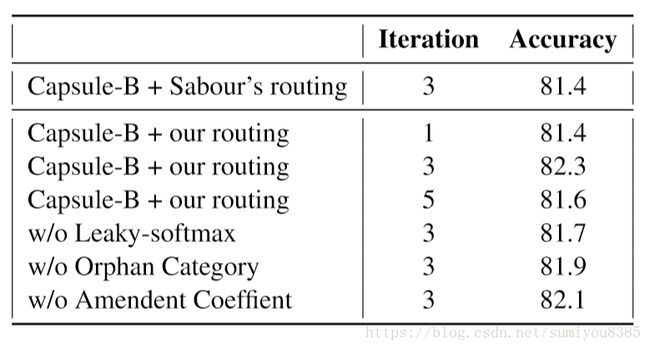

4.2 模型简化测试

为了分析我们的胶囊架构的不同组件对文本分类的影响,我们还报告了使用胶囊网络的不同设置的胶囊B模型的模型简化测试。实验结果总结在表5中。通常,所有三种提出的动态路由策略通过减轻一些可能包含“背景”信息的噪声胶囊的干扰(例如,对于特定类别无关的词和词)而有助于Capsule-B的有效性。补充材料表A.4列出了更全面的比较结果。

表5:MR数据集上的Capsule-B的模型简化研究。标准路由是在最后一个胶囊层中没有leaky-softmax和孤立类别的协议路由算法。附录中讨论了更多。

单标签到多标签的分类迁移

胶囊网络在单标签文本分类中表现出很有前景的性能,它将预定义集合中的标签分配给文本(参见表2)。然而,多标签文本分类是一个更具挑战性的实际问题。从单标签到多标签(带有n个类别标签)的文本分类,标签空间从n扩展到2n,因此需要更多的训练来覆盖整个标签空间。单标签文字,实际上很容易收集和注释样本。然而,大规模多标签文本数据集的收集和注释负担通常非常高。由于多标签训练样本不足,神经网络(例如,CNN和LSTM)如何最好地处理多标签文本分类仍然是个问题。在本节中,我们通过仅使用单标签样本作为训练数据来研究胶囊网络对多标签文本分类的能力。将特征属性作为胶囊提取信息的一部分,我们可以更好地将模型推广到多标签文本分类,而不需要大量的标记数据。

模型评估在路透社的21578条数据集上进行(Lewis,1992)。该数据集由路透金融新闻专线服务的10,788份文件组成,每份文件包含多个标签或单个标签。我们重新处理语料库以评估胶囊网络从单标签到多标签文本分类的能力。对于开发集和训练集,我们只使用路透社数据集里的开发集和训练集。对于测试,Reuters Multi-label仅在测试数据集中使用多标签文档,而Reuters-Full包含测试集中的所有文档。表3描述了这两个数据集的特征。

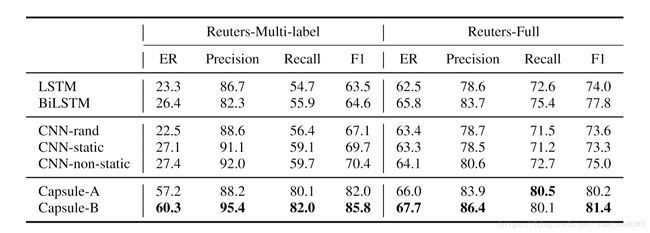

根据(Sorower,2010),我们采用微平均精度(Precision),微平均召回(Recall)和微平均F1评分(F1)作为多标签文本分类的评估指标。这些分数中的任何一个都是首先在各个类别标签上计算出来的,然后在所有类别上进行平均,称为基于标签的度量。此外,我们还测量精确匹配率(ER),将部分正确的预测视为不正确,而只计算完全正确的样本。

实验结果总结在表4中。从结果中,我们可以观察到,在Reuters Multi-label、Reuters-Full中,胶囊网络相较于基本方法,在所有四个评估指标方面都有显着的改进数据集。

尤其是,在Reuters Multi-label中的中很大改进,这份数据集的测试集中仅包含多标签文档。这些符合我们的预期,因为胶囊网络能够保留由单个标签文档训练的类别的实例化参数。胶囊网络具有比常规深度神经网络更强的传输能力。此外,Reuters-Full的良好结果还表明,胶囊网络在单标签文件上也具有超过竞争对手的强大优势。

表4:在Reuters Multi-label、Reuters-Full中,从单标签到多标签文本分类的转换能力比较。为了公平比较,我们对模型和其他基本方法使用了边际损失。

5.1连接强度的可视化

为了清楚地显示胶囊层之间的连接强度,我们移除卷积胶囊层并且直接使初级胶囊层和全连接胶囊层,其中初级胶囊表示胶囊形式的N-gram短语。

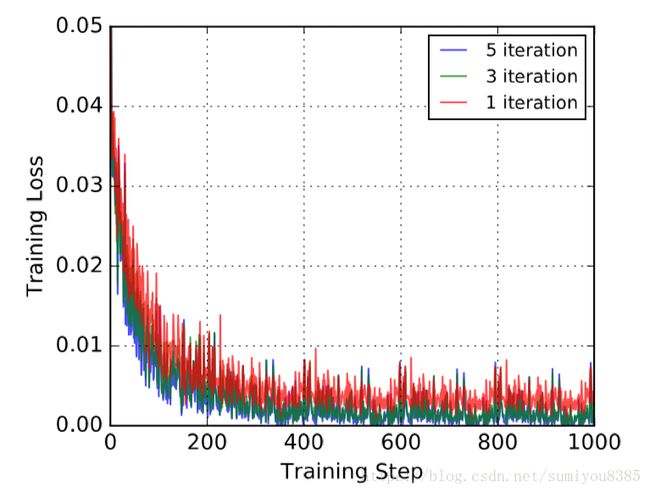

连接强度显示了每个初级胶囊对于文本类别的重要性,就像一个平行关注机制(parallel attention mechanism)。这个可以让胶囊网络识别文本中的多个类别,即使模型是在单标签文档上进行培训。由于空间有限,我们选择了多个来自Reuters Multi-label的标签文档,其类别标签(即Interest Rates利率和Money/Foreign Exchange货币/外汇交易)通过我们的模型以高置信度(p> 0.8)被正确预测(完全正确),这些数据在表6中有报告出来。像”Interest Rates”和”Money/Foreign Exchange”这类的特定短语用红色突出显示。我们使用标签云来显示利率和货币/外汇类别的3-gram短语。连接强度越大,字体越大。从结果中,我们观察到胶囊网络可以正确识别并划分关于文本类别的重要短语。表6所示(底线)的直方图,用于显示初级胶囊和全连接胶囊之间的连接强度强度。由于空间有限,展示了五个直方图。路由程序将正确地选择预测向量来对”Interest Rates”和”Money/Foreign Exchange”分类。更多的例子可以在补充材料的表A.2-A.3中找到。为了通过实验验证路由算法的收敛性,我们还绘制了学习曲线,以显示随着时间的不同迭代路由的训练损失。从图3中,我们观察到,具有3次或5次路由迭代的Capsule-B能够更快地优化损失,并相较1次路由迭代最终能收敛到更低的损失。

表6:初级胶囊与全连接胶囊之间的连接强度的可视化,使用3-gram的词云和强度的直方图。 x轴表示为例子选择的初级胶囊(3-gram短语),y轴表示连接强度的强度。结果从用3次路由迭代训练的Capsule-B中得到。原始文本(第一列)中的红色类别特定关键短语手动标注以供参考。

图3:capsule-B在Reuters Multi-label上的训练损失

相关工作

早期的文本分类方法采用了词袋子模型,N-gram和TF-IDF等典型特征(Zhang等,2008)作为机器学习算法的输入,如支持向量机(SVM)(Joachims,1998),逻辑回归(Genkinetal,2007),朴素贝叶斯(NB)(McCallum等,1998)进行分类。然而,这些模型通常严重依赖于费力的特征工程或大量额外的语言资源。

深度神经网络和表征学习的最新进展大大提高了文本分类任务的性能。主要的方法是循环神经网络,特别是LSTMs和CNNs。(Kim,2014)研究了一系列关于CNNs的实验,这些实验是在预先训练的单词向量的基础上进行的,用于句级分类任务。当时的CNN模型在7项任务中的4项改进了最新技术。(Zhang等,2015)提供了一个关于使用字符级卷积网络(Convnets)进行文本分类的实证研究,实验表明Convnets跑赢了传统模式。(Joulin等,2016)提出了一个简单而有效的文本分类方法fastText,可以在十分钟内对十亿字进行训练。(Conneau等,2017)提出了一个非常深的卷积网络(有29个卷积层)用于文本分类。(Tai等,2015)将LSTM推广到树形网络拓扑(Tree-LSTM),该网络拓扑在两个文本分类任务中取得了最佳结果。

最近,提出了一种新型的神经网络,利用胶囊的概念来改善CNN和RNN的表征局限性。(Hinton等,2011)首先介绍了“胶囊”的概念,以解决CNN和RNN的代表性局限性。具有变换矩阵的胶囊允许网络自动学习部分 - 整体关系。因此,(Sabour等,2017)提出了胶囊网络,其用矢量输出胶囊代替了CNN的标量输出特征检测器,并通过协议路由来代替最大池化。胶囊网络通过在MNIST数据上实现最新的结果显示了它的潜力。然而,与CNN中的最大池化技术不同,胶囊网络不会丢弃有关该区域内实体的准确位置的信息。对于低级胶囊,位置信息被编码到较为活跃的胶囊中。(Xi等,2017)进一步测试了胶囊网络在维数较高的CIFAR数据上的应用。(Hinton等,2018)提出了一种基于EM算法的胶囊层之间的迭代路由过程,该算法在小型NORB数据集上实现了更好的精度。迄今为止,还没有工作调查NLP任务中胶囊网络的性能。这项研究在这个主题中占据领先地位。

结论

在本文中,我们调查了用动态路由进行文本分类的胶囊网络。提出了三种策略来提高动态路由过程的性能,以减轻噪声胶囊的干扰。在六个文本分类基准上的大量实验显示了胶囊网络在文本分类中的有效性。更重要的是,当通过与已有效果较好的基本方法比较,测试单标签到多标签文本分类时,胶囊网络也显示出显着的改进。