CCAI 2017 | 南加州大学计算机系终身教授刘燕:艺术与人工智能的明天——人机信任合作...

7 月 22 - 23 日,在中国科学技术协会、中国科学院的指导下,由中国人工智能学会、阿里巴巴集团 & 蚂蚁金服主办,CSDN、中国科学院自动化研究所承办的 2017 中国人工智能大会(CCAI 2017)在杭州国际会议中心盛大召开。

大会第二天下午,南加州大学计算机系终身教授、机器学习中心主任刘燕参与了【人工智能科学与艺术】论坛的讨论,并发表了《艺术与人工智能的明天——人机信任合作》主题演讲,刘燕教授认为将来人工智能与艺术的结合,主要在于人机信任合作,在提供可解释性、可迁移性、可靠性方面进行长足的发展。刘燕教授从DeepDream、Megenta、Angelina、Sunspring等振奋人心的最新AI艺术项目和作品入手,谈人工智能与艺术的共同点、不同点。从可解释性的角度,人工智能和艺术都是目前无法解释的黑箱,但人工智能在黑箱解释方面还是有一些最新的进展。

以下为演讲实录,在不改变原意的情况下做了些许删减和调整。

大家好,今天非常开心有这个机会,让我谈一下未来人工智能对于人类艺术方面的结合。我今天探讨的中心是人机的信任合作,我相信这是艺术与人工智能的明天。

去年,Alpha GO基本上实现了全机器性质的计算学习,打败了人类的下棋高手。人工智能的发展是快速的,同时也如热浪袭来,我们还没有准备好,就已经淹没在热浪当中。这种大环境,也是为什么组委会想让我们讨论一下,人工智能与艺术方面的一些合作的原因。

一、人工智能在艺术上的发展

技术应用于艺术,从古至今都是有的。比如,文艺复兴时期,非常有名的画家Hans Holbein作了一幅画,里面有一个头骨,我们用肉眼看的时候,不能辨别这个头骨。其实画家用了一种技术,他把头骨画在一张纸上,倾斜的放在多面上,然后通过灯光的投影,就可以看到一个侧向的头骨。他想利用技术的方法实现光影的效果,来作为一种隐喻。其实,人工智能作为一种技术,也可以与艺术相辅相成。

现在有许多人工智能在艺术方面的创作。比如,DeepDream,能够创造非常美丽的,不同于我们常人想象的照片。像《盗梦空间》里,可以从一个空间到另外一个空间一样,DeepDream想告诉我们,通过人工智能的办法,我们人类可以转移到另外一个空间,看到非常不一样的东西。DeepDream的团队也是希望能够帮助艺术有所发展。

还比如,谷歌的Megenta,它是用人工智能创造音乐。还有Angelina,它用人工智能创造游戏,大家玩起来非常的新鲜。人工智能甚至还能创造电影剧本,比如说Sunspring。

二、艺术家对人工智能在艺术创造上发展的观点

人工智能在艺术方面的发展已经非常振奋人心了,我们再来看看一些艺术家们对人工智能创造的艺术是怎样一种看法?

我总结了一下杨安女士采访叶永青先生的观点,他觉得人工智能在艺术创造方面还不能达到人类的巅峰,主要在三个方面。

1.个性化。每位画家都想要表现个性,想要表现一种对生活和对自然的不完美的态度。大部分机器学习的办法是通过计算找到完美的解法。从这个角度来讲,机器与人类是不一样的。

2.表达与共鸣。这个共鸣存在很多不同的阶段,比如,我在说一段话的时候,大家能够从意识上大概理解我想要表达的意思,但如果我想表达一个非常准确的意思,我不一能够做到。举个例子,西班牙语对色彩的描述有很多不同的词,再看西班牙画家的作品,色彩非常鲜艳。所以说,表达和共鸣是由文化和语言所产生的,这个在机器学习、人工智能方面还有长足的发展。

3.时代性。我小时候看过一部电视剧叫《渴望》,那个时候大家非常喜欢看这部电视剧,但如果把这部电视给现在的孩子看,他就不一定会觉得有意思。因为艺术反映的是一个时代的特征,只有在那个时代经历过的人,才有共鸣。

从这些角度来讲,叶永青先生给我们做了非常好的回答,人工智能和艺术是有非常大的不同的,在这条道路上有很多的瓶颈。

三、可解释性人工智能

我列举了很多不同的研究问题,比如说人工智能的迁移问题,人工智能情感研究方面的问题,还有可解释性人工智能,即我怎么理解这个艺术。我先就可解释性人工智能方面给大家一个引子。

1、为什么需要可解释性人工智能?

我认为其实人工智能和艺术有共同点。比如,你问一个艺术家什么是艺术,他们每个人都有不同的解释;再比如,当我们看到一幅名画的时候,我们答不上来它为什么有名,需要专家给我们解释。

类似的,从人工智能角度来讲,很多时候都是以黑匣子的方式,只是用它,但是不知道为什么会这样子。所以从这个方面角度来讲,人工智能与艺术现在对于可解释性方面确确实实是一个非常大的难点。

2、可解释性人工智能为什么重要?

打个比方,在医疗AI方面,当我们给医生建造一个预测糖尿病的模型,病人可能不太相信模型,他们会有疑问,为什么我有糖尿病,而另外一个人没有。从这个角度上来讲,可解释性人工智能很重要。

另外就是信任问题。说一个经典的例子,一篇KDD2016有关于LIME算法的文章讲到:其实机器很容易被愚弄。文章中做了一个非常有趣的事情,收集了100张哈士奇的照片,想要机器区分它和狼,狼的照片里面都有雪作为背景,哈士奇照片里是非雪的背景,最后机器认为有雪的地方里面的动物就是狼。这极端的颠覆了我们的常识,也说明了为什么我们需要可解释性的人工智能。

通过可解释人工智能,有可能提高人们对艺术的理解。什么时候什么样的作品能让人们产生美感,以及知道这个时候我们如何的评价和估价艺术作品,从这些角度来讲,其实可解释性是非常重要的。

3、可解释性人工智能的方法

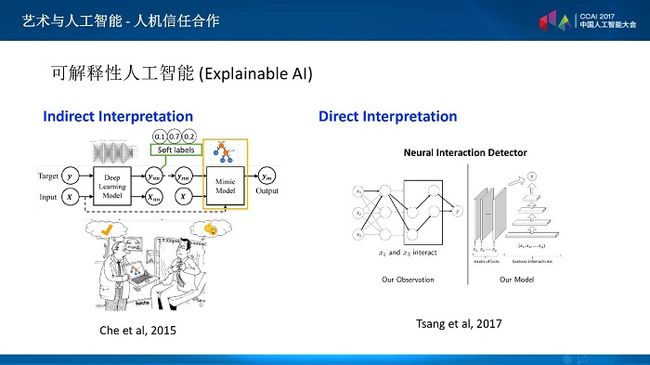

关于可解释性人工智能大概可以分为两种,一种是关于间接解释,利用的办法是解释预测结果,看一看深度网络是怎样做预测的。比如,可以看看在深度学习里面,哪些特征是非常重要的,或者改变一下网络的构造,使它能够解释这个模型。

在间接解释这方面,我的研究成果里运用了模仿学习:主要想法是说我们可以先用一种深度学习的办法,去建一个模型,之后我们可以通过小数点后面的值,大概判断出它的不同区间的预测。通过这种办法我们把数据放在简单的模型里面,我们用的是一些决策树的模型,这样的模型比较容易解释,同时又能够模仿,这是非常好的方法。

直接解释方面,有一种神经交互的检测系统,我们可以通过深度学习的模型看一下不同的特征之间是怎么样交互的,这样通过这种交互,我们就能够得到正确的方程式。这样也能够帮助我们解释。

很多时候大家都在问,十年之后什么工作会被人工智能取代?我认为艺术是最有创作性的工作,它很难被取代。

所以我认为将来人工智能与艺术的结合主要还是人机信任合作,在提供可解释性、可迁移性、可靠性方面,能够进行长足的发展。这样我们能够同时利用机器擅长的方面和人擅长的方面,创作最好的艺术。

CCAI 2017 更多精彩内容,请关注微信公众号“AI 科技大本营”,一次掌握“现场微信群”、“图文报道”、 “PPT 下载”、“大会会刊”所有入口!