liunx环境要求

搭建平台

搭建平台CentOS6.4

Hadoop版本 Hadoop2.4.1

Java版本 java1.7

https://pan.baidu.com/s/1ck94gI 密码:ofgb

准备虚拟机网络设置

打开VMware-->编辑-->虚拟网络编辑器-->更改设备-->VMnet8-->设置子网为192.168.8.0,子网掩码255.255.255.0-->NAT设置-->网关设为192.168.8.2-->确定

windows--> 打开网络和共享中心 -> 更改适配器设置 -> 右键VMnet8 -> 属性 -> 双击IPv4 -> 设置windows的IP:192.168.8.9 子网掩码:255.255.255.0 网关:192.168.8.2-->确定

VMware -->我的计算机 --> 选中CentOS --> 右键 --> 设置--> 网络适配器--> NAT模式--> 确定

修改主机名

$ vim /etc/sysconfig/networ

NETWORKING=yes

HOSTNAME=master

修改IP

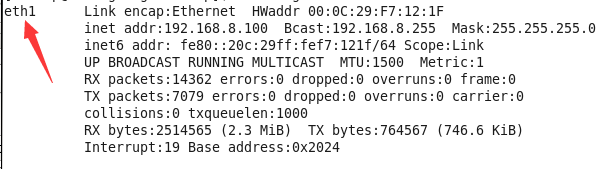

先试用命令查看本机网卡和ip

ifconfig

方法一:使用CentOS的图形界面

右键点击右上方的两个小电脑 --> 点击Edit connections -> 选中ifconfig显示的网卡 -> 双击-> 选择IPv4 -> Method设置为manual -> add -> IP:192.168.8.10 子网掩码:255.255.255.0 网关:192.168.8.2 -> apply

方法二:修改配置文件方式

$ vim /etc/sysconfig/network-scripts/ifcfg-Auto_eth1

192.168.8.10

PREFIX=24

GATEWAY=192.168.8.2

DEFROUTE=yes

IPV4_FAILURE_FATAL=yes

IPV6INIT=no

NAME="Auto eth1"

UUID=48636279-aad6-4432-bfbd-e06e3a25b5e7

ONBOOT=yes

HWADDR=00:0C:29:F7:12:1F

LAST_CONNECT=1514422930

添加主机名和IP的映射

$ vim /etc/hosts

192.168.8.10 master

关闭防火墙

$ service iptables status #查看防火墙状态

$ service iptables stop #关闭防火墙

$ chkconfig iptables --list #查看防火墙开机启动状态

$ chkconfig iptables off #关闭防火墙开机启动

重启Centos

如果是单独修改了ip时,我们需要重启网卡

$ service network restart

安装hadoop配置

安装要求,使用普通用户安装hadoop,防止安装时的权限问题。

让普通用户具有sudo权限,先切换到root权限$ su # vim /etc/sudoers root ALL=(ALL) ALL 在后面加上一行 hadoop ALL=(ALL) ALL 如果root权限下还是不能修改`sudoers`文件,就为root赋予`sudoers`的写入权限 ` # chmod 640 /etc/sudoers` 然后在修改`sudoers`文件

将java和hadoop上传到CentOS桌面

java安装

创建java安装目录

$ sudo mkdir /usr/java

解压

$ sudo tar -zxvf jdk-7u65-linux-i586.tar.gz -C /usr/java/

$ cd /usr/java/ #进入文件夹下

$ mv jdk1.7.0_65/ jdk1.7 ##修改名字

将java添加到环境

$ sudo vim /etc/profile

export JAVA_HOME=/usr/java/jdk1.7 #在文件最后添加

export PATH=$PATH:$JAVA_HOME/bin

$ source /etc/profile #刷新配置

hadoop2.4.1 安装

将hadoop安装到/home/hadoop目录下

解压

$ tar -zxvf hadoop-2.4.1.tar.gz -C /home/hadoop/

修改hadoop配置

- hadoop-env.sh

$ sudo vim hadoop-env.sh

export JAVA_HOME=/usr/java/jdk1.7 #修改第27行

- core-site.xml

$ sudo vim core-site.xml

fs.defaultFS

hdfs://mastar:9000

hadoop.tmp.dir

/home/hadoop/hadoop2.4/tmp

- hdfs-site.xml

$ sudo vim hdfs-site.xml

dfs.replication

1

- mapred-site.xml

$ mv mapred-site.xml.template mapred-site.xml #修改名称去掉 .template

$ vim mapred-site.xml

mapreduce.framework.name

yarn

- yarn-site.xml

$ sudo vim yarn-site.xml

yarn.resourcemanager.hostname

master

yarn.nodemanager.aux-services

mapreduce_shuffle

将hadoop添加到环境变量

$ sudo vim /etc/profile

export JAVA_HOME=/usr/java/jdk1.7

export HADOOP_HOME=/home/hadoop/hadoop2.4

PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

$ source /etc/profile

格式化namenode

$ hdfs namenode -format

($ hadoop namenode -format) 两个命令都可以,执行一次就行

执行后查看倒数第五行

Exiting with status 1 则配置有问题

Exiting with status 0 格式化成功

启动hadoop

$ start-all.sh

注:每次开启hadoop后必须进行关闭,关闭命令

$ stop-all.sh

查看hadoop启动情况

$ jps

4978 SecondaryNameNode

5120 ResourceManager

4804 NameNode

5382 Jps

4803 ResourceManager

5512 DataNode

查看HDFS管理界面能否访问

http://192.168.8.10:50070

查看MR管理界面能否访问

http://192.168.8.10:8088

配置ssh免登陆

$ cd ~/.ssh

$ ssh-keygen -t rsa #四个回车生成rsa

执行ls命令查看文件,可以看到两个文件

id_rsa(私钥) id_rsa.pub(公钥)

将公钥拷贝到要免登陆的机器上

ssh-copy-id master

ssh-copy-id localhost