WAF学习之一——Nginx与反向代理

文章目录

- 反向代理

- 什么是反向代理

- 反向代理与正向代理

- 工作流程

- 优点

- Nginx模块

- 模块划分

- 模块处理

- nginx作为反向代理的使用

- 作内容服务器的替身

- 作为内容服务器的负载均衡器

- 实例

- 1)环境:

- 2)针对不同请求的负载均衡:

- 3)访问同一页面的负载均衡:

反向代理

https://www.cnblogs.com/loverwangshan/p/9927968.html

https://www.jianshu.com/p/6215e5d24553

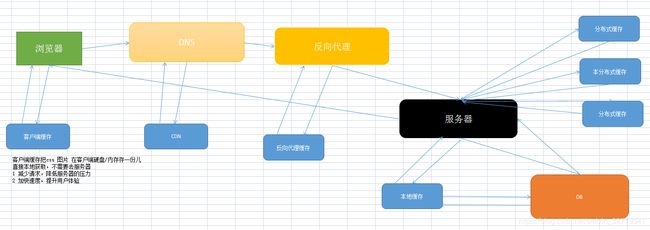

流程图如下:

什么是反向代理

-

反向代理是(Reverse Proxy)是以代理服务器的形式来接受来自Internet的请求,然后将请求转发给内部服务器;并从服务器得到响应返回给Internet的客户端,此时这个代理服务器对外表现和一个服务器是一样的

-

比如我想访问 http://www.test.com/readme,但www.test.com上并不存在readme页面,于是他是偷偷从另外一台服务器上取回来,然后作为自己的内容返回用户,但用户并不知情。这里所提到的 www.test.com 这个域名对应的服务器就设置了反向代理功能。

-

结论就是,反向代理服务器对于客户端而言它就像是原始服务器,并且客户端不需要进行任何特别的设置。客户端向反向代理的命名空间(name-space)中的内容发送普通请求,接着反向代理服务器将判断向何处(原始服务器)转交请求,并将获得的内容返回给客户端,就像这些内容原本就是它自己的一样。

反向代理与正向代理

-

正向代理(Forward Proxy)通常都被简称为代理,就是在用户无法正常访问外部资源,比方说受到GFW的影响无法访问twitter的时候,我们可以通过代理的方式,让用户绕过防火墙,从而连接到目标网络或者服务。

-

正向代理的工作原理就像一个跳板,比如:我访问不了google.com,但是我能访问一个代理服务器A,A能访问google.com,于是我先连上代理服务器A,告诉他我需要google.com的内容,A就去取回来,然后返回给我。从网站的角度,只在代理服务器来取内容的时候有一次记录,有时候并不知道是用户的请求,也隐藏了用户的资料,这取决于代理告不告诉网站。

-

结论就是,正向代理是一个位于客户端和原始服务器(origin server)之间的服务器。为了从原始服务器取得内容,客户端向代理发送一个请求并指定目标(原始服务器),然后代理向原始服务器转交请求并将获得的内容返回给客户端。

工作流程

-

用户通过域名发出访问Web服务器的请求,该域名被DNS服务器解析为反向代理服务器的IP地址;

-

反向代理服务器接受用户的请求;

-

反向代理服务器在本地缓存中查找请求的内容,找到后直接把内容发送给用户;

-

如果本地缓存里没有用户所请求的信息内容,反向代理服务器会代替用户向源服务器请求同样的信息内容,并把信息内容发给用户,如果信息内容是缓存的还会把它保存到缓存中。

优点

- 普通的代理只能代理内部网络对于外部Internet网络的访问,客户机需要制定服务器,将发送到web服务器的http请求发送到代理服务器上 . 且不支持外部网络对于内部网络的访问,因为内部网络对网部是不可见的.当一个代理服务器能够代理外部网络的主机,访问内部网络时,就称他为反向代理.此时代理服务器对外表现为一个Web服务器,外部网络就可以简单把它当作一个标准的Web服务器而不需要特定的配置。不同之处在于,这个服务器没有保存任何网页的真实数据,所有的静态网页或者CGI程序,都保存在内部的Web服务器上。因此对反向代理服务器的攻击并不会使得网页信息遭到破坏,这样就增强了Web服务器的安全性。

- 节约了有限的IP地址,企业内所有的网站共享一个在internet中注册的IP地址,这些服务器分配私有地址,采用虚拟主机的方式对外提供服务。

- 减少WEB服务器压力,提高响应速度:反向代理就是通常所说的web服务器加速,它是一种通过在繁忙的web服务器和外部网络之间增加一个高速的web缓冲服务器来降低实际的web服务器的负载的一种技术。反向代理是针对web服务器提高加速功能,作为代理缓存,它并不是针对浏览器用户,而针对一台或多台特定的web服务器,它可以代理外部网络对内部网络的访问请求。

反向代理服务器会强制将外部网络对要代理的服务器的访问经过它,这样反向代理服务器负责接收客户端的请求,然后到源服务器上获取内容,把内容返回给用户,并把内容保存到本地,以便日后再收到同样的信息请求时,它会把本地缓存里的内容直接发给用户,以减少后端web服务器的压力,提高响应速度。因此Nginx还具有缓存功能。 - 其他优点

(1)请求的统一控制,包括设置权限、过滤规则等;

(2)区分动态和静态可缓存内容;

(3)实现负载均衡,内部可以采用多台服务器来组成服务器集群,外部还是可以采用一个地址访问;

(4)解决Ajax跨域问题;

(5)作为真实服务器的缓冲,解决瞬间负载量大的问题;

Nginx模块

Nginx有五大优点:模块化、事件驱动、异步、非阻塞、多进程单线程。由内核和模块组成的,其中内核完成的工作比较简单,仅仅通过查找配置文件将客户端请求映射到一个location block,然后又将这个location block中所配置的每个指令将会启动不同的模块去完成相应的工作。

模块划分

从结构上分为核心模块,基础模块和第三方快

-

核心模块:HTTP模块、EVENT模块和MAIL模块

-

基础模块:HTTP Access模块、HTTP FastCGI模块、HTTP Proxy模块和HTTP Rewrite模块,

-

第三方模块:HTTP Upstream Request Hash模块、Notice模块和HTTP Access Key模块。也可自己添加,如配置Modsecurity模块

Nginx的模块从功能上分为如下四类:

-

Core(核心模块):构建nginx基础服务、管理其他模块。

-

Handlers(处理器模块):此类模块直接处理请求,并进行输出内容和修改headers信息等操作。

-

Filters (过滤器模块):此类模块主要对其他处理器模块输出的内容进行修改操作,最后由Nginx输出。

-

Proxies (代理类模块):此类模块是Nginx的HTTP Upstream之类的模块,这些模块主要与后端一些服务比如FastCGI等进行交互,实现服务代理和负载均衡等功能

Nginx的核心模块主要负责建立nginx服务模型、管理网络层和应用层协议、以及启动针对特定应用的一系列候选模块。其他模块负责分配给web服务器的实际工作:

-

当Nginx发送文件或者转发请求到其他服务器,由Handlers(处理模块)或Proxies(代理类模块)提供服务;

-

当需要Nginx把输出压缩或者在服务端加一些东西,由Filters(过滤模块)提供服务。

模块处理

-

(1)当服务器启动,

每个handlers(处理模块)都有机会映射到配置文件中定义的特定位置(location);如果有多个handlers(处理模块)映射到特定位置时,只有一个会“赢”(说明配置文件有冲突项,应该避免发生)。

处理模块以三种形式返回:- OK

- ERROR

- 或者放弃处理这个请求而让默认处理模块来处理(主要是用来处理一些静态文件,事实上如果是位置正确而真实的静态文件,默认的处理模块会抢先处理)。

-

(2)

如果handlers(处理模块)把请求反向代理到后端的服务器,就变成另外一类的模块:load-balancers(负载均衡模块)。负载均衡模块的配置中有一组后端服务器,当一个HTTP请求过来时,它决定哪台服务器应当获得这个请求。

Nginx的负载均衡模块采用两种方法:- 轮转法,它处理请求就像纸牌游戏一样从头到尾分发;

- IP哈希法,在众多请求的情况下,它确保来自同一个IP的请求会分发到相同的后端服务器。

-

(3)

如果handlers(处理模块)没有产生错误,filters(过滤模块)将被调用。多个filters(过滤模块)能映射到每个位置,所以(比如)每个请求都可以被压缩成块。它们的执行顺序在编译时决定。-

filters(过滤模块)是经典的“接力链表(CHAIN OF RESPONSIBILITY)”模型:一个filters(过滤模块)被调用,完成其工作,然后调用下一个filters(过滤模块),直到最后一个filters(过滤模块)。-

过滤模块链的特别之处在于:

-

每个filters(过滤模块)不会等上一个filters(过滤模块)全部完成;

-

它能把前一个过滤模块的输出作为其处理内容;有点像Unix中的流水线;

-

-

-

过滤模块能以buffer(缓冲区)为单位进行操作,这些buffer一般都是一页(4K)大小,当然你也可以在nginx.conf文件中进行配置。这意味着,比如,模块可以压缩来自后端服务器的响应,然后像流一样的到达客户端,直到整个响应发送完成。 -

总之,过滤模块链以流水线的方式高效率地向客户端发送响应信息。

-

-

(4) 所以总结下上面的内容,一个典型的HTTP处理周期是这样的:

客户端发送HTTP请求 –>

Nginx基于配置文件中的位置选择一个合适的处理模块 ->

(如果有)负载均衡模块选择一台后端服务器 –>

处理模块进行处理并把输出缓冲放到第一个过滤模块上 –>

第一个过滤模块处理后输出给第二个过滤模块 –>

然后第二个过滤模块又到第三个 –>

依此类推 –> 最后把响应发给客户端。

Nginx本身做的工作实际很少,当它接到一个HTTP请求时,它仅仅是通过查找配置文件将此次请求映射到一个location block,而此location中所配置的各个指令则会启动不同的模块去完成工作,因此模块可以看做Nginx真正的劳动工作者。通常一个location中的指令会涉及一个handler模块和多个filter模块(当然,多个location可以复用同一个模块)。handler模块负责处理请求,完成响应内容的生成,而filter模块对响应内容进行处理。

以上内容都是来自如下链接,写的太清晰了,所以全复制了…这篇文章还有很多没看完,先梳理这些作为入门…

https://www.jianshu.com/p/6215e5d24553

nginx作为反向代理的使用

反向代理服务器通常有两种模型,它可以作为内容服务器的替身,也可以作为内容服务器集群的负载均衡器。

作内容服务器的替身

- 如果您的内容服务器具有必须保持安全的敏感信息,如信用卡号数据库,可在防火墙外部设置一个代理服务器作为内容服务器的替身。当外部客户机尝试访问内容服务器时,会将其送到代理服务器。实际内容位于内容服务器上,在防火墙内部受到安全保护。代理服务器位于防火墙外部,在客户机看来就像是内容服务器。

- 当客户机向站点提出请求时,请求将转到代理服务器。然后,代理服务器通过防火墙中的特定通路,将客户机的请求发送到内容服务器。内容服务器再通过该通道将结果回传给代理服务器。代理服务器将检索到的信息发送给客户机,好像代理服务器就是实际的内容服务器。如果内容服务器返回错误消息,代理服务器会先行截取该消息并更改标头中列出的任何 URL,然后再将消息发送给客户机。如此可防止外部客户机获取内部内容服务器的重定向 URL。

- 这样,代理服务器就在安全数据库和可能的恶意攻击之间提供了又一道屏障。与有权访问整个数据库的情况相对比,就算是侥幸攻击成功,作恶者充其量也仅限于访问单个事务中所涉及的信息。未经授权的用户无法访问到真正的内容服务器,因为防火墙通路只允许代理服务器有权进行访问。

作为内容服务器的负载均衡器

- 可以在一个组织内使用多个代理服务器来平衡各 Web 服务器间的网络负载。在此模型中,可以利用代理服务器的高速缓存特性,创建一个用于负载平衡的服务器池。此时,代理服务器可以位于防火墙的任意一侧。如果 Web 服务器每天都会接收大量的请求,则可以使用代理服务器分担 Web 服务器的负载并提高网络访问效率。

- 对于客户机发往真正服务器的请求,代理服务器起着中间调停者的作用。代理服务器会将所请求的文档存入高速缓存。如果有不止一个代理服务器,DNS 可以采用“循环复用法”选择其 IP 地址,随机地为请求选择路由。客户机每次都使用同一个 URL,但请求所采取的路由每次都可能经过不同的代理服务器。

- 可以使用多个代理服务器来处理对一个高用量内容服务器的请求,这样做的好处是内容服务器可以处理更高的负载,并且比其独自工作时更有效率。在初始启动期间,代理服务器首次从内容服务器检索文档,此后,对内容服务器的请求数会大大下降。

实例

因为nginx在处理并发方面的优势,现在这个应用非常常见。当然了Apache的 mod_proxy和mod_cache结合使用也可以实现对多台app server的反向代理和负载均衡,但是在并发处理方面apache还是没有nginx擅长。

1)环境:

- 我们本地是Windows系统,然后使用VirutalBox安装一个虚拟的Linux系统。在本地的Windows系统上分别安装nginx(侦听 8080端口)和apache(侦听80端口)。在虚拟的Linux系统上安装apache(侦听80端口)。这样我们相当于拥有了1台nginx在前端 作为反向代理服务器;后面有2台apache作为应用程序服务器(可以看作是小型的server cluster。 );

- nginx用来作为反向代理服务器,放置到两台apache之前,作为用户访问的入口;nginx仅仅处理静态页面,动态的页面(php请求)统统都交付给后台的两台apache来处理。也就是说,可以把我们网站的静态页面或者文件放置到nginx的目录下;动态的页面和数据库访问都保留到后台的apache服务器上。

- 如下介绍两种方法实现server cluster的负载均衡。

- 我们假设前端nginx(为127.0.0.1:80)仅仅包含一个静态页面index.html;后台的两个apache服务器(分别为localhost:80和158.37.70.143:80),一台根目录放置phpMyAdmin文件夹 和test.php(里面测试代码为

print "server1";),另一台根目录仅仅放置一个test.php(里面测试代码为print "server2";)。

2)针对不同请求的负载均衡:

- 在最简单地构建反向代理的时候(nginx仅仅处理静态不处理动态内容,动态内容交给后台的apache server来处理),我们具体的设置为:在nginx.conf中修改:

location ~ /.php$ { proxy_pass 158.37.70.143:80 ; }- 这样当客户端访问

localhost:8080/index.html的时候,前端的nginx会自动进行响应; - 当用户访问

localhost:8080/test.php的时候(这个时候nginx目录下根本就没有该文件),但是通过上面的设置location ~ /.php$(表示正则表达式匹配以.php结尾的文件,详情参看location是如何定义和匹配的http://wiki.nginx.org /NginxHttpCoreModule) ,nginx服务器会自动pass给158.37.70.143的apache服务器了。该服务器下的test.php就会被自动解析,然后将html的 结果页面返回给nginx,然后nginx进行显示(如果nginx使用memcached模块或者squid还可以支持缓存),输出结果为打印 server2。

- 这样当客户端访问

如上是最为简单的使用nginx做为反向代理服务器的例子;

- 我们现在对如上例子进行扩展,使其支持如上的两台服务器。

- 我们设置nginx.conf的server模块部分,将对应部分修改为:

location ^~ /phpMyAdmin/ { proxy_pass 127.0.0.1:80 ; }location ~ /.php$ { proxy_pass 158.37.70.143:80 ; }- 上面第一个部分

location ^~ /phpMyAdmin/,表示不使用正则表达式匹配(^~),而是直接匹配,也就是如果客户端访问的URL是以http://localhost:8080/phpMyAdmin/开头的话(本地的nginx目录下根本没有phpMyAdmin目录),nginx会自动pass到127.0.0.1:80的Apache服务器,该服务器对phpMyAdmin目录下的页面进行解析,然后将结果发送给nginx,后者显示;

- 上面第一个部分

- 如果客户端访问URL是

http://localhost/test.php的话,则会被pass到158.37.70.143:80的apache进行处理。 - 因此综上,我们实现了针对不同请求的负载均衡。

- 如果用户访问静态页面

index.html,最前端的nginx直接进行响应; - 如果用户访问

test.php页面的话,158.37.70.143:80的Apache进行响应; - 如果用户访问目录

phpMyAdmin下的页面的话,127.0.0.1:80的Apache进行响应;

- 如果用户访问静态页面

3)访问同一页面的负载均衡:

-

即用户访问

http://localhost:8080/test.php这个同一页面的时候,我们实现两台服务器的负载均衡(实际情况中,这两个服务器上的数据要求同步一致,这里我们分别定义了打印server1和server2是为了进行辨认区别)。 -

现在我们的情况是在windows下nginx是localhost侦听8080端口;

- 两台apache,一台是127.0.0.1:80(包含test.php页面但是打印server1),另一台是虚拟机的158.37.70.143:80(包含test.php页面但是打印server2)。

-

因此重新配置nginx.conf为:

- 首先在nginx的配置文件nginx.conf的http模块中添加,服务器集群server cluster(我们这里是两台)的定义:

upstream myCluster { server 127.0.0.1:80 ; server 158.37.70.143:80 ; }表示这个server cluster包含2台服务器>然后在server模块中定义,负载均衡:location ~ /.php$ { proxy_pass http://myCluster; #这里的名字和上面的cluster的名字相同proxy_redirect off; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; }这样的话,如果访问http://localhost:8080/test.php页面的话,nginx目录下根本没有该文件,但是它会自动将其pass到myCluster定义的服务区机群中,分别由127.0.0.1:80;或者158.37.70.143:80;来做处理。上面在定义upstream的时候每个server之后没有定义权重,表示两者均衡;如果希望某个更多响应 的话例如:upstream myCluster { server 127.0.0.1:80 weight=5;server 158.37.70.143:80 ; }这样表示5/6的几率访问第一个server,1/6访问第二个。另外还可以定义max_fails和fail_timeout等参数。

- 首先在nginx的配置文件nginx.conf的http模块中添加,服务器集群server cluster(我们这里是两台)的定义:

-

综上,我们使用nginx的反向代理服务器reverse proxy server的功能,将其布置到多台apache server的前端。

-

nginx仅仅用来处理静态页面响应和动态请求的代理pass,后台的apache server作为app server来对前台pass过来的动态页面进行处理并返回给nginx。

-

通过以上的架构,我们可以实现nginx和多台apache构成的机群cluster的负载均衡。两种均衡:

- 可以在nginx中定义访问不同的内容,代理到不同的后台server;如上例子中的访问phpMyAdmin目录代理到第一台server上;访问test.php代理到第二台server上;

- 可以在nginx中定义访问同一页面,均衡(当然如果服务器性能不同可以定义权重来均衡)地代理到不同的后台server上。如上的例子访问test.php页面,会均衡地代理到server1或者server2上。

实际应用中,server1和server2上分别保留相同的app程序和数据,需要考虑两者的数据同步。