3. pycharm配置pyspark

pycharm配置运行pyspark

1. 安装pycharm

2. 配置

3. 测试

1. 安装pycharm

官网下载pycharm:https://www.jetbrains.com/pycharm/

下载 pycharm-community-2018.3.2.tar.gz

解压:可以bash,也可以右键归档管理器提取

此时进入bin目录 ./pycharm.sh 就可以运行了

也可配置为双击运行:(没必要,后面直接创建桌面快捷方式)

打开文件夹,左上角有“文件”,文件—》首选项—》行为—》可执行文本—》运行

2. 配置

2.1 桌面快捷方式

右下角Configer——》create desktop entry

如果已经进去了不在这个节目了,就点击菜单栏的tools——》create desktop entry

2.2 配置anaconda python环境

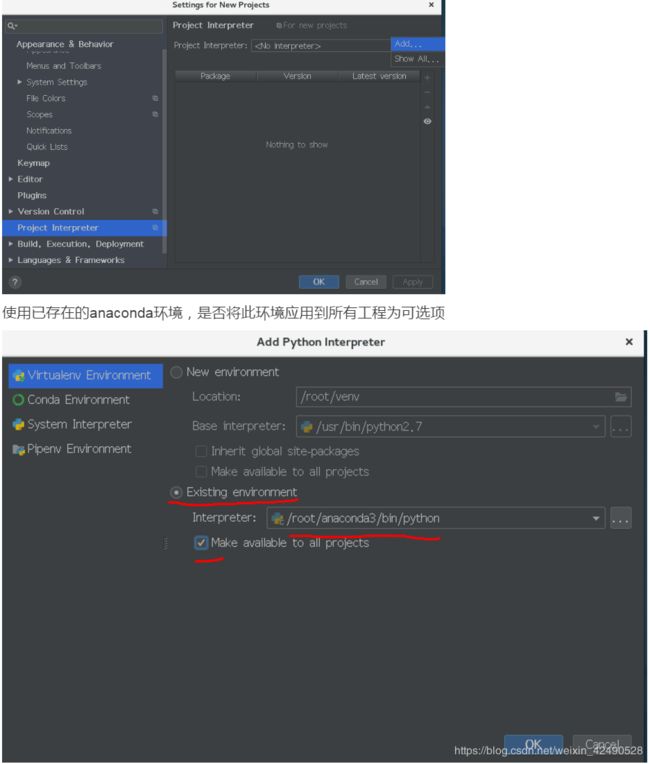

设置 settings—》peoject interpreter(解释器)—》右上角的设置图标—》Add

点击ok,python环境配置完成。

2.3 配置spark路径和spark的python链接库

上一节配置的是anaconda的python链接库,当我们跑pyspark程序时,

还要引用spark的python链接库,所以还需要配置一下

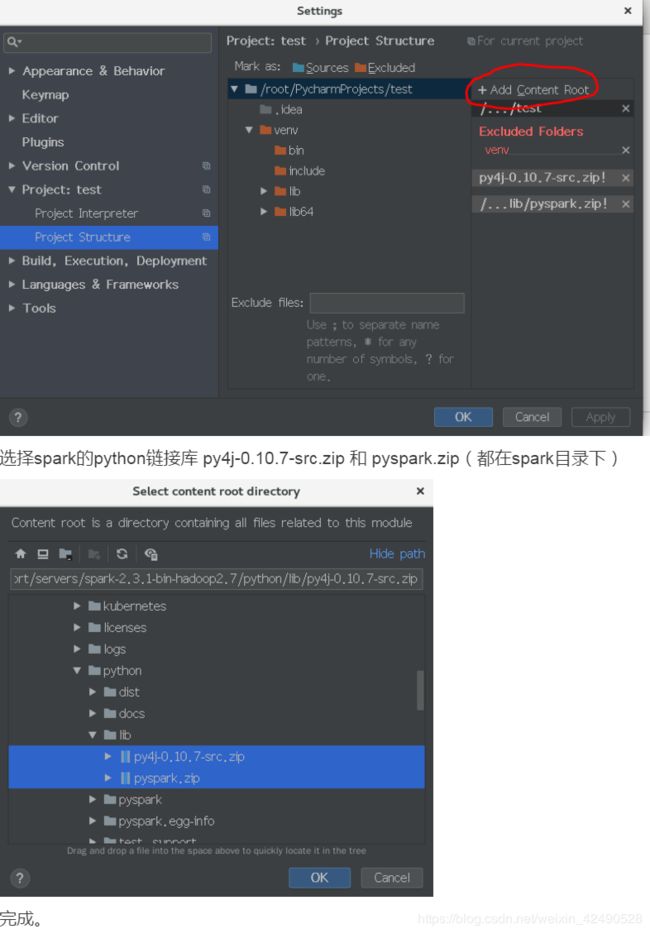

spark的python链接库:py4j-0.10.7-src.zip 和 pyspark.zip

这两个文件都在Spark中的python文件夹下,/spark/python/lib

因为是跑程序时需要spark路径和这两个spark的python库,

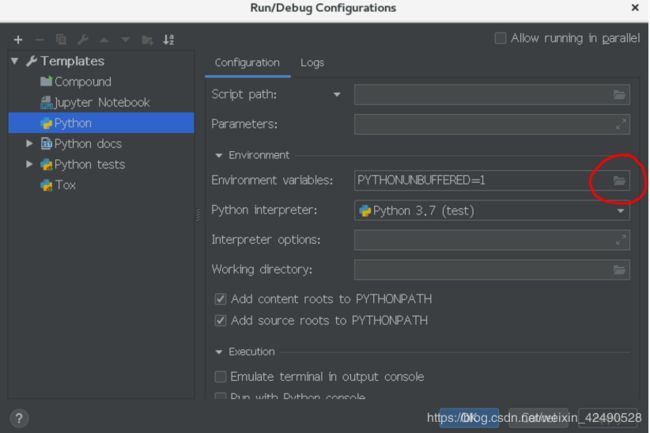

所以我们新建一个项目test,配置Run:

(1)spark路径

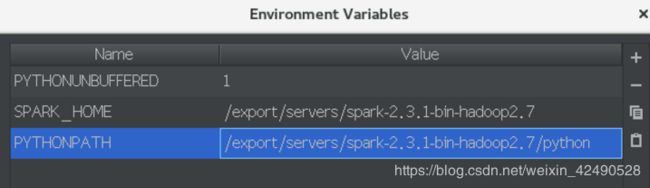

Run ->Edit Configurations ->Templates ->Python ->Environment ->Environment variables

点击图示位置,添加SPARK_HOME目录与PYTHONPATH目录

SPARK_HOME是spark的路径:/export/servers/spark-2.3.1-bin-hadoop2.7

PYTHONPATH是spark下python的路径:/export/servers/spark-2.3.1-bin-hadoop2.7/python

(2)spark的python链接库

setting(在file中)->project Structure ->Add Content Root

3. 测试

在此项目下新建python文件,输入

from pyspark import SparkContext

无红线,不报错。

直接在pycharm中运行pyspark程序

见案例:wordcount(pycharm)