深度卷积网络原理与模型介绍

深度学习计算机视觉从入门到精通——深度卷积网络原理与模型介绍

来自数据堂人工智能实验室的分享

数据实验室:https://www.datatang.com/laboratory?dw=news

一、卷积神经网络原理

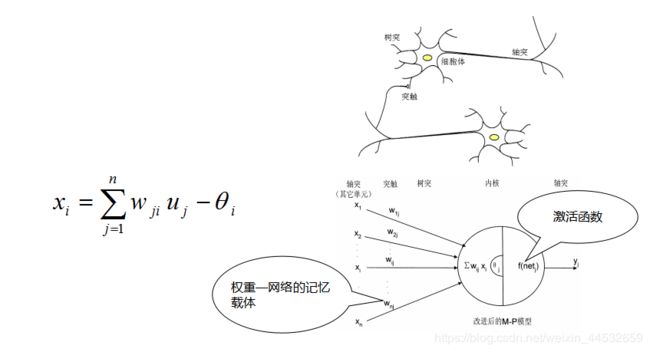

1.1神经网络最基本单元—神经元

1943年心理学家McCulloch和数学家W.Pitts在分析总结神经元基本特性的基础上首先提出的M-P模型

美国学者Rosenblatt 于1958年提出来的感知器(Perceptron)

Rumelhart,McClelland于1985年提出了BP网络的误差反向后传BP(Back Propagation)学习算法

1985年,Powell提出了多变量插值的径向基函数(Radical Basis Function,RBF)方法 。1988年, Moody和Darken提出了一种神经网络结构,即RBF神经网络

1976年,美国Boston大学学者G.A.Carpenter提出自适应共振理论(Adaptive Resonance Theory,缩写为ART)

1982年,美国加州工学院J.Hopfield提出了可用作联想存储器和优化计算的反馈网络,这个网络称为Hopfield神经网络

从某种意义上来说,人工智能起源于人类试图用机器模仿人类大脑。

激活函数作用—数学上的映射

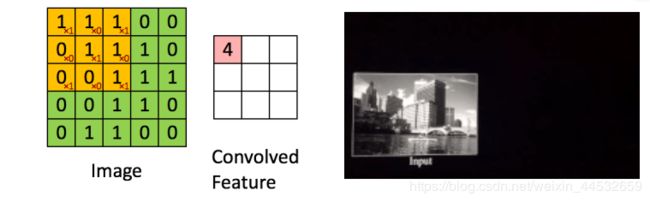

1.2卷积操作

现代计算机常用的离散卷积是两矩阵对应元素相乘求和

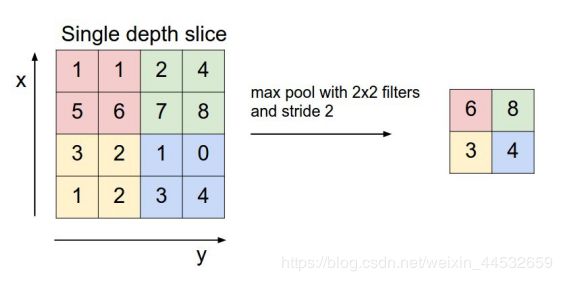

1.3池化层

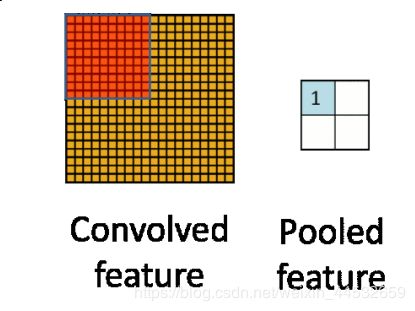

池化层的主要目的是通过降采样的方式,在不影响图像质量的情况下,压缩图片,减少参数。

池化过程动画演示

1.4全连接层

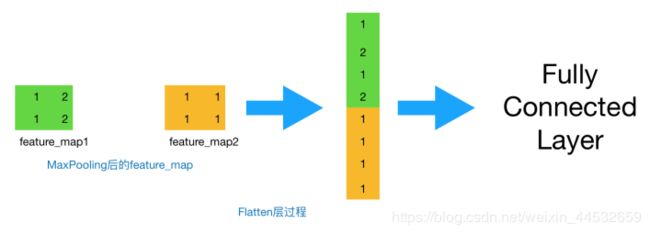

做完Max Pooling后,我们就会把这些数据“拍平”,丢到Flatten层,然后把Flatten层的output放到full connected Layer里,采用softmax对其进行分类。

二、经典卷积网络

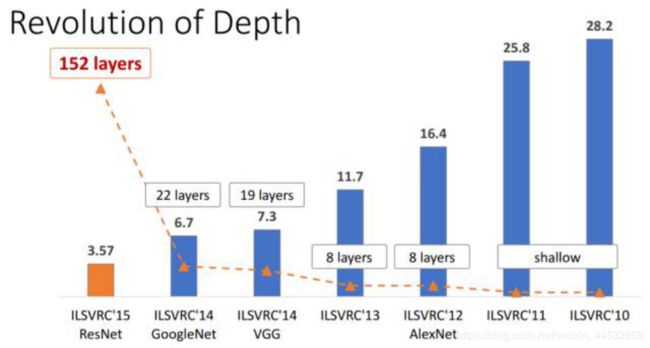

2.1深度学习网络结构演变

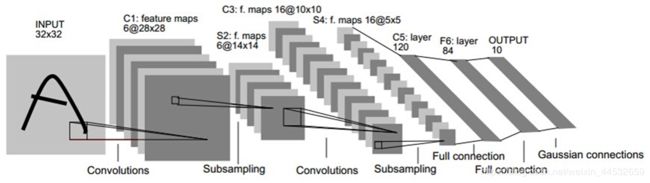

2.2LeNet

Yann LeCun 是美国工程院院士、Facebook人工智能研究院院长、纽约大学Sliver教授,同时还兼职于科学数据中心,数学科学交流学院,神经科学中心,以及电子工程计算机系。他于2003年加入纽约大学,之后还在普林斯顿的NEC研究院短暂任职。在2012年,他创建了纽约大学数据科学中心,并担任主任。2013年底,他被任命为Facebook人工智能研究总监, 并继续在纽约大学做兼职教授。2015-2016年,他在巴黎法兰西工学院做客座教授。

Lecun创立的卷积网络模型,被广泛地应用于计算机视觉和语音识别应用里,也因此他被称为卷积网络之父,是公认的世界人工智能三巨头之一。

LeCun创建了International Conference on Learning Representations机器学习展示国际大会,并且与Yoshua Bengio共同担任主席,同时兼任其它几个大会的组委会委员。他还与人一起担任着加拿大机器与大脑程序学习深度研究所的主席,同时担任IPAM and ICERM的董事会委员。他还是2014年IEEE(电气与电子工程师协会)神经网络先驱奖获奖者,2015年IEEE PAMI杰出研究员奖获奖者。

五层最简单的网络结构,深度学习网络的鼻祖。

2.3AlexNet

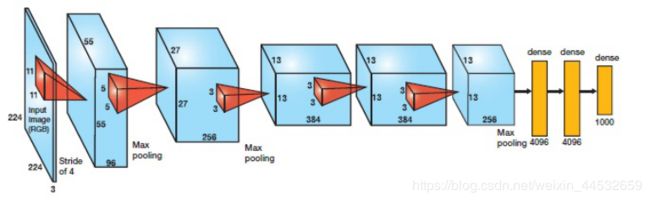

AlexNet 可以说是具有历史意义的一个网络结构,可以说在AlexNet之前,深度学习已经沉寂了很久。历史的转折在2012年到来,AlexNet 在当年的ImageNet图像分类竞赛中,top-5错误率比上一年的冠军下降了十个百分点,而且远远超过当年的第二名。

AlexNet特点

非线性激活函数:ReLU

防止过拟合的方法:Dropout,Data augmentation

大数据训练:百万级ImageNet图像数据

其他:GPU实现,LRN归一化层的使用

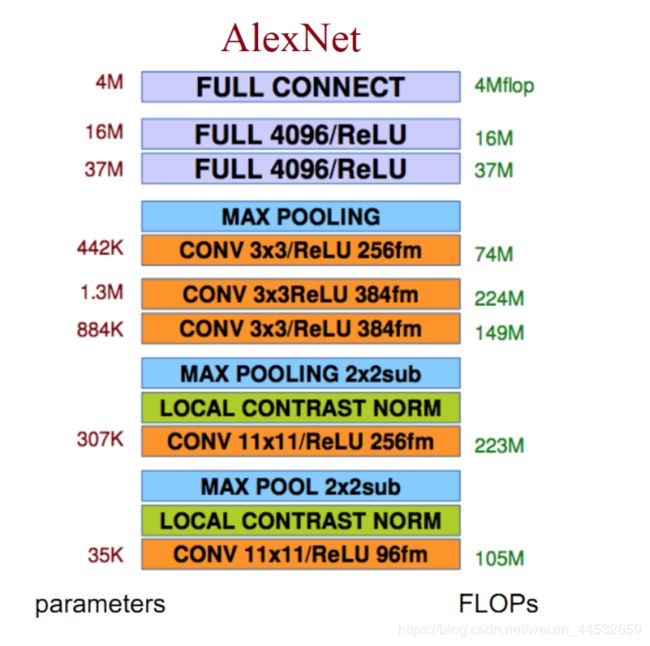

由下向上,全连接层耗费了大多数的内存。

AlexNet由Alex Krizhevsky于2012年提出,夺得2012年ILSVRC比赛的冠军,top5预测的错误率为16.4%。AlexNet采用8层的神经网络,5个卷积层和3个全连接层(3个卷积层后面加了最大池化层),包含6亿3000万个链接,6000万个 参数和65万个神经元。

2.4VGGNet

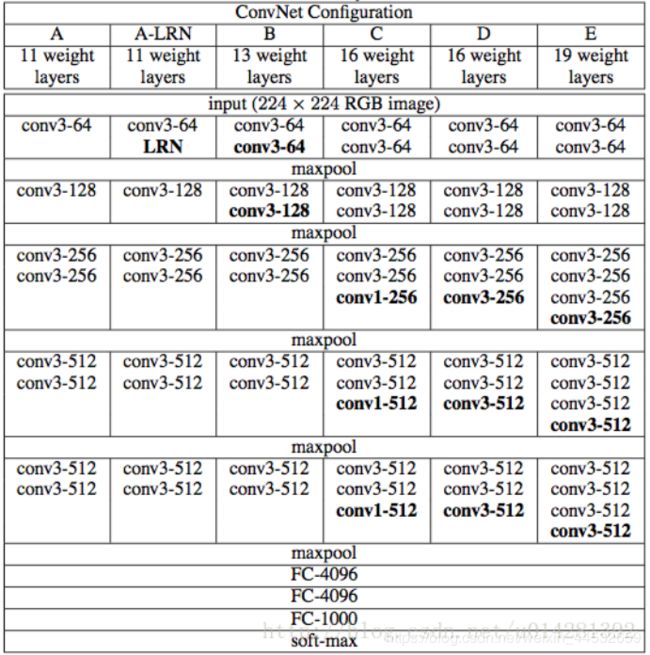

VGG网络是在AlexNet网络的基础上发展而来的,其主要贡献在于使用非常小的3*3的卷积核进行网络设计,并且将网络深度增加到16-19层。在2014年ImageNet比赛中,获得了定位第1,分类第2的好成绩,网络具有很好的泛化能力。

2014年,牛津大学计算机视觉组(Visual Geometry Group)和Google DeepMind公司的研究员一起研发出了新的深度卷积神经网络:VGGNet,并取得了ILSVRC2014比赛分类项目的第二名(第一名是GoogLeNet,也是同年提出的)和定位项目的第一名。

最大特点:只使用3x3 卷积层和2x2 pooling层从头到尾堆叠。

VGGNet探索了卷积神经网络的深度与其性能之间的关系,成功地构筑了16~19层深的卷积神经网络,证明了增加网络的深度能够在一定程度上影响网络最终的性能,使错误率大幅下降,同时拓展性又很强,迁移到其它图片数据上的泛化性也非常好。到目前为止,VGG仍然被用来提取图像特征。

VGGNet可以看成是加深版本的AlexNet,都是由卷积层、全连接层两大部分构成。

2.5ResNet

ResNet在2015年被提出,在ImageNet比赛classification任务上获得第一名,因为它“简单与实用”并存,之后很多方法都建立在ResNet50或者ResNet101的基础上完成的,检测,分割,识别等领域都纷纷使用ResNet,Alpha zero也使用了ResNet。

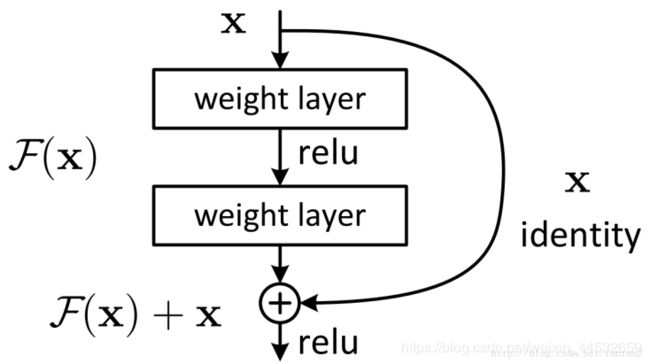

残差网络更容易优化,并且能够通过增加相当的深度来提高准确率。

核心是解决了增加深度带来的副作用(退化问题),这样能够通过单纯地增加网络深度,来提高网络性能。

CNN能够提取low/mid/high-level的特征,网络的层数越多,意味着能够提取到不同level的特征越丰富。并且,越深的网络提取的特征越抽象,越具有语义信息。

ResNet由微软研究院的Kaiming He等四名华人提出ILSVRC2015比赛中取得冠军,同时参数量比VGGNet低。ResNet的结构可以极快的加速神经网络的训练,模型的准确率也有比较大的提升。

ResNet的主要思想是在网络中增加了Highway Network的思想。此前的网络结构是性能输入做一个非线性变换,而Highway Network则允许保留之前网络层的一定比例的输出,即原始输入信息直接传到后面的层中。

来自数据堂人工智能实验室的分享

数据实验室:https://www.datatang.com/laboratory?dw=news