水下图像去雾算法C++实现

图像去雾之何凯明暗通道先验去雾算法原理及自动色阶算法c++代码实现

何凯明博士,2007年清华大学毕业,2011年香港中文大学博士毕业,可谓是功力深厚,感叹于国内一些所谓博士的水平,何这样的博士才可以真正叫做

Doctor。

关于何博士的一些资料和论文,大家可以访问这里:http://research.microsoft.com/en-us/um/people/kahe/

本文主要上是对《Single Image Haze Removal Using Dark Channel Prior》的翻译、整理、及部分解释、代码实现。如果您的英文水平好,建议看原

文可能来的更爽些。

一、论文思想的简单描述

首先看看暗通道先验是什么:

在绝大多数非天空的局部区域里,某一些像素总会有至少一个颜色通道具有很低的值。换言之,该区域光强度的最小值是个很小的数。

我们给暗通道一个数学定义,对于任意的输入图像J,其暗通道可以用下式表达:

![]()

式中Jc表示彩色图像的每个通道 ,Ω(x)表示以像素X为中心的一个窗口。

式(5)的意义用代码表达也很简单,首先求出每个像素RGB分量中的最小值,存入一副和原始图像大小相同的灰度图中,然后再对这幅灰度图进行最小值

滤波,滤波的半径由窗口大小决定,一般有WindowSize = 2 * Radius + 1;

暗通道先验的理论指出:

![]()

实际生活中造成暗原色中低通道值主要有三个因素:a)汽车、建筑物和城市中玻璃窗户的阴影,或者是树叶、树与岩石等自然景观的投影;b)色彩鲜艳的物

体或表面,在RGB的三个通道中有些通道的值很低(比如绿色的草地/树/植物,红色或黄色的花朵/叶子,或者蓝色的水面);c)颜色较暗的物体或者表面,

例如灰暗色的树干和石头。总之,自然景物中到处都是阴影或者彩色,这些景物的图像的暗原色总是很灰暗的。

在作者的论文中,统计了5000多副图像的特征,也都基本符合这个先验,因此,我们可以认为其实一条定理。

有了这个先验,接着就需要进行一些数学方面的推导来最终解决问题。

首先,在计算机视觉和计算机图形中,下述方程所描述的雾图形成模型被广泛使用:

![]()

其中,I(X)就是我们现在已经有的图像(待去雾的图像),J(x)是我们要恢复的无雾的图像,A是全球大气光成分, t(x)为透射率。现在的已知条件就是

I(X),要求目标值J(x),显然,这是个有无数解的方程,因此,就需要一些先验了。

将式(1)稍作处理,变形为下式:

![]()

如上所述,上标C表示R/G/B三个通道的意思。

首先假设在每一个窗口内透射率t(x)为常数,定义他为![]() ,并且A值已经给定,然后对式(7)两边求两次最小值运算,得到下式:

,并且A值已经给定,然后对式(7)两边求两次最小值运算,得到下式:

![]()

上式中,J是待求的无雾的图像,根据前述的暗原色先验理论有:

![]()

因此,可推导出:

![]()

把式(10)带入式(8)中,得到:

![]()

下面我给出自动色阶算法,暗通道去雾算法到处都是代码了

#include

#include

#include

#include

#include

#include

using namespace std;

using namespace cv;

Mat autolevel(Mat matface,double dlowcut,double dhighcut)

{

uchar allmap[256*3] = {0};

//double dlowcut = 0.5;

//double dhighcut = 0.5;

long T_1 = clock();

vector rgb_planes;

split(matface,rgb_planes);

Mat HistBlue,HistGreen,HistRed;

int histSize = 256;

float range[] = { 0, 255 } ;

const float* histRange = { range };

bool uniform = true; bool accumulate = false;

calcHist( &rgb_planes[0], 1, 0, Mat(), HistRed, 1,&histSize, &histRange, uniform, accumulate );

calcHist( &rgb_planes[1], 1, 0, Mat(), HistGreen, 1, &histSize, &histRange, uniform, accumulate );

calcHist( &rgb_planes[2], 1, 0, Mat(), HistBlue, 1, &histSize, &histRange, uniform, accumulate );

printf("\n hist time %f ms.\n",(double)(clock() - T_1));

int PixelAmount = matface.rows*matface.cols;

//printf("%d\n",PixelAmount);

float isum = 0;

// blue

long T_2 = clock();

int iminblue=0;int imaxblue=0;

for (int y = 0;y<256;y++)

{

isum= isum + HistBlue.at(y);

//printf("%d\n",(int)HistBlue.at(y));

//isum= isum+HistBlue[y];

if (isum>=PixelAmount*dlowcut*0.01)

{

iminblue = y;

break;

}

}

//printf("%d\n",iminblue);

isum = 0;

for (int y=255;y>=0;y--)

{

isum=isum + HistBlue.at(y);

//isum=isum+HistBlue[y];

if (isum>=PixelAmount*dhighcut*0.01)

{

imaxblue=y;

break;

}

}

isum=0;

int iminred=0;int imaxred=0;

for (int y = 0;y<256;y++)

{

isum= isum+HistRed.at(y);

//isum= isum+HistRed[y];

if (isum>=PixelAmount*dlowcut*0.01)

{

iminred = y;

break;

}

}

//printf("%d\n",iminred );

isum = 0;

for (int y=255;y>=0;y--)

{

isum=isum+HistRed.at(y);

//isum=isum+HistRed[y];

if (isum>=PixelAmount*dhighcut*0.01)

{

imaxred=y;

break;

}

}

//printf("%d\n",imaxred);

//green

isum=0;

int imingreen=0;int imaxgreen=0;

for (int y = 0;y<256;y++)

{

isum= isum+HistGreen.at(y);

//isum= isum+HistGreen[y];

if (isum>=PixelAmount*dlowcut*0.01)

{

imingreen = y;

break;

}

}

//printf("%d\n",imingreen);

isum = 0;

for (int y=255;y>=0;y--)

{

isum=isum+HistGreen.at(y);

//isum=isum+HistGreen[y];

if (isum>=PixelAmount*dhighcut*0.01)

{

imaxgreen=y;

break;

}

}

printf("\n cut time %f ms.\n",(double)(clock() - T_2));

long T_3 = clock();

#pragma omp parallel for

for (int y=0;y<256;y++)

{

if (y<=iminblue)

{

allmap[y*3+2]=0;

}

else

{

if (y>imaxblue)

{

allmap[y*3+2]=255;

}

else

{

float ftmp = (float)(y-iminblue)/(imaxblue-iminblue);

allmap[y*3+2]=(uchar)(ftmp*255);

}

}

}

//red

#pragma omp parallel for

for (int y=0;y<256;y++)

{

if (y<=iminred)

{

allmap[y*3]=0;

}

else

{

if (y>imaxred)

{

allmap[y*3]=255;

}

else

{

float ftmp = (float)(y-iminred)/(imaxred-iminred);

allmap[y*3]=(uchar)(ftmp*255);

}

}

}

//green

#pragma omp parallel for

for (int y=0;y<256;y++)

{

if (y<=imingreen)

{

allmap[y*3+1]=0;

}

else

{

if (y>imaxgreen)

{

allmap[y*3+1]=255;

}

else

{

float ftmp = (float)(y-imingreen)/(imaxgreen-imingreen);

allmap[y*3+1]=(uchar)(ftmp*255);

}

}

}

printf("\n map time %f ms.\n",(double)(clock() - T_3));

long T_4 = clock();

Mat lut(1,256,CV_8UC3,allmap);

LUT(matface,lut,matface);

printf("\n values time %f ms.\n",(double)(clock() - T_4));

return matface;

}

int main()

{

bool flag;

VideoCapture cap("test.avi"); //打开摄像头

// 如果要打开本地视频采用 VideoCapture cap("***.avi");

// if(!cap.isOpened()) return -1; //检测一下摄像头是否打开

Mat frame;

Mat result;

// Mat result2;

flag=true;

while(flag){

cap>>frame;

cv::resize(frame, result, cv::Size(512, 512), (0, 0), (0, 0), cv::INTER_LINEAR);

cv::resize(frame, frame, cv::Size(512, 512), (0, 0), (0, 0), cv::INTER_LINEAR);

// cv::resize(frame, result2, cv::Size(512, 512), (0, 0), (0, 0), cv::INTER_LINEAR);

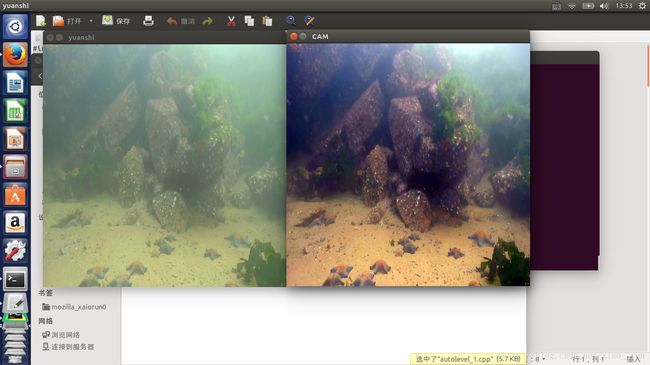

imshow("yuanshi",frame);

result=autolevel(result,0.5,0.5) ;

// result2=autolevel(result,1,0.5) ;

//namedWindow("xiaorun Opencv CAM",CV_WINDOW_AUTOSIZE) ; //读取当前帧

// 此处可添加图像处理算法,对图像进行处理,当然了,我们可以不做任何操作,只打开一下摄像头

imshow("CAM", result); //显示一下

// imshow("CAM2", result2); //显示一下

if(waitKey(20) >=0) break; // 等待按键,跳出循环

}

}

/*int main()

{

Mat I = imread("14.jpg");

long T_1 = clock();

Mat dehaze = autolevel(I,0.5,0.5);

printf("\nTotal Time: %f ms.\n", (double)(clock() - T_1));

namedWindow("dehaze",WINDOW_NORMAL);

imshow("dehaze",dehaze);

imwrite("dehaze.jpg",dehaze);

waitKey(0);

destroyAllWindows();

return 0;

}*/