光流估计网络调研

![]()

本文转载自知乎 Face++ IC组 专栏,已获作者hzwer授权转载。

https://zhuanlan.zhihu.com/p/151741828

光流,定义为视频图像中的同一对象移动到下一帧的移动量。移动可能是由相机移动或者物体移动引起的。光流估计通常分为稀疏光流估计和稠密光流估计。稀疏光流估计是指在图像中选取了一些特征点进行光流估计和跟踪,而稠密光流估计则是要描述图像中每一个像素点的光流。

光流可视化示例:

图片来自 https://github.com/PharrellWANG/optical-flow-visualization

以下先通过介绍传统 Lucas-Kanade 算法引入光流估计的重要假设,接着介绍了三个系列的稠密光流估计神经网络。

Lucas-Kanade 算法

稀疏光流的经典算法是 Lucas-Kanade 算法。这个算法对光流进行了两个重要假设,这两个假设之后被大多数光流算法采用。

亮度不变假设:因为环境光通常比较恒定,所以假设两帧图像的同一物体亮度不变。在 $t$ 时刻,位于 位置的物体,在经过了 时间后位于 位置,则根据亮度不变假设,有:

即

得 ,其中 是已知的。

邻域光流相近假设:在一个图像的小邻域内的像素点的光流一致,本质上是假设了图像的邻域都是同一个物体的表面。

如果我们选取了某个邻域的 n 个点,有 ,该式可由最小二乘法求解。为了避免多解(孔径问题),通常通过角点检测算法找出亮度变化明显的角点。

Flownet 系列光流估计网络

A. Dosovitskiy 等人 2015 年提出的 Flownet 是最早使用深度学习来估计光流的算法。

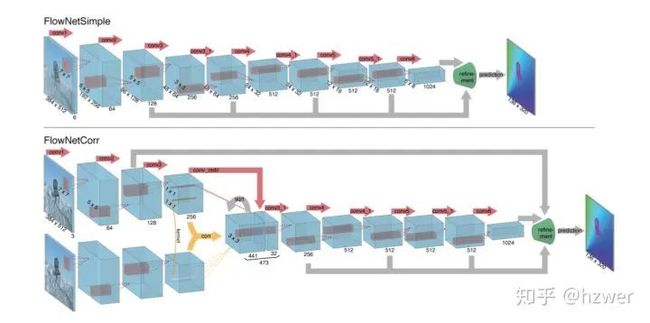

Flownet 的两种结构。两种结构的特征提取部分不同,FlowNetCorr 先通过两个分支提取特征,在特征图上进行相关性运算。

Flownet 的两种结构。两种结构的特征提取部分不同,FlowNetCorr 先通过两个分支提取特征,在特征图上进行相关性运算。

Flownet 尝试用端到端的卷积神经网络解决光流估计问题,该模型的输入是两帧图像 ,输出是第一帧到第二帧的光流 。光流网络训练的损失函数通常是端点误差函数 (End Point Error Loss),即加和每个像素点预测的光流与标注的二维空间欧式距离。由于人工标注光流数据难以实现,作者设计了一种数据合成算法。

作者生成了一个 FlyingChairs 数据集,其背景是来自于 Flickr(海外图像分享网站)中某些特定标签的图像,前景是三维椅子模型,共有 809 种椅子,62个视角。为了产生运动信息,产生第一张图像的时候会随机产生一个位移变量,与背景图像与椅子位移相关, 再通过这种位移变量产生第二个图像和光流。每一个图像对的椅子的类型,数量,大小,位置,位移向量都是随机的(但为了简便,只考虑了二维平面上的运动)。最后生成了 22, 872 个图像对,每张图像大小 。

网络结构上,采用的是编解码网络结构,其编码模块均为 9 层卷积,解码模块为 4 层反卷积。作者主要设计了两种结构,FlowNetSimple 和 FlowNetCorr,二者的编码模块不同。FlowNetSimple 直接将两张图像按照通道拼接后输入,因此输入的通道数为 6。FlowNetCorr 先分别对两张图像进行特征提取获得高层特征,再进行相关性运算(一种按图像匹配思想设计的算子)。解码模块的反卷积的每一层输入前一层的输出,同时还输入前一层预测的低尺度的光流和对应编码模块中的特征层。

Flownet2.0结构。其中的 FlownetC 和 FlownetS 是原版 Flownet 的结构,在两个光流网络的连接处,用已有的光流结果映射第二帧图像后,再和第一帧图像一起输入下一个光流网络。FlownetSD是针对小运动设计的一个子网络,用于改进最后的光流结果。

Flownet2.0结构。其中的 FlownetC 和 FlownetS 是原版 Flownet 的结构,在两个光流网络的连接处,用已有的光流结果映射第二帧图像后,再和第一帧图像一起输入下一个光流网络。FlownetSD是针对小运动设计的一个子网络,用于改进最后的光流结果。

Flownet2.0 是 E. Ilg 等人在 2017 年实现的Flownet的改进算法。这个算法的主要改进一是通过堆叠多个 FlowNet 网络,实现由粗到精的光流估计。每次堆叠网络结构时,将当前得到的光流作用在第二帧上,做后向映射(backward warp),往第一帧图像的方向对齐。改进二是通过实验发现 Flownet 对于比较小的物体运动估计不准。改进做法是将卷积核缩小并缩短卷积步长。Flownet2.0 合成了新的数据集,在 FlyingChairs 的基础上增加了一些小位移数据。同时,还混合了2017年提出的一个更复杂的数据集 Things3D(加入了各种各样的物体,并考虑了三维空间的运动)。最终 Flownet2.0 达到了传统的光流估计算法的最好结果,并且速度上比传统算法快两个数量级。

PWC-net 系列光流估计网络

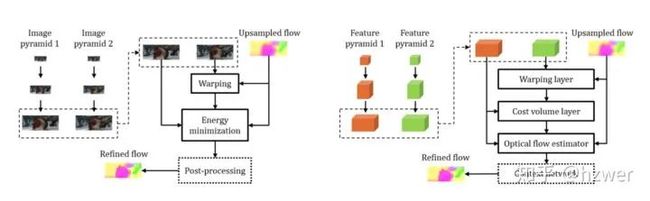

传统算法使用图像金字塔,对第二帧图像的金字塔做后向映射,通过迭代优化能量函数来计算光流。PWC-net中,先对两帧图像构建了特征金字塔,在级联光流的每一层中,对第二帧图像的特征做后向映射,再和第一帧图像特征进行匹配代价容量计算,匹配代价容量中估计光流的修正量。

传统算法使用图像金字塔,对第二帧图像的金字塔做后向映射,通过迭代优化能量函数来计算光流。PWC-net中,先对两帧图像构建了特征金字塔,在级联光流的每一层中,对第二帧图像的特征做后向映射,再和第一帧图像特征进行匹配代价容量计算,匹配代价容量中估计光流的修正量。

PWC-net 是2018年 提出的一个光流估计网络,其采用的三个主要组件是图像金字塔(Pyramid),映射 (Warping) 和匹配代价容量计算 (Cost Volume,类似于 Flownet 的相关性计算),映射和匹配代价容量计算不需要训练参数,所以可以减少模型参数量。PWC-net 在 的视频上做到了视频流实时光流估计(达到35帧每秒),其参数量是 Flownet2.0 的 0.06倍,并且训练策略也更加简单。

MaskFlownet 是2020年提出的 PWC-net 的一个改进版,其采用了非对称的、结合遮挡掩膜的匹配代价容量计算。主要思路是做匹配代价容量计算时,应当排除那些在一帧中被遮挡的像素。同时,由于第二帧的特征经过了映射,破坏了匹配的对称性,因此,在匹配前,对映射后的第二帧的特征再插入若小运算量的可变卷积(deformable convolution),并加入一个前层网络预测的遮挡掩膜,再和第一帧的特征进行匹配。这个做法显著地提高了 PWC-net 的效果。

LiteFlownet 光流估计网络

LiteFlownet结构。图中展示了三级级联光流网络,每一级主要由光流估计模块(M),子像素修正层(S)和光流正则化层(R)构成。

LiteFlownet结构。图中展示了三级级联光流网络,每一级主要由光流估计模块(M),子像素修正层(S)和光流正则化层(R)构成。

LiteFlownet是2018提出的轻量级光流估计网络。这个网络和PWC-net有很多相似之处,包括图像金字塔和匹配代价容量计算。其特点是参数量比较小,约为 Flownet2.0 的 0.03 倍,速度约 1.4 倍。其与 PWC-net 的主要区别是:对于级联的不同层次的局部特征容量计算,LiteFlownet设置了不同的范围以减小计算量,把计算后的特征通过子像素修正层(sub-pixel refinement layer),用来提升上一级光流结果的精度。同时,为每一级的光流结果构造了一个光流正则化层,起名为特征驱动的局部卷积(Feature-driven Local Convolution),通过当前的图像特征和光流构造位置相关的卷积核以平滑光流结果。

References:

[1]Baker, S. and Matthews, I. Lucas-kanade 20 years on: A unifying framework. International journal of computer vision, 56(3), 2004: 221–255.

[2]Sun, D., Yang, X., Liu, M.-Y., and Kautz, J. Pwc-net: Cnns for optical flow using pyramid, warping, and cost volume. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018, pages 8934–8943.

[3]Dosovitskiy, A., Fischer, P., Ilg, E., Hausser, P., Hazirbas, C., Golkov, V., Van Der Smagt, P., Cremers, D., and Brox, T. Flownet: Learning optical flow with convolutional networks. In: Proceedings of the IEEE international conference on computer vision. 2015, pages 2758–2766.

[4]Zhao, S., Sheng, Y., Dong, Y., Chang, E. I.-C., and Xu, Y. Maskflownet: Asymmetric fea- ture matching with learnable occlusion mask. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2020.

[5]Hui, T.-W., Tang, X., and Change Loy, C. Liteflownet: A lightweight convolutional neural network for optical flow estimation. In: Proceedings of the IEEE conference on computer vision and pattern recognition. 2018, pages 8981–8989.

想要更加全面细致了解计算机视觉的同学欢迎,欢迎购买下面这本国外经典教材:

![]()

备注:CV

![]()

计算机视觉交流群

交流最新最前沿的计算机视觉技术,欢迎扫码备注进群。

我爱计算机视觉

微信号:aicvml

QQ群:805388940

微博知乎:@我爱计算机视觉

网站:www.52cv.net

![]()

在看,让更多人看到 ![]()