【文本信息抽取与结构化】详聊如何用BERT实现关系抽取

常常在想,自然语言处理到底在做的是一件什么样的事情?到目前为止,我所接触到的NLP其实都是在做一件事情,即将自然语言转化为一种计算机能够理解的形式。这一点在知识图谱、信息抽取、文本摘要这些任务中格外明显。不同的任务的差异在于目标的转化形式不一样,因而不同的任务难度、处理方式存在差异。

这个系列文章【文本信息抽取与结构化】,在自然语言处理中是非常有用和有难度的技术,是文本处理与知识提取不可或缺的技术。

BERT这么强大的预训练模型,当然会想着把他利用起来,本篇介绍如何利用BERT进行关系抽取。

作者&编辑 | 小Dream哥

前述

关系分类与提取是一个重要的NLP任务,其主要目标是提取出实体以它们之间的关系。在BERT之前,最有效的关系分类方法主要是基于CNN或RNN。最近,预训练BERT模型在许多NLP的分类和序列标注任务中都获得了非常好的结果。

因此,必然会有工作考虑利用BERT来自关系抽取。关系提取与分类的主要难点在于,其不仅仅依赖于两个目标实体的信息,还依赖于句子本身的语义及语法信息。利用BERT强大的编码能力,预期能够同时抽取到文本中的两种特征。事实上也正是如此,目前效果最好的关系抽取模型正是基于BERT的工作,本片介绍几个利用BERT来做关系抽取的工作。

R-BERT模型

R-BERT(作者这样称呼),是我调研到的第一篇用BERT做RE的模型,所以笔者先介绍这个模型。

1) 模型结构

Wu S , He Y . Enriching Pre-trained Language Model with Entity Information for Relation Classification[J]. 2019.

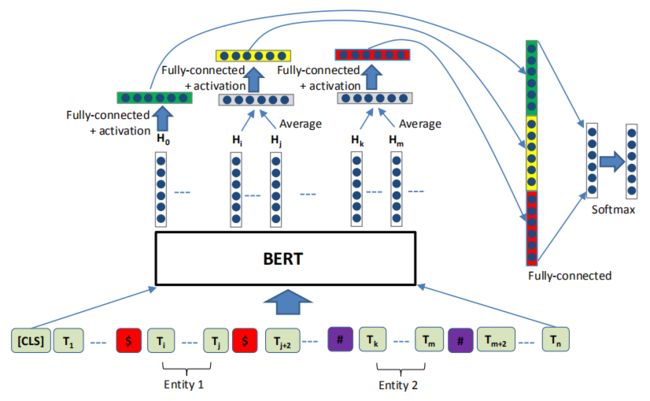

如上图所示,是R-BERT的模型结构在模型中,需要注意一下三点:

1.为了使BERT模型能够定位两个实体的位置,作者在每个句子的开头添加 "[CLS]" ,在第一个实体前后添加特殊字符 "$" ,在第二个实体前后添加特殊字符"#"

2.R-BERT利用了BERT三部分特征进行最后的关系分类:

(1)[CLS]最终隐含状态向量,这部分提取了句子

的语义特征

(2)两个实体的隐含状态向量,这部分提取了实体

特征

3.最后,利用拼接三个特征进行关系分类,接一个softmax进行分类

2) 模型运算

下面来讲一讲如何获取这三个特征,对于[CLS]特征,利用BERT输出的第一个编码向量,做以下的处理即可得到:

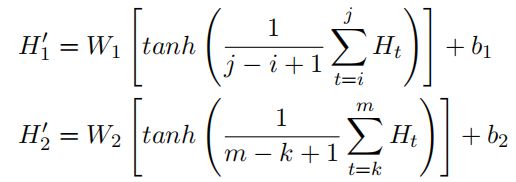

对于两个实体的特征,在训练时,拿到BERT输出对应位置的隐藏向量后做如下的处理即可得到:

获取到3个特征之后,如何进行关系分类呢?模型将上述3个特征拼接起来,然后接一个DENSE层,在通过softmax进行分类,具体运算过程如下:

作者还做了去除了实体前后的标识符的实验,发现模型的F1值从89.25%降到87.98%,表明标识符可以帮助提供实体信息;假如仅仅使用BERT输出层的[CLS]句子向量,会使得模型F1值从89.25%降到87.99%;上述实验证明在关系分类任务中,明确实体的位置,能够提升模型的性能。

但是这仅仅是一个关系分类的模型,在前面的文章我们介绍过,在关系抽取模型中,其实end-to-end模型才是更合理的方式,下面介绍一种端到端的BERT关系抽取模型。

2 End-to-End BERT RE

1) 模型结构

Giorgi J , Wang X , Sahar N , et al. End-to-end Named Entity Recognition and Relation Extraction using Pre-trained Language Models[J]. 2019.

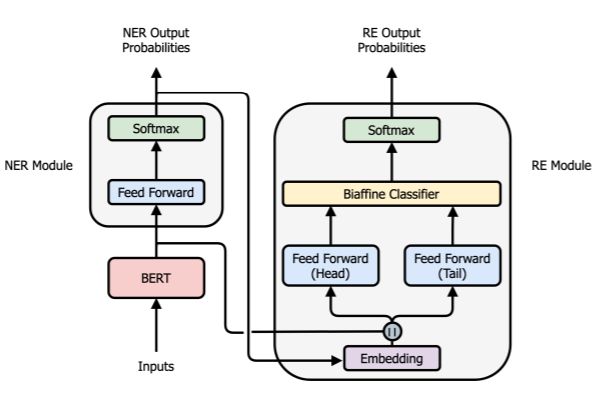

如上图所示是该模型的结构示意图,模型可以分为两个部分:实体抽取模块和关系分类模块。

1. 实体识别模块

实体抽取模块和我们前面介绍的实体抽取模块基本相同,感兴趣的同学可以看如下的文章:

【NLP-NER】如何使用BERT来做命名实体识别

该模型中差异仅仅在于,文本经过BERT进行特征抽取之后,接一个Feed-Forward层和sonftmax,而不是CRF。

2. 关系分类模块

我们重点来看关系抽取的模块,该模块的输入由2个部分组成:实体抽取信息以及BERT编码信息。将实体抽取模块输出的BIOES类别信息,编码成固定维度的向量。然后将该向量与BERT的编码向量拼接起来,作为关系抽取模块的输入,如下公式所示:

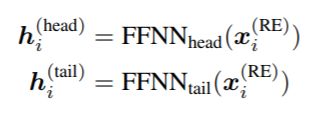

该输入并行的通过了两个FFN层,称为FFN-head和FFN-tail,如上面的模型结构图所示,得到两个向量。

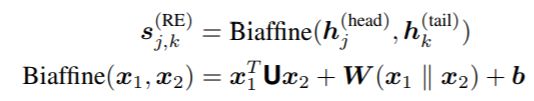

随后,将这两个向量通过一个 Biaffine层,预测出属于每个关系的类别:

这里U的维度是m*C*m,W的维度是C*2m。m是FFN层输出的向量的维度,C是关系的类别数。

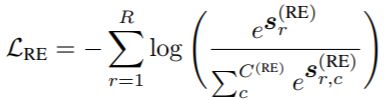

2)损失函数

如上公式所示,是该模型采用的损失函数,其中S_r是模型预测的样本中真正有的关系的预测得分,即r in R(样本标签里的关系)。S_r_c表示模型预测样本有某一个关系的得分,r in C。

当然,NER模型和RE模型要一起优化,所以总的损失函数为:

这个模型的特点是端到端的实现了实体抽取和关系抽取,同时也能够预测多个关系类别。

总结

文本信息抽取与结构化是目前NLP中最为实际且效益最大的任务,熟悉这个任务是一个NLP算法工程师必需要做的事情。

读者们可以留言,或者加入我们的NLP群进行讨论。感兴趣的同学可以微信搜索jen104,备注"加入有三AI NLP群"。

下期预告:详述关系识别模型

知识星球推荐

扫描上面的二维码,就可以加入我们的星球,助你成长为一名合格的自然语言处理算法工程师。

知识星球主要有以下内容:

(1) 聊天机器人;

(2) 知识图谱;

(3) NLP预训练模型。

转载文章请后台联系

侵权必究

![]()

![]()

![]()

往期精选

【完结】 12篇文章带你完全进入NLP领域,掌握核心技术

【年终总结】2019年有三AI NLP做了什么,明年要做什么?

【NLP-词向量】词向量的由来及本质

【NLP-词向量】从模型结构到损失函数详解word2vec

【NLP-NER】什么是命名实体识别?

【NLP-NER】命名实体识别中最常用的两种深度学习模型

【NLP-NER】如何使用BERT来做命名实体识别

【NLP-ChatBot】我们熟悉的聊天机器人都有哪几类?

【NLP-ChatBot】搜索引擎的最终形态之问答系统(FAQ)详述

【NLP-ChatBot】能干活的聊天机器人-对话系统概述

【知识图谱】人工智能技术最重要基础设施之一,知识图谱你该学习的东西

【知识图谱】知识表示:知识图谱如何表示结构化的知识?

【知识图谱】如何构建知识体系:知识图谱搭建的第一步

【知识图谱】获取到知识后,如何进行存储和便捷的检索?

【知识图谱】知识推理,知识图谱里最“人工智能”的一段

【文本信息抽取与结构化】目前NLP领域最有应用价值的子任务之一

【文本信息抽取与结构化】详聊文本的结构化【上】

【文本信息抽取与结构化】详聊文本的结构化【下】

【NLP实战】tensorflow词向量训练实战

【NLP实战系列】朴素贝叶斯文本分类实战

【NLP实战系列】Tensorflow命名实体识别实战

【NLP实战】如何基于Tensorflow搭建一个聊天机器人

【NLP实战】基于ALBERT的文本相似度计算

【每周NLP论文推荐】从预训练模型掌握NLP的基本发展脉络

【每周NLP论文推荐】 NLP中命名实体识别从机器学习到深度学习的代表性研究

【每周NLP论文推荐】 介绍语义匹配中的经典文章

【每周NLP论文推荐】 对话管理中的标志性论文介绍

【每周NLP论文推荐】 开发聊天机器人必读的重要论文

【每周NLP论文推荐】 掌握实体关系抽取必读的文章

【每周NLP论文推荐】 生成式聊天机器人论文介绍

【每周NLP论文推荐】 知识图谱重要论文介绍