CDH6.0、6.1篇:5、CDH的使用(hadoop ha、yarn ha)

本文分3个部分阐述

1.使用CDH注意事项

2.Hadoop HA 搭建

3.YARN HA 搭建

----------------------------------------分割线-------------------------------------------------------------

1.使用CDH注意事项

1.每台机器:根据aliyun提供的服务进行 时间同步:ntpdate -u ntp6.aliyun.com

1.先同步阿里云时间,再执行启动ntpd服务为好,

才能保证ntpd服务正常启动:ntpdate -u ntp6.aliyun.com

2.启动服务 systemctl start ntpd、重启服务systemctl restart ntpd、关闭服务systemctl stop ntpd

查看是否启动 ps -ef | grep ntpd

开机启动 systemctl enable ntpd.service

查看时间同步状态 ntpstat

3.查看时间:date 或 timedatectl

注意:每个节点执行ntpstat 和 timedatectl 都显示同步并且时间相同,那么CDH才能正常使用。

每次ntp服务同步到外部授时中心都要一段时间(5~10分钟),只有当NTP server(node1)节点和其他的NTP client(node2、node3)节点都显示同步成功之后,

CM页面中的每台机器才不会报错。可通过timedatectl查看到当前节点是否同步成功:如果显示 NTP enabled: yes 和 NTP synchronized: yes 才表示成功。

2.必须保证MySQL启动了,才能正常启动Cloudera Manager Server:service mysql start 和 service mysql status

3.node1主节点:启动Cloudera Manager Server

一般机器启动时,Cloudera Manager Server便会自动启动,因此无需手动启动

systemctl start cloudera-scm-server

启动之后需要一段时间才能完全整个启动(一般一分钟之内),才可以访问到 192.168.88.100:7180/cmf/login

systemctl stop cloudera-scm-server

建议每次关机之前都先停止 cloudera-scm-server,要么就挂起

systemctl restart cloudera-scm-server

systemctl status cloudera-scm-server

-

1.ps -ef | grep cloudera-scm-server 查看是否启动

-

2.systemctl status cloudera-scm-server 查看启动状态,启动正常显示 Active: active (running)

-

3.cloudera-scm-server 默认使用的端口 7180,那么就可以通过 192.168.88.100:7180/cmf/login 访问 CM

-

4.netstat -lnpt | grep 7180 只要被使用时才能访问到 192.168.88.100:7180/cmf/login

正常显示 tcp 0 0 0.0.0.0:7180 0.0.0.0:* LISTEN 68289/java

3.所有机器的时间同步

-

1.ntpdate -u ntp6.aliyun.com 同步阿里云时间

-

2.timedatectl 查看当前时间和NTP服务的同步状态,需要显示为 NTP enabled: yes 和 NTP synchronized: yes 才表示各机器之间的时间服务NTP完全同步

-

3.如果显示 NTP enabled: no那么 启动服务 systemctl start ntpd,查看是否启动 ps -ef | grep ntpd

-

4.执行ntpstat每个节点时间服务NTP的同步情况,主节点显示synchronised to NTP server (xxx.xxx.xxx.xxx)表示成功同步外部的授时中心 其他子节点显示synchronised to NTP server

(主节点IP)表示其他子节点同步主节点的时间,如果显示unsynchronised表示没有同步成功,这时可选择systemctl

restart ntpd -

5.注意:ntpd服务启动后,主节点一般需要15分钟才能同步上外部的授时中心,其他子节点同样可能需要15分钟才同步上主节点时钟

4.通过 192.168.88.100:7180/cmf/login 访问 CM

1.HDFS:

1.dfs.permissions 检查 HDFS 权限

操作:关闭权限检查,选择 不勾选

2.HDFS/Hive:

2.HDFS/Hive:

问题:Canary 测试无法在目录 /tmp/.cloudera_health_monitoring_canary_files 中创建文件

解决:经过查看日志,发现 Name node is in safe mode.

sudo -u hdfs hdfs dfsadmin -safemode leave

然后重启HDFS,注意可能还要等一段时间CDH才会重新显示hive为正常(绿色)

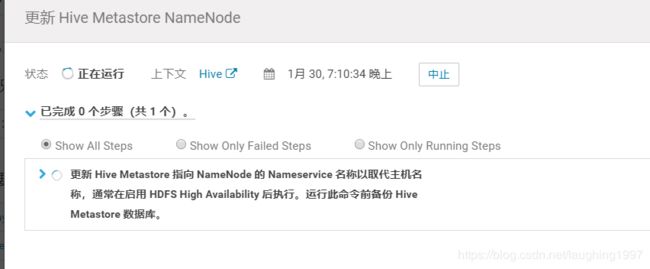

2.Hadoop HA 搭建

dfs.namenode.edits.dir (NameNode 编辑目录) :

写入 NameNode 编辑的本地文件系统上的目录。未指定将存放在namenode数据目录中。

dfs.journalnode.edits.dir (JournalNode 编辑目录):

用于存储 NameNode 编辑的本地文件系统目录。journalnode所在节点的目录,存放editlog和其他信息。

3.YARN HA 搭建

问题记录

1.在使用 yarn HA时,运行 hive on yarn 的任务无法得出结果时,并且出现以下错误

Caused by:javax.servlet.ServletException: Could not determine the proxy server for redirection

问题:无法确定用于重定向的代理服务器

解决:禁用 YARN HA,即ResourceManager只使用一个主节点,其实一般yarn HA仍然能运行 hive on yarn 的任务并且能得出正常结果,但是还是会报出同样错误

2.当前运行的环境是 YARN HA(node1、node2均部署了ResourceManager)的情况下,执行 hive on spark 的程序,虽然能得出正常执行成功得出结果

但是对应该程序的日志信息仍然报错:无法确定用于重定向的代理服务器

Could not determine the proxy server for redirection。

select * from test_tb;

select count(*) from test_tb;

insert into test_tb values(2,'ushionagisa');