- spark学习资料

Liam_ml

AdvancedApacheSpark-SameerFarooqui(Databricks)”(https://www.youtube.com/watch?v=7ooZ4S7Ay6Y)将几天的课程浓缩到了一天,质量非常好。Spark的文档:Overview-Spark1.6.1Documentation,这里面包含项目介绍,代码示例,配置,部署,调优等等,入门使用足够了。Sparkrepo:apa

- Hudi学习 6:Hudi使用

hzp666

Hudihudi数据湖湖仓一体湖仓融合实时数仓

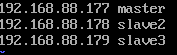

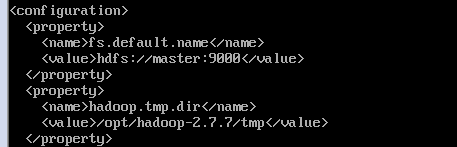

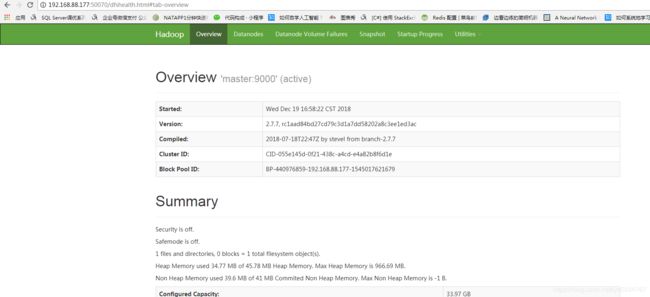

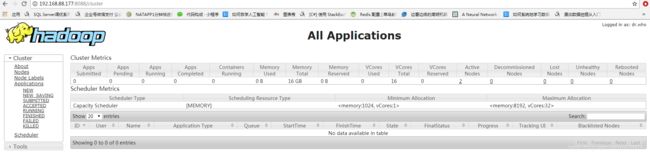

准备工作:1.安装hdfshttps://mp.csdn.net/mp_blog/creation/editor/1096891432.安装sparkspark学习4:spark安装_hzp666的博客-CSDN博客3.安装ScalaHudi学习6:安装和基本操作_hzp666的博客-CSDN博客spark-shell写入和读取hudi2.模拟数据插入hudi使用spark写入数据

- spark学习4:spark安装

hzp666

sparkspark大数据

1.下载spark安装包2.配置环境1.cd/bigdata/spark-3.0.1-bin-hadoop3.2/conf/2.4.添加动态库在hadoop-3.2.2/bin目录下添加hadoop.dll和winutils.exe文件,可以从https://github.com/cdarlint/winutils和https://github.com/steveloughran/winutils

- pyspark学习-自定义udf

heiqizero

sparkspark

#demo1:frompyspark.sqlimportSparkSession,Rowif__name__=='__main__':spark=SparkSession.builder.getOrCreate()num=spark.sparkContext.parallelize([1,2,3,4,5]).map(lambdax:Row(num=x))numDF=spark.createData

- pyspark学习-spark.sql.functions normal函数

heiqizero

sparkspark

1.col#col(col)"""作用:返回一个基于已给列名的列信息场景:类似于dataframe格式中提取data["id"],能够进行计算参数: col:列名 返回: column:返回一个基于已给列名的列信息"""spark=SparkSession.builder.getOrCreate()data=spark.range(3)data.select(col("id").alias(

- [Spark] 如何设置Spark资源

LZhan

转自1.公众号[Spark学习技巧]如何设置Spark资源2.Spark性能优化篇一:资源调优Spark和YARN管理的两个主要资源:CPU和内存应用程序中每个SparkExecutor都具有相同的固定数量的核心和相同的固定堆大小。使用--executor-cores命令行参数或者通过设置spark.executor.cores属性指定核心数;使用--executor-memory命令行参数或者通

- pyspark学习-spark.sql.functions 聚合函数

heiqizero

sparkspark

https://spark.apache.org/docs/3.4.1/api/python/reference/pyspark.sql/functions.html1.approx_count_distinct和count_distinct#approx_count_distinct(col:ColumnOrName,rsd:Optionnal[float]=None)"""作用:返回列col的

- spark学习笔记:弹性分布式数据集RDD(Resilient Distributed Dataset)

黄道婆

bigdata

弹性分布式数据集RDD1.RDD概述1.1什么是RDDRDD(ResilientDistributedDataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。RDD具有数据流模型的特点:自动容错、位置感知性调度和可伸缩性。RDD允许用户在执行多个查询时显式地将数据缓存在内存中,后续的查询能够重用这些数据,这极大地提升了查询速度。D

- pyspark学习_dataframe常用操作_02

heiqizero

sparkspark

#回顾01常用操作frompysparkimportSparkSession,DataFramespark=SparkSession.builder.getOrCreate()peopleDF=spark.read.json("people.json")peopleDF.printSchema()#显示DataFrame的模式信息peopleDF.show()#显示DataFrame的数据信息pe

- Spark学习笔记五:Spark资源调度和任务调度

开发者连小超

一、StageSpark任务会根据RDD之间的依赖关系,形成一个DAG有向无环图,DAG会提交给DAGScheduler,DAGScheduler会把DAG划分相互依赖的多个stage,划分stage的依据就是RDD之间的宽窄依赖。遇到宽依赖就划分stage,每个stage包含一个或多个task任务。然后将这些task以taskSet的形式提交给TaskScheduler运行。stage切割规则切

- pyspark学习_wordcount

heiqizero

sparksparkpython

#统计文件中每个字母出现次数#第一版rdd文件行类型:Aaron,OperatingSystem,100frompysparkimportSparkConf,SparkContextconf=SparkConf().setAppName("RddwordCount").setMaster("local[*]")sc=SparkContext(conf=conf)lines=sc.textFile(

- pyspark学习_RDD转为DataFrame

heiqizero

sparksparkpython

#方法1:反射机制推断RDD模式people.txtTom12Jack13Janny14frompyspark.sqlimportSparkSession,Rowspark=SparkSession.builder.getOrCreate()lines=spark.sparkContext.textFile("people.txt")people=lines.map(lambdax:x.split

- pyspark学习-RDD转换和动作

heiqizero

sparksparkpython

#RDD创建#1.parallelize方法:创建RDD,参数为list,返回RDDsc.parallelize(param:list)#demosc.parallelize(['tom','jack','black'])#2.textFile方法:读取文件,创建RDD,参数为hdfs文件地址或者本地文件地址,返回RDDsc.textFile(param:filepath)#demosc.text

- pyspark学习_dataframe常用操作_01

heiqizero

sparksparkpython

1.创建DataFrame本文使用DataFrame通过读取json文件获取数据,代码如下:frompyspark.sqlimportSparkSessionspark=SparkSeesion.builder.getOrCreate()#创建sparkSessionpeopleDF=spark.read.format("json").load("people.json")"""spark支持读取

- Spark学习(8)-SparkSQL的运行流程,Spark On Hive

技术闲聊DD

大数据hivespark学习

1.SparkSQL的运行流程1.1SparkRDD的执行流程回顾1.2SparkSQL的自动优化RDD的运行会完全按照开发者的代码执行,如果开发者水平有限,RDD的执行效率也会受到影响。而SparkSQL会对写完的代码,执行“自动优化”,以提升代码运行效率,避免开发者水平影响到代码执行效率。这是因为:RDD:内含数据类型不限格式和结构。DataFrame:100%是二维表结构,可以被针对Spar

- Apriori

BluthLeee

Apriori算法原理总结-刘建平FPTree算法原理总结-刘建平PrefixSpan算法原理总结-刘建平用Spark学习FPTree算法和PrefixSpan算法-刘建平

- Spark学习之Spark Core

John Stones

sparkbigdatascala

什么是Spark?(官网:http://spark.apache.org)https://www.cnblogs.com/lq0310/p/9841647.html

- 【大数据】Spark学习笔记

pass night

学习笔记javaspark大数据sql

初识SparkSpark和HadoopHadoopSpark起源时间20052009起源地MapReduceUniversityofCaliforniaBerkeley数据处理引擎BatchBatch编程模型MapReduceResilientdistributedDatesets内存管理DiskBasedJVMManaged延迟高中吞吐量中高优化机制手动手动APILowlevelhighleve

- spark学习之旅(2)之之RDD常用方法

浩哥的技术博客

sparkspark大数据

RDD(ResilientDistributedDataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。这里的弹性指的是RDD可以根据当前情况自动进行内存和硬盘存储的转换简单点讲就是spark中对数据的一个封装,把数据封装进对象,容易操作在spark中所有的计算都是围绕着RDD操作的,每个RDD都被分为多个分区,这些分区运行在集群

- spark学习一-------------------Spark算子最详细介绍

创作者mateo

spark大数据专栏spark学习ajax

Spark学习–spark算子介绍1.基本概念spark算子:为了提供方便的数据处理和计算,spark提供了一系列的算子来进行数据处理。一般算子分为action(执行算子)算子Transformation(懒执行)算子。2.Transformation算子基本介绍简介:transformation被称为懒执行算子,如果没有action算子,则代码是不会执行的,一般分为:map算子:map算子是将r

- 2017.09.06 scala spark学习

RazorH

日记

2.scala没有静态的修饰符,但object下的成员都是静态的,若有同名的class,这其作为它的伴生类。在object中一般可以为伴生类做一些初始化等操作,如我们常常使用的valarray=Array(1,2,3)(ps:其使用了apply方法)scala里的object一般特指的是伴生对象,可以通过对象名直接调用其中的成员,类似Java中的static成员,如果不在当前作用域,需要impor

- spark学习笔记(十一)——sparkStreaming-概述/特点/构架/DStream入门程序wordcount

一个人的牛牛

spark学习sparkscala大数据

目录SparkStreamingsparkStreamingDStreamsparkStreaming特点sparkStreaming构架背压机制DStream入门SparkStreamingsparkStreamingSparkStreaming用于流式数据的处理。SparkStreaming支持的数据输入源很多:Kafka、Flume、Twitter、ZeroMQ和简单的TCP套接字等等。数据

- Spark学习——1.代表性大数据技术

楓尘林间

SparkSpark大数据学习

本篇博客是学习子雨大数据之Spark入门教程的学习笔记,仅作学习之用。1.代表性的大数据技术HadoopSparkFlinkBeam主要计算模式如图1-11.1HadoopHadoop的生态系统图如图1-2开源谷歌GFS,利用MapReduce分布式并行编程,MapReduce和HDFS是Hadoop的两大核心。HDFS分布式文件管理系统Hive数据仓库数据仓库,借助底层HDFS和HBase完成存

- Spark学习笔记一

孤独的偷学者

开发环境的搭建大数据spark

文章目录1Spark架构设计与原理思想1.1Spark初始1.2Spark架构核心1.3Spark的计算阶段1.4Spark执行流程1.4Spark核心模块2Spark运行环境2.1Local模式2.2Standalone模式2.2.1上传与解压Spark压缩包2.2.2默认配置文件的修改2.2.3启动集群2.2.4配置历史服务2.2.5配置高可用(HA)1Spark架构设计与原理思想1.1Spa

- 大数据Spark学习笔记—sparkcore

Int mian[]

大数据大数据sparkhadoopscala分布式

目录Spark概述核心模块Spark编程配置IDEA配置scala环境WordCount案例Spark-Standalone运行环境Local配置步骤集群分工解压文件修改配置启动集群配置历史服务器Spark-Yarn运行环境配置步骤配置历史服务器Windows运行环境配置步骤常用端口号Spark架构核心组件DriverExecutorMaster&WorkerApplicationMasterHa

- 20210127_spark学习笔记

yehaver

spark

一、部分理论spark:由Scala语言开发的快速、通用、可扩展的基于内存的大数据分析引擎。在mapreduce上进行了优化,但没mapreduce稳定。SparkCore是spark平台的基础通用执行引擎,所有其他功能都是基于。它在外部存储系统中提供内存计算和引用数据集。spark最基础的最核心的功能SparkSQL是SparkCore之上的一个组件,它引入了一个称为SchemaRDD的新数据抽

- 【Spark学习笔记】- 1Spark和Hadoop的区别

拉格朗日(Lagrange)

#Spark学习笔记spark学习笔记

目录标题Spark是什么SparkandHadoop首先从时间节点上来看:功能上来看:SparkorHadoopSpark是什么Spark是一种基于内存的快速、通用、可扩展的大数据分析计算引擎。SparkandHadoop在之前的学习中,Hadoop的MapReduce是大家广为熟知的计算框架,那为什么咱们还要学习新的计算框架Spark呢,这里就不得不提到Spark和Hadoop的关系。首先从时间

- Spark学习笔记【基础概念】

java路飞

大数据Sparkspark大数据java

文章目录前言Spark基础Spark是什么spark和hadoop区别Spark核心模块Spark运行模式Spark运行架构运行架构Executor与Core(核)并行度(Parallelism)有向无环图(DAG)spark的提交方式clientclusterSpark核心编程三大数据结构RDD什么是RDD执行原理RDDAPIRDD创建RDD转换算子Action行动算子统计操作RDD序列化RDD

- Spark学习笔记(3)——Spark运行架构

程光CS

#Spark学习笔记

本系列文章内容全部来自尚硅谷教学视频,仅作为个人的学习笔记一、运行架构Spark框架的核心是一个计算引擎,整体来说,它采用了标准master-slave的结构。如下图所示,它展示了一个Spark执行时的基本结构。图形中的Driver表示master,负责管理整个集群中的作业任务调度。图形中的Executor则是slave,负责实际执行任务。二、核心组件由上图可以看出,对于Spark框架有两个核心组

- 【Spark学习笔记】- 4运行架构&核心组件&核心概念

拉格朗日(Lagrange)

#Spark学习笔记spark学习笔记

目录标题1运行架构2核心组件2.1Driver2.2Executor2.3Master&Worker2.4ApplicationMaster3核心概念3.1Executor与Core3.2并行度(Parallelism)3.3有向无环图(DAG)4提交流程4.1YarnClient模式4.2YarnCluster模式5分布式计算模拟5.1Driver5.2Executor5.3Executor25

- 强大的销售团队背后 竟然是大数据分析的身影

蓝儿唯美

数据分析

Mark Roberge是HubSpot的首席财务官,在招聘销售职位时使用了大量数据分析。但是科技并没有挤走直觉。

大家都知道数理学家实际上已经渗透到了各行各业。这些热衷数据的人们通过处理数据理解商业流程的各个方面,以重组弱点,增强优势。

Mark Roberge是美国HubSpot公司的首席财务官,HubSpot公司在构架集客营销现象方面出过一份力——因此他也是一位数理学家。他使用数据分析

- Haproxy+Keepalived高可用双机单活

bylijinnan

负载均衡keepalivedhaproxy高可用

我们的应用MyApp不支持集群,但要求双机单活(两台机器:master和slave):

1.正常情况下,只有master启动MyApp并提供服务

2.当master发生故障时,slave自动启动本机的MyApp,同时虚拟IP漂移至slave,保持对外提供服务的IP和端口不变

F5据说也能满足上面的需求,但F5的通常用法都是双机双活,单活的话还没研究过

服务器资源

10.7

- eclipse编辑器中文乱码问题解决

0624chenhong

eclipse乱码

使用Eclipse编辑文件经常出现中文乱码或者文件中有中文不能保存的问题,Eclipse提供了灵活的设置文件编码格式的选项,我们可以通过设置编码 格式解决乱码问题。在Eclipse可以从几个层面设置编码格式:Workspace、Project、Content Type、File

本文以Eclipse 3.3(英文)为例加以说明:

1. 设置Workspace的编码格式:

Windows-&g

- 基础篇--resources资源

不懂事的小屁孩

android

最近一直在做java开发,偶尔敲点android代码,突然发现有些基础给忘记了,今天用半天时间温顾一下resources的资源。

String.xml 字符串资源 涉及国际化问题

http://www.2cto.com/kf/201302/190394.html

string-array

- 接上篇补上window平台自动上传证书文件的批处理问卷

酷的飞上天空

window

@echo off

: host=服务器证书域名或ip,需要和部署时服务器的域名或ip一致 ou=公司名称, o=公司名称

set host=localhost

set ou=localhost

set o=localhost

set password=123456

set validity=3650

set salias=s

- 企业物联网大潮涌动:如何做好准备?

蓝儿唯美

企业

物联网的可能性也许是无限的。要找出架构师可以做好准备的领域然后利用日益连接的世界。

尽管物联网(IoT)还很新,企业架构师现在也应该为一个连接更加紧密的未来做好计划,而不是跟上闸门被打开后的集成挑战。“问题不在于物联网正在进入哪些领域,而是哪些地方物联网没有在企业推进,” Gartner研究总监Mike Walker说。

Gartner预测到2020年物联网设备安装量将达260亿,这些设备在全

- spring学习——数据库(mybatis持久化框架配置)

a-john

mybatis

Spring提供了一组数据访问框架,集成了多种数据访问技术。无论是JDBC,iBATIS(mybatis)还是Hibernate,Spring都能够帮助消除持久化代码中单调枯燥的数据访问逻辑。可以依赖Spring来处理底层的数据访问。

mybatis是一种Spring持久化框架,要使用mybatis,就要做好相应的配置:

1,配置数据源。有很多数据源可以选择,如:DBCP,JDBC,aliba

- Java静态代理、动态代理实例

aijuans

Java静态代理

采用Java代理模式,代理类通过调用委托类对象的方法,来提供特定的服务。委托类需要实现一个业务接口,代理类返回委托类的实例接口对象。

按照代理类的创建时期,可以分为:静态代理和动态代理。

所谓静态代理: 指程序员创建好代理类,编译时直接生成代理类的字节码文件。

所谓动态代理: 在程序运行时,通过反射机制动态生成代理类。

一、静态代理类实例:

1、Serivce.ja

- Struts1与Struts2的12点区别

asia007

Struts1与Struts2

1) 在Action实现类方面的对比:Struts 1要求Action类继承一个抽象基类;Struts 1的一个具体问题是使用抽象类编程而不是接口。Struts 2 Action类可以实现一个Action接口,也可以实现其他接口,使可选和定制的服务成为可能。Struts 2提供一个ActionSupport基类去实现常用的接口。即使Action接口不是必须实现的,只有一个包含execute方法的P

- 初学者要多看看帮助文档 不要用js来写Jquery的代码

百合不是茶

jqueryjs

解析json数据的时候需要将解析的数据写到文本框中, 出现了用js来写Jquery代码的问题;

1, JQuery的赋值 有问题

代码如下: data.username 表示的是: 网易

$("#use

- 经理怎么和员工搞好关系和信任

bijian1013

团队项目管理管理

产品经理应该有坚实的专业基础,这里的基础包括产品方向和产品策略的把握,包括设计,也包括对技术的理解和见识,对运营和市场的敏感,以及良好的沟通和协作能力。换言之,既然是产品经理,整个产品的方方面面都应该能摸得出门道。这也不懂那也不懂,如何让人信服?如何让自己懂?就是不断学习,不仅仅从书本中,更从平时和各种角色的沟通

- 如何为rich:tree不同类型节点设置右键菜单

sunjing

contextMenutreeRichfaces

组合使用target和targetSelector就可以啦,如下: <rich:tree id="ruleTree" value="#{treeAction.ruleTree}" var="node" nodeType="#{node.type}"

selectionChangeListener=&qu

- 【Redis二】Redis2.8.17搭建主从复制环境

bit1129

redis

开始使用Redis2.8.17

Redis第一篇在Redis2.4.5上搭建主从复制环境,对它的主从复制的工作机制,真正的惊呆了。不知道Redis2.8.17的主从复制机制是怎样的,Redis到了2.4.5这个版本,主从复制还做成那样,Impossible is nothing! 本篇把主从复制环境再搭一遍看看效果,这次在Unbuntu上用官方支持的版本。 Ubuntu上安装Red

- JSONObject转换JSON--将Date转换为指定格式

白糖_

JSONObject

项目中,经常会用JSONObject插件将JavaBean或List<JavaBean>转换为JSON格式的字符串,而JavaBean的属性有时候会有java.util.Date这个类型的时间对象,这时JSONObject默认会将Date属性转换成这样的格式:

{"nanos":0,"time":-27076233600000,

- JavaScript语言精粹读书笔记

braveCS

JavaScript

【经典用法】:

//①定义新方法

Function .prototype.method=function(name, func){

this.prototype[name]=func;

return this;

}

//②给Object增加一个create方法,这个方法创建一个使用原对

- 编程之美-找符合条件的整数 用字符串来表示大整数避免溢出

bylijinnan

编程之美

import java.util.LinkedList;

public class FindInteger {

/**

* 编程之美 找符合条件的整数 用字符串来表示大整数避免溢出

* 题目:任意给定一个正整数N,求一个最小的正整数M(M>1),使得N*M的十进制表示形式里只含有1和0

*

* 假设当前正在搜索由0,1组成的K位十进制数

- 读书笔记

chengxuyuancsdn

读书笔记

1、Struts访问资源

2、把静态参数传递给一个动作

3、<result>type属性

4、s:iterator、s:if c:forEach

5、StringBuilder和StringBuffer

6、spring配置拦截器

1、访问资源

(1)通过ServletActionContext对象和实现ServletContextAware,ServletReque

- [通讯与电力]光网城市建设的一些问题

comsci

问题

信号防护的问题,前面已经说过了,这里要说光网交换机与市电保障的关系

我们过去用的ADSL线路,因为是电话线,在小区和街道电力中断的情况下,只要在家里用笔记本电脑+蓄电池,连接ADSL,同样可以上网........

- oracle 空间RESUMABLE

daizj

oracle空间不足RESUMABLE错误挂起

空间RESUMABLE操作 转

Oracle从9i开始引入这个功能,当出现空间不足等相关的错误时,Oracle可以不是马上返回错误信息,并回滚当前的操作,而是将操作挂起,直到挂起时间超过RESUMABLE TIMEOUT,或者空间不足的错误被解决。

这一篇简单介绍空间RESUMABLE的例子。

第一次碰到这个特性是在一次安装9i数据库的过程中,在利用D

- 重构第一次写的线程池

dieslrae

线程池 python

最近没有什么学习欲望,修改之前的线程池的计划一直搁置,这几天比较闲,还是做了一次重构,由之前的2个类拆分为现在的4个类.

1、首先是工作线程类:TaskThread,此类为一个工作线程,用于完成一个工作任务,提供等待(wait),继续(proceed),绑定任务(bindTask)等方法

#!/usr/bin/env python

# -*- coding:utf8 -*-

- C语言学习六指针

dcj3sjt126com

c

初识指针,简单示例程序:

/*

指针就是地址,地址就是指针

地址就是内存单元的编号

指针变量是存放地址的变量

指针和指针变量是两个不同的概念

但是要注意: 通常我们叙述时会把指针变量简称为指针,实际它们含义并不一样

*/

# include <stdio.h>

int main(void)

{

int * p; // p是变量的名字, int *

- yii2 beforeSave afterSave beforeDelete

dcj3sjt126com

delete

public function afterSave($insert, $changedAttributes)

{

parent::afterSave($insert, $changedAttributes);

if($insert) {

//这里是新增数据

} else {

//这里是更新数据

}

}

- timertask

shuizhaosi888

timertask

java.util.Timer timer = new java.util.Timer(true);

// true 说明这个timer以daemon方式运行(优先级低,

// 程序结束timer也自动结束),注意,javax.swing

// 包中也有一个Timer类,如果import中用到swing包,

// 要注意名字的冲突。

TimerTask task = new

- Spring Security(13)——session管理

234390216

sessionSpring Security攻击保护超时

session管理

目录

1.1 检测session超时

1.2 concurrency-control

1.3 session 固定攻击保护

- 公司项目NODEJS实践0.3[ mongo / session ...]

逐行分析JS源代码

mongodbsessionnodejs

http://www.upopen.cn

一、前言

书接上回,我们搭建了WEB服务端路由、模板等功能,完成了register 通过ajax与后端的通信,今天主要完成数据与mongodb的存取,实现注册 / 登录 /

- pojo.vo.po.domain区别

LiaoJuncai

javaVOPOJOjavabeandomain

POJO = "Plain Old Java Object",是MartinFowler等发明的一个术语,用来表示普通的Java对象,不是JavaBean, EntityBean 或者 SessionBean。POJO不但当任何特殊的角色,也不实现任何特殊的Java框架的接口如,EJB, JDBC等等。

即POJO是一个简单的普通的Java对象,它包含业务逻辑

- Windows Error Code

OhMyCC

windows

0 操作成功完成.

1 功能错误.

2 系统找不到指定的文件.

3 系统找不到指定的路径.

4 系统无法打开文件.

5 拒绝访问.

6 句柄无效.

7 存储控制块被损坏.

8 存储空间不足, 无法处理此命令.

9 存储控制块地址无效.

10 环境错误.

11 试图加载格式错误的程序.

12 访问码无效.

13 数据无效.

14 存储器不足, 无法完成此操作.

15 系

- 在storm集群环境下发布Topology

roadrunners

集群stormtopologyspoutbolt

storm的topology设计和开发就略过了。本章主要来说说如何在storm的集群环境中,通过storm的管理命令来发布和管理集群中的topology。

1、打包

打包插件是使用maven提供的maven-shade-plugin,详细见maven-shade-plugin。

<plugin>

<groupId>org.apache.maven.

- 为什么不允许代码里出现“魔数”

tomcat_oracle

java

在一个新项目中,我最先做的事情之一,就是建立使用诸如Checkstyle和Findbugs之类工具的准则。目的是制定一些代码规范,以及避免通过静态代码分析就能够检测到的bug。 迟早会有人给出案例说这样太离谱了。其中的一个案例是Checkstyle的魔数检查。它会对任何没有定义常量就使用的数字字面量给出警告,除了-1、0、1和2。 很多开发者在这个检查方面都有问题,这可以从结果

- zoj 3511 Cake Robbery(线段树)

阿尔萨斯

线段树

题目链接:zoj 3511 Cake Robbery

题目大意:就是有一个N边形的蛋糕,切M刀,从中挑选一块边数最多的,保证没有两条边重叠。

解题思路:有多少个顶点即为有多少条边,所以直接按照切刀切掉点的个数排序,然后用线段树维护剩下的还有哪些点。

#include <cstdio>

#include <cstring>

#include <vector&

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()