有关深度估计的几篇文章的阅读笔记

一、A generalized Depth Eestimation Algorithm with a Single Image 一种基于单一图像的广义深度估计算法(TPAMI,1992)

1. 边读边记

深度估计对于场景估计、物体识别等计算机视觉方向有重要作用;

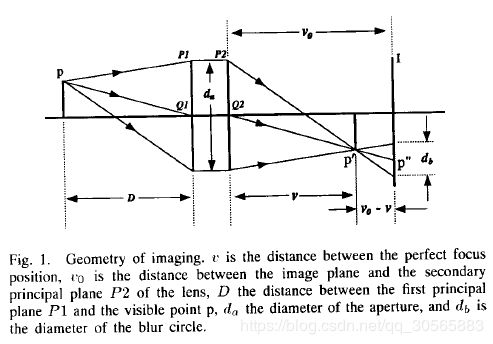

严格来说,深度是指物体表面到薄凸透镜的第一主平面的距离;

实体视觉(stereopsis)方法是比较流行的方法,该方法基于测量双目视差(binocular disparity),然后用三角测量(triangulation)方法修复3D结构,然后用特征提取和匹配来衡量差异性。对应过程是该方法最复杂的部分。

最近有一种基于摄像机焦距(camera focus)的新方法[引文9],称为DFF法(Ddistance From Focus),用散焦或模糊的数量来估计距离。该方法只需要一张图就可以重构深度信息,并且不需要特征对应(feature correspondence)过程。引文9认为模糊的边(blurred edge)是由正常聚焦的边与可以近似为2D高斯分布G(r, σ)的点扩散函数(point spread function)卷积成的。空间常数σ与深度直接有关,深度由散焦(defocus)数量决定。具体分析在引文9和11. 单一点光源在散焦图像上的点扩散函数取决于光的波长和透镜系统的特性。分析认为对于白色光,不同波长的光所获得的点扩散函数之和具有这个2D高斯分布的一般形式。

文献12把点扩散函数推广到旋转对称(rotationally moment)形式,采用二阶中心矩做参数σ,用一种近似形式来估计深度。

以上两种方法都用二阶变异(second-order differentiation operation)来估计σ,但是二阶变异对噪声很敏感,本文提出一种广义算法,把σ分解为σx和σy,因此也不再需要边缘取向(edge orientation)。

当一个点不在凸透镜的焦点上的时候,它在成像平面上成的像就是一个模糊的圈,称为模糊圈(blur circle)。实际的模糊点的个数还要取决于透镜系统和该点距离实际焦点的距离。

透镜公式告诉我们: F − 1 = D − 1 + v − 1 F^{-1}=D^{-1}+v^{-1} F−1=D−1+v−1

其中 F F F是透镜的焦距。

经过一些转化和加入高斯分布,得到了文章中公式(3)的形式。D为深度,D的估计方法在Section II的最后一段。

文章认为观测到的图像(observed unfocused image)f(a,b)是由聚焦图像(well-focused image)I(x,y)与高斯函数G(x,y,σ)卷积得到的,即公式(4)。经过一系列转化,σ分解为x方向和y方向,得到Section IV的前两个公式,这就是本文的最终优化目标。

文章最终用牛顿法求解。由于优化目标不算凸优化,因此使用观测到的图像作为g1和g2的初始值。

大体如此,求解和一部分推导没完全看懂。

2. 好词好句

rigorously speaking 严格来讲

the novelty of … is ···的新奇之处是

the validity of 正确性

let us assume that 让我们假设

with respect to 关于,至于

convergence property 收敛性

take a coarse search 做一个粗搜索

二、Depth Estimation from Image Structure 从图像结构中估计深度(TPAMI,2002)

1. 边读边记

如果没有绝对的深度度量线索,如双目视差、移动(motion)、散焦(defocus),从观测者到场景的距离就无法得知。色差、边缘、连接可能提供场景的3D模型,却无法提供尺度。一种可能的绝对深度信息渠道是已知物体的投影尺度(image size)。然而这又带来了识别问题,也比较难做。本文提出了一种基于整体场景结构的深度估计方法,不依赖于特定物体。

文章认为,空间结构、场景中主要物体的尺度和位置会随着到观测者的距离的变化而变化,而且这种变化是常规的可预测的。通过识别图像中表现出来的结构,这种结构性的规律稳定到可以用来估计场景的平均深度。

多数深度信息修复技术关注的是相对深度,如从阴影(shading)、纹理变化、边界和交合、对称图像、分形维度(fractal dimension)来塑性(shape),或者从其他的图形提示,例如闭合(occlusions)、相对尺度、相对地平线的海拔等等。这些方法应用场景有限。

绝对(absolute)深度估计相关研究也很多,大多依赖于有限信息源,如双目视觉、移动视差、散焦等等。

然而在普通视觉下也应该能估计深度信息。有一种信息可以利用,是熟悉物体的尺度,如脸,身体,车辆等等。然而这要求在非约束条件下做图像分割,难做且不可靠。

本文为绝对深度估计提供了一种新的信息源:全局图像结构。这种信息不需要多目视觉或图像分割。

文章扯了很多局部/全局傅里叶/谱,很冗长。前面的introduction算是看懂了一些东西。从全局图和局部图出发做场景的平均深度估计,又分为人工场景和自然场景,主要是基于EM算法做估计。

2. 好词好句

we demonstrate that 我们论证/证明了

infer 推论

illustrate 阐述

remains still difficult and unreliable 仍然很难且不可信

it is acknowledged that 公认

our objective is to 我们的目标是

三、Unsupervised Monocular Depth Estimation with Left-Right Consistency 基于左右一致性的单目无监督深度估计(CVPR, 2017)

1. 边读边记

本文提出了一种新的训练目标,使得CNN能够估计深度值,尽管没有真实的深度值。通过探索极线约束和图像重构损失,用网络获取了不一致图像。提出了一种新的损失函数。

在运动结构(structure from motion)、X光成像、双目和多视角立体系统(multi-view stereo)等方面已经有了丰硕成果,然而他们多假设场景中可以获取多个视角的数据。为了解决这个问题,提出了很多有监督的单目深度估计方法,使用ground truth depth data做线下训练。但是这些方法的应用局限于可以大规模获取像素级别深度值对应的场景中。

深度估计的应用,文章列举了很多。

文章的网络是用合成深度来训练的,只是不需要ground truth深度。已有的类似方法要么输出图像分辨率不够,要么效果不够好。

对于左右两个视角,文章提出求解一个dl和dr,分别用于右侧视角和左侧视角重构彼此,其中d指的是图像差异,是模型需要预测的精确到像素的一个标量。

通过推论左侧视角如何卷曲到右侧,文章的网络预测了深度。

测试时,网络在最佳尺度上预测视角差异性,要求与输入图像分辨率相同。然后用已知的摄像机baseline和距离训练集的焦点长度,可以把差异图转化为深度图。

构建的新损失函数没细看,大致是分三部分,一部分encourage重构图像与对应输入趋于相似,一部分enforce流畅的差异图,一部分perfer左右差异图具有一致性。

这篇会议文章读起来比较顺畅,没有太多拐弯抹角。而且给出了代码和演示视频,以后可以好好参考对照。

2. 好词好句

promising 有前途的,有前景的

despite the absence of 尽管没有…

ground truth depth data 真实的深度值

fruitful approaches have relied on 基于…的方法成果丰硕

these can come in the form of … 可能是…的形式

a surge in …方面的突飞猛进