ELK日志分析平台——logstash数据采集(本地数据收集、远程ES节点数据收集、数据收集时的优化)

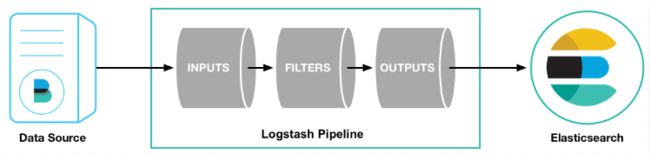

1.什么是logstash?

Logstash是一个开源的服务器端数据处理管道。

logstash拥有200多个插件,能够同时从多个来源采集数据,转换数据,然后将数据发送到您最喜欢的 “存储库” 中。(大多都是 Elasticsearch。)

Logstash管道有两个必需的元素,输入和输出,以及一个可选元素过滤器。

2.logstash中的元素介绍

输入:采集各种样式、大小和来源的数据

Logstash 支持各种输入选择 ,同时从众多常用来源捕捉事件。

能够以连续的流式传输方式,轻松地从您的日志、指标、Web 应用、数据存储以及各种 AWS 服务采集数据。

过滤器:实时解析和转换数据

数据从源传输到存储库的过程中,Logstash 过滤器能够解析各个事件,识别已命名的字段以构建结构,并将它们转换成通用格式,以便更轻松、更快速地分析和实现商业价值。

利用 Grok 从非结构化数据中派生出结构

从 IP 地址破译出地理坐标

将 PII 数据匿名化,完全排除敏感字段

简化整体处理,不受数据源、格式或架构的影响

输出:选择您的存储库,导出您的数据

尽管 Elasticsearch 是我们的首选输出方向,能够为我们的搜索和分析带来无限可能,但它并非唯一选择。

Logstash 提供众多输出选择,您可以将数据发送到您要指定的地方,并且能够灵活地解锁众多下游用例。

3.Logstash安装与配置

3.1 安装logstash

在server4上安装配置logstash

(1)获取logstash软件包

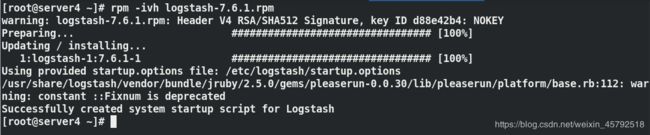

(2)logstash安装

rpm -ivh jdk-8u181-linux-x64.rpm ##安装java语言软件包

rpm -ivh logstash-7.6.1.rpm ##安装logstash

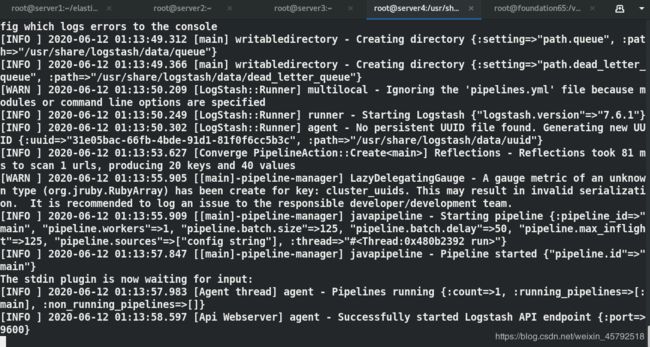

/usr/share/logstash/bin/logstash -e 'input { stdin { } } output { stdout {} }'

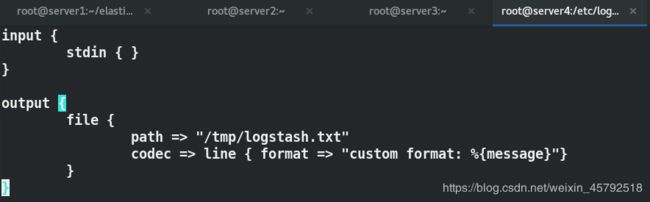

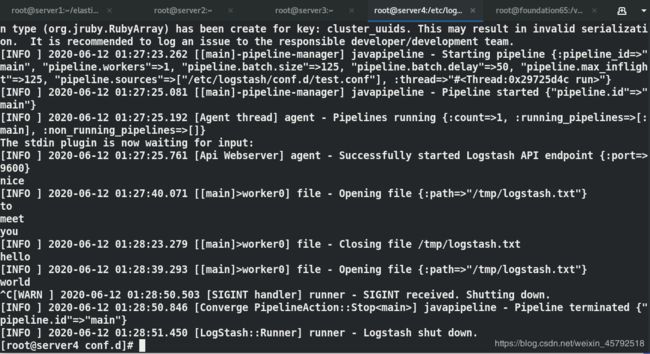

3.2 配置file输出插件

标准输入到文件

vim /etc/logstash/conf.d/test.conf

input {

stdin { }

}

output {

file {

path => "/tmp/logstash.txt" #输出的文件路径,把录入的数据保存到指定文件中

codec => line { format => "custom format: %{message}"} ##指定存的数据格式是什么,%{message}表示你在终端下输的任何数据

}

}

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/test.conf

![]()

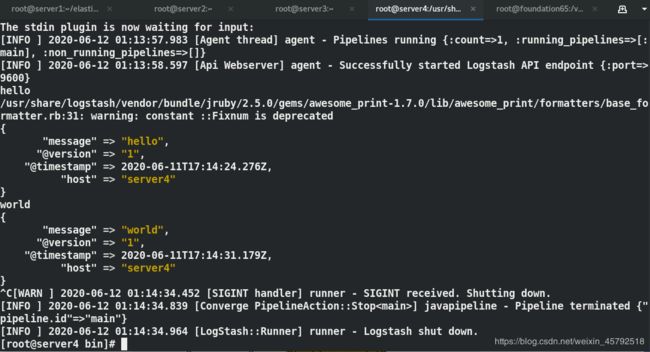

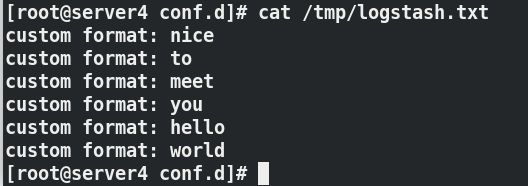

在标准输入中键入信息后查看

可以在指定的路径中查看到输入的内容

cat /tmp/logstash.txt

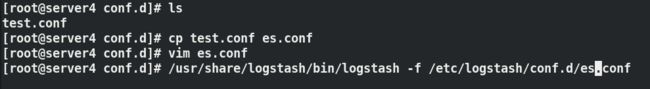

3.3 配置elasticsearch输出插件

标准输入到es主机:

vim /etc/logstash/conf.d/es.conf

input {

stdin { }

}

output {

elasticsearch {

hosts => "172.25.12.1:9200" ##输出到ES主机与端口

index => "logstash-%{+YYYY.MM.dd}" ##指定索引名称,索引每天创建一份,因为它调用的是变量

}

}

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf ##指定配置文件运行

测试:在终端输入两条信息

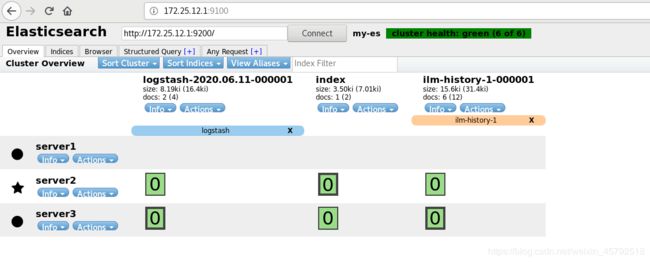

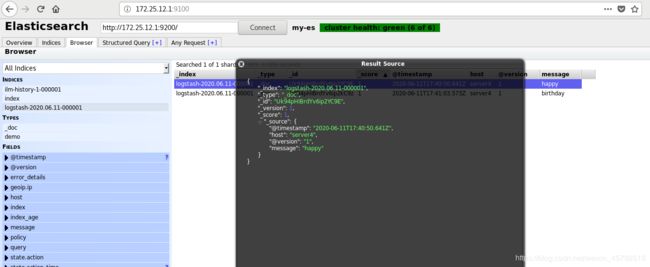

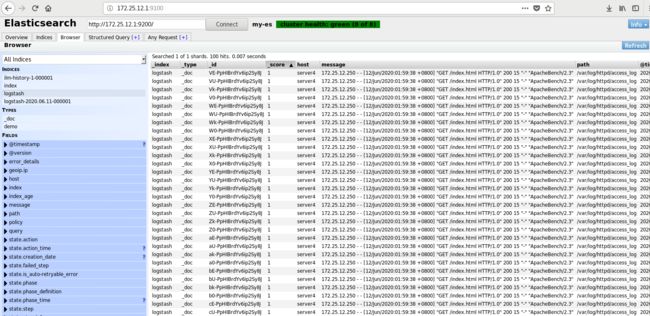

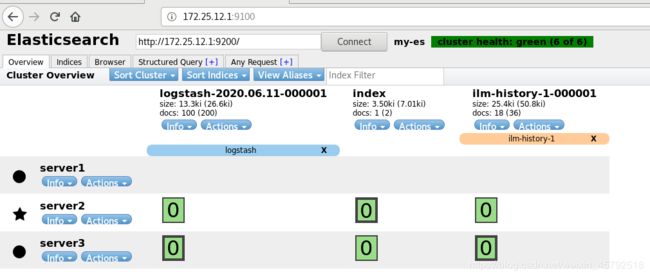

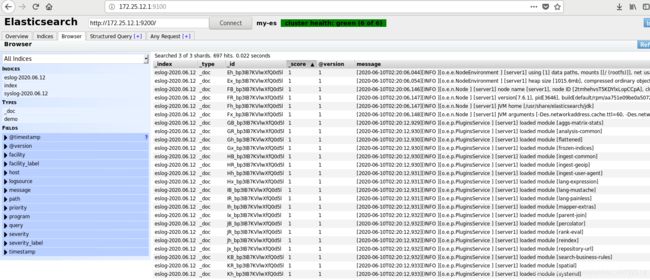

查看ES主机:可以查看到刚才输入的信息

在logstash主机上安装httpd服务,并开启,配置默认发布页信息

![]()

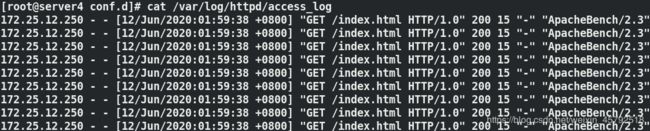

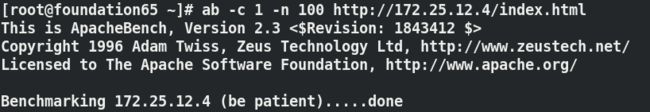

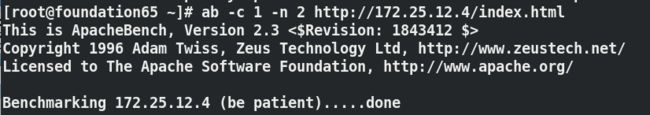

在外部物理机上做压力测试

ab -c 1 -n 100 http://172.25.12.4/index.html

在logstash主机查看日志,可以看到来自物理机的访问日志信息

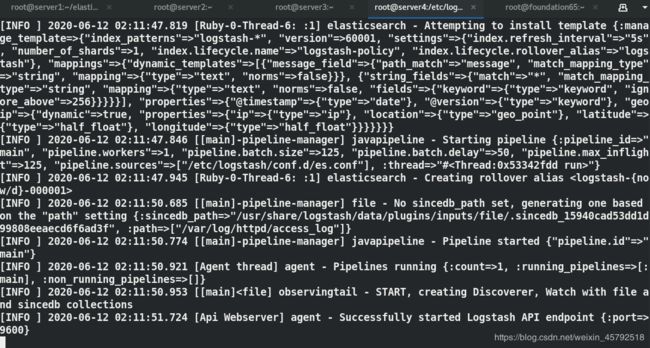

更改输入到es主机的配置文件,将路径更改为/var/log/httpd/access_log,指定配置文件运行

![]()

查看ES主机:可以看到100条访问记录已经被采集到了es主机上

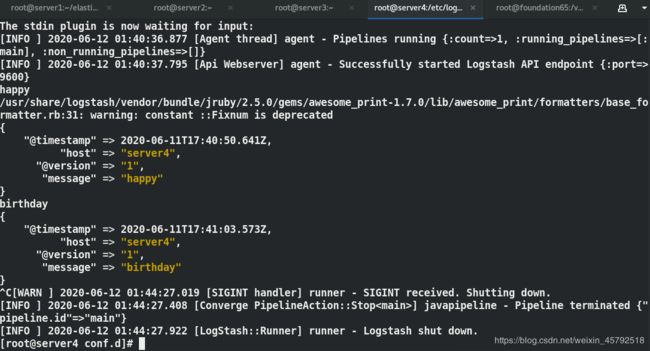

这里有一个问题,在我们编辑es配置文件后,指定配置文件运行时,运行成功,将不再加载信息,一直卡在那

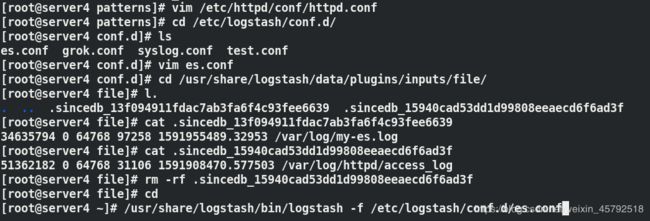

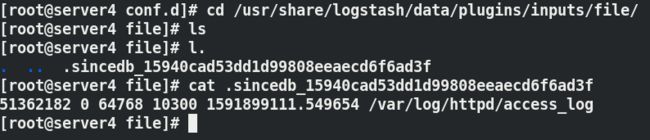

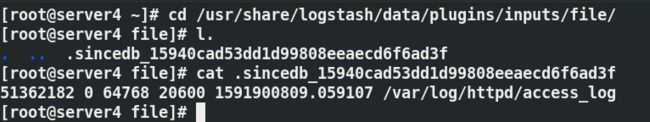

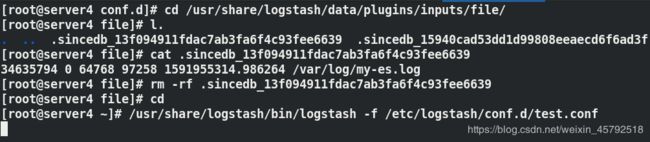

logstash会把文件的读取进程保存到sincedb文件中,这样的话它下次启动时,依然会先从sincedb文件中加载,sincedb中保留的是上次加载的位置上,它并没有从这个文件的开头再录入一遍

![]()

sincedb文件是为了保证你不会重复加载文件里面的数据而导致数据冗余

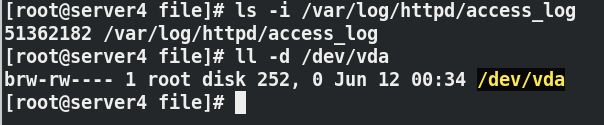

logstash如何区分设备、文件名、文件的不同版本

ls -i /var/log/httpd/access_log

sincedb文件内容解释

# cat .sincedb_452905a167cf4509fd08acb964fdb20c

20297 0 64768 119226 1551859343.6468308 /var/log/messages

sincedb文件一共6个字段

inode编号

文件系统的主要设备号

文件系统的次要设备号

文件中的当前字节偏移量

最后一个活动时间戳(浮点数)

与此记录匹配的最后一个已知路径

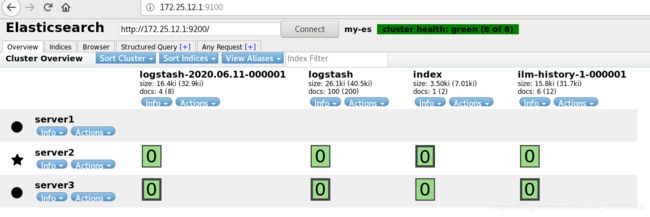

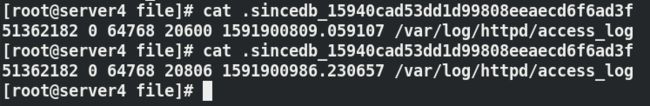

删除之前的sincedb文件,指定配置文件运行

![]()

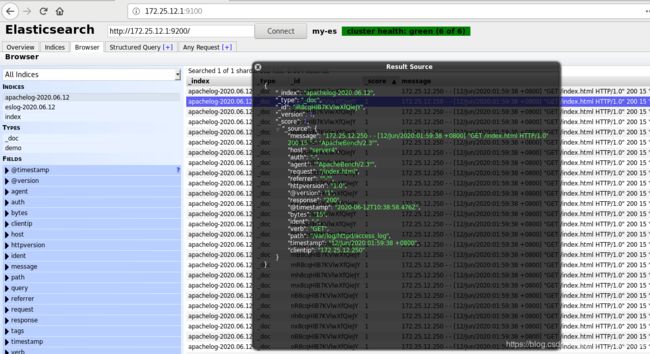

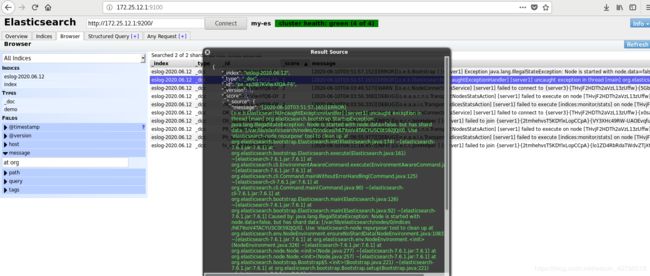

查看ES主机

验证文件偏移量:

200条信息时

文件偏移数值从20600到20806

压力测试访问:两次

查看ES主机:202条信息

3.4 配置Syslog输入插件

将多个节点的日志汇聚到server4(logstash)上,不用在ES节点上安装logstash

logstash可以伪装成日志服务器,直接接受远程日志

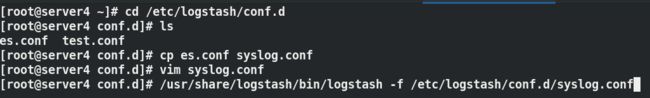

(1)编辑syslog.conf文件

vim /etc/logstash/conf.d/syslog.conf

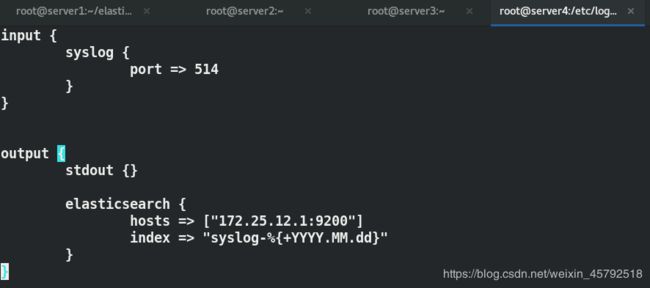

input {

syslog {

type => "rsyslog"

port => 514 ##日志收集端口

}

}

output {

stdout { }

elasticsearch {

hosts => ["172.25.12.1:9200"]

index => "syslog-%{+YYYY.MM.dd}"

}

}

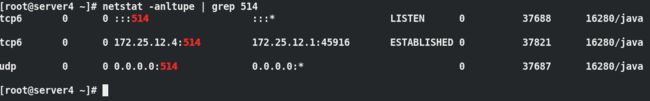

日志收集端口514,用来收集ES节点上的日志

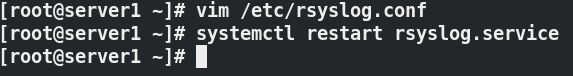

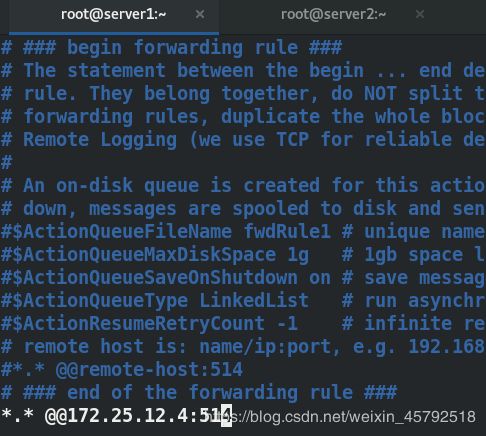

(2)配置客户端(ES节点)传入日志

vim /etc/rsyslog.conf

*.* @@172.25.12.4:514

systemctl restart rsyslog

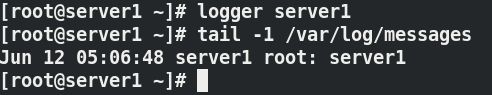

logger server1 ##产生日志信息

logger这个动作只会把日志记录在本地/var/log/messages

但是我们在/etc/rsyslog.conf中配置到把这个信息也给发送到远程主机上去

在server4终端查看,可以看到刚才产生的日志信息(直接同步)

(3)在配置一个客户端(ES节点)传入日志

在server4终端查看,可以看到server2节点信息

3.5 配置多行过滤插件

多行过滤可以把多行日志记录合并为一行事件

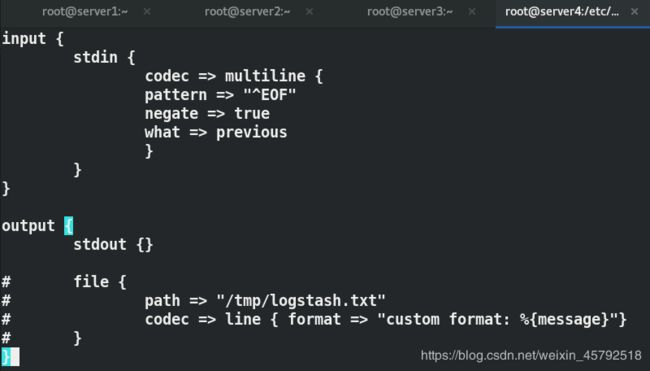

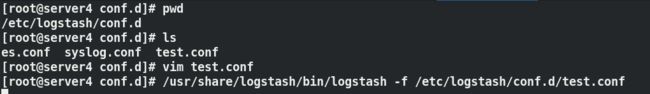

编辑test.conf文件

vim /etc/logstash/conf.d/test.conf

input {

stdin {

codec => multiline {

pattern => "^EOF"

negate => true

what => previous

}

}

}

output {

stdout {}

}

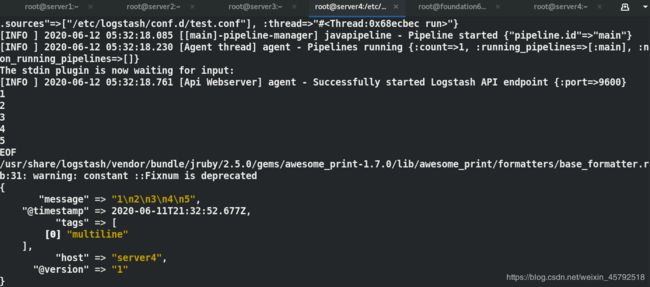

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/test.conf ##指定配置文件运行

查看输出:将一个日志事件记录多行,整合到一行

当出现标志符EOF出现,一个事件记录完毕

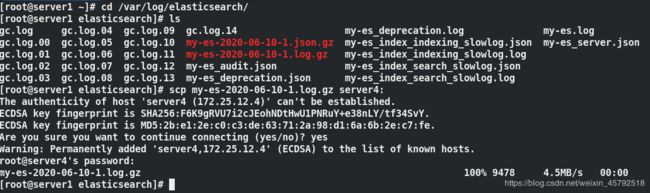

server1上的日志已经给我们打包了,将这个日志包发给server4,解压查看,可以看到一个事件被记录多行信息

将这个日志文件放到/var/log/my-es.log下进行信息优化整合

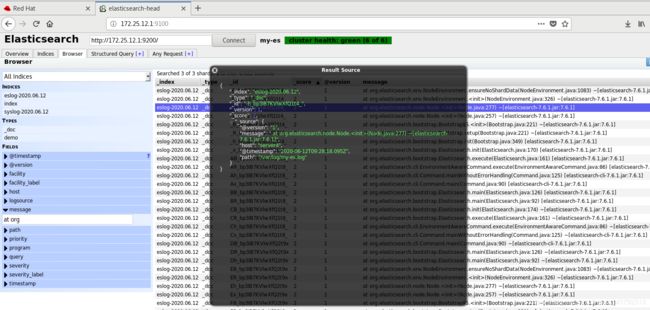

可以看到有很多at org信息,同属一个事件,却单独占一行

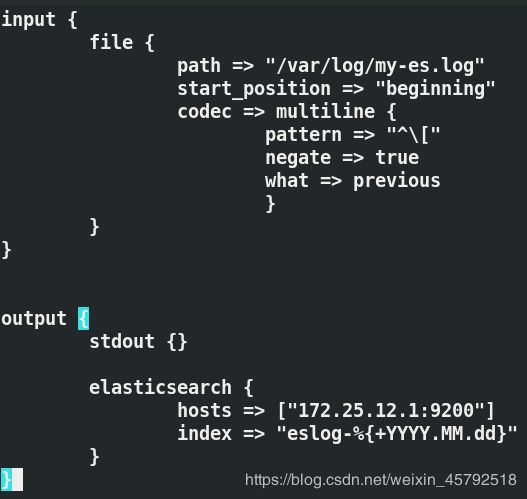

修改test.conf配置文件,以 [ 开头的行为一行

上边没有加载出信息是因为sincedb文件,我们删除sincedb文件重新执行运行指令即可

多行过滤之前的信息条目是688,过滤后变为453,可以看到at org 信息条目都归属在它所对应的事件中去了,不再单独占一行,一个信息条目了

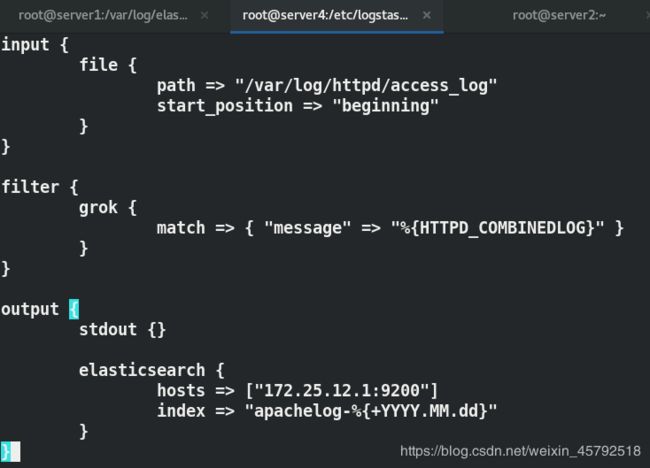

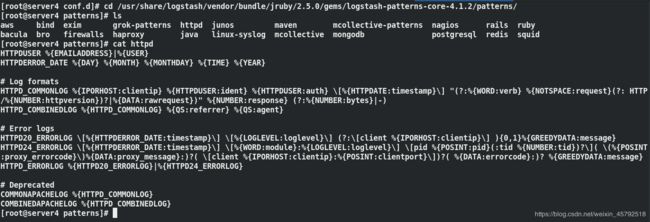

3.6 配置grok过滤插件

grok过滤:

当logstsh输出数据时,不直接放入ES中,而是放到redis,数据到达redis后,我们可以通过熟悉的语言交互redis做处理,然后放入ES中

Grok适合对syslog日志、apache等web服务器日志、mysql日志以及其他任何供人阅读的日志格式。Grok是通过文本模式对日志进行结构化处理的,它预设了超过120种文本模式,用户也能根据自己的需要进行调整或增加。

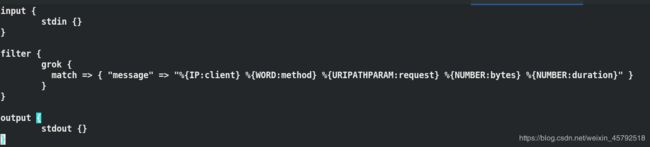

(1)编辑grok.conf文件

vim /etc/logstash/conf.d/grok.conf

input {

stdin {}

}

filter {

grok {

match => { "message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}" }

}

}

output {

stdout {}

}

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/grok.conf ##指定配置文件运行

55.3.244.1 GET /index.html 15824 0.043

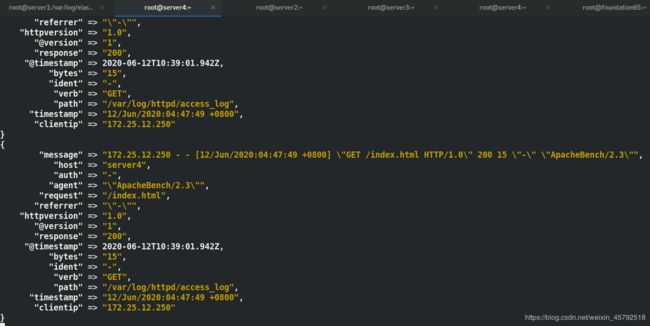

可以看到数据信息按照grok.conf文件里所设置的格式进行输出

apache服务日志过滤实战

常用服务的日志一般都有格式,可以参考它来做

vim /etc/logstash/conf.d/es.conf

input {

file {

path => "/var/log/httpd/access_log"

start_position => "beginning"

}

}

filter{

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" }

}

}

output {

elasticsearch {

hosts => "172.25.12.1:9200"

index => "apachelog-%{+YYYY.MM.dd}"

}

}

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf ##指定配置文件运行