- python模块triton安装教程

2401_85863780

1024程序员节tritonwhl

Triton是一个用于高性能计算的开源库,特别适用于深度学习和科学计算。通过预编译的whl文件安装Triton可以简化安装过程,尤其是在编译时可能会遇到依赖问题的情况下。以下是详细的安装步骤:安装前准备:Python环境:确保已经安装了Python,并且Python版本与whl文件兼容。pip:确保已经安装了pip,这是Python的包管理器,用来安装外部库。下载whl文件:从可靠的来源下载适用于

- 【机器学习】逻辑回归(LogisticRegression)原理与实战

GentleCP

机器学习(深度学习)逻辑回归logisticregression原理与实战机器学习

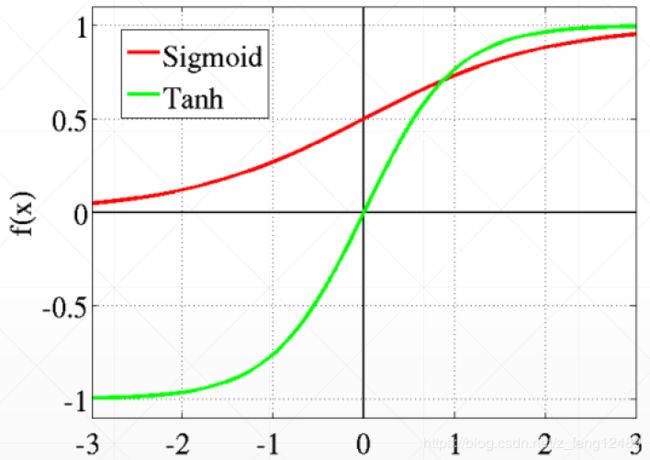

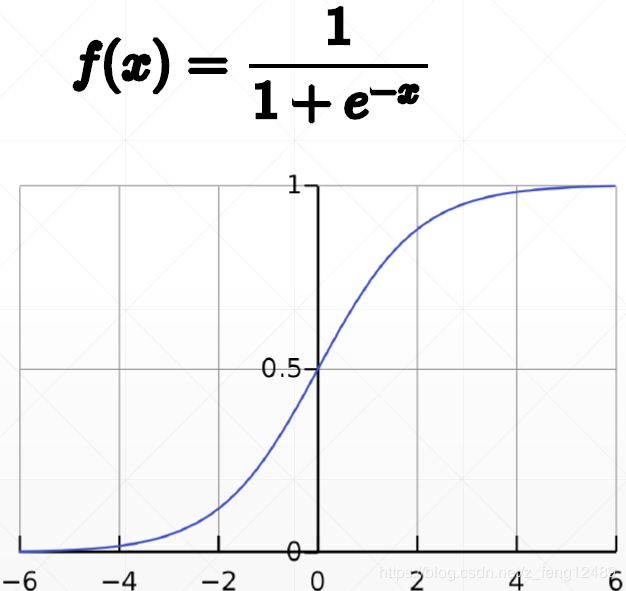

文章目录前言一、什么是逻辑回归1.1逻辑回归基础概念1.2逻辑回归核心概念二、逻辑回归Demo2.1数据准备2.2创建逻辑回归分类器2.3分类器预测三、逻辑回归实战3.1数据准备3.2数据划分与模型创建3.3预测数据评估模型四、参数选择五、总结六、参考资料本文属于我的机器学习/深度学习系列文章,点此查看系列文章目录前言本文主要通过文字和代码样例讲述逻辑回归的原理(包含逻辑回归的基础概念与推导)和实

- 磨人小妖精-tensorflow之removed in a future version

凯旋的铁铁

磨人的小妖精pythontensorflow

TensorFlow1.14版本TensorFlow使用五个不同级别的日志消息。按照上升的顺序,它们是DEBUG,INFO,WARN,ERROR和FATAL。当您在任何这些级别配置日志记录时,TensorFlow将输出与该级别相对应的所有日志消息以及所有级别的严重级别。例如,如果设置了ERROR的日志记录级别,则会收到包含ERROR和FATAL消息的日志输出,如果设置了一个DEBUG级别,则会从所

- 《深度Q网络优化:突破高维连续状态空间的束缚》

人工智能深度学习

在人工智能的发展历程中,深度Q网络(DQN)作为强化学习与深度学习融合的关键成果,为解决复杂决策问题开辟了新路径。但当面对高维连续状态空间时,DQN会出现训练不稳定、收敛速度慢等问题,严重限制了其应用范围。如何优化DQN以适应高维连续状态空间,成为当下研究的热点。深度Q网络基础回顾深度Q网络结合了深度学习强大的特征提取能力与Q学习的决策优化思想。在传统强化学习中,Q学习通过Q表记录每个状态-动作对

- 智享AI直播三代系统,开启「机器人比人更会带货」时代!

缘分开始t621238

人工智能机器人

智享AI直播三代系统,开启「机器人比人更会带货」时代!在当今数字化浪潮汹涌的时代,直播行业作为电商领域的重要驱动力,正经历着前所未有的变革。近日,智享AI直播三代系统的横空出世,宛如一颗重磅炸弹,在直播行业掀起了惊涛骇浪,正式开启了「机器人比人更会带货」的全新时代。一、技术革新,颠覆传统直播模式智享AI直播三代系统的诞生,标志着直播行业进入了智能化的新纪元。它融合了先进的人工智能技术,包括深度学习

- 自学黑客(网络安全),一般人我劝你还是算了吧

网安周星星

web安全安全windows网络网络安全

基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包文章讲述了自学网络安全时常见的误区,如先学编程、过度追求深度学习以及收集过多资料,并提供了前期学习的硬件、软件选择建议,强调了基础编程知识和英文能力的重要性。文中给出了详细的学习路线,包括基础操作入门、实战操作以及参加CTF和HVV等竞赛来提升技能,并推荐了一系列相关书籍和学习资源。一、自学网络安全学习的误区和陷阱1.不要试图先成为一

- DQN的原理和代码实现

SmallerFL

NLP&机器学习DQN强化学习深度学习

文章目录1.概述2.DQN的训练步骤2.1初始化2.2训练循环2.3终止条件2.4评估3.代码示例1.概述深度Q网络(DeepQ-Network,DQN)是强化学习中的一种重要算法,由GoogleDeepMind于2013年提出。DQN结合了Q学习和深度学习,通过使用神经网络来近似Q值函数,解决了传统Q学习在高维状态空间中的问题。2.DQN的训练步骤2.1初始化环境:定义环境(例如,Atari游戏

- 深度学习基础知识

namelijink

深度学习人工智能

cuda简介:CUDA(ComputeUnifiedDeviceArchitecture)是由NVIDIA开发的一种并行计算平台和应用程序编程接口(API)。它允许开发人员利用NVIDIA的GPU(图形处理器)来加速各种计算任务,包括科学计算、机器学习、深度学习、数据分析等。NVIDIA是一个全球领先的计算技术公司,专注于设计和制造高性能计算设备。除了生产强大的GPU,NVIDIA还提供与其GPU

- 【python语言应用】最新全流程Python编程、机器学习与深度学习实践技术应用(帮助你快速了解和入门 Python)

赵钰老师

python机器学习深度学习python机器学习深度学习数据分析人工智能

近年来,人工智能领域的飞速发展极大地改变了各个行业的面貌。当前最新的技术动态,如大型语言模型和深度学习技术的发展,展示了深度学习和机器学习技术的强大潜力,成为推动创新和提升竞争力的关键。特别是PyTorch,凭借其灵活性和高效性,成为科研人员和工程师的首选工具。理解和掌握深度学习的基础知识,深入了解其与经典机器学习算法的区别与联系,并系统掌握包括迁移学习、循环神经网络(RNN)、长短时记忆网络(L

- 【Python深入浅出㊸】解锁Python3中的TensorFlow:开启深度学习之旅

奔跑吧邓邓子

Python深入浅出python深度学习tensorflow

目录一、TensorFlow简介1.1定义与背景1.2特点二、Python3与TensorFlow的关系2.1版本对应2.2为何选择Python3三、安装TensorFlow3.1安装步骤3.2验证安装四、TensorFlow基本概念与使用方法4.1计算图(Graph)4.2会话(Session)4.3张量(Tensor)4.4变量(Variable)4.5占位符(Placeholder)五、Te

- keras实现TCN网络层

谦虚且进步

深度学习预测keras人工智能深度学习

keras实现TCN网络层,keras3.0可用。fromkeras.layersimportLambda,Dense,Layer,Conv1DimporttensorflowastfclassTCNCell(Layer):"""sumary_line:Chinese:让输入的时间序列[bs,seql,dim]提升kernel_size倍的感受野English:Doublethereceptive

- 【Java】已解决:java.util.concurrent.ExecutionException

屿小夏

java开发语言android

个人简介:某不知名博主,致力于全栈领域的优质博客分享|用最优质的内容带来最舒适的阅读体验!文末获取免费IT学习资料!文末获取更多信息精彩专栏推荐订阅收藏专栏系列直达链接相关介绍书籍分享点我跳转书籍作为获取知识的重要途径,对于IT从业者来说更是不可或缺的资源。不定期更新IT图书,并在评论区抽取随机粉丝,书籍免费包邮到家AI前沿点我跳转探讨人工智能技术领域的最新发展和创新,涵盖机器学习、深度学习、自然

- c++加载TensorRT调用深度学习模型方法

feibaoqq

深度学习深度学习YOLO

使用TensorRT来调用训练好的模型并输出结果是一个高效的推理过程,特别是在需要低延迟和高吞吐量的应用场景中。以下是一个基本的步骤指南,展示了如何在C++中使用TensorRT进行推理。步骤1:准备环境安装TensorRT:确保你已经安装了NVIDIATensorRT库。准备模型:确保你的训练好的模型已经转换为TensorRT支持的格式,通常是一个.engine文件。你可以使用onnx-tens

- 点云从入门到精通技术详解100篇-基于 CBCT 与口内扫描数据的牙齿点云配准

格图素书

深度学习计算机视觉数学建模人工智能

目录前言国内外研究现状传统牙齿配准点云配准2牙齿数据的深度学习点云配准基础2.1牙齿数据获取方法2.1.1口腔印模2.1.2辐射成像2.1.3口内扫描2.2深度学习网络2.2.1全连接神经网络2.2.2卷积神经网络2.2.3孪生神经网络2.3点云数据配准基础2.3.1点云数据格式2.3.2点云旋转表达2.3.3传统点云配准方法3基于PCRNet的PCR-SA牙齿点云配准3.1CBCT-IOS牙齿配

- Python深度学习代做目标检测NLP计算机视觉强化学习

matlabgoodboy

计算机视觉python深度学习

了解您的需求,您似乎在寻找关于Python深度学习领域的代做服务,特别是在目标检测、自然语言处理(NLP)、计算机视觉以及强化学习方面。以下是一些关于这些领域的概述以及寻找相关服务的建议。1.Python深度学习代做概述目标检测:目标检测是计算机视觉中的一个重要任务,旨在识别图像或视频中的特定对象,并确定它们的位置。Python中的深度学习框架(如TensorFlow、PyTorch)和计算机视觉

- 基于深度学习YOLOv5的活体人脸检测系统(Python+PySide6界面+训练代码)

深度学习&目标检测实战项目

深度学习YOLOpython人工智能目标跟踪计算机视觉开发语言

一、前言随着人工智能技术的快速发展,计算机视觉(ComputerVision)已广泛应用于各种实际场景中,特别是在安全、金融、医疗等领域。人脸识别作为计算机视觉的一个重要应用,已经成为很多身份验证、安防监控、智能门禁等系统的核心技术。近年来,随着深度学习的突破,YOLO(YouOnlyLookOnce)系列算法因其高效、准确、实时的特点,广泛应用于物体检测任务。在实际的人脸识别应用中,活体人脸检测

- 【深度学习】计算机视觉(CV)-目标检测-SSD(Single Shot MultiBox Detector)—— 单次检测多框检测器

IT古董

深度学习人工智能计算机视觉深度学习目标检测

SSD(SingleShotMultiBoxDetector)——单次检测多框检测器1️⃣什么是SSD?SSD(SingleShotMultiBoxDetector)是一种用于目标检测(ObjectDetection)的深度学习模型,由WeiLiu等人在2016年提出。它采用单阶段(SingleStage)方法,能够直接从图像中检测多个对象,并输出类别和边界框,比传统的两阶段方法(如FasterR

- 【深度学习】YOLO-World: Real-Time Open-Vocabulary Object Detection,目标检测

XD742971636

深度学习机器学习深度学习YOLO目标检测

介绍一个酷炫的目标检测方式:论文:https://arxiv.org/abs/2401.17270代码:https://github.com/AILab-CVC/YOLO-World文章目录摘要Introduction第2章相关工作2.1传统目标检测2.2开放词汇目标检测第3章方法3.1预训练公式:区域-文本对3.2模型架构3.3可重参数化的视觉-语言路径聚合网络(RepVL-PAN)3.4预训练

- PyTorch入门实战:从零搭建你的第一个神经网络

不打滑的西瓜皮

机器学习深度学习人工智能神经网络pythonpytorchpycharm

目录一、PyTorch简介:为什么选择它?二、环境搭建:5分钟快速安装三、核心概念:张量与自动求导1.张量(Tensor):深度学习的数据基石2.自动求导(Autograd):神经网络训练的核心四、实战:手写数字识别(MNIST)1.数据集加载与预处理2.构建卷积神经网络(CNN)3.训练与评估五、下一步学习建议一、PyTorch简介:为什么选择它?PyTorch是当前最热门的深度学习框架之一,由

- 关于pip Install与conda install

ClaNNEd@

DeepLearningpipconda

conda解决依赖的问题很弱,环境包多了以后经常要解决依赖几分钟到十几分钟。我个人感觉比较好的实践是conda创建虚拟环境,装torch/tensorflow等比较难装的包,基础环境配好以后,后面装包一律用pip。conda,pip,anaconda,miniconda的区别网页https://www.quora.com/What-is-the-comparison-among-conda-vs-

- 超火的Deepseek的MOE架构是什么?

魔王阿卡纳兹

大模型知识札记架构DeepSeekMoE大模型

DeepSeek的MOE(MixtureofExperts,混合专家)架构是一种基于专家模型(MixtureofExperts)的深度学习框架,旨在通过动态选择和激活部分专家模块来提高计算效率和模型性能。以下是对其核心特点和工作原理的详细介绍:1.核心概念与架构MOE架构的基本思想是将模型划分为多个“专家”模块,每个专家专注于处理特定类型的任务或数据特征。在推理时,通过门控机制(GatingMec

- 使用神经架构搜索(Neural Architecture Search, NAS)自动化设计高效深度学习模型的技术详解

瑕疵

热点资讯

博客主页:瑕疵的CSDN主页Gitee主页:瑕疵的gitee主页⏩文章专栏:《热点资讯》使用神经架构搜索(NeuralArchitectureSearch,NAS)自动化设计高效深度学习模型的技术详解使用神经架构搜索(NeuralArchitectureSearch,NAS)自动化设计高效深度学习模型的技术详解使用神经架构搜索(NeuralArchitectureSearch,NAS)自动化设计高

- 目标检测代码示例(基于Python和OpenCV)

matlab_python22

计算机视觉

引言目标检测是计算机视觉领域中的一个核心任务,其目标是在图像或视频中定位和识别特定对象。随着技术的发展,目标检测算法不断演进,从传统的基于手工特征的方法到现代的深度学习方法,再到基于Transformer的架构,目标检测技术已经取得了显著的进步。本文将总结和对比几种主要的目标检测算法,探讨它们的优势、劣势和适用场景。1.目标检测算法分类1.1单阶段检测(One-Stage)与双阶段检测(Two-S

- 基于深度学习YOLOv8的海洋动物检测系统(Python+PySide6界面+训练代码)

深度学习&目标检测实战项目

深度学习YOLOpython目标检测人工智能开发语言

引言近年来,计算机视觉技术在各行各业中得到了广泛的应用,特别是在智能监控、自动驾驶、医疗诊断等领域。深度学习,尤其是卷积神经网络(CNN)的出现,极大地提高了计算机处理图像和视频的能力。在这一领域,YOLO(YouOnlyLookOnce)系列模型以其高效且准确的目标检测能力,成为了当下最为流行的深度学习模型之一。在海洋生物保护、海洋环境监测等应用中,快速识别和检测海洋动物种类对于科学研究和保护工

- 基于YOLOv5深度学习的木材表面缺陷检测系统:UI界面 + YOLOv5 + 数据集详细教程

深度学习&目标检测实战项目

YOLO深度学习uiYOLOv5人工智能计算机视觉

随着工业自动化的发展,木材加工行业对产品质量的要求日益提高。木材表面缺陷的检测是确保产品质量的重要环节。传统的人工检测方式不仅费时费力,而且容易受到人为因素的影响。基于深度学习的目标检测技术,尤其是YOLOv5,凭借其优越的实时性和准确性,成为木材表面缺陷检测的有效工具。本博客将详细介绍如何构建一个基于YOLOv5的木材表面缺陷检测系统,包括数据集准备、模型训练、UI界面开发及完整代码实现。目录目

- 动手学深度学习笔记|3.2线性回归的从零开始实现(附课后习题答案)

lusterku

动手学深度学习深度学习笔记线性回归

动手学深度学习笔记|3.2线性回归的从零开始实现(附课后习题答案)线性回归的从零开始实现生成数据集读取数据集初始化模型参数定义模型定义损失函数定义优化算法训练练习1.如果我们将权重初始化为零,会发生什么。算法仍然有效吗?2.计算二阶导数时可能会遇到什么问题?这些问题可以如何解决?3.为什么在`squared_loss`函数中需要使用`reshape`函数?4.尝试使用不同的学习率,观察损失函数值下

- 发文新思路!双通道CNN的惊人突破,准确率接近100%!

沃恩智慧

深度学习人工智能cnn人工智能神经网络

双通道CNN作为一种创新的卷积神经网络架构,正引领深度学习领域的新趋势。其核心优势在于并行卷积层设计,能够同时处理更多特征信息,从而显著提升模型的特征表示能力和识别精度。这种架构不仅提高了计算效率,还有效降低了过拟合风险,使其在复杂视觉任务中表现卓越。例如,最新的研究提出了一种名为DDTransUNet的混合网络,结合了Transformer和CNN的优势,通过双分支编码器和双重注意力机制,有效解

- 基于华为自研NPU Ascend 910的TensorFlow 1.x训练脚本迁移和使能混合精度记录

Tianyi Li 1997

华为云tensorflow华为人工智能深度学习python

简介基于TesorFlow1.x以Sess.run形式搭建入门级——手写数字分类网络,并迁移到华为自研NPUAscend910,同时使能混合精度。硬件介绍华为自研NPUAscend910,即昇腾910AI处理器(简称NPU),根据官方介绍,是在2019年发布的人工智能(AI)专用的神经网络处理器,其算力高达256T,最新款算力高达310T,是业界主流芯片算力的2倍。当前业界大多数训练脚本基于Ten

- 超级实用!一个基于python的简化版深度学习框架,包括深度学习神经网络的设计和深度学习模型的设计,适用于中小型项目的开发和实现

大懒猫软件

深度学习python神经网络numpypytorch人工智能

一、运用Python技术开发深度学习框架需要具备的基础知识总结开发一个基于Python的深度学习框架是一个复杂的任务,需要具备多方面的基础知识。以下是一些关键领域的总结,帮助你更好地准备和理解开发深度学习框架所需的知识。1.Python编程基础语法和数据结构:掌握Python的基本语法、数据类型(如列表、字典、元组等)和控制流(如循环、条件语句等)。函数和模块:理解函数的定义和使用,以及如何组织代

- 详解AI作画算法原理

Jimaks

后端AIpythonai作画python人工智能

在艺术与科技的交汇处,AI作画正以惊人的创造力刷新着我们对美的认知。这一领域融合了深度学习、计算机视觉和生成模型的前沿技术,让机器能够“想象”并创作出令人惊叹的图像。本文将深入浅出地探讨AI作画的核心算法原理,分析常见问题与易错点,并通过一个简单的代码示例,带领大家一窥AI艺术创作的奥秘。一、核心概念与原理1.生成对抗网络(GANs)GANs是AI作画中最著名的算法之一,由IanGoodfello

- java封装继承多态等

麦田的设计者

javaeclipsejvmcencapsulatopn

最近一段时间看了很多的视频却忘记总结了,现在只能想到什么写什么了,希望能起到一个回忆巩固的作用。

1、final关键字

译为:最终的

&

- F5与集群的区别

bijian1013

weblogic集群F5

http请求配置不是通过集群,而是F5;集群是weblogic容器的,如果是ejb接口是通过集群。

F5同集群的差别,主要还是会话复制的问题,F5一把是分发http请求用的,因为http都是无状态的服务,无需关注会话问题,类似

- LeetCode[Math] - #7 Reverse Integer

Cwind

java题解MathLeetCodeAlgorithm

原题链接:#7 Reverse Integer

要求:

按位反转输入的数字

例1: 输入 x = 123, 返回 321

例2: 输入 x = -123, 返回 -321

难度:简单

分析:

对于一般情况,首先保存输入数字的符号,然后每次取输入的末位(x%10)作为输出的高位(result = result*10 + x%10)即可。但

- BufferedOutputStream

周凡杨

首先说一下这个大批量,是指有上千万的数据量。

例子:

有一张短信历史表,其数据有上千万条数据,要进行数据备份到文本文件,就是执行如下SQL然后将结果集写入到文件中!

select t.msisd

- linux下模拟按键输入和鼠标

被触发

linux

查看/dev/input/eventX是什么类型的事件, cat /proc/bus/input/devices

设备有着自己特殊的按键键码,我需要将一些标准的按键,比如0-9,X-Z等模拟成标准按键,比如KEY_0,KEY-Z等,所以需要用到按键 模拟,具体方法就是操作/dev/input/event1文件,向它写入个input_event结构体就可以模拟按键的输入了。

linux/in

- ContentProvider初体验

肆无忌惮_

ContentProvider

ContentProvider在安卓开发中非常重要。与Activity,Service,BroadcastReceiver并称安卓组件四大天王。

在android中的作用是用来对外共享数据。因为安卓程序的数据库文件存放在data/data/packagename里面,这里面的文件默认都是私有的,别的程序无法访问。

如果QQ游戏想访问手机QQ的帐号信息一键登录,那么就需要使用内容提供者COnte

- 关于Spring MVC项目(maven)中通过fileupload上传文件

843977358

mybatisspring mvc修改头像上传文件upload

Spring MVC 中通过fileupload上传文件,其中项目使用maven管理。

1.上传文件首先需要的是导入相关支持jar包:commons-fileupload.jar,commons-io.jar

因为我是用的maven管理项目,所以要在pom文件中配置(每个人的jar包位置根据实际情况定)

<!-- 文件上传 start by zhangyd-c --&g

- 使用svnkit api,纯java操作svn,实现svn提交,更新等操作

aigo

svnkit

原文:http://blog.csdn.net/hardwin/article/details/7963318

import java.io.File;

import org.apache.log4j.Logger;

import org.tmatesoft.svn.core.SVNCommitInfo;

import org.tmateso

- 对比浏览器,casperjs,httpclient的Header信息

alleni123

爬虫crawlerheader

@Override

protected void doGet(HttpServletRequest req, HttpServletResponse res) throws ServletException, IOException

{

String type=req.getParameter("type");

Enumeration es=re

- java.io操作 DataInputStream和DataOutputStream基本数据流

百合不是茶

java流

1,java中如果不保存整个对象,只保存类中的属性,那么我们可以使用本篇文章中的方法,如果要保存整个对象 先将类实例化 后面的文章将详细写到

2,DataInputStream 是java.io包中一个数据输入流允许应用程序以与机器无关方式从底层输入流中读取基本 Java 数据类型。应用程序可以使用数据输出流写入稍后由数据输入流读取的数据。

- 车辆保险理赔案例

bijian1013

车险

理赔案例:

一货运车,运输公司为车辆购买了机动车商业险和交强险,也买了安全生产责任险,运输一车烟花爆竹,在行驶途中发生爆炸,出现车毁、货损、司机亡、炸死一路人、炸毁一间民宅等惨剧,针对这几种情况,该如何赔付。

赔付建议和方案:

客户所买交强险在这里不起作用,因为交强险的赔付前提是:“机动车发生道路交通意外事故”;

如果是交通意外事故引发的爆炸,则优先适用交强险条款进行赔付,不足的部分由商业

- 学习Spring必学的Java基础知识(5)—注解

bijian1013

javaspring

文章来源:http://www.iteye.com/topic/1123823,整理在我的博客有两个目的:一个是原文确实很不错,通俗易懂,督促自已将博主的这一系列关于Spring文章都学完;另一个原因是为免原文被博主删除,在此记录,方便以后查找阅读。

有必要对

- 【Struts2一】Struts2 Hello World

bit1129

Hello world

Struts2 Hello World应用的基本步骤

创建Struts2的Hello World应用,包括如下几步:

1.配置web.xml

2.创建Action

3.创建struts.xml,配置Action

4.启动web server,通过浏览器访问

配置web.xml

<?xml version="1.0" encoding="

- 【Avro二】Avro RPC框架

bit1129

rpc

1. Avro RPC简介 1.1. RPC

RPC逻辑上分为二层,一是传输层,负责网络通信;二是协议层,将数据按照一定协议格式打包和解包

从序列化方式来看,Apache Thrift 和Google的Protocol Buffers和Avro应该是属于同一个级别的框架,都能跨语言,性能优秀,数据精简,但是Avro的动态模式(不用生成代码,而且性能很好)这个特点让人非常喜欢,比较适合R

- lua set get cookie

ronin47

lua cookie

lua:

local access_token = ngx.var.cookie_SGAccessToken

if access_token then

ngx.header["Set-Cookie"] = "SGAccessToken="..access_token.."; path=/;Max-Age=3000"

end

- java-打印不大于N的质数

bylijinnan

java

public class PrimeNumber {

/**

* 寻找不大于N的质数

*/

public static void main(String[] args) {

int n=100;

PrimeNumber pn=new PrimeNumber();

pn.printPrimeNumber(n);

System.out.print

- Spring源码学习-PropertyPlaceholderHelper

bylijinnan

javaspring

今天在看Spring 3.0.0.RELEASE的源码,发现PropertyPlaceholderHelper的一个bug

当时觉得奇怪,上网一搜,果然是个bug,不过早就有人发现了,且已经修复:

详见:

http://forum.spring.io/forum/spring-projects/container/88107-propertyplaceholderhelper-bug

- [逻辑与拓扑]布尔逻辑与拓扑结构的结合会产生什么?

comsci

拓扑

如果我们已经在一个工作流的节点中嵌入了可以进行逻辑推理的代码,那么成百上千个这样的节点如果组成一个拓扑网络,而这个网络是可以自动遍历的,非线性的拓扑计算模型和节点内部的布尔逻辑处理的结合,会产生什么样的结果呢?

是否可以形成一种新的模糊语言识别和处理模型呢? 大家有兴趣可以试试,用软件搞这些有个好处,就是花钱比较少,就算不成

- ITEYE 都换百度推广了

cuisuqiang

GoogleAdSense百度推广广告外快

以前ITEYE的广告都是谷歌的Google AdSense,现在都换成百度推广了。

为什么个人博客设置里面还是Google AdSense呢?

都知道Google AdSense不好申请,这在ITEYE上也不是讨论了一两天了,强烈建议ITEYE换掉Google AdSense。至少,用一个好申请的吧。

什么时候能从ITEYE上来点外快,哪怕少点

- 新浪微博技术架构分析

dalan_123

新浪微博架构

新浪微博在短短一年时间内从零发展到五千万用户,我们的基层架构也发展了几个版本。第一版就是是非常快的,我们可以非常快的实现我们的模块。我们看一下技术特点,微博这个产品从架构上来分析,它需要解决的是发表和订阅的问题。我们第一版采用的是推的消息模式,假如说我们一个明星用户他有10万个粉丝,那就是说用户发表一条微博的时候,我们把这个微博消息攒成10万份,这样就是很简单了,第一版的架构实际上就是这两行字。第

- 玩转ARP攻击

dcj3sjt126com

r

我写这片文章只是想让你明白深刻理解某一协议的好处。高手免看。如果有人利用这片文章所做的一切事情,盖不负责。 网上关于ARP的资料已经很多了,就不用我都说了。 用某一位高手的话来说,“我们能做的事情很多,唯一受限制的是我们的创造力和想象力”。 ARP也是如此。 以下讨论的机子有 一个要攻击的机子:10.5.4.178 硬件地址:52:54:4C:98

- PHP编码规范

dcj3sjt126com

编码规范

一、文件格式

1. 对于只含有 php 代码的文件,我们将在文件结尾处忽略掉 "?>" 。这是为了防止多余的空格或者其它字符影响到代码。例如:<?php$foo = 'foo';2. 缩进应该能够反映出代码的逻辑结果,尽量使用四个空格,禁止使用制表符TAB,因为这样能够保证有跨客户端编程器软件的灵活性。例

- linux 脱机管理(nohup)

eksliang

linux nohupnohup

脱机管理 nohup

转载请出自出处:http://eksliang.iteye.com/blog/2166699

nohup可以让你在脱机或者注销系统后,还能够让工作继续进行。他的语法如下

nohup [命令与参数] --在终端机前台工作

nohup [命令与参数] & --在终端机后台工作

但是这个命令需要注意的是,nohup并不支持bash的内置命令,所

- BusinessObjects Enterprise Java SDK

greemranqq

javaBOSAPCrystal Reports

最近项目用到oracle_ADF 从SAP/BO 上调用 水晶报表,资料比较少,我做一个简单的分享,给和我一样的新手 提供更多的便利。

首先,我是尝试用JAVA JSP 去访问的。

官方API:http://devlibrary.businessobjects.com/BusinessObjectsxi/en/en/BOE_SDK/boesdk_ja

- 系统负载剧变下的管控策略

iamzhongyong

高并发

假如目前的系统有100台机器,能够支撑每天1亿的点击量(这个就简单比喻一下),然后系统流量剧变了要,我如何应对,系统有那些策略可以处理,这里总结了一下之前的一些做法。

1、水平扩展

这个最容易理解,加机器,这样的话对于系统刚刚开始的伸缩性设计要求比较高,能够非常灵活的添加机器,来应对流量的变化。

2、系统分组

假如系统服务的业务不同,有优先级高的,有优先级低的,那就让不同的业务调用提前分组

- BitTorrent DHT 协议中文翻译

justjavac

bit

前言

做了一个磁力链接和BT种子的搜索引擎 {Magnet & Torrent},因此把 DHT 协议重新看了一遍。

BEP: 5Title: DHT ProtocolVersion: 3dec52cb3ae103ce22358e3894b31cad47a6f22bLast-Modified: Tue Apr 2 16:51:45 2013 -070

- Ubuntu下Java环境的搭建

macroli

java工作ubuntu

配置命令:

$sudo apt-get install ubuntu-restricted-extras

再运行如下命令:

$sudo apt-get install sun-java6-jdk

待安装完毕后选择默认Java.

$sudo update- alternatives --config java

安装过程提示选择,输入“2”即可,然后按回车键确定。

- js字符串转日期(兼容IE所有版本)

qiaolevip

TODateStringIE

/**

* 字符串转时间(yyyy-MM-dd HH:mm:ss)

* result (分钟)

*/

stringToDate : function(fDate){

var fullDate = fDate.split(" ")[0].split("-");

var fullTime = fDate.split("

- 【数据挖掘学习】关联规则算法Apriori的学习与SQL简单实现购物篮分析

superlxw1234

sql数据挖掘关联规则

关联规则挖掘用于寻找给定数据集中项之间的有趣的关联或相关关系。

关联规则揭示了数据项间的未知的依赖关系,根据所挖掘的关联关系,可以从一个数据对象的信息来推断另一个数据对象的信息。

例如购物篮分析。牛奶 ⇒ 面包 [支持度:3%,置信度:40%] 支持度3%:意味3%顾客同时购买牛奶和面包。 置信度40%:意味购买牛奶的顾客40%也购买面包。 规则的支持度和置信度是两个规则兴

- Spring 5.0 的系统需求,期待你的反馈

wiselyman

spring

Spring 5.0将在2016年发布。Spring5.0将支持JDK 9。

Spring 5.0的特性计划还在工作中,请保持关注,所以作者希望从使用者得到关于Spring 5.0系统需求方面的反馈。