2、ElasticSearch(ik)中文分析器

Elasticsearch 中文搜索时遇到几个问题:

- 当搜索关键词如:“人民币”时,如果分词将“人民币”分成“人”,“民”,“币”三个单字,那么搜索该关键词会匹配到很多包含该单字的无关内容,但是如果将该词分词成一个整词“人民币”,搜索单字如“人”字又不会匹配到包含“人民币”关键词的内容,怎么解决这个问题,既保证覆盖度又保证准确度?

- 搜索“RMB”时只会匹配到包含“RMB”关键词的内容,实际上,“RMB”和“人民币”是同义词,我们希望用户搜索“RMB”和“人民币”可以相互匹配,ES同义词怎么配置?

- 用户搜索拼音: 如"baidu",或者拼音首字母"bd",怎么匹配到"百度"这个关键词,又如用户输入"摆渡"这个词也能匹配到"百度"关键词,中文拼音匹配怎么做到?

- 怎么保证搜索关键词被正确分词,通常我们会采用自定义词典来做,那么怎么获取自定义词典?

接下来从以下几点讲一下怎么ES中文分词

- 中文分词器

- ES 分词流程之 analysis,analyzer,filter,tokenizer

- ES内置分词器

- 自定义analyzer

- ES同义词功能实现

- ES拼写纠错

- ES自定义词典获取

- 停用词

1.IK 分词器

Elasticsearch中文分词我们采用Ik分词,ik有两种分词模式,ik_max_word,和ik_smart模式;

ik_max_word: 会将文本做最细粒度的拆分,比如会将“中华人民共和国国歌”拆分为“中华人民共和国,中华人民,中华,华人,人民共和国,人民,人,民,共和国,共和,和,国国,国歌”,会穷尽各种可能的组合;

ik_smart: 会做最粗粒度的拆分,比如会将“中华人民共和国国歌”拆分为“中华人民共和国,国歌”。索引时,为了提供索引的覆盖范围,通常会采用ik_max_word分析器,会以最细粒度分词索引,搜索时为了提高搜索准确度,会采用ik_smart分析器,会以粗粒度分词

字段mapping设置如下:

"author": {

"type": "string",

"analyzer": "ik",

"search_analyzer": "ik_smart"

}2.分析(analysis)和分析器(analyzer)

analysis索引分析模块充当analyzer分析器的可配置注册表,通过analyzer对文档索引阶段的字段和搜索String进行处理,自定义analyzer时,通常需要character filter tokenizer token filters来完成

(1) character filter 字符过滤器

首先字符串经过过滤器(character filter),他们的工作是在分词前处理字符串。字符过滤器能够去除HTML标记,例如把“”变成“a.

(2)tokenizer 分词器

英文分词可以根据空格将单词分开,中文分词比较复杂,可以采用机器学习算法来分词

(3)token filters 表征过滤器

最后,每个词都通过所有表征过滤(token filters),他可以修改词(例如将“Quick”转为小写),去掉词(例如停用词像“a”、“and”、“the”等等),或者增加词(例如同义词像“a”、“and”、“the”等等)或者增加词(例如同义词像“jump”和“leap”)。

(4)ES分词流程

字符过滤器-->>分词器-->>token filters

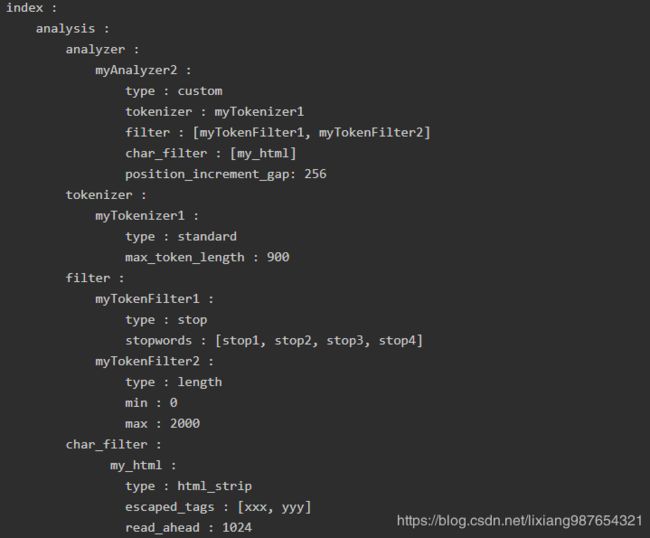

3.自定义analyzer

4.分词mapping设置

"content": {

"type": "string",

"analyzer": "ik_max_word",

"search_analyzer": "ik_smart"

}如果更改了mapping分词器,需要重新索引数据才能生效

POST /_reindex

{

"source": {

"index": "twitter"

},

"dest": {

"index": "new_twitter"

}

}5.分词测试

http://127.0.0.1:9200/index/_analyze?analyzer=ik_max_word&pretty=true&text=中国驻洛杉矶

6.更改别名,不重启服务

POST /_aliases

{

"actions": [

{

"remove": {

"index": "oldindex",

"alias": "alias_oldindex"

}

},

{

"add": {

"index": "newindex",

"alias": "alias_oldindex"

}

}]

}7.同义词

- elasticsearch /config/analysis 下建议同义词词典文件pro_synonym.txt,采用UTF-8编码,写入内容

- 同义词内容格式 ,注意标点符号使用英文符号

- 启航 => 起航 : "=>"左边的词全部会被右边的词替换

- 启航,起航 :使用","英文逗号分隔,两个词是互等的,分词时会同时分成两个词进行索引或者检索,如"启航"会被分成"启航","起航"两个词分别建立索引或者去倒排索引检索

自定义添加同义词通过ik分词器

"settings": {

"analysis": {

"filter": {

"my_synonym_filter": {

"type": "synonym",

"synonyms_path": "analysis/pro_synonym.txt"

}

},

"analyzer": {

"ik_syno_max_word": {

"tokenizer": "ik",

"filter": "my_synonym_filter"

},

"ik_syno_smart": {

"tokenizer": "ik_smart",

"filter": "my_synonym_filter"

}

}

查看同义词效果

http://192.168.0.100:9200/index/_analyze?analyzer=ik_max_word&pretty=true&text=启航参考文献:

https://www.cnblogs.com/johnson108178/p/9295737.html

快来成为我的朋友或合作伙伴,一起交流,一起进步!:

QQ群:961179337

微信:lixiang6153

邮箱:[email protected]

公众号:IT技术快餐