CornerNet算法解读

CornerNet: Detecting Objects as Paired Keypoints

论文链接:https://arxiv.org/abs/1808.01244

代码链接:https://github.com/umich-vl/CornerNet

1.背景介绍和摘要

目前的检测算法主要思路还是设置大量anchor+分配正负样本+训练的一个思路,Anchor的本质是目标的候选框,因为目标的形状和位置的多种可能性,Anchor的数量往往非常庞大,否则会出现遗漏的情况,这种情况对于one-stage的检测算法更加突出。本文不使用anchor boxes,而是提出了一种叫做corner pooling的操作帮助网络更好地定位目标。

Anchor有两个缺点:

1)通常需要大量的anchor,在DSSD中需要40k,而在RetinaNet中则需要100k。大量的anchor中只有少部分和gt的重合比较大,可以作为正样本训练,其它都是负样本,这样就带来了正负例anchor的比例不均衡,也降低了网络的训练速度。

2)anchor boxes的引入带来了许多的超参数,并且需要进行细致设计。包括anchor boxes的数量、尺寸、长宽比例。特别是在单一网络在多尺度进行预测的情况下会变得复杂,每个尺度都需要独立设计。

基于上述两点原因,再加上keypoint问题的启发,作者就想到用关键点检测的思路来处理detection问题,只要找到top-left和Bottom-right两个点,就可以准确框出一个目标了。使用单一卷积模型生成热点图和连接矢量:所有目标的左上角和所有目标的右下角热点图heatmap,每个顶点的连接矢量(embedding vector)。也就是该方法在卷积的输出结果上,分别预测边界框的左上角与右下角,之后寻找它们之间的对应关系。

主要思路其实来源于一篇多人姿态估计的论文。基于CNN的2D多人姿态估计方法,通常有2个思路(Bottom-Up Approaches和Top-Down Approaches):

Top-Down framework:就是先进行行人检测,得到边界框,然后在每一个边界框中检测人体关键点,连接成每个人的姿态,缺点是受人体检测框影响较大,代表算法有RMPE(alphapose);

Bottom-Up framework:就是先对整个图片进行每个人体关键点部件的检测,再将检测到的人体部位拼接成每个人的姿态,代表方法就是openpose。

在文章中给出了两个创新点:

1)文章将目标检测上升到方法论,基于多人姿态估计的Bottom-Up思想,首先同时预测定位框的顶点对(左上角和右下角)热点图和一个分支输出embedding vector,然后找出那些最有可能是top-left和bottom-right的点,并根据embedding vector对顶点进行分组(论文中提到分组的依据是同目标的两个角点距离是很小的),因此embedding vector是用来帮助判断top-left与bottom-right之间的匹配关系。

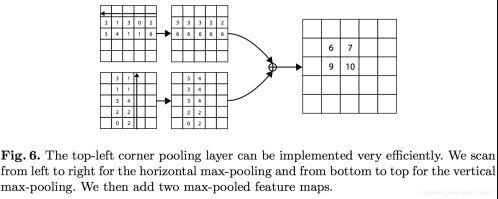

2)文章提出了corner pooling用于定位顶点,因为检测任务的变化,传统的Pooling方法并不是非常适用该网络框架。自然界的大部分目标是没有边界框也不会有矩形的顶点,以top-left corner pooling 为例,对每个channel,分别提取特征图对应位置处的水平和垂直方向的最大值,然后求和(如下图1所示)。

图1

为什么基于角点的检测要比基于anchor boxes的检测效果更好,这里假设了两个原因:

1)anchor boxes的中心点难以确定,是依赖于目标的四条边的,但是顶点却只需要目标框的两个边,所以角点更容易提取,而且还是使用了corner pooling,因而表现比anchor好。

2)采用了更加高效的空间检测框机制,顶点可以更有效地提取离散的边界空间,这里只使用O(w∗h)个角点就代表了O(W2∗h2)的可能检测框anchor box。

不理解没关系,可继续看下面的详细介绍就能清楚了

2.模型框架

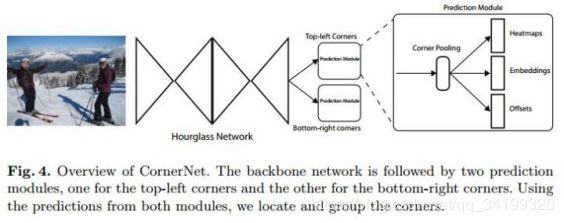

2.1Overview

图2

模型整体是首先通过1个7×7的卷积层将输入图像尺寸缩小为原来的1/4(论文中输入图像大小是511×511,缩小后得到128×128大小的输出)。然后经过特征提取网络(backbone network)提取特征,该网络采用hourglass network,该网络通过串联多个hourglass module组成(这里是2个),每个hourglass module都是先通过一系列的降采样操作缩小输入的大小,然后通过上采样恢复到输入图像大小,因此该部分的输出特征图大小还是128×128,整个hourglass network的深度是104层。

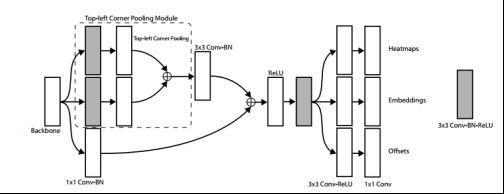

hourglass module后会有两个输出分支模块,分别表示左上角点预测分支和右下角点预测分支,每个分支模块包含一个corner pooling层和3个输出:heatmaps、embeddings和offsets。heatmaps是输出预测顶点信息,可以用维度为C*H*W的特征图表示,其中C表示目标的类别(注意:没有背景类),这个特征图的每个通道都是一个mask,mask的每个值(范围为0到1)表示该点是顶点的分数;embeddings用来对预测的corner点做group,也就是找到属于同一个目标的左上角角点和右下角角点;offsets用来对预测框做微调,这是因为从输入图像中的点映射到特征图时有量化误差,offsets就是用来输出这些误差信息。

需要注意网络有两个分支,一个分支预测Top-left Corners,另一个预测Bottom-right corners。每个分支有三个线路,heatmaps预测哪些点最有可能是Corners点,embeddings主要预测每个点所属的目标,最后的offsets用于对点的位置进行修正,下面进行每部分的详细介绍

2.2 Hourglass Networks

特征提取网络也就是Backbone使用的是Hourglass网络如图3,这也是从人体姿态估计处借用来的灵感。顾名思义,这个网络的形状非常像沙漏,网络前半部分通过卷积池化处理,进行多次下采样操作,获得一些分辨率较低的特征,从而使计算复杂度降低。下采样不断变小feature map,后面则通过上采样增大feature map恢复到输入图像大小,上采样操作使得图像的分辨率增高,同时更有能力预测物体的准确位置。由于在maxpooling层中丢失了详细信息,因此将添加残差层以将详细信息带回到上采样的特性中,因此才有类似fpn那样将前后网络相加的操作,每个残差结构的详情如图4所示。当多个沙漏模块被堆放在网络中时,沙漏模块可以重新处理这些特性以捕获更高级别的信息。这些特性使得沙漏网络也成为目标检测的理想选择。沙漏网络在关键点检测上已经证明了其有效性。

![]()

图3 沙漏结构

![]()

图4 沙漏模块残差结构

文章的沙漏网络由两个沙漏组成,对沙漏模块的架构做了一些修改。不是使用最大max pooling,而是使用stride=2来降低特征分辨率。降低了5倍的特征分辨率,并增加了沿途特征通道的数量(256;384;384;384;512)。当我们对特征进行上采样时,我们应用了两个残差模块,然后是最近邻上采样。每个跳过连接还包括2个残差模块。在沙漏模块的中间有4个残差模块,512个通道。在沙漏模块之前,我们使用一个7×7的卷积模块,步长2和128个通道,然后是一个有步长2和256个通道的残差块,将图像分辨率降低4倍。

我们还增加了训练中的监督。但是,我们不会将中间预测添加到网络中,因为我们发现这会损害网络的性能。我们将3×3 Conv-BN模块应用于第一个沙漏模块的输入和输出。然后,我们通过元素级的加法将它们合并,然后跟随一个relu和一个256个通道的残差块,将其用作第二个沙漏模块的输入。沙漏网络的深度为104。与许多其他最先进的检测器不同,我们只使用整个网络最后一层的特征来进行预测。

2.3 Detecting Corners

接下来分别看看这3个输出的含义。CornerNet的第一个输出是headmaps,也就是预测角点的位置。

模型生成的heatmaps是输出预测顶点信息,可以用维度为C*H*W的特征图表示,包含C channels(C是目标的类别,没有background channel)。Heatmaps的每个channel都是一个mask,mask的每个值(范围为0到1)表示该点是顶点的分数。其中非零点表示相应类别的顶点位置corners。

公式1是针对顶点预测(headmaps)的损失函数,整体上是改良版的focal loss。几个参数的含义:pcij表示预测的heatmaps在第c个通道(类别c)的(i,j)位置的值,ycij表示对应位置的ground truth。N是图片中目标的总数。ycij=1时候的损失函数容易理解,就是focal loss,α参数用来控制难易分类样本的损失权重;ycij等于其他值时表示(i,j)点不是类别c的目标顶点,照理说此时yycij应该是0(大部分算法都是这样处理的),但是这里ycij不是0,而是用基于ground truth顶点的高斯分布计算得到,因此距离ground truth比较近的(i,j)点的ycij值接近1,这部分通过β参数控制权重,这是和focal loss的差别。

为什么对不同的负样本点用不同权重的损失函数呢?这是因为靠近ground truth的误检顶点组成的预测框仍会和ground truth有较大的重叠面积,如图5所示,是关于对不同负样本点的损失函数采取不同权重值的原因。对于每个顶点,只有一个ground truth,其他位置都是负样本。红色实线框是ground truth,绿色虚线是一个预测框,可以看出这个预测框的两个角点和ground truth并不重合,但是该预测框基本框住了目标,因此是有用的预测框,所以要有一定权重的损失返回,这就是为什么要对不同负样本点的损失函数采取不同权重值的原因。具体来讲是这样的:在训练过程,模型减少负样本,在每个ground-truth顶点设定半径r区域内都是正样本,这是因为落在半径r区域内的顶点依然可以生成有效的边界定位框,橘色圆圈就是根据ground truth的左上角顶点、右下角顶点和设定的半径值画出来的,半径是根据圆圈内的角点组成的框和ground truth的IOU值大于0.7而设定的,圆圈内的点的数值是以圆心往外呈二维的高斯分布exp(-(x^2+y^2)/2σ^2),σ=1/3设置的,其中,中心坐标是标注的角点定位。

图5

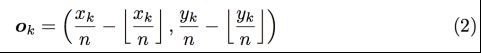

CornerNet的第二个输出是offset,这个值和目标检测算法中预测的offset类似却完全不一样,说类似是因为都是偏置信息,说不一样是因为在目标检测算法中预测的offset是表示预测框和anchor之间的偏置,而这里的offset是表示在取整计算时丢失的精度信息。在卷积神经网络中存在着下采样层,这样从原始的图像输入到最后的heatmap产生的这个过程会累计误差,特别是在对一些小目标的物体进行检测的时候,这样的误差就无法接受了,因而文章才引入了偏移修正来修正它。也就是公式2所表达的内容。

我们知道从输入图像到特征图之间会有尺寸缩小,假设缩小倍数是n,那么输入图像上的(x,y)点对应到特征图上就如下式子

式子中的符号是向下取整,取整会带来精度丢失,这尤其影响小尺寸目标的回归,Faster RCNN中的 ROI Pooling也是有类似的精度丢失问题。所以通过公式2计算offset,然后通过公式3的smooth L1损失函数监督学习该参数(使用L1损失与原图标注的位置对其进行修正),和常见的目标检测算法中的回归支路类似。

2.4 Grouping Corners

CornerNet的第三个输出是embedding,对应文章中group corner的内容。前面介绍了关于顶点的检测,在那部分中对顶点的预测都是独立的,不涉及一个目标的一对顶点的概念,因此如何找到一个目标的两个顶点就是第三个输出embedding做的工作。如图6,一共预测了4个点,那如何确定哪两个点是一组(哪两个是绿色的,哪两个是橘色的)这部分是受associative embedding那篇文章的启发,简而言之就是基于不同角点的embedding vector之间的距离找到每个目标的一对角点,如果一个左上角角点和一个右下角角点属于同一个目标,那么二者的embedding vector之间的距离应该很小。

图6

图7

工作原理看图7的两个图,在预测的heatmaps的地方,已经产生了所有的4个点,现在对4个点进行分组,在train的时候,已知标签label了,也就是已经知道了每对角点的位置,所以在embeddings这个预测模块的相应位置,提取出值,然后对这些值求方差和均值,同一对的corner优化这个方差尽可能小,对于不同对的corner则使刚刚求出来的均值做差取绝对值,尽可能优化使绝对值最大。通过pull和push的操作最终训练好,模型的分组操作。

具体来讲,embedding这部分的训练是通过两个损失函数实现的,etk表示属于k类目标的左上角角点的embedding vector,ebk表示属于k类目标的右下角角点的embedding vector,ek表示etk和ebk的均值。公式4用来缩小属于同一个目标(k类目标)的两个角点的embedding vector(etk和ebk)距离,公式5用来扩大不属于同一个目标的两个角点的embedding vector距离。模型训练Lpull损失函数使同一目标的顶点进行分组,Lpush损失函数用于分离不同目标的顶点。

最后的网络损失函数是上面的几个相加的形式:

其中,α=β=0.1,γ=1。

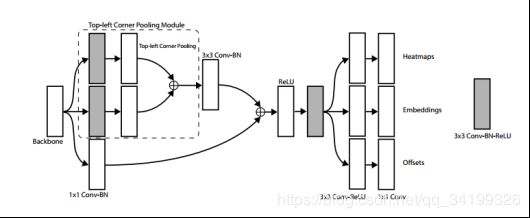

2.5 Corner Pooling

最后一部分是corner pooling。首先看看为什么要引入corner pooling,如图8所示。常规意义的pooling对corner检测的效果也存在一定的问题, 例如,我们常用的max pooling一般以当前位置为中心,大小是3x3的kernel,感受野自然也是以当前位置为中心的。但是corner的检测相对于这样一个方形的感受野,更关心单一方向。因为CornerNet是预测左上角和右下角两个角点,但是这两个角点在不同目标上没有相同规律可循,如果采用普通池化操作,那么在训练预测角点支路时会比较困难。以top-left为例,考虑到左上角角点的右边有目标顶端的特征信息(第一张图的头顶),左上角角点的下边有目标左侧的特征信息(第一张图的手),它更关心的是水平向右和垂直向下这两个方向上的信息,因此如果左上角角点经过池化操作后能有这两个信息,那么就有利于该点的预测,这就有了corner pooling。

图8

图9是针对左上角点做corner pooling的示意图,该层有2个输入特征图,特征图的宽高分别用W和H表示,假设接下来要对图中红色点(坐标假设是(i,j))做corner pooling,那么就计算(i,j)到(i,H)的最大值(对应图9上面第二个图),类似于找到图9 中第一张图的左侧手信息;同时计算(i,j)到(W,j)的最大值(对应图9下面第二个图),类似于找到图8 中第一张图的头顶信息,然后将这两个最大值相加得到(i,j)点的值(对应图9最后一个图的蓝色点)。例如feature map的大小是10x10,现在的一个点是(2,1),那么top-left corner pooling就是计算(2,1)到(2,10)这条线上的最大值和(2,1)到(10,1)这条线上的最大值,并将它们进行叠加。实际计算的时候,可以通过反向计算来实现,如图10所示那样。右下角点的corner pooling操作类似,只不过计算最大值变成从(0,j)到(i,j)和从(i,0)到(i,j)。

图9

图10也是针对左上角点做corner pooling的示意图,是图9的具体数值计算例子,该图一共计算了4个点的corner pooling结果。第二列的两个图的数值计算和图9介绍的一样,至于第一列的图,运算过程大致为:计算左上角时,1.计算top(图10中的第一列的第二行图片,带往上箭头的这个图):对feature map从下往上看,该图最后一行不变,倒数第二行的数值跟最后一行比较,如果大于最后一行,就保留当前数值,否则就更新成最后一行的数值,以此类推。2.计算left(图10中的第一列的第一行图片,带往左箭头的这个图):对feature map从右往左看,最后一列保存不变,倒数第二列的数值跟最后一列比较,如果大于最后一列,就保留当前数值,否则就更新成最后一列的数值,以此类推。以2,1,3,0,2这一行为例,最后的2保持不变,倒数第二个是max(0,2)=2,因此得到2,2。然后倒数第三个为max(3,2)=3……依次类推。

最后两者相加,就是top-left的数值。

图10

具体作用是啥呀?作者在论文里面说,由于预测的那两个点,并不是在‘内容’上面,而是在内容旁边,例如图5的情形,橘色的点并不是打在人物身上,而是打在了人物旁边,但是这个地方所提供的信息并没有作用,而真正有作用的是人物,所以需要通过corner pool的方式将人物上的信息,转移到旁边来,以便模型在预测点的时候能更准确。

图11是图2中预测模块的详细结构,该结构包括corner pooling模块和预测输出模块两部分,corner pooling模块采用了类似residual block的形式,有一个skip connection,虚线框部分执行的就是corner pooling操作,也就是图10的操作,这样整个corner pooling操作就介绍完了。

图11

本文参考了几篇写得非常棒的优秀博客,这里列出感谢他们:

https://blog.csdn.net/qq_21949357/article/details/82687053

https://blog.csdn.net/u014380165/article/details/83032273