Pyspider爬虫框架(以及与Scrapy爬虫框架的优缺点)

Pyspider: 一个国人编写强大的网络爬虫系统并带有强大的WebUI, 采用Python语言编写, 分布式架构, 支持多种数据库后端, 强大的WebUI支持脚本编辑器, 任务监视器, 项目管理器以及结果查看器.

主要功能需求:

1> 抓取, 更新调度多站点的特定的页面

2> 需要对页面进行结果化信息的提取

3> 灵活可扩展, 稳定可监控

Pyspider设计基础:

1> 通过python脚本进行结构化信息的提取, follow链接调度抓取控制, 实现最大的灵活性

2> 通过web化的脚本编写, 调试环境. web展现调度状态

3> 抓取环境成熟稳定, 模块间相互独立, 通过消息队列链接, 从单进程到多机分布式灵活拓展

官方文档: 点击打开链接

最新版本: 点击打开链接

一: 安装方法与步骤:

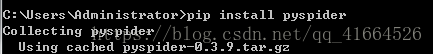

1. 下载pyspider

在cmd命令行工具中输入: pip install pyspider

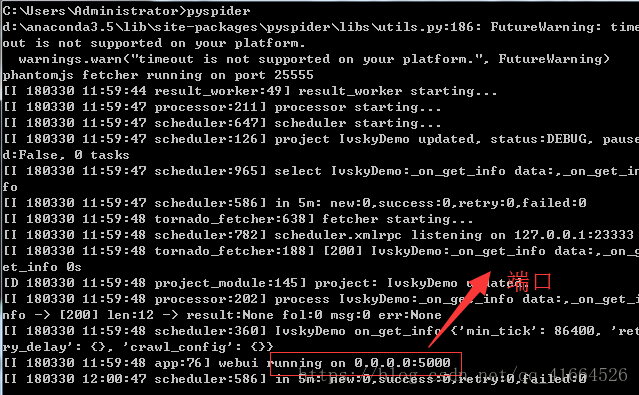

2. 下载完成后, 输入pyspider启动

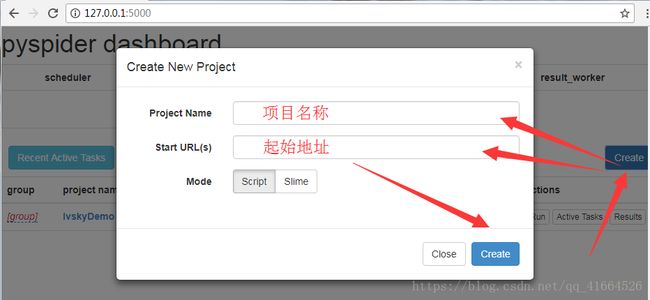

3. 打开浏览器输入地址, 默认端口5000(Flask默认端口),访问

4. 点击create创建项目

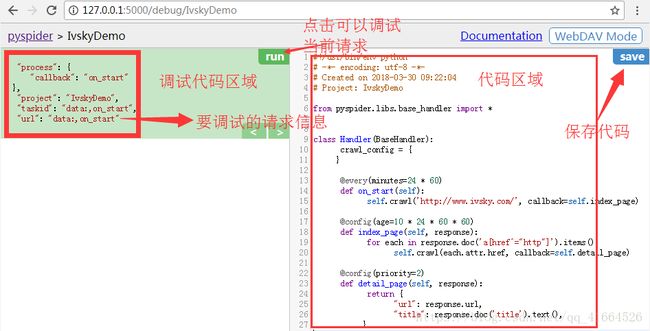

5. 创建后的页面

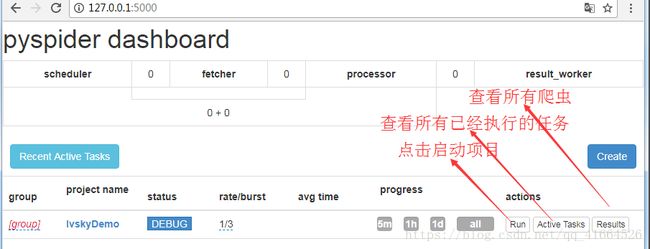

6. 运行主界面

以上是一些基本操作, 详细具体内容请百度!

二: Pyspider与Scrapy的优缺点

Pyspider具有以下特性(好与坏):

1. python脚本控制, 可以用任何你喜欢的html解析包

2. WEB 界面编写调试脚本, 起停脚本, 监控执行状态, 查看活动历史, 获取结果产出

3. 支持MySQL, MongoDB, SQlite

4. 支持抓取JavaScript的页面

5. 组件可替换, 支持单机/分布式部署, 支持Docker部署

6. 强大的调度控制

7. 可以在线提供爬虫服务, 也就是所说的SaaS

8. 做简单的爬虫框架推荐使用, 立刻就能上手, 但自定义程度相对Scrapy低, 社区人数和文档都没有Scrapy强

......

Scrapy具有以下特性(好与坏):

1. 不支持js渲染, 需要单独下载scrapy-splash(或者使用selenium)

2. 全部命令行操作

3. 对千万级URL去重支持很好, 采用布隆过滤

4. scrapy默认的debug模式信息量太大, 不容易调试, 可读性略差

5. 自定义程度高, 适合学习研究爬虫计数, 要学习的相关知识也较多, 故而完成一个爬虫的时间较长.

6. 是一个成熟的框架

......

具体的区别,可以看Quora的一个老外写的文章(偏向于Scrapy)

点击打开链接