探索计算机视觉与音频的交叉:基于视觉的音乐相关研究Review(声源分离 & Beyond)...

![]()

本文转自知乎,已获作者授权转载,请勿二次转载。

https://zhuanlan.zhihu.com/p/151696020

文章略有修改。

01

前言

近年来计算机视觉和深度学习的快速进展已经不必再多赘述,当传统(深度)vision,(和audio)的各个领域已经几乎饱和并疯狂内卷的当今,关注合适的,Promising的方向,无论是对心怀憧憬刚刚入门的新Researcher还是对已经饱经风霜的科研老手都是至关重要的。

在这里介绍一个近年来逐渐兴趣,依然小众却又充满前景的领域——探索视觉和音频(听觉)的联合学习任务(Audio-Visual Learning)。本方向相比纯视觉领域有以下几点值得大家关注:

自然的多模态信息。人类生来就有视觉和听觉两种感官接受信息,期待在研究中将两种信息融合用于对世界的理解各个任务中可以获得提升可谓非常自然。

竞争压力小,大量方向未被探索。由于领域不大,目前audio-visual的研究集中在有限的几个方向,甚至都处于发展初期,方向探索一片蓝海。

大佬背书。领域虽小,却并不是完全缺乏关注。William T. Freeman,Antonio Torralba,Andrew Zisserman和Alexei A. Efros都也在此领域深耕多年。这几位在计算机视觉领域的地位大家应该都懂。

社区友好。在内卷的领域内,reviewer和author相爱相杀互相diss,audio-visual领域却是小而精致,researcher们和和气气心心相惜。

整个Audio-Visual领域内的方向目前已经发展壮大,一个比较comprehensive的review可以参考朱昊同学的 Deep Audio-Visual Learning: A Survey。

虽然严格来讲并不能严谨地对细分方向进行分类,但是从研究对象来说,目前的研究方向还是可以简单地分为(1)人脸和语音(2)乐器和音乐(3)一切自然场景和自然声。当然各个research work也并不会完全限制在某一个方面,很多论文会同时对乐器和人声甚至自然声进行效果的展示。

However,在音乐方面的研究侧重点和语音又存在明显的区别。为了精炼内容,本文将会着重于对实验主要 conducted on 乐器和音乐数据的研究工作做一个简单的介绍。

02

视觉引导的声源分离

声源分离问题是音频信号处理中的老问题,在语音中所对应就是著名的鸡尾酒会效应。而在音乐和乐器的关系中,视觉信息分别被作为乐器种类,位置信息的承载者和音乐运动信息的提供者,被用于在音乐数据中引导声源分离。

这一领域的兴起和推动主要源于在 ECCV 2018 赵行博士和高若涵学长一作发表的工作,这二位也是笔者非常尊重和一直Follow的前辈。

本文会以 The Sound of Pixels 作为例子进行详细介绍,后面工作的数据使用,网络结构,核心思想都大同小异。

1. The Sound of Pixels. ECCV2018. [7]

The Sound of Pixels 是MIT的赵行博士和淦创博士 ECCV 2018 的工作,其最突出的贡献是收集了MUSIC数据集(虽然没有很好的划分训练和测试集),并很好的开源了训练代码。

MUSIC数据集信息统计

MUSIC数据集信息统计

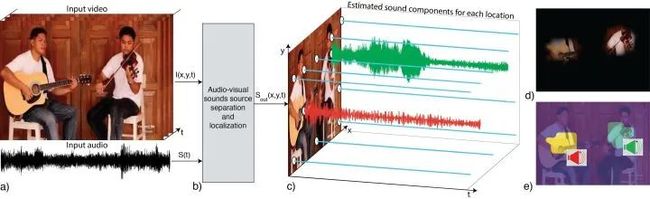

整个工作试图无监督地学习图像feature map(Image层面的像素块)和各个乐器声音的联系,并利用图像feature map作为引导信息辅助音乐的声源分离。

最后呈现的效果如上图所示,把吉他和小提琴的合奏音频和图像位置进行联系,利用小提琴位置的视觉特征可以从mix的音频中predict小提琴only的音频,吉他亦是如此。

Sound of Pixel训练流程

Sound of Pixel训练流程

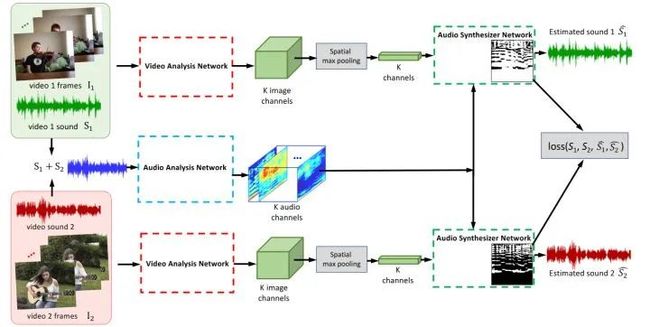

整个工作的框架非常简单。在训练时选取两段独立的独奏视频,将各自的音频作为ground truth,并将人工混合的结果作为audio输入,从而构建从mixed输入到两个solo的监督,在视觉信息的辅助下进行声源分离。其网络的细节和数据处理的细节见下图:

Audio的处理使用简单的短时傅里叶变换(STFT),将一维的时域音频信息转化为二维的时间-频率的频域信息。从而使用一个简单的U-Net将频谱映射到K个音频feature map。

对视频处理则是使用简单的ResNet18网络,并将最后的feature map在时空上使用max pooling操作得到视觉最强响应位置的feature。

接着视觉feature对K个feature map进行加权求和,得到两种乐器各自对应频谱的Mask,与输入频谱相乘得到目标频谱。最后通过iSTFT转换回时域音频。

作为早期工作,这篇论文从发展的眼光看具必然有局限性,但这些正是作者们留下的坑:(1)这篇文章的网络构建,loss设置和信息使用都很简单(2)只能使用solo视频用作训练(3)也只能适用于两个乐器同时弹奏的duet场景。

2. Learning to Separate Object Sounds by Watching Unlabeled Video. ECCV 2018 (oral). [3]

Amazingly同在ECCV 2018,UTAustin的研究者若涵 et al. 同样使用了视觉信息指导声源分离。

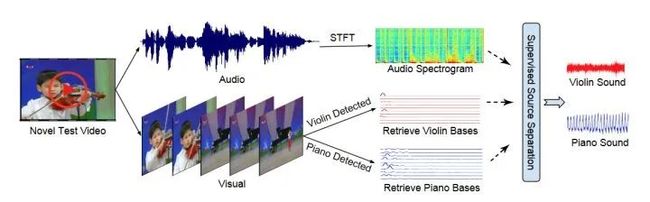

不同的是这个工作使用了比较传统的Non-negative Matrix Factorization将频谱分成了M个Basis,并和预测的视觉信息通过MIML进行联系。

相比于Sound of Pixels,这篇文章除了音乐,在各种自然声上也进行了实验。但是这种传统的方法明显在效果上会逊色于全神经网络的方法,所以若涵本人在后续工作中也抛弃了这种pipeline。

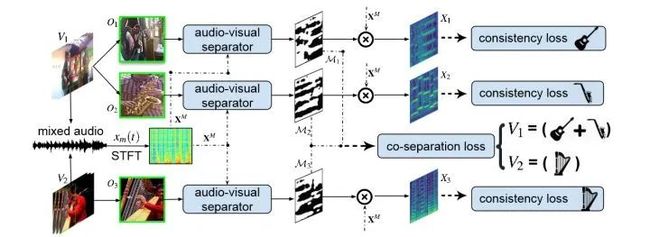

3. Co-Separating Sounds of Visual Objects. ICCV 2019. [4]

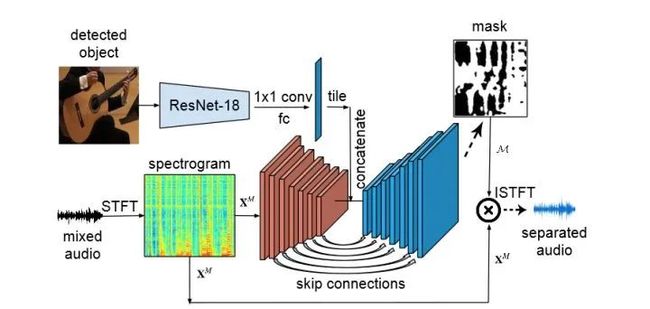

发表于ICCV 2019的这篇文章中,UT Austin团队(若涵和老板)在ICCV 2019就换用了U-Net作为网络的backbone,不同之处是使用类似conditional generation的任务,将视觉信息的feature在U-Net的bottleneck中concatenate了进去。

网络结构见下图:

这篇文章利用了乐器detection的结果直接抽取feature,并利用了乐器类的label作为分类监督,从而将duet的音频也用于训练中。

实验证明了对于duet和solo混合的场景中,文章方法比Sound of Pixels有较大提升。

4. Recursive Visual Sound Separation Using Minus-Plus Net. ICCV 2019. [6]

这篇ICCV 2019的文章来自(我们)CUHK MMLab,一作是徐旭东同学。这篇文章基于Sound of Pixels,对网络的loss进行改进,recursive地对预测的频谱进行finetune。

文章证明对于三个混合的声源,文章相比Sound of Pixels有提升,同时在自然声数据集上也验证文章效果。

5. The Sound of Motions. ICCV 2019. [8]

同样在ICCV 2019中,赵行博士和淦创博士对Sound of Pixels进行了亲手改进,把运动信息作为引导融入音乐声源分离任务。

事实上之前列举的所有工作都只是注重于静态图像信息和音频的对应关系,其利用的实际信息其实只有乐器的外形和种类。

这篇文章使用dense flow定义了一种特殊的dense运动轨迹,并与video的外观feature进行融合。而视觉信息和音频信息的融合也被放入了U-Net的bottleneck位置。

在bottleneck的特征融合方面,文章也提出了一种新的fusion方式。

增加了运动信息之后,此文对sound of pixels的结果和多乐器mix的结果都有显著的提高。除此之外,文章将之前MUSIC数据集的11类乐器扩充到了21类。

6. Music Gesture for Visual Sound Separation. CVPR 2020. [1]

在最近的CVPR 2020上,淦创博士进一步对Sound of Motions进行改进,将人体关键点引入音乐分离任务中。

整个网络结构和Sound of Motions比较相似,区别在于motion部分本文中使用了ST-GCN进行了特征提取。

这篇文章相较于之前所有文章,在各个评价指标上都有了全面的效果提升。

03

视觉引导的立体声重构

视觉引导的立体声重构则是另一个有趣的任务,根据视觉信息将单个或者多个混合的乐器的单通道(mono)audio转化为多通道。下面接下来会主要介绍一下基于深度学习的立体声重构工作。

7. Self-Supervised Generation of Spatial Audio for 360◦ Video. NeurIPS 2018. [5]

这是发表于NeurIPS 2018,Adobe的一篇针对360度视频,生成空间声场效果的论文。这是最早完全使用 Deep Learning 方式生成空间声场效果(Ambisonic格式立体声)的论文。

由于用到了 Ambisonic 的音频录制格式,没接触过的读者可能读起来会稍有些吃力。

简单来说,本文将单通道的输入看作第0阶的Ambisonic信号,用视觉信息引导将其恢复成1阶的x,y,z通道的Ambisonic。和分离问题类似,其目标的output是三个信号的Mask。

在实现过程中,文章利用Ambisonic的性质,假设使用神经网络将声源进行了分离,并对三个方向进行了投影,其分解过程利用了球谐函数和Ambisonic通道之间的关系(具体请参考paper中的公式)。

这篇paper的理论非常漂亮,通过Ambisonic球谐函数分解的性质分析了分离后声源与立体声的关系,又假设通过神经网络拟合了分离的过程,实现简单,理论精巧。

同时这篇论文也收集了360度摄像机拍摄的多个立体声数据集,更是第一篇使用纯深度学习的方式进行立体声重构(Ambisonic空间声场)的论文,可以说是我个人在18年看过数一数二的好论文!

8. 2.5D Visual Sound. CVPR 2019. [2]

UT-Austin 的若涵和Grauman在CVPR 2019为正常视角的视频设计了从单通道到双通道的网络Mono2Binaural,同时收集了宝贵的 FAIR-Play 数据集。这个数据集有非常严重的问题,包括场景全部在同一个音乐室,乐器数量有限,train和test甚至有些镜头都有overlap。

简而言之,用神经网络会很容易overfit这个数据。但是这并不能掩盖他的重要性,FAIR-Play是第一个通过专业3Dio Binaural Mic和GoPro采集的立体声与视觉匹配的数据集,实现了这个领域从0到1的数据积累。

本文提出的Mono2Binaural模型也是异常的简单,将visual的feature concat的输入频谱UNet,预测频谱复数的Mask。如下图所示:

值得注意的一点是,网络输入的单通道音频作者假设是左右两通道的和 ,而UNet输出层则用于预测两通道的差 。

这一设计适应了双通道音频的性质,使得网络输出的差异和输入更大,使网络更好学习。由此可以从输入输出恢复左右两个通道的结果。

04

视觉引导的音乐生成相关任务

声源分离和立体声重构都是在给定输入音频的情况下使用mask对输入进行加权分散为多个通道的任务,而从视觉信息直接引导音乐的生成任务会比只预测mask的任务难很多。

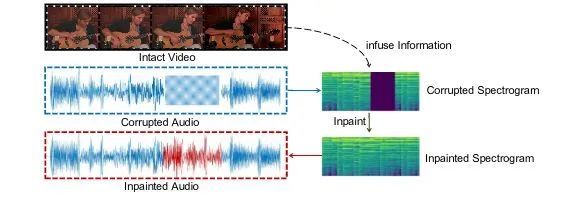

9. Vision-Infused Deep Audio Inpainting. ICCV 2019. [9]

笔者发表在ICCV2019的音频补全论文是依赖给定音频前后的信息和完整的视觉信息,对缺失的音频进行补全。其难点在于补全的片段需要和前后的已有音频和谐连续。

文章通过对音频从时域到频域的转换,把一维的音频补全任务转化为二维的频谱补全任务,从而用GAN使用类似图像补全的方式进行频谱补全。最后利用一个频谱转换真实音频的WaveNet将补全的频谱转换回音频。

视频信息通过concat的方法放入inpainting网络的bottleneck层。本文设计的model在有或没有视频信息的情况下都可以适用。

单纯依靠视频进行音乐的生成任务在最近也开始得到发展和关注,本文接下来会持续更新这方面的最新动态。

一点私货

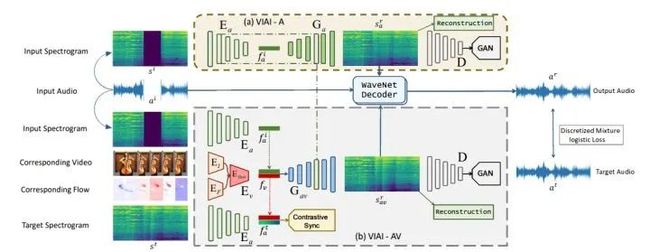

10. Sep-Stereo: Visually Guided Stereophonic Audio Generation by Associating Source Separation。ECCV 2020. [10]

在刚刚揭晓结果的 ECCV 2020 中,笔者和徐旭东同学合作的论文:

被录取为Poster。在这篇文章中我们把声源分离任务看作是立体声重构任务的特殊情况,用一个uniform的框架同时解决了这两个问题(题图即为paper的teaser)。

通过Multi-task learning,在保持Sound of Pixel水准分离结果的同时,在立体声重构任务上获得了很好的提升。

论文地址:

https://arxiv.org/abs/2007.09902

项目地址:

https://github.com/SheldonTsui/SepStereo_ECCV2020

小结

由视觉引导的声源分离经过这两年的发展,在音乐和乐器数据上(尤其是MUSIC数据集)有了不小的进步和成功的探索,但是一开始Sound of Pixels就留下的坑依然没有完全填好,研究的初衷也从通过神经网络探索视觉信息与音频分离的联系延拓到了对效果的追求。

从笔者个人角度此领域未来的路还有很长可以走,抛砖引玉列出以下几个方面:

(1)在更多声源数量情况下的分离依然是未能解决的难题;

(2)Universal 的 separation,把音乐和人声一起处理;

(3)音乐声源分离与音乐其他方向的交叉,可在未来参见我们这次ECCV20的工作;

(4)将音频处理领域的domain knowledge引入此任务。

目前该方向的研究还有点CV researcher自嗨的意思,将audio领域新结构,例如从wav form直接进行separation,还是尚未得到完整探索。

参考文献

[1] Gan, C., Huang, D., Zhao, H., Tenenbaum, J.B., Torralba, A.: Music gesture for visual sound separation. In: IEEE/CVF Conference on Computer Vision and Pattern Recognition. (CVPR 2020).

[2] Gao, R., Grauman, K.: 2.5 d visual sound. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (2019)

[3] Gao, R., Feris, R., Grauman, K.: Learning to separate object sounds by watching unlabeled video. In: Proceedings of the European Conference on Computer Vision. (ECCV 2018).

[4] Gao, R., Grauman, K.: Co-separating sounds of visual objects. In: Proceedings of the IEEE International Conference on Computer Vision. (ICCV 2019).

[5] Morgado, P., Nvasconcelos, N., Langlois, T., Wang, O.: Self-supervised generation ofspatial audio for 360 video. In: Advances in Neural Information Processing Systems. (NeurIPS 2018).

[6] Xu, X., Dai, B., Lin, D.: Recursive visual sound separation using minus-plus net. In: Proceedings of the IEEE International Conference on Computer Vision. (ICCV 2019).

[7] Zhao, H., Gan, C., Rouditchenko, A., Vondrick, C., McDermott, J., Torralba, A.: The sound of pixels. In: Proceedings of the European Conference on Computer Vision. (ECCV 2018).

[8] Zhao, H., Gan, C., Ma, W.C., Torralba, A.: The sound of motions. In: Proceedings of the IEEE International Conference on Computer Vision. (ICCV 2019).

[9] Zhou, H., Liu, Z., Xu, X., Luo, P., Wang, X.: Vision-infused deep audio inpainting.In: Proceedings of the IEEE International Conference on Computer Vision (ICCV 2019).

[10] Zhou, H., Xu, X., Lin, D., Wang, X., Liu, Z.: Sep-stereo: Visually guided stereophonic audio generation by associating source separation. In: Proceedings of the European Conference on Computer Vision. (ECCV 2020)

END

![]()

备注:语音

![]()

语音声音处理与识别交流群

语音声音处理与识别等最新资讯,

若已为CV君其他账号好友请直接私信。

我爱计算机视觉

微信号:aicvml

QQ群:805388940

微博知乎:@我爱计算机视觉

网站:www.52cv.net

![]()

在看,让更多人看到 ![]()