朴素贝叶斯

朴素贝叶斯

1 概述

1.1 真正的概率分类器

在许多分类算法应用中,特征和标签之间的关系并非是决定性的。算法得出的结论,永远不是100%确定的,更多的是判断出了一种“样本的标签更可能是某类 的可能性”,而非一种“确定”。我们通过某些规定,比如说,在决策树的叶子节点上占比较多的标签,就是叶子节点上所有样本的标签,来强行让算法为我们返回一个固定结果。但许多时候,我们也希望能够理解算法判断出的可能性本身。每种算法使用不同的指标来衡量这种可能性。比如说,决策树使用的就是叶子节点上占比较多的标签所占的比例 (接口predict_proba调用),逻辑回归使用的是sigmoid函数压缩后的似然(接口predict_proba调用),而SVM 使用的是样本点到决策边界的距离(接口decision_function调用)。但这些指标的本质,其实都是一种“类概率”的 表示,我们可以通过归一化或sigmoid函数将这些指标压缩到0~1之间,让他们表示我们的模型对预测的结果究竟有多大的把握(置信度)。但无论如何,我们都希望使用真正的概率来衡量可能性,因此就有了真正的概率算法: 朴素贝叶斯。

朴素贝叶斯是一种直接衡量标签和特征之间的概率关系的有监督算法,它既可以做回归也可以分类,不过多是用于分类之中。朴素贝叶斯的算法根源就是基于概率论和数理统计的贝叶斯理论,因此它是根正苗红的概率模型。接下来,我们就来认识一下这个简单快速的概率算法。

1.2 与众不同的朴素贝叶斯

在过去的许多个星期内,我们学习的分类算法总是有一个特点:这些算法先从训练集中学习,获取某种信息来建立模型,然后用模型去对测试集进行预测。比如逻辑回归,我们要先从训练集中获取让损失函数最小的参数,然后用 参数建立模型,再对测试集进行预测。在比如支持向量机,我们要先从训练集中获取让边际最大的决策边界,然后 用决策边界对测试集进行预测。相同的流程在决策树,随机森林中也出现,我们在fit的时候必然已经构造好了能够 让对测试集进行判断的模型。而朴素贝叶斯,似乎没有这个过程。

我给了大家一张有标签的表,然后提出说,我要预测零下的时候,年龄为20天的瓢虫,会冬眠的概率,然后我们就顺理成章地算了出来。没有利用训练集求解某个模型的过程,也没有训练完毕了我们来做测试的过程,而是直接对 有标签的数据提出要求,就可以得到预测结果了。

这说明,朴素贝叶斯是一个不建模的算法。以往我们学的不建模算法,比如KMeans,比如PCA,都是无监督学 习,而朴素贝叶斯是第一个有监督的,不建模的分类算法。在我们刚才举的例子中,有标签的表格就是我们的训练 集,而我提出的要求“零下的时候,年龄为20天的瓢虫”就是没有标签的测试集。我们认为,训练集和测试集都来自 于同一个不可获得的大样本下,并且这个大样本下的各种属性所表现出来的规律应当是一致的,因此训练集上计算 出来的各种概率,可以直接放到测试集上来使用。即便不建模,也可以完成分类。

但实际中,贝叶斯的决策过程并没有我们给出的例子这么简单。

1.3 sklearn中的朴素贝叶斯

如我们刚才所说,我们在贝叶斯中,需要重点求解贝叶斯概率公式中的分子。

在现实中,要求解分子也会有各种各样的问题。我们可能面临特征非常多,而每个特征下的分类也非常多的情况, 像我们刚才那样去手动数出概率,需要极多的计算资源。并且,可能会出现,测试集中出现的某种概率组合,是训练集中从未出现的状况,这种时候就会出现某一个概率为0的情况,分子就会为0,这种情况下的概率预测就是无效 的。还有,现实中的大多数标签还是连续型变量,要处理连续型变量的概率,就不是单纯的数样本个数的占比的问 题了。求解连续型变量的概率,需要引入各种概率论中的数字分布,使用各种分布下的概率密度曲线来估计一个概率。其中涉及的数学过程是极其复杂的,要求大家必须要熟悉概率论和微积分。

其中,我们最常用的几个分布分别是:高斯分布,伯努利分布和多项式分布。sklearn中,基于这些分布以及这些 分布上的概率估计的改进,为我们提供了四个朴素贝叶斯的分类器。

2 不同分布下的贝叶斯

2.1 高斯朴素贝叶斯GaussianNB

class sklearn.naive_bayes.GaussianNB (priors=None, var_smoothing=1e-09)

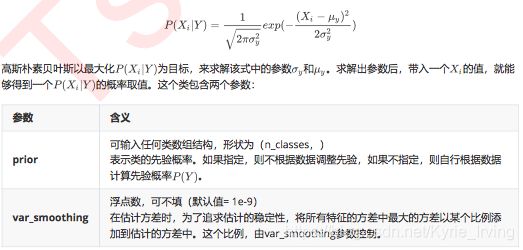

高斯朴素贝叶斯,通过假设是服从高斯分布(也就是正态分布),来估计每个特征下每个类别上的条件概 率。对于每个特征下的取值,高斯朴素贝叶斯有如下公式:

但在实例化的时候,我们不需要对高斯朴素贝叶斯类输入任何的参数,可以说是一个非常轻量级的类。所以很遗憾的是,贝叶斯也没有太多的参数可以调整,调用的接口也全部都是我们曾经见过的。

无论如何,先来进行一次预测试试看吧

#1.导入库和数据

import numpy as np

import matplotlib.pyplot as plt

from sklearn.naive_bayes import GaussianNB

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

digits = load_digits()

X, y = digits.data, digits.target

Xtrain,Xtest,Ytrain,Ytest = train_test_split(X,y,test_size=0.3,random_state=420)

# 2. 建模,探索建模结果

gnb = GaussianNB().fit(Xtrain,Ytrain)

#查看分数

acc_score = gnb.score(Xtest,Ytest)

print('score:%.2f'%acc_score)

#查看预测结果

print('Ytest:',Ytest)

Y_pred = gnb.predict(Xtest)

print('Y_pred:',Y_pred)

#查看预测的概率结果

prob = gnb.predict_proba(Xtest)

print('prob:',prob)

# 3. 使用混淆矩阵来查看贝叶斯的分类结果

from sklearn.metrics import confusion_matrix as CM

print(CM(Ytest,Y_pred))

print(type(Ytest))

print(type(Y_pred))

控制台

score:0.86

Ytest: [6 1 3 0 4 5 0 8 3 9 6 8 7 8 2 2 5 9 5 6 5 4 7 4 8 2 7 2 2 9 2 1 3 6 0 3 8

2 1 5 2 8 8 9 2 2 0 7 3 6 7 2 8 0 5 4 1 9 4 0 5 8 9 1 7 2 3 5 8 2 4 4 8 6

5 1 2 1 7 1 2 5 9 4 3 6 9 4 4 2 4 8 0 5 7 7 7 4 7 8 9 8 0 3 2 1 9 9 9 7 1

5 9 8 0 9 8 1 5 6 4 3 3 8 0 6 8 6 4 6 1 8 5 0 8 2 1 8 8 6 6 0 1 4 7 8 9 5

9 4 7 9 8 6 7 0 8 4 7 1 2 4 4 9 1 0 3 4 3 8 7 0 6 9 7 5 5 5 6 1 6 6 2 3 8

2 7 3 1 1 6 8 2 8 7 5 2 5 0 0 3 6 6 7 6 0 4 5 5 2 4 6 5 1 5 1 9 6 2 8 8 2

4 1 6 5 9 9 3 8 9 1 3 3 5 5 8 7 4 0 9 0 9 9 6 4 3 4 8 1 0 2 9 1 6 8 8 0 6

0 1 7 1 9 5 4 6 8 1 5 7 7 5 1 0 0 9 3 1 1 6 3 7 2 4 2 9 9 8 3 3 5 7 7 9 3

9 5 0 7 5 5 1 4 9 2 0 6 3 0 8 7 2 8 1 6 4 1 2 5 7 1 4 9 5 4 2 3 5 9 5 0 0

0 0 4 2 0 2 6 2 7 1 1 9 1 2 7 8 0 2 3 1 4 6 1 9 1 6 6 7 2 8 5 9 2 1 3 7 2

5 1 9 2 8 1 7 8 9 5 0 4 7 8 1 9 5 3 8 5 5 3 1 0 4 3 8 4 8 5 7 6 9 9 5 2 9

9 1 8 6 4 3 3 3 3 0 8 0 7 9 6 0 8 9 8 3 6 6 8 7 5 8 4 5 8 6 7 6 7 7 2 0 9

2 2 0 5 7 3 9 2 8 2 0 3 3 6 2 1 7 5 7 1 7 7 2 7 5 2 6 5 1 0 0 2 8 3 3 6 1

5 6 2 0 1 5 1 8 0 3 5 0 7 6 4 4 1 5 9 5 3 7 1 1 3 5 8 5 1 5 6 1 6 7 4 3 7

0 5 4 9 5 8 6 3 5 2 9 8 9 3 9 7 3 4 9 4 3 1]

Y_pred: [6 1 3 0 4 5 0 8 3 8 6 8 7 8 8 8 5 9 5 6 5 4 7 4 8 2 7 2 8 9 2 8 3 6 0 3 8

8 1 5 2 8 8 9 2 2 0 7 3 6 7 2 8 0 5 4 1 9 4 0 5 8 9 1 7 8 7 5 8 2 4 4 8 2

6 1 2 1 7 8 8 5 9 4 3 6 9 7 4 2 4 8 0 5 7 7 7 4 7 8 8 7 0 7 2 1 9 9 8 7 1

5 1 8 0 4 8 9 5 6 4 8 3 8 0 6 8 6 7 6 1 8 5 0 8 2 1 8 8 6 6 0 2 4 7 8 9 5

9 4 7 8 8 6 7 0 8 4 7 2 2 6 4 4 1 0 3 4 3 8 7 0 6 9 7 5 5 3 6 1 6 6 2 3 8

2 7 3 1 1 6 8 8 8 7 7 2 5 0 0 8 6 6 7 6 0 7 5 5 8 4 6 5 1 5 1 9 6 8 8 8 2

4 8 6 5 9 9 3 1 9 1 3 3 5 5 7 7 4 0 9 0 9 9 6 4 3 4 8 1 0 2 9 7 6 8 8 0 6

0 1 7 1 9 5 4 6 8 1 5 7 7 5 1 0 0 9 3 9 1 6 3 7 2 7 1 9 9 8 3 3 5 7 7 7 3

9 5 0 7 5 5 1 4 9 2 0 6 3 0 8 7 2 8 1 6 4 1 2 5 7 1 4 9 5 4 2 3 5 9 8 0 0

0 0 4 2 0 6 6 8 7 1 1 8 1 1 7 8 7 8 3 1 4 6 1 8 1 6 6 7 2 8 5 3 2 1 8 7 8

5 1 7 2 1 1 7 8 9 5 0 4 7 8 8 9 5 5 8 5 5 8 1 0 4 3 8 2 8 5 7 6 9 9 5 8 9

9 1 8 6 4 3 3 3 3 0 8 0 7 7 6 0 8 9 8 3 6 6 8 7 5 8 4 5 8 6 7 6 7 7 8 0 8

2 2 0 5 7 3 0 2 8 2 0 2 3 6 8 1 7 5 7 1 7 7 2 7 5 2 6 5 8 0 0 8 1 3 7 6 1

5 6 2 0 1 5 7 8 0 3 5 0 7 5 4 4 1 5 9 5 3 7 1 7 3 5 8 5 8 5 6 1 6 7 4 3 7

0 5 4 9 3 3 6 3 5 2 9 8 9 3 9 7 3 4 9 4 3 1]

prob: [[0.00000000e+000 4.69391744e-052 1.74871280e-098 ... 0.00000000e+000

4.19588993e-033 1.51751459e-119]

[0.00000000e+000 1.00000000e+000 9.26742456e-013 ... 0.00000000e+000

0.00000000e+000 0.00000000e+000]

[0.00000000e+000 0.00000000e+000 3.73608152e-026 ... 0.00000000e+000

1.29541754e-039 5.54684869e-077]

...

[0.00000000e+000 2.43314963e-047 4.82483668e-305 ... 2.31612692e-008

1.23891596e-126 2.87896140e-257]

[0.00000000e+000 8.26462929e-129 4.99150558e-012 ... 0.00000000e+000

4.01802372e-003 6.19000712e-013]

[0.00000000e+000 9.99929965e-001 1.45462767e-013 ... 5.05856094e-005

1.94498169e-005 3.42317317e-042]]

[[47 0 0 0 0 0 0 1 0 0]

[ 0 46 2 0 0 0 0 3 6 2]

[ 0 2 35 0 0 0 1 0 16 0]

[ 0 0 1 40 0 1 0 3 4 0]

[ 0 0 1 0 39 0 1 4 0 0]

[ 0 0 0 2 0 58 1 1 1 0]

[ 0 0 1 0 0 1 49 0 0 0]

[ 0 0 0 0 0 0 0 54 0 0]

[ 0 3 0 1 0 0 0 2 55 0]

[ 1 1 0 1 2 0 0 3 7 41]]

混淆矩阵和精确性可以帮助我们了解贝叶斯的分类结果。然而,我们选择贝叶斯进行分类,大多数时候都不是为了单单追求效果,而是希望看到预测的相关概率。这种概率给出预测的可信度,所以对于概率类模型,我们希望能够 由其他的模型评估指标来帮助我们判断,模型在“概率预测”这项工作上,完成得如何。接下来,我们就来看看概率 模型独有的评估指标。

2.2 概率类模型的评估指标

2.2.1 布里尔分数

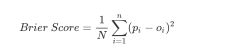

概率预测的准确程度被称为“校准程度”,是衡量算法预测出的概率和真实概率的差异的一种方式。在二分类中,最常用的指标叫做布里尔分数,它被计算为是概率预测相对于测试样本的均方误差,表示为

布里尔分数的范围是从0到1,分数越高则贝叶斯的预测结果越差劲。由于它的本质也是在衡量一种损失,所以在 sklearn当中,布里尔得分被命名为brier_score_loss。我们可以从模块metrics中导入这个分数来衡量我们的模型 评估结果:

print('bsl:',brier_score_loss(Ytest, prob[:, 1], pos_label=1))

# 我们的pos_label与prob中的索引一致,就可以查看这个类别下的布里尔分数是多少

基于布里尔分数,我们可以构筑概率校准曲线,来查看我们的模型的效果。当然,对于校准效果不理想的模型,我们还可以使用一些方法来帮助他们改善概率预测结果