京东副总裁何晓冬:GPT-3后,人机对话与交互何去何从?

8 月 7 日-8 月 9 日,2020 年全球人工智能和机器人峰会(简称“CCF-GAIR 2020”)在深圳如期举办!CCF-GAIR 由中国计算机学会(CCF)主办,香港中文大学(深圳)、雷锋网联合承办,鹏城实验室、深圳市人工智能与机器人研究院协办,以“AI 新基建产业新机遇”为大会主题,致力打造国内人工智能和机器人领域规模最大、规格最高、跨界最广的学术、工业和投资领域盛会。

8 月 7 日下午,在「人工智能前沿专场」上,京东集团副总裁、人工智能研究院常务副院长、及智能人机交互业务负责人何晓冬博士进行了题为「多模态人机对话与交互: 理解、创作、决策」的演讲。

何晓冬博士的演讲围绕人机对话系统的发展与应用展开,结合对“AI 新秀”GPT-3 的技术探讨,针对 GPT-3 等超大规模语言模型缺少知识和逻辑推理能力以及主要还局限于文本数据的短板,提出将高复杂的知识推理与决策任务及多模态的信息处理技术作为人工智能未来发展的驱动力。何博士还着重强调了下一步可在知识驱动的复杂任务导向人机对话和超出文本的多模态数据和信息融合两个方向发力,推动多模态人机对话与交互,并将人机对话系统落实到产业应用上,包括智能客服、智能交互营销、智能消费媒体等。

以下是何晓冬博士在大会的演讲实录,AI 科技评论进行了不修改原意的整理和编辑:

一、人机对话的构想与进展

70 年前提出图灵测试时,图灵选择将人与机器之间的对话作为判断机器是否具有智能的标准。他的选择并不是随意的。图灵认为对话是人特有的高级智能,只有当机器能够与人进行长时间对话时,才称得上是拥有了类人的智能。

人机对话不但是一个科学问题,也是一个技术问题。

自计算机发明以来,研究人员一直在致力于如何克服“人机交流障碍”,如何使人和机器的交流变得越来越简单。人机交互技术每往前进一步,使用计算机的人就增加几个数量级,产业价值也往往随着快速增长。下一步,我们希望计算机能与人类进行更加自如的智能的交流,从而让机器能更好的帮我们完成更多更复杂的任务。

距离图灵测试提出 16 年后,MIT 开发出第一个人机对话机器人 Eliza。但当时它只是简单模仿人的行为,谈不上智能。到上世纪 90 年代,人机对话进入了一个新的发展阶段,大家开始讨论怎么让计算机理解人类意图与执行命令。2012 年,以苹果的 Siri 为代表的智能个人助理成为主流,随后出现更多的对话机器人,如微软小冰等等。这些机器人不但能完成你下达的任务,还能逐渐跟用户建立情感上的联系。我们预想,今后会出现越来越多能与人自由交互的机器人,人类将真正与机器人共存。

人机对话领域一直十分活跃。今年 1 月,谷歌开发了一个大规模端到端的对话模型,Facebook 也在 4 月发布了一个对话模型。这些对话模型都是基于深度学习结构和 Transformer 变种的模型大规模训练出来的,在闲聊等场景表现出很强的应答有效性和精确性。

二、GPT-3 的机遇与挑战

人机交互在文字自动生成方面也有了较大进展,如 GPT-3。我认为 GPT-3 是研究和工程结合的一个典范。虽然 GPT-3 本质上仍基于 Transformer 模型,但 OpenAI 在开发的过程中运用了 3000 亿单词进行训练,模型内含 1750 亿参数,覆盖 50 多个任务,用到 28.5 万个 CPU 核和 1 万个 V100GPU 做训练,最终取得了一个非常好的表现。GPT-3 让大家开始幻想:机器还有多久能模拟人的智能?

目前来看,仍是长路漫漫。仅仅从“硬件”角度来看,人类大脑有 860 亿神经元、100-1000 万亿联接,能处理的任务也远远超过 GPT-3。

GPT-3 的强大有目共睹。它可以执行很多任务。如果让它生成某个特定的网页,它不但能生成网页,还能生成网页对应的 HTML 代码。它也可以直接转换语言的风格。比如你写一个很幽默的句子,GPT-3 很容易就能将句子的风格转变成严肃的 style。它还可以写作、聊天、翻译、问答等等。如果给它看棋谱,它还会下象棋。按照 Open AI 的统计,如果让 GPT-3 生成一段很长的故事,再让人判断这段故事是人写还是机器写,发现人类判断准确的概率只有 52% 左右。这是一个令人非常感叹的结果。

但 GPT-3 处理另外一些简单工作的表现并不是特别好。如果你让它做一位数、两位数的加法,正确率基本能达到百分之百,但如果你让它用 5 位数加 5 位数,它的正确率就会迅速下降。这一点很奇怪。如果一个小孩已经学会加法,一般不会再出现很大的错误,除非是粗心。但是计算机是不会粗心的。再比如,如果用户去问 GPT-3 新冠疫情会在什么时候结束,它会给你一个答案: 2023 年 12 月 31 日。当然,我们现在没法验证这个答案的可信度,但这不是关键,关键是 GPT-3 依据什么样的证据来给出这个答案?如果它给不出证据的话,我们怎么相信这个答案是有效的?这说明计算机并没有真正做到逻辑理解和推理,它只是通过模式的匹配和某种泛化的规范的记忆来得到结果。

诸如 GPT-3 之类的超大规模语言模型实验给我们带来非常有趣的思考和挑战:

1、技术路线

人类智能/AI 的许多问题与不完备规则相关。对话系统就是一个典例。它不像围棋也不像扑克。它没有完备的规则和知识边界。因此,我们可能会问:端到端的架构能力边界在哪里?超大规模的模型对知识有海量的记忆能力,展现出很强的泛化能力,在开放领域的对话能力出色,精确性、有效性的表现还不错。但这是因为它有很强的归纳能力和泛化记忆能力。在推演和演绎方面,超大规模语言模型在符号推理、输出可控和可解释方面还较弱。这是我们下一步需要聚焦的。

2、评测指标

我们希望机器拥有拟人的智能,但我们怎么判断拟人呢?是在对话层次上还是整体体验上判断?在实现传统的闲聊时,我们希望机器所说的每句话都能像人一样,分辨不出是人写的还是机器写的。如果从端到端来看,我们做闲聊的社交机器人,我们希望它在交流层次上能够拟人,让我们有一种陪伴的感觉。在做任务导向的机器人的时候,我们更关注的是任务达成,并希望机器人能在达成和效率上反映整体的对话体验,而不是简单评估每一个回复是不是对的。

3、系统任务

什么是任务?对话的一个核心问题是理解语言,但理解语言并不是对话的最终极目标。在很多的复杂人机对话和交互里面,交互是多模态的,另外目的也超过了简单的理解意图。比如说咨询导购,这是一种很常见的人和人之间对话的任务,但这个任务的目的不只是为了理解用户、回答用户咨询,很多时候是要完成一个“销售”的任务。这是更深层次的一个系列的博弈和决策,最后使得销售的任务可以达成。从这个角度来说,文本只是一种呈现形式。

三、GPT-3 后,人机交互何去何从?

我认为 AI 不仅可以进行简单的浅层的任务,还可以尝试更多需要知识驱动的任务,比如复杂的任务型的对话系统。这类任务需要领域知识及基础常识的支撑,需要深度的推理与决策,不能通过简单泛化记忆模型来解决。另外一个是多模态数据。模态交叉将带来比目前高几个数量级的数据,而跨模态的数据信息融合 (pooling)和联接(grounding)将能使无监督学习(predictive learning) 更高效的获得更通用的模型。比如通过海量文本、语音、图像、视频数据建设跨模态数据集和知识库。多模态数据可能可以帮助我们的模型超越语言,跟实体世界进一步结合,帮助我们更好地获得人类世界的知识。

1)知识驱动的复杂任务导向人机对话

在用户在与机器人导购或销售聊天时,表层是交互、关怀、交流,但在底层则需要大量的技术支撑,包括多轮对话管理、认知智能、情感智能和推理与决策等。

比方说,如果顾客表示想给他的父母买一台电视机当节日礼物,客服机器人马上判断出来,并会结合情景判断父母的年龄可能比较大,推荐更合适的商品。接着客户可能会惊讶为什么推荐的电视机这么贵,这时对话机器人能够理解客户的真实意图——他不是不买,而是对价格有点失望,需要一个解释。于是机器人通过信息的挖掘,解释为什么这个商品更适合他,甚至进一步给用户推荐超值优惠活动,帮助顾客开心地完成礼物购买,整个对话达到双赢的结局。

对话不光是语言理解,还是一种博弈和决策。比如说,我们需要 AI 学会怎么做金牌销售,从大量数据中学习销售的语言技巧和对话策略以优化全局销售的结果为模型学习的目标。我们在看对话的时候不止是看到语义理解和语音识别,更多的是了解对话的具体目的和任务。这一目标的实现需要具体的技术支持。

自然语言任务的决策优化是一个很难的问题。AlphaGo 是一项很伟大的工作,但围棋的执行空间比较有限,每一步只能选 361 个点。从语言的角度来说,对话的每一句话可以有无限的选择,在这种情况下你怎么进行强化学习、掌握最好的规划策略?这是一个比较 open 的问题。

此外,人机对话能否基于很长的上下文做意图识别。比如说,用户说了很多话,哪些字或者哪些句子是真正定义这个用户的意图的,我们需要精确分辨出来并给予一定的可解释性。

除了分辨意图之外,我们还要对自然语言的语义进行表征。我们需要把每一个自然语言的描述(最好能把它的语义)用一个向量提取出来,在同一个语义空间表示。当不同的人表达不同的方式时,只要意图相近就很容易判断出来。

另外,我们可以通过在连续空间里面投影我们的知识,再把这个知识的点和整个知识图谱都投影到一个连续语义空间里面,在这个空间里面做很多直接的计算,判断这个知识的一致性,并进行知识的补全。

2)超出文本的多模态数据和信息处理

多模态的智能和多模态的数据迎来了很多新的机会。

如果我们想理解一个实体,比如说奥巴马,我们可以通过读文字、看图片或者听他的演讲来理解他,甚至可以通过看他和他周围的亲戚、党派、出生地等等知识对他有一个更好的了解。这些信息以前分属于不同的模态,所以研究起来很分裂。

基于新的深度学习模型,我们有可能把不同模态的信息投影到统一的语义空间,在这个空间里面做很多计算,帮助我们从各个角度理解这些信息。比如说,把文字和图片投向同一个空间,这样很快就可以知道文字和图片是不是描述同样的意思,然后生成一张图片,迅速用语言模型来描述它真正的视觉信息,帮助我们更好地理解语言和视觉之间的互相管理。

我们还可以通过建立跨模态知识库连接视觉、语言和实体的信息。这是我们之前做的一个全球名人数据库 “MS-Celeb-1M”(见下图),把人的图像信息和知识图谱里面的实体信息进行连接。在这张图片里,我们不光识别出一个人,我们还知道她是 1982 年出生的,是一个美国人,在某一个剧里演了某个角色,这样我们对这个实体的人的了解知识迅速丰富起来。

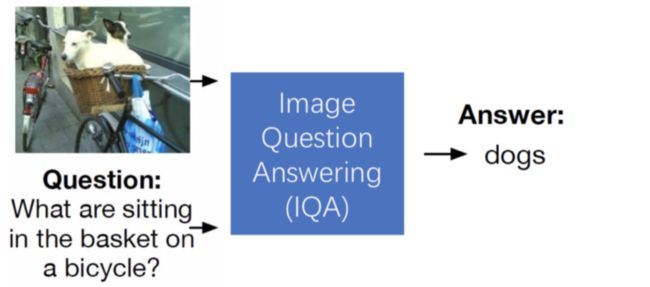

除此之外,我们可以通过多模体做视觉信息到语义推理的问答。基于一张简单的图片或者问题,我们有没有可能建造一个模型帮助我们回答疑问?这就意味着我们需要建设一系列语言模型、视觉模型,特别是需要建立一个多层的语言和视觉信息交换的模型,可以提取出最好的信息,帮助我们在语言和视觉之间联合理解蕴涵的多模态信息。

我们还模拟人的注意力机制提出了“bottom-up and top-down attention “ 机制,让语言和视觉跨模态的信息融合和理解更高效。

我们还可以先理解语言再创作图画。我们把“一只红羽毛白肚子点短咀小鸟”这句话梳理文字给 AI 的时候,有没有可能 AI 在画这只小鸟的时候,学会对应看那个语言对应的语义,知道什么地方应该画什么颜色,比如肚子上要画白色,羽毛上画红色,在头部画一个短嘴,最后凭空合成这么一张小鸟图片。

通过一系列的模型,我们可以在视觉和语言这两个最重要的模态中间建立信息的交换、融合。我们也可基于这类模型做艺术创作,让计算机学会怎么创作一个艺术地图、怎么写书法。

大家知道《兰亭集序》开头的 4 个字“永和九年”(如下图)。这里面有 4 个字是王羲之写的,另外四个是 AI 模仿王羲之的风格写的。大家能看出哪些是王羲之胁的,哪些是 AI 写的?确切来说,圈出来的字是 AI 写的。AI 书写还有一些瑕疵,比如“九”字是有瑕疵的,“和”“年”这两个字则十分完美。而且 AI 还可以写出带有不同情绪的书法,兴奋时写得比较轻快,悲伤时写得比较顿挫。

基于这种新的多模态交互技术,配上之前的人机对话任务,有可能让我们的模型在 GPT-3 后更向前走一步。

【 图片来源:null 所有者:null 】

上图所示是京东的一个人类顾客与机器客服的交流,交流过程中双方使用了大量图片直接表达信息。

这是一个实际的产业应用的例子。在我们生活中,人和人、人和客户交互,肯定不止是语言和对话,肯定有多模态、视频、图像。有时候图片表达比文字表达更直接有效,这也从应用角度反过来驱动我们更好地把对话或者语言模型进一步向多模态智能模型提升。

四、人机对话系统落地

产业界对人机对话系统的需求很大。在过去的几年里也出现了一些特定领域的应用,比如京东的智能客服、微软小冰、亚马逊智能音箱等等。我们发现在特定领域确实对话系统通常表现好,在很多时候能提升我们的工作效率,降低工作成本,甚至可以提升顾客体验。但是在开放领域、对可靠性有很高要求的时候,对话系统还是一个很大的挑战。

京东深耕智能对话与交互平台的应用,比如智能客服、智能营销、导购、智能消费媒体等等,希望把人机对话技术在产业界落地,创造新价值,引发新思考。

我们将 TTS、ASR、语义理解跟工单结合,打通工单系统与快递系统,谋求一体化,给客户提供一个比较无缝的售中/售后服务体验。

销售 AI 比客服 AI 的发明过程更难。客服只负责让你满意,销售必须让顾客下单。我们在销售智能这一块投入了许多,比如摸索如何通过多模态的卖点营销,把商品最亮的亮点给用户一下提出来;如何通过对话式的商品推荐,把最合适的商品推荐给用户;我们甚至可以通过智能系统促进下单成交。比如用户咨询以后,如果有一段时间没有反应,我们可以再跟进一下。比如上次咨询某个产品很好,现在它的优惠快过期了,用户要不要下单。这是我们从金牌销售的技巧中学到的,但我们并不是让金牌销售手把手教 AI,而是通过大量的学习、甚至通过某种程度的强化学习,让 AI 从金牌销售那里学到该怎么交流,怎么对话能更有效。我们内部也在看人工导购和通过机器辅助导购的转化率,发现机器导购可以带来转化率的直接提升。

在衡量对话系统成功的指标时,我们发现,在导购场景下,顾客和客服聊的时间越长,他下单的概率越大;但如果是售后场景,顾客跟客服聊得越长,他越不满意。

除了对话营销之外,我们还可以通过多模态的交互技术生成消费媒体。这个可以看成是广义的对话,它不是一轮一轮的应答,而是某种程度上产生信息的交互,使得用户感知到这些信息,促进用户做下一轮的行为。这些是针对新的商品在不同的情况下给出不同的销售文案(如下图),在京东网页客服对话的情景下,用不同的形式、不同的风格、不同的语气来表达商品的特点,使用户更能体会到商品的优点。我们达到了风格多变、可控的结果。

我们还可以通过数字人多模态交互,综合语音、情绪、视觉形象等等做一种更加自然、更加拟人化的人和机器的交互。通过人工智能技术,我们希望可以为数以亿计的每一个商品都配上一个带货主播和专属客服。

此外,我们通过智能对话技术赋能 IoT 设备,使得硬件更好地连接起来,使得我们可以开拓更多的新市场。

从研究到应用之间往往存在一个期望的不匹配,一个“技术应用鸿沟”。很多时候,当一个新技术刚出来,人们往往希望在短时间内就看到它的爆发或者巨大的价值增长,但实际上,我们往往高估了它短期带来的价值,但低估了它的长远价值。因为很多时候,单项新技术的价值往往是有限的,需要跟其他技术连接之后,才能构成一个技术的网格、真正解决我们的问题,提高价值。比如很多年前语音识别就能提供 API,但是价值一直没有得到很好的体现。如果我们把语音识别、语言理解、计算机视觉、IoT 和云计算综合起来,就可以创造更大的能力,解决更大的问题,带来更大的价值。

另一方面,新的技术是需要一个应用生态的。如果一项技术只是为了服务单一的应用,开发技术的成本往往会显得特别高,没有被摊平。如果有一个繁荣的应用生态,技术可以复用,那么技术开发成本就会迅速降低,产生的价值也会继续增长。所以在探索智能对话和交互技术的时候,我们会考虑客服、交互营销、消费媒体、创意产业、智能硬件。长期来看,未来 10 年 AI 技术带来的价值将呈非线性的迅速增长,而目前来看,我们需要进一步促进技术联接和培养应用生态。参考文献:

Computing Machinery and Intelligence (Alan Turing, 1950)

Anderson, He, Buehler, Teney, Johnson, Gould, Zhang, “Bottom-Up and Top-Down Attention”, CVPR 2018

Adiwardana, Luong, So, Hall, Fiedel, Thoppilan, Yang, Kulshreshtha, Nemade, Lu, Le, "Towards a Human-like Open-Domain Chatbot", https://arxiv.org/abs/2001.09977

Brown et al., “Language Models are Few-shot learners,” 2020.

Vaswani et al., "Attention is all you need." 2017

Fang, Gupta, Iandola, Srivastava, Deng, Dollar, Gao, He, et al., “From Captions to Visual Concepts and Back,” CVPR2015

Guo, Zhang, Hu, He, Gao, “MS-Celeb-1M”, ECCV 2016

He, Chen, He, Gao, Li, Deng, Ostendorf, “Deep Reinforcement Learning with a Natural Language Action Space,” ACL2016

Huang, He, Gao, Deng, Acero, Heck, “Deep Structured Semantic Model”, CIKM2013

Liu et al., Mappa Mundi: An Interactive Artistic Mind Map Generator with Artificial Imagination, IJCAI 2019 雷锋网

Chen et al., MaLiang: An Emotion-Driven Chinese Calligraphy Artwork Composition System, ACM MM 2020 雷锋网

Smith, Williamson, Shuster, Weston, Boureau, “Can You Put it All Together: Evaluating Conversational Agents' Ability to Blend Skills," ACL 2020

Xu, Zhang, Huang, Zhang, Gan, Huang, He, “AttnGAN,” CVPR 2018

Yang, He, Gao, Deng, Smola, “Stacked Attention Networks,” CVPR 2016

Yang, Yang, Dyer, He, Smola, Hovy, “Hierarchical Attention Networks”, NAACL 2016

Yang, Yih, He, Gao, Deng, “Embedding entitles and relations for learning and inference in knowledge bases”, ICLR 2015

Zhang, Yang, He, Deng, “Multimodal Intelligence: Representation Learning, Information Fusion, and Applications”, IEEE JSTSP, March 2020