pandas数据处理效率提升方法

在进行业界大规模数据处理及特征工程的时候,往往需要对dataframe进行处理。而处理方式一般人会选择用apply的方式。

apply方式进行了一些底层的优化,相比直接对dataframe进行for循环效率高了很多。

但是,尽管使用了apply后,依然有很多优化的空间。

方法如下:

Pandas循环提速7万多倍

文中提到了一种用numpy进行优化的方法,但是具体的实施方式说得并不清楚。

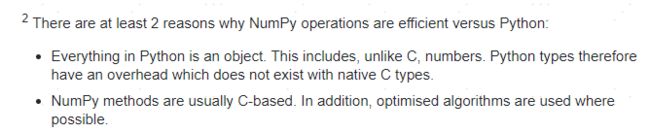

至于为什么采用numpy会对pandas的循环有如此明显的效果优化,stack overflow给出了解释。

那么了解了numpy的优势之后,为了优化代码,则需要将之前的方法替换成numpy的方式。这里我们以一个维度(16307, 20)的dataframe进行说明。目前涉及到的主要有以下三种:

1.直接进行values维度计算

利用timeit监测两种方式的运行时间

%%timeit

df['amount'] = df['last_kj_amount'] + df['last_15day_amount']

567 µs ± 32 µs per loop (mean ± std. dev. of 7 runs, 1000 loops each)

%%timeit

df['amount2'] = df['last_kj_amount'].values + df['last_15day_amount'].values

221 µs ± 19 µs per loop (mean ± std. dev. of 7 runs, 1000 loops each)

在当前数据量并不大的情况下,速度只提升了一倍,如果在生产中使用values值进行计算的话优化效果更好。

2.利用np.vectorize代替apply

这里我们对上面计算的结果进行向上取整,采用两种方式对比,并用timeit监测运行时间。

%%timeit

df['safe_amount1'] = df.apply(lambda x:math.ceil(x['amount']),axis = 1)

243 ms ± 16.8 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

def getInt(x):

return math.ceil(x)

%%timeit

df['safe_amount2'] = np.vectorize(getInt)(df['amount'])

4.05 ms ± 162 µs per loop (mean ± std. dev. of 7 runs, 100 loops each)

可见采用np.vectorize方式,时间缩短了近60倍。

3.利用np.where代替apply

np.where类似于if…else语句,主要是用来进行条件判定和数据筛选。

%%timeit

df['signal'] = df.apply(lambda x: 1 if x['last_15day_amount'] == 0 and x['statis_date'] == 20200506 and x['time_type'] == 2 else 0,axis = 1)

269 ms ± 31.8 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

%%timeit

df['signal1'] = np.where((df['last_15day_amount'] == 0)&(df['statis_date'] == 20200506)&(df['time_type'] == 2),1,0)

1.59 ms ± 196 µs per loop (mean ± std. dev. of 7 runs, 100 loops each)

可见,np.where方式时间缩短了近170倍。

以上是最近工程中遇到的主要优化方式,后续想到继续更新。