caffe常用网络层及参数说明

通用参数设置

layer {

name: "net1"

type: "Data、Scale、Convolution、ReLU、Pooling、Eltwise、InnerProduct、Accuracy、Softmax、Python"

bottom: "data"

top: "net1"

param {

lr_mult: 1.0

decay_mult: 1.0

}

}name:根据网络总的位置可自定义一个相关的名字。

type:网络层类型。

bottom:前一层的输入。

top:这一层的输出。

param:设置通用参数。

lr_mult:学习率系数, 最终学习率是lr_mult*solver.prototxt配置文件中的base_lr

decay_mult 权值衰减 最终权值衰减decay_mult*solver.prototxt的weight_dacay

所以权值更新 wi = wi -(base_lr * lr_mult) *dwi - (weight_dacay * decay_mult) * wi (dwi是误差关于wi的偏导数)

如果有两个lr_mult, 则第一个表示权值的学习率,第二个表示偏置项的学习率。

lr_mult、decay_mult仅在有参数的层出现,比如卷积层、全连接层。

1.data层

网络的输入,维度为NCHW。

name: "SequeezeNet"

input : "data"

input_dim: 1

input_dim: 3

input_dim: 65

input_dim 150name: "SSD300"

input : "data"

input_shape {

dim: 1

dim: 3

dim: 300

dim: 300

}2.Normalize层

layer {

name: "conv4_3_norm"

type: "Normalize"

bottom: "conv4_3"

top: "conv4_3_norm"

norm_param {

across_spatial: false

scale_filler {

type: "constant"

value: 20

}

channel_shared: false

}

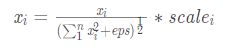

}归一化层主要作用是将空间或者通道内的元素归一化到0到1之间,具体公式可以表示为:

normalize层有两个参数,一个是across_spatial_另一个是channel_shared_。

across_spatial_参数表示是否对整个图片进行归一化,归一化的维度为:1 x c x h x w,否则对每个像素点进行归一化:1 x c x 1 x 1。

channels_shared表示scale是否相同,如果为true,则scale_i都是一样的,否则对于同像素点位置一样,对不同像素点是不一样的。

3.Permute层

layer {

name: "conv4_3_norm_mbox_loc_perm"

type: "Permute"

bottom: "conv4_3_norm_mbox_loc"

top: "conv4_3_norm_mbox_loc_perm"

permute_param {

order: 0

order: 2

order: 3

order: 1

}

}permute是SSD特有的层,功能类似于np.swapaxes,相当于交换caffe_blob中数据的维度。例如,经过conv4_3_norm_mbox_loc_perm层后,caffe里面blob顺序由[batch_size,channels,height,width]变为[batch_size,height,width,channels]。

4.Flatten层

layer {

name: "conv9_2_mbox_conf_flat"

type: "Flatten"

bottom: "conv9_2_mbox_conf_perm"

top: "conv9_2_mbox_conf_flat"

flatten_param {

axis: 1

}

}将多维数据拉成向量:Flatten层是把一个输入的大小为N*C*H*W变成一个简单的向量,其大小为 N*(C*H*W)。当Reshape层的param参数为:{ shape { dim: 0 dim: -1 } } ,那么输出和flatten输出是完全一样的。所以,flatten相当于是reshape的特例。

5.Concat层

layer {

name: "mbox_priorbox"

type: "Concat"

bottom: "conv4_3_norm_mbox_priorbox"

bottom: "fc7_mbox_priorbox"

bottom: "conv6_2_mbox_priorbox"

bottom: "conv7_2_mbox_priorbox"

bottom: "conv8_2_mbox_priorbox"

bottom: "conv9_2_mbox_priorbox"

top: "mbox_priorbox"

concat_param {

axis: 2

}

}按指定维度进行拼接,通过axis指定拼接的维度。caffe中数据通常为4个维度,即 NCHW,因此默认值1表示channels通道进行拼接。

6.reshape层

layer {

name: "mbox_conf_reshape"

type: "Reshape"

bottom: "mbox_conf"

top: "mbox_conf_reshape"

reshape_param {

shape {

dim: 0

dim: -1

dim: 2 ####12

}

}

}只改变输入数据的维度,内容不变。“dim:0”表示维度不变,“dim:2”或“dim:3”表示将原来维度变为2或3,“dim:-1”表示由系统自动根据之前维度推断出当前维度。

7.slice层

layer {

name: "slicelayer"

type: "Slice"

bottom: "labels"

top: "labels1"

top: "labels2"

top: "labels3"

top: "labels4"

top: "labels5"

top: "labels6"

top: "labels7"

top: "labels8"

slice_param {

axis: 1

slice_point: 1

slice_point: 2

slice_point: 3

slice_point: 4

slice_point: 5

slice_point: 6

slice_point: 7

}

}slice层,可根据给定的维度将bottom切分成多个top,用于具有多个输入多任务的网络。slice层有三个参数,axis和slice_dim用于指定切分的维度是什么,默认为1,切分channel维度,还有另一个选择就是切分num,类似于Concat层,但是注意这两个参数只能指定一个,常用axis。第三个参数就是指定从哪里开始切分,怎么切分?这个参数就是slice_point。

8、Interp层

layer {

name: "conv7_2_us"

type: "Interp"

bottom: "conv7_2"

top: "conv7_2_us"

interp_param {

height: 38

width: 38

}

}注意可按需求改为interp_param{height:38 width:38}(即固定特征图的尺寸),也可以不需要这个interp_param参数。

参考文献:

- https://blog.csdn.net/liu1152239/article/details/81478313

- https://blog.csdn.net/CSDNhuaong/article/details/83660018

- https://blog.csdn.net/qq_31261509/article/details/83650591

- https://www.cnblogs.com/wmr95/p/8715607.html

- https://www.cnblogs.com/cvtoEyes/p/8623287.html