散列思想

散列表就是我们平常说的哈希表,英文名叫"Hash Table",其基础依据就是:

散列表用的是数组支持按照下标随机访问数据的特性,所以散列表其实就是数组的一种扩展,由数组演化而来。可以说,如果没有数组,就没有散列表。

这里还是直接使用老师的例子来说事吧.中间添加自己的思想就行了.自己想例子又得半天,而且我们的目标也不是想一个好例子,而是真正理解并掌握知识.对吧?

用一个例子来解释一下。假如我们有 89 名选手参加学校运动会。为了方便记录成绩,每个选手胸前都会贴上自己的参赛号码。这 89 名选手的编号依次是 1 到 89。现在我们希望编程实现这样一个功能,通过编号快速找到对应的选手信息。你会怎么做呢?

我们可以把这 89 名选手的信息放在数组里。编号为 1 的选手,我们放到数组中下标为 1 的位置;编号为 2 的选手,我们放到数组中下标为 2 的位置。以此类推,编号为 k 的选手放到数组中下标为 k 的位置。 因为参赛编号跟数组下标一一对应,当我们需要查询参赛编号为 x 的选手的时候,我们只需要将下标为 x 的数组元素取出来就可以了,时间复杂度就是 O(1)。这样按照编号查找选手信息,效率是不是很高?

实际上,这个例子已经用到了散列的思想。在这个例子里,参赛编号是自然数,并且与数组的下标形成一一映射,所以利用数组支持根据下标随机访问的时候,时间复杂度是 O(1) 这一特性,就可以实现快速查找编号对应的选手信息。

你可能要说了,这个例子中蕴含的散列思想还不够明显,那我来改造一下这个例子。

假设校长说,参赛编号不能设置得这么简单,要加上年级、班级这些更详细的信息,所以我们把编号的规则稍微修改了一下,用 6 位数字来表示。比如 051167,其中,前两位 05 表示年级,中间两位 11 表示班级,最后两位还是原来的编号 1 到 89。这个时候我们该如何存储选手信息,才能够支持通过编号来快速查找选手信息呢?

思路还是跟前面类似。尽管我们不能直接把编号作为数组下标,但我们可以截取参赛编号的后两位作为数组下标,来存取选手信息数据。当通过参赛编号查询选手信息的时候,我们用同样的方法,取参赛编号的后两位,作为数组下标,来读取数组中的数据。 这就是典型的散列思想。其中,参赛选手的编号我们叫作键(key)或者关键字。我们用它来标识一个选手。我们把参赛编号转化为数组下标的映射方法就叫作散列函数(或“Hash 函数”“哈希函数”),而散列函数计算得到的值就叫作散列值(或“Hash 值”“哈希值”)。

所以散列表的思想就是:

散列表用的就是数组支持按照下标随机访问的时候,时间复杂度是 O(1) 的特性。我们通过散列函数把元素的键值映射为下标,然后将数据存储在数组中对应下标的位置。当我们按照键值查询元素时,我们用同样的散列函数,将键值转化数组下标,从对应的数组下标的位置取数据。

散列函数

从上面的例子我们可以看出,如何将键转换为数组的下标这是至关重要的一步,而这一步正是散列函数所起得作用.

散列函数其实就是hash(key),其中key就是键值,hash(key)表示经过散列函数计算得到的散列值.

比如,改造后的例子的散列函数就是:

int hash_fun(string key)

{

//提取最后两位字符

string LastTwoChars = key.substr(key.length() - 2, 2);

//将其转换为 int 类型

int index = stoi(LastTwoChars);

return index;

}

以上就是散列的入门了,现在我们来看一些复杂的操作.

如果参赛选手的编号是随机生成的 6 位数字,又或者用的是 a 到 z 之间的字符串,该如何构造散列函数呢?我总结了三点散列函数设计的基本要求:

- 散列函数计算得到的散列值是一个非负整数(要作为数组下标来使用)

- 如果 key1 = key2,那 hash(key1) == hash(key2)(相同的key,相同的散列值)

- 如果 key1 ≠ key2,那 hash(key1) ≠ hash(key2)(难以办到,会出现

散列冲突。而且,因为数组的存储空间有限,也会加大散列冲突的概率)

散列冲突:其实就是说,有时候可能key不相同,但通过该散列函数计算出来的散列值是相同的.

如何解决散列冲突?

再好的散列函数也无法避免散列冲突。那究竟该如何解决散列冲突问题呢?我们常用的散列冲突解决方法有两类,开放寻址法(open addressing)和链表法(chaining)

1. 开放寻址法

开放寻址法的核心思想就是,如果出现了散列冲突,我们就重新探测一个空闲位置,将其插入。那如何重新探测新的位置呢?主要有以下几种方法:

(1) 线性探测(Linear Probing)。

当我们往散列表中插入数据时,如果某个数据经过散列函数散列之后,存储位置已经被占用了,我们就从当前位置开始,依次往后查找,看是否有空闲位置,直到找到为止。

举一个例子具体说明一下。这里面黄色的色块表示空闲位置,橙色的色块表示已经存储了数据。

从图中可以看出,散列表的大小为 10,在元素 x 插入散列表之前,已经 6 个元素插入到散列表中。x 经过 Hash 算法之后,被散列到位置下标为 7 的位置,但是这个位置已经有数据了,所以就产生了冲突。于是我们就顺序地往后一个一个找,看有没有空闲的位置,遍历到尾部都没有找到空闲的位置,于是我们再从表头开始找,直到找到空闲位置 2,于是将其插入到这个位置。

这是其插入,那么如何查找呐?

我们通过散列函数求出要查找元素的键值对应的散列值,然后比较数组中下标为散列值的元素和要查找的元素。如果相等,则说明就是我们要找的元素;否则就顺序往后依次查找。如果遍历到数组中的空闲位置,还没有找到,就说明要查找的元素并没有在散列表中。

这是其查找,那么如何删除一个元素呐?

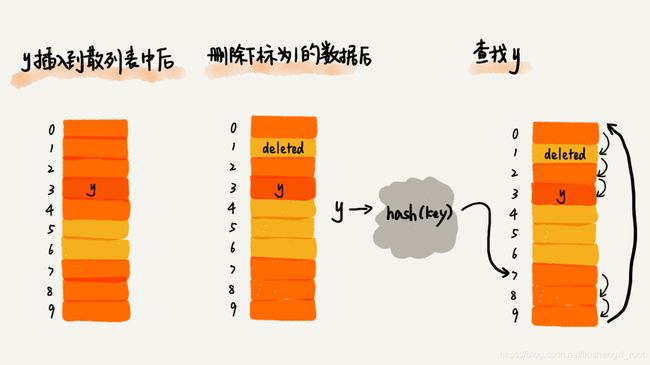

将删除的元素,特殊标记为 deleted。当线性探测查找的时候,遇到标记为 deleted 的空间,并不是停下来,而是继续往下探测。

提问:为什么不把要删除的元素设置为空呐?

因为在查找的时候,一旦我们通过线性探测方法,找到一个空闲位置,我们就可以认定散列表中不存在这个数据。但是,如果这个空闲位置是我们后来删除的,就会导致原来的查找算法失效。本来存在的数据,会被认定为不存在

散列表的缺点

当散列表中插入的数据越来越多时,散列冲突发生的可能性就会越来越大,空闲位置会越来越少,线性探测的时间就会越来越久。极端情况下,我们可能需要探测整个散列表,所以最坏情况下的时间复杂度为 O(n)。同理,在删除和查找时,也有可能会线性探测整张散列表,才能找到要查找或者删除的数据。

(2) 二次探测(Quadratic probing)

二次探测与线性探测很像,线性探测每次探测的步长是 1,那它探测的下标序列就是 hash(key)+0,hash(key)+1,hash(key)+2……而二次探测探测的步长就变成了原来的“二次方”,也就是说,它探测的下标序列就是 hash(key)+0,hash(key)+1^2,hash(key)+2^2……

(3) 双重散列(Double hashing)

所谓双重散列,意思就是不仅要使用一个散列函数。我们使用一组散列函数 hash1(key),hash2(key),hash3(key)……我们先用第一个散列函数,如果计算得到的存储位置已经被占用,再用第二个散列函数,依次类推,直到找到空闲的存储位置。

以上三种方法,在遇到插入的数据越来越多时,散列冲突发生的可能性也会越来越大,一般情况下,我们都会在散列表中维持一定比例的空闲槽位,来保证效率.我们用装载因子来表示空位的多少.

散列表的装载因子 = 填入表中的元素个数 / 散列表的长度

装载因子越大,说明空闲位置越少,冲突越多,散列表的性能会下降。

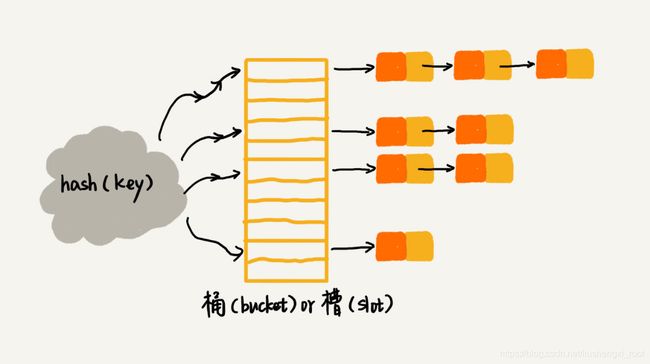

2. 链表法

链表法是一种更加常用的散列冲突解决办法,相比开放寻址法,它要简单很多。我们来看这个图,在散列表中,每个“桶(bucket)”或者“槽(slot)”会对应一条链表(其实就是类似于邻接表,不是吗?),所有散列值相同的元素我们都放到相同槽位对应的链表中。

当插入的时候,直接找到对应的槽位,头插链表即可,时间复杂度为O(1).查找与删除自然需要遍历对应的整个链表完成,时间复杂度是O(k),k是指链表长度.对于散列比较均匀的散列函数来说,理论上讲,k=n/m,其中 n 表示散列中数据的个数,m 表示散列表中“槽”的个数。

一些思考题:

- Word文档中的单词拼写检查功能是如何实现的?

平常所用的单词就20万个,而一个单词假设有10个字母,那么就是2百万的字母,即2百万字节,也就是2MB,再大点也就是200MB,计算机内存完全可以放得下,所以我们使用散列表来存储整个英文词典

当用户输入某个英文单词时,我们拿用户输入的单词去散列表中查找。如果查到,则说明拼写正确;如果没有查到,则说明拼写可能有误,给予提示。借助散列表这种数据结构,我们就可以轻松实现快速判断是否存在拼写错误。

- 假设我们有 10 万条 URL 访问日志,如何按照访问次数给 URL 排序?

答:这道题刚开始我不明白是什么个意思,后来看了答案,品了几天,算是终于明白了.

首先我们要搞清楚排序的对象是什么?其实很明显,就是URL,只不过得按照访问次数进行排序.比如下面这个的例子:

www.1111.xxxxx

www.2222.xxx

www.1111.xxxxx

那么结果是什么呐?

www.1111.xxxxx

www.2222.xxx

就是上面这样就行了

由例子可知,我们必须遍历一遍,找到对应的URL的访问次数和去掉重复的URL.

然后我们去按照访问次数排序去掉重复的URL的URL集合即可.

sort(set.bagin(),set.end(),[](string lhs,string rhs){

return HashTable[hashfun(lhs)] < HashTable[hashfun(rhs)];

// 按照访问次数排序`URL`集合

}

- 有两个字符串数组,每个数组大约有 10 万条字符串,如何快速找出两个数组中相同的字符串?

答:以第一个字符串数组为基准建立散列表.具体以字符串为 key ,以出现次数为value ,默认为0.然后遍历第二个字符串数组,用每一个字符串去找,如果value != 0 ,就说明找到一个两个数组中相同的字符串.

由以上可知,散列表的查询效率与散列函数,装载因子等有莫大的关系.如果使用的是链表,就有可能从O(1)的查询效率退化为O(n),这是我们不允许的.那么如何解决这个问题呐?或者说是我们如何设计一个可以应对各种异常情况的工业级散列表,来避免在散列冲突的情况下,散列表性能的急剧下降,并且能抵抗散列碰撞攻击?这就是我们这一节要谈论的问题了

如何设计散列函数?

一个好的散列函数应该具有以下几点:

- 散列函数的设计不能太复杂。(过于复杂的散列函数,势必会消耗很多计算时间,也就间接的影响到散列表的性能 )

- 散列函数生成的值要尽可能随机并且均匀分布.(这样才能避免或者最小化散列冲突,而且即便出现冲突,散列到每个槽里的数据也会比较平均,不会出现某个槽内数据特别多的情况。)

散列函数主要有:直接寻址法、平方取中法、折叠法、随机数法,数据分析法等(这些只要了解就行了)

提问:散列函数的作用到底是什么?

答:将key转换为数组的索引 hashfun(key)

装载因子过大了怎么办?

散列表基于数组设计,在申请时就固定了大小.所以对于动态频繁的散列表来讲,装载因子也一定会变得越来越大.一个可以采取的方法就是:动态扩容(其实就和vector一样)

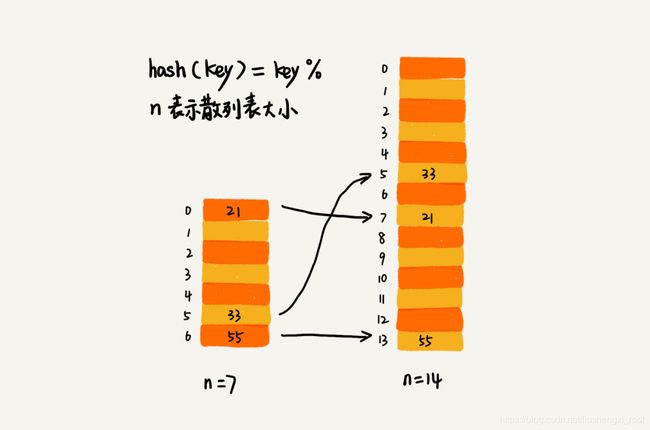

重新申请一个更大的散列表,将数据搬移到这个新散列表中。假设每次扩容我们都申请一个原来散列表大小两倍的空间。如果原来散列表的装载因子是 0.8,那经过扩容之后,新散列表的装载因子就下降为原来的一半,变成了 0.4。

针对数组的扩容,数据搬移操作比较简单。但是,针对散列表的扩容,数据搬移操作要复杂很多。因为散列表的大小变了,数据的存储位置也变了,所以我们需要通过散列函数重新计算每个数据的存储位置。

你可以看我图里这个例子。在原来的散列表中,21 这个元素原来存储在下标为 0 的位置,搬移到新的散列表中,存储在下标为 7 的位置。

插入时间复杂度:

插入一个数据,最好情况下,不需要扩容,最好时间复杂度是 O(1)。最坏情况下,散列表装载因子过高,启动扩容,我们需要重新申请内存空间,重新计算哈希位置,并且搬移数据,所以时间复杂度是 O(n)。用摊还分析法,均摊情况下,时间复杂度接近最好情况,就是 O(1)。

如果随着删除的元素越来越多,散列表可以选择缩容(和扩容类似),另外,装载因子的阀值要更具实际情况确定.

如何避免低效地扩容?

何之为低效:插入导致扩容,假设数据1GB,操作过程为 **申请空间->将旧数据搬移到新的空间->重新计算哈希值->插入.**用脑子想,这肯定会很慢.

解决方法:

将扩容操作穿插在插入操作的过程中,分批完成。当装载因子触达阈值之后,我们只申请新空间,但并不将老的数据搬移到新散列表中。

当有新数据要插入时,我们将新数据插入新散列表中,并且从老的散列表中拿出一个数据放入到新散列表。每次插入一个数据(其实不一定一个数据啦)到散列表,我们都重复上面的过程。经过多次插入操作之后,老的散列表中的数据就一点一点全部搬移到新散列表中了。这样没有了集中的一次性数据搬移,插入操作就都变得很快了。

这种实现方式,任何情况下,插入一个数据的时间复杂度都是 O(1)。不知道vector是不是这样做的呐?(我下来研究一下)

如何查询:先从新散列表中查找,如果没有找到,再去老的散列表中查找。

如何选择冲突解决方法?

1.开放寻址法

-

优点

- 数据都存储在数组中,可以有效地利用 CPU 缓存加快查询速度

- 序列化起来比较简单

-

缺点

- 删除数据的时候比较麻烦

- 冲突的代价更高

-

适用场景

当数据量比较小、装载因子小(< 1)的时候,适合采用开放寻址法。这也是 Java 中的

ThreadLocalMap使用开放寻址法解决散列冲突的原因。

2.链表法的适用场景

-

优点

- 不会大量浪费内存(因为是链表嘛,对吧)

- 对大装载因子的容忍度更高(只要散列函数随即均匀,他是多少几乎都能够接受)

-

缺点

- 对 CPU 缓存是不友好的(因为是链表嘛,对吧)

- 比较小的对象的存储,是比较消耗内存的(有可能一个指针的大小都会比存储对象要大哦)

-

适用场景

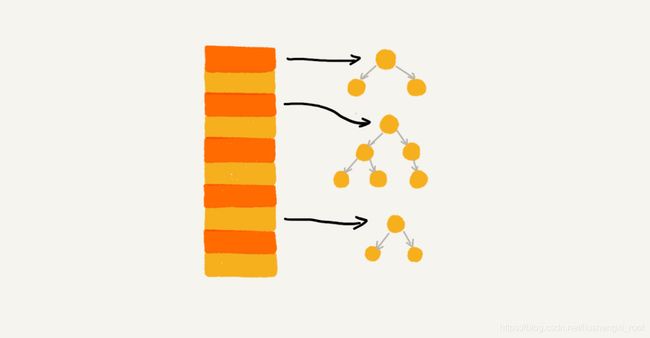

基于链表的散列冲突处理方法比较适合存储大对象、大数据量的散列表,而且,比起开放寻址法,它更加灵活,支持更多的优化策略,比如用红黑树代替链表。

极端情况下,所有的数据都散列到同一个桶内,那最终退化成的散列表的查找时间也只不过是 O(logn)。这样也就有效避免了前面讲到的散列碰撞攻击。

工业级散列表举例分析 (Java 中的 HashMap)

1. 初始大小

HashMap 默认的初始大小是 16,当然这个默认值是可以设置的,如果事先知道大概的数据量有多大,可以通过修改默认初始大小,减少动态扩容的次数,这样会大大提高 HashMap 的性能。

2. 装载因子和动态扩容

最大装载因子默认是 0.75,当 HashMap 中元素个数超过 0.75*capacity(capacity 表示散列表的容量)的时候,就会启动扩容,每次扩容都会扩容为原来的两倍大小。

3. 散列冲突解决方法

HashMap 底层采用链表法来解决冲突。即使负载因子和散列函数设计得再合理,也免不了会出现拉链过长的情况,一旦出现拉链过长,则会严重影响 HashMap 的性能。

于是,在 JDK1.8 版本中,为了对 HashMap 做进一步优化,我们引入了红黑树。而当链表长度太长(默认超过 8)时,链表就转换为红黑树。我们可以利用红黑树快速增删改查的特点,提高 HashMap 的性能。当红黑树结点个数少于 8 个的时候,又会将红黑树转化为链表。因为在数据量较小的情况下,红黑树要维护平衡,比起链表来,性能上的优势并不明显。

4. 散列函数

int hash(Object key) {

int h = key.hashCode();

return (h ^ (h >>> 16)) & (capitity -1); //capicity 表示散列表的大小

}

5.如何设计一个工业级别的散列表?

何为一个工业级的散列表?工业级的散列表应该具有哪些特性?

结合已经学习过的散列知识,我觉得应该有这样几点要求:

- 支持快速的查询、插入、删除操作;

- 内存占用合理,不能浪费过多的内存空间;

- 性能稳定,极端情况下,散列表的性能也不会退化到无法接受的情况。 **

如何实现这样一个散列表呢**?根据前面讲到的知识,我会从这三个方面来考虑设计思路:

- 设计一个合适的散列函数;

- 定义装载因子阈值,并且设计动态扩容策略;

- 选择合适的散列冲突解决方法。

只要我们朝这三个方向努力,就离设计出工业级的散列表不远了。