Weakly Supervised Data Augmentation Net-work (WS-DAN)

Weakly Supervised Data Augmentation Net-work (WS-DAN)

原文:Weakly Supervised Data Augmentation Net-work (WS-DAN) (Hu et al., “See Better Before

Looking Closer: Weakly Supervised Data Augmentation Network for Fine-Grained Visual

Classification”, arXiv:1901.09891)

Weakly Suprevised Learning弱监督学习:相对监督而言,lable不是很完善的情况。三种弱监督类型:不完全监督:只有一部分训练数据具备标签;不确切监督:训练数据只具备粗粒度标签;以及不准确监督:给出的标签并不总是真值。

Fine-Grained Visual Classification (FGVC)细粒度视觉分类:目的是在一个基本大类中进行细分类。例如鸟的种类,飞机型号。FGVC的难点在于:1、类中差异大。属于同一类的对象,呈现出不同的姿势,视觉角度也会造成很大差异。2、低类间差异:属于不同类的物体可能非常相似。3、训练数据有限。需要专业的知识和大量的时间标注。

所以仅依靠CNN很难获得准确的分类结果。

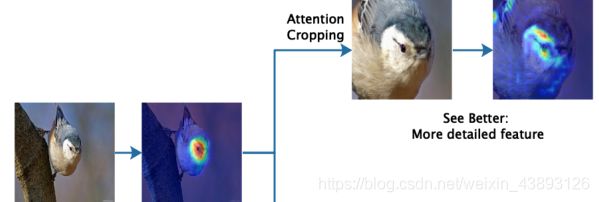

attention-guided data augmentation注意力引导数据增强:用Weakly Supervised Attention Learning来生成attention map。然后在attention map的基础上进行数据增强(attention cropping and attention dropping),提高数据增强的效率。attention cropping是裁剪并放大其中一个attention region,以增强局部特征的呈现。attention dropping 是随机的从图像中删除一个attention region,以激励模型从多个判别部分中提取特征。最后,在测试过程中,利用attention map对整个目标进行精确定位和放大,进一步提高精度。

WS-DAN 方法介绍

training process 训练过程:

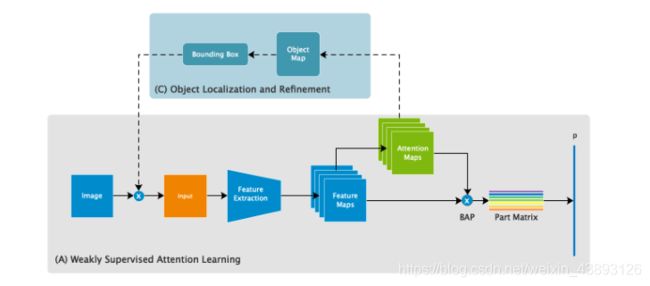

(A)Weakly Supervised Attention Learning :弱监督注意力学习,通过弱监督注意力学习对每一张训练图片生成一个注意力图(attention maps)来展现对象的显著特征。(b)注意力引导数据增强,随机选择一张注意力图,通过注意力剪裁和注意力删除的方式去增强这张图片,最后原图和增强对数据都会被作为输入数据进行训练。 BAP:Bilinear Attention Pooling双线性注意力池化

下面说明Weakly Supervised Attention Learning的各个部分:

Spatial Representation:空间关系。在这个方法中采用弱监督学习只根据类别标注来预测物体的位置分布。从一张图片I中通过CNN提取特征F ∈ R^(H×W×N)高H,宽W,数量为N。物体的分布通过Attention Maps来体现,A ∈ R^(H×W×M)。attention maps的获取通过对特征图F做卷积。

f(·)是卷积函数。Ak表示物体的一部分或视觉模式,如鸟的头部、汽车的轮子。

1、Bilinear Attention Pooling双线性注意力池化(BAP)

通过BAP来提取特征。

首先通过主干网络(Inception v3)来生成特征图(feature maps),和注意力图(attention maps)。attention maps代表一个特定物体的某个部分。然后把feature map和attention map按元素对应相乘生成部分特征图(part feature maps)。然后通过卷积运算或者池化提取部分特征(part feature)。最终的特征矩阵(feature maps)包含所有的part feature。

采用元素对应相乘。

然后,通过额外的特征提取函数g(·),如全局平均池(GAP)、全局最大池(GMP)或卷积,来提取具有识别力的局部特征。

![]()

feature matrix P ∈ R^M×N

2、Attention Regularization注意力正则化

因为我们想要attention map Ak只呈现物体的第k个部位。所以惩罚同一物体不同特征间的差异。也就是说特征f_k要靠近全局特征中心。

L_A是损失函数。c_k是第k个部分的特征中心。beta是更新速率。

3、Attention-guided Data Augmentation注意力引导数据增强

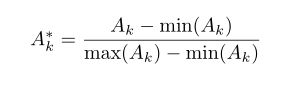

随机数据增强是一种低效的方法,特别是当目标尺寸很小时,它容易引入高百分比的背景噪声。有了注意力图,数据可以更有效地增加。对于每一幅训练图像,我们随机选择其注意图Ak来指导数据增强过程,并对它做归一化处理。

Attention Cropping

我们从Ak*中获取Crop Mask(Ck)。方法是,选取一个阈值theta。大于阈值,亮度设为1,小于设为0。

然后再在原图中找到一个边界框(bounding box)Bk,它可以完全的框住大于阈值的部分。然后把这个部分放大显示出来。这样就实现了论文提出的更近更好的看到特征。

Attention Dropping

和Attention Cropping相反,大于阈值显示0,小于阈值显示1,然后把大于阈值的部分剪掉。这将鼓励网络提取其他有识别力的部分,这意味着物体也可以被更好地看到:分类的稳健性和定位的准确性将得到提高。

dropping和cropping的贡献:

Testing process

首先,由(A)从原始图像中输出目标的类别预测和注意图。其次,根据(C)对目标进行定位,然后对目标进行放大以细化类别预测。最后,将上述两种可能性结合起来作为最终预测。

Object Localization and Refinement物体的定位和细化

这个部分会将特征放大。

算法步骤:

输入一张图像。

1、预测粗分类的概率p1,同时的到注意力图attention maps

2、计算object map Am

3、从Am中获取边界框B

4、放大区域B得到Io

5、预测细分类结果p2 = W(Io)

6、计算最终概率 p = (p1 + p2)/2

论文中采用的具体参数:

主干网络:Inception v3

feature maps:Mix6e layer

获取attention maps : 1 *1的卷积核

池化函数g(·):GAP

cropping 和 dropping的阈值:0.5

论文结论:

Attention maps的个数在32个达到稳定,准确率稳定在89.4%

WS-DAN 方法相比其他网络在CUB-200-2011 、 Stanford Dogs datasets、FGVC-Aircraft testing dataset和Stanford Cars testing dataset测试集上都取得了更好的准确率(采用mIoU评价)。