Opencv-Python-导向滤波&快速导向滤波

版本:Python:2.7.15 OpenCV:2.4.13

导向滤波算法原理

原理可以看博主:白马负金羁 的文章导向滤波(Guided Filter)的解析与实现,对原理解释十分通俗易懂。

导向滤波:

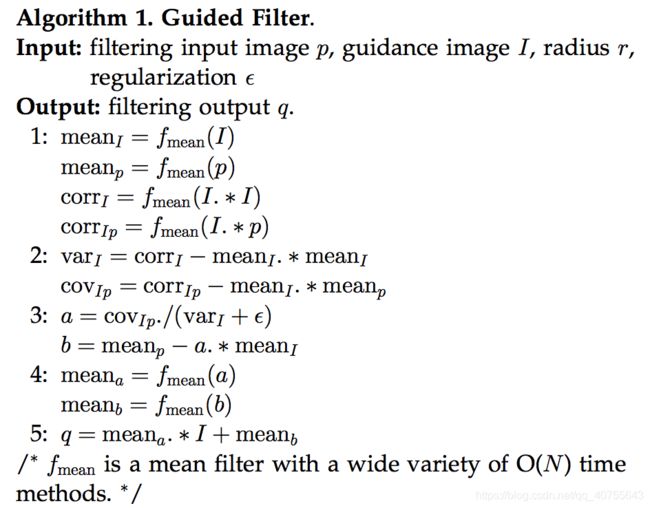

1.实现的伪代码:

导向图像(Guidance Image) I,滤波输出图像(Filtering Input Image) p,均值平滑窗口半径 r,正则化参数 e。

利用导向滤波进行图像平滑处理时,通常令p=I。

2.opencv库代码实现:

其中:guideFilter()函数调用opencv自带的库函数blur() 进行均值平滑。

def guideFilter(I, p, winSize, eps):

#I的均值平滑

mean_I = cv2.blur(I, winSize)

#p的均值平滑

mean_p = cv2.blur(p, winSize)

#I*I和I*p的均值平滑

mean_II = cv2.blur(I*I, winSize)

mean_Ip = cv2.blur(I*p, winSize)

#方差

var_I = mean_II - mean_I * mean_I #方差公式

#协方差

cov_Ip = mean_Ip - mean_I * mean_p

a = cov_Ip / (var_I + eps)

b = mean_p - a*mean_I

#对a、b进行均值平滑

mean_a = cv2.blur(a, winSize)

mean_b = cv2.blur(b, winSize)

q = mean_a*I + mean_b

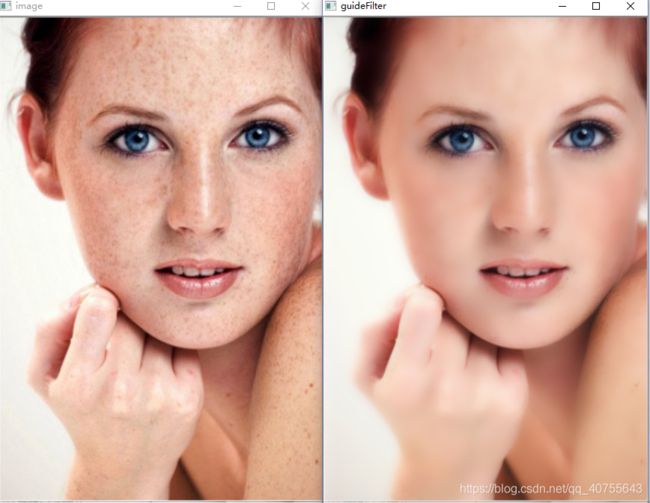

return q3.结果对比:

下图采用了r=16也就是winSize=(16,16), eps=0.01的参数大小。

快速导向滤波

通过下采样减少像素点,计算mean_a & mean_b后进行上采样恢复到原有的尺寸大小。

假设缩放比例为s,那么缩小后像素点的个数为N/s^2,那么时间复杂度变为O(N/s^2)

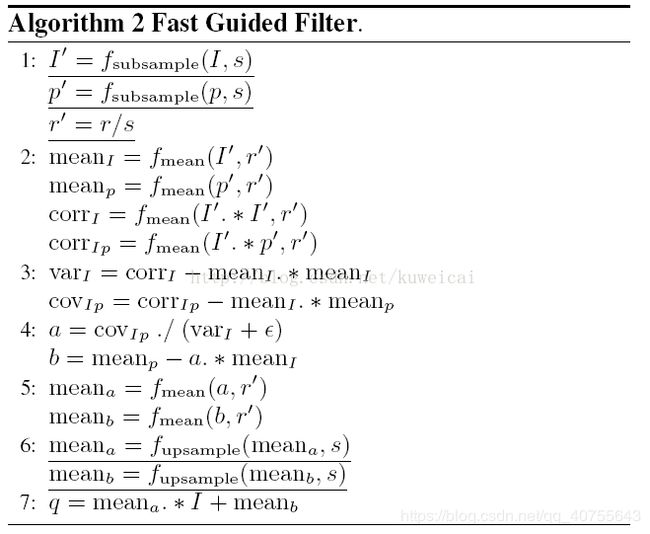

1.实现的伪代码:

fmean代表均值平滑,fsubsample代表图像下采样即缩小图像,fupsample代表图片上采样即放大图像,s为缩小系数。

2.opencv库代码实现:

这里使用opencv自带库函数resize()进行上下采样。

def guideFilter(I, p, winSize, eps, s):

#输入图像的高、宽

h, w = I.shape[:2]

#缩小图像

size = (int(round(w*s)), int(round(h*s)))

small_I = cv2.resize(I, size, interpolation=cv2.INTER_CUBIC)

small_p = cv2.resize(I, size, interpolation=cv2.INTER_CUBIC)

#缩小滑动窗口

X = winSize[0]

small_winSize = (int(round(X*s)), int(round(X*s)))

#I的均值平滑

mean_small_I = cv2.blur(small_I, small_winSize)

#p的均值平滑

mean_small_p = cv2.blur(small_p, small_winSize)

#I*I和I*p的均值平滑

mean_small_II = cv2.blur(small_I*small_I, small_winSize)

mean_small_Ip = cv2.blur(small_I*small_p, small_winSize)

#方差

var_small_I = mean_small_II - mean_small_I * mean_small_I #方差公式

#协方差

cov_small_Ip = mean_small_Ip - mean_small_I * mean_small_p

small_a = cov_small_Ip / (var_small_I + eps)

small_b = mean_small_p - small_a*mean_small_I

#对a、b进行均值平滑

mean_small_a = cv2.blur(small_a, small_winSize)

mean_small_b = cv2.blur(small_b, small_winSize)

#放大

size1 = (w, h)

mean_a = cv2.resize(mean_small_a, size1, interpolation=cv2.INTER_LINEAR)

mean_b = cv2.resize(mean_small_b, size1, interpolation=cv2.INTER_LINEAR)

q = mean_a*I + mean_b

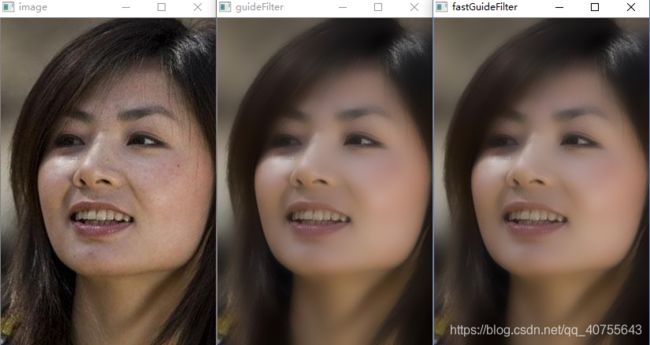

return q3.结果对比:

下图导向滤波采用了r=16也就是winSize=(16,16), eps=0.01的参数大小。

快速导向滤波采用了r=16也就是winSize=(16,16), eps=0.01,s=0.5的参数大小。

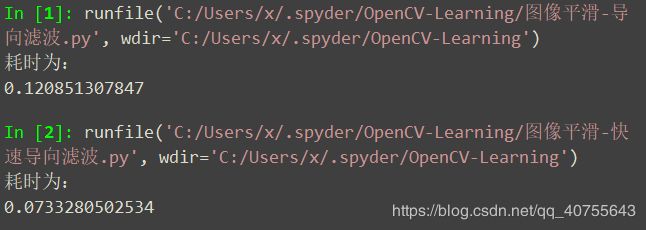

从结果上看二者的滤波结果别无二致,但是运行时间有所降低。

代码运行注意

1.输入图像必须归一化

image = cv2.imread(r'C:\Users\1.jpg', cv2.IMREAD_ANYCOLOR)

#将图像归一化

image_0_1 = image/255.02.图像保存问题

导向滤波返回的是灰度值范围在[0,1]之间的图像矩阵,像保存8位图要先乘255,再转换数据类型。

#保存导向滤波结果

gf = gf*255

gf[gf>255] = 255

gf = np.round(gf)

gf = gf.astype(np.uint8)

cv2.imwrite(r'C:\Users\2.jpg', gf)3.关于cv2.resize()函数

cv2.resize(src, dsize[, dst[, fx[, fy[, interpolation]]]]) -> dst

参数说明:

src - 原图

dst - 目标图像。

当参数dsize不为0时,dst的大小为size;否则,它的大小需要根据src的大小,参数fx和fy决定。dst的类型(type)和src图像相同

dsize - 目标图像大小。

当dsize为0时,它可以通过以下公式计算得出:

![]()

所以,参数dsize和参数(fx, fy)不能够同时为0

fx - 水平轴上的比例因子。当它为0时,计算公式如下:

![]()

fy - 垂直轴上的比例因子。当它为0时,计算公式如下:

![]()

interpolation - 插值方法:

1)INTER_NEAREST - 最近邻插值法

2)INTER_LINEAR - 双线性插值法(默认)

3)INTER_AREA - 基于局部像素的重采样(resampling using pixel area relation)。对于图像抽取(image decimation)来说,这可能是一个更好的方法。但如果是放大图像时,它和最近邻法的效果类似。

4)INTER_CUBIC - 基于4x4像素邻域的3次插值法

5)INTER_LANCZOS4 - 基于8x8像素邻域的Lanczos插值

4.多通道处理

本文的两个滤波函数只能对单一通道进行处理,如果是多通道,需要split()函数将原图分为RGB三张图,然后分别进行滤波,然后再用merge()函数将三张图合为一张。

#导向滤波(三通道)

b, g, r = cv2.split(image_0_1)

gf1 = guideFilter(b, b, (16,16), math.pow(0.1,2))

gf2 = guideFilter(g, g, (16,16), math.pow(0.1,2))

gf3 = guideFilter(r, r, (16,16), math.pow(0.1,2))

gf = cv2.merge([gf1, gf2, gf3])5.计算函数运行时间

# time start

t1 = cv2.getTickCount()

"""

代码段落

"""

# time end

t2 = cv2.getTickCount()

#计算执行秒数,利用getTickFrequency()获取时钟频率

t = (t2-t1)/cv2.getTickFrequency()

print t