ICDAR 2019比赛及数据集下载-任务-任务-ICDAR 2019扫描收据OCR和信息提取的稳健阅读挑战

ICDAR 2019比赛及数据集下载-任务-

https://rrc.cvc.uab.es/?ch=13&com=tasks

任务-ICDAR 2019扫描收据OCR和信息提取的稳健阅读挑战

数据集和注释

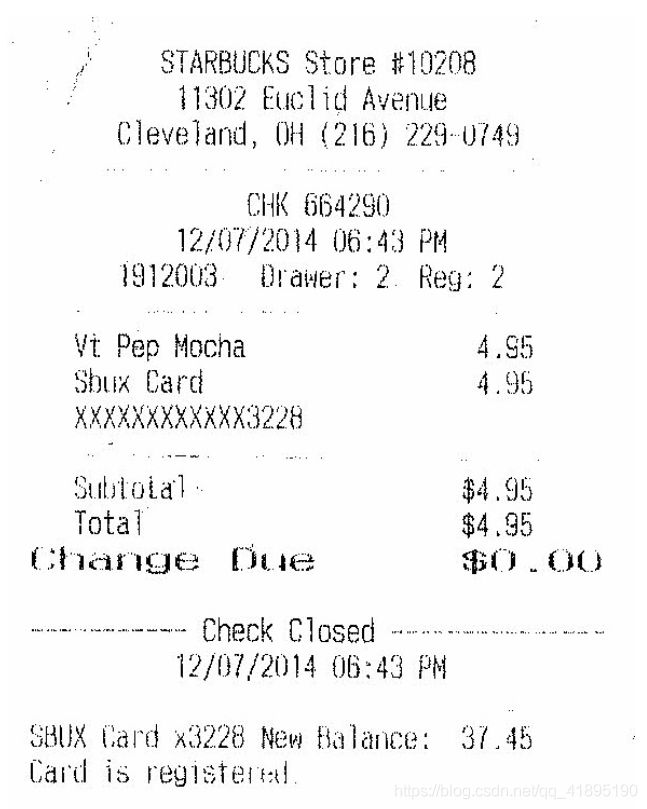

数据集将具有1000个完整的扫描收据图像。每个收据图像包含大约四个关键文本字段,例如商品名称,单价和总成本等。在数据集中标注的文本主要由数字和英文字符组成。扫描收据示例如下所示:

数据集分为训练/验证集(“ trainval”)和测试集(“ test”)。“训练”集包括600张收据图像,这些图像将与参与者的注释一起提供给参与者。“测试”集包含400张图像,这些图像将在提交截止日期前几周提供。

对于接收OCR任务,数据集中的每个图像都用文本边界框(bbox)和每个文本bbox的脚本进行注释。位置标注为具有四个顶点的矩形,这些顶点从顶部开始按顺时针顺序排列。图像的注释存储在具有相同文件名的文本文件中。注释格式类似于ICDAR2015数据集的格式,如下所示:

x1_1,y1_1,x2_1,y2_1,x3_1,y3_1,x4_1,y4_1,成绩单_1

x1_2,y1_2,x2_2,y2_2,x3_2,y3_2,x4_2,y4_2,成绩单_2

x1_3,y1_3,x2_3,y2_3,x3_3,y3_3,x4_3,y4_3,transcript_3

…

对于信息提取任务,数据集中的每个图像都用一个文本文件注释,其格式如下所示:

{“公司”:“ STARBUCKS STORE#10208”,

“ date”:“ 14/03/2015”,

“ address”:“ 11302 EUCLID AVENUE,CLEVELAND,OH(216)229-0749”,

“ total”:“ 4.95”,

}

任务1-扫描的收据文本本地化

任务描述

本地化和识别文本是许多以前的比赛中出现的常规任务,例如ICDAR健壮阅读比赛(RRC)2013,ICDAR RRC 2015和ICDAR RRC 2017 [1] [2]。此任务的目的是精确定位具有4个顶点的文本。文本本地化基础事实将至少在单词级别。要求参与者提交一个zip文件,其中包含所有测试图像的结果。

评估协议

由于参与团队可能会应用本地化算法在不同级别(例如,文本行)定位文本,因此在此任务中,为了评估文本的本地化,将实施基于DetVal的方法。该方法部分地解决了所检测文本的一对多和多对一对应的问题。在我们的评估协议中,将基于F1得分进行计算并用于排名[3],从而计算平均平均准确度(mAP)和平均召回率。

任务2-扫描的收据OCR

任务描述

此任务的目的是准确识别收据图像中的文本。没有提供或不需要本地化信息。相反,要求参与者提供图像中识别的单词列表。该任务将仅限于包含拉丁字符和数字的单词。

训练此任务所需的基本事实是抄录中出现的单词列表。 为了获得 此任务的基本信息,应标记化在空间上拆分的所有字符串。例如,字符串“ Date:12/3/56”应标记为“ Date:”,“ 12/3/56”。字符串“ Date:12/3/56”应标记为“ Date:”“ 12”,“ /”,“ 3”,“ /”,“ 56”。

评估协议

对于“识别”排名,我们将参与者提供的所有单词与基本事实中的单词匹配。如果某些单词在图像中重复,则预期它们也会在提交结果中重复。我们将计算“精度”(在检测到的单词数范围内的正确匹配数)或“召回”(在“事实真词”数量范围内的正确匹配数)度量,并将F1分数用作最终排名度量。

任务3-从扫描的收据中提取关键信息

任务描述

此任务的目的是从给定的收据中提取多个关键字段的文本,并将每个收据图像的文本保存在json文件中,格式如图3所示。参与者将被要求提交一个包含以下内容的zip文件:所有测试发票图像。

评估协议

对于每个测试收据图像,将提取的文本与基本事实进行比较。如果提交的内容和提取的文本的类别均与基本内容匹配,则提取的文本被标记为正确;否则,标记为不正确。在所有测试收据图像的所有提取文本上计算精度。F1分数是根据精度和召回率计算的。F1分数将用于排名。

下载-ICDAR 2019扫描收据OCR和信息提取的强大阅读挑战

==================================================

对于SROIE竞赛,我们总共创建了1000张带注释的图像用于培训和测试。

SROIE竞赛任务的培训和验证数据集包含600张带批注的图像,现在可以从以下Google Drive和Baidu Pan链接下载这些图像:

- https://drive.google.com/open?id=1ShItNWXyiY1tFDM5W02bceHuJjyeeJl2

- https://pan.baidu.com/s/1a57eKCSq8SV8Njz8-jO4Ww#list/path=%2FSROIE2019&parentPath=%2F

任务1和任务2的测试数据集现已打开,现在可以从上面的Google云端硬盘和百度Pan链接下载该数据集。

任务3的测试数据集现已打开,可从上述链接下载。请注意,任务3测试数据集是任务1和2的测试数据集的子集(347张图像)(总共361张图像)。