第六章 统计学习方法-逻辑斯蒂回归与最大熵模型

逻辑斯蒂回归(logistic regression)是统计学习中的经典分类方法。

最大熵是概率模型学习的一个准则,将其推广到分类问题得到最大熵模型(maximum entropy model)。

逻辑斯蒂回归模型与最大熵模型都属于对数线性模型。

6.1.1 逻辑斯蒂分布

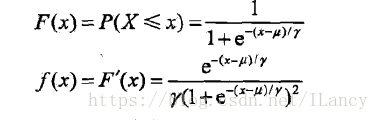

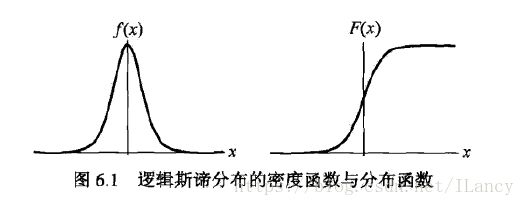

设X是连续随机变量,X服从逻辑斯蒂分布是指X具有下列分布函数和密度函数:

6.1.2 二项逻辑斯蒂回归模型

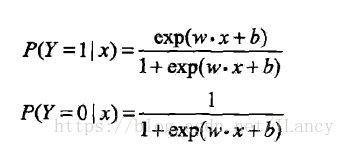

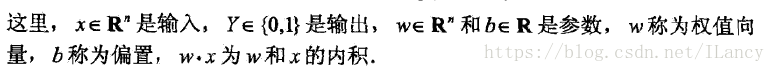

二项逻辑斯蒂回归模型(binomial logistic regression model)是一种分类模型,由条件概率分布P(Y|X)表示,形式为参数化的逻辑斯蒂分布。随机变量X取值为实数,随机变量Y取值为1或0。

逻辑斯蒂回归模型:二项逻辑斯蒂回归模型是如下的条件概率分布:

6.1.3 模型参数估计

逻辑斯蒂回归模型学习时,对于给定的训练数据集T = {(x1,y1),(x2,y2),...,(x![]() n,yn)},其中,

n,yn)},其中,![]() 可以应用极大似然估计法估计模型参数,从而得到逻辑斯蒂回归模型。

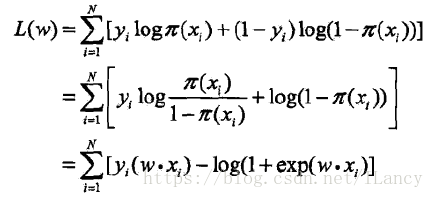

可以应用极大似然估计法估计模型参数,从而得到逻辑斯蒂回归模型。

设:

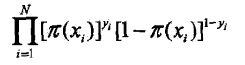

似然函数:

对数似然函数:

6.1.4 多逻辑斯蒂回归

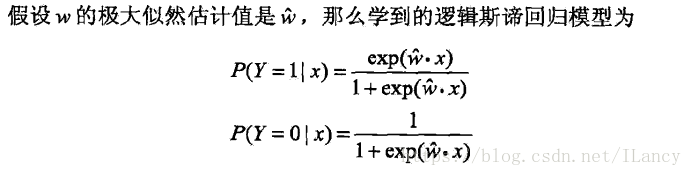

多项逻辑斯蒂回归模型(multi-nominal logistic regression model):

6.2 最大熵模型(maximum entropy model)

6.2.1 最大熵原理

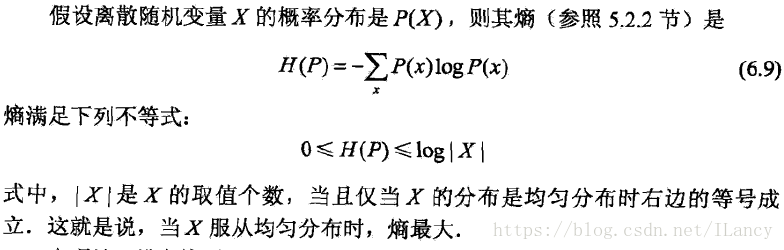

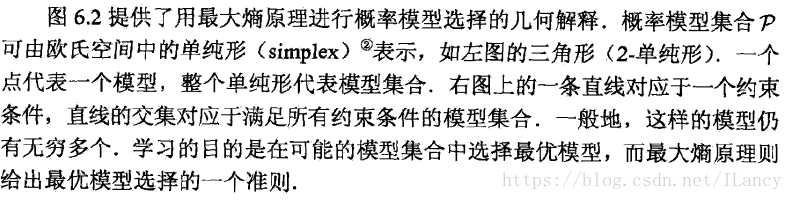

最大熵原理是概率模型学习的一个准则。最大熵原理认为,学习概率模型时,在所有可能的概率模型(分布)中,熵最大的模型就是最好的模型。通常用约束条件来确定概率模型的集合,所以最大熵原理也可以表述为在满足约束条件的模型集合中选取熵最大的模型。

6.2.2 最大熵的定义

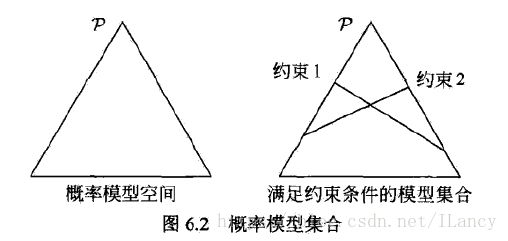

给定训练数据集,可以确定联合分布P(X,Y)的经验分布和边缘分布P(X)的经验分布,

其中,v(X=x,Y=y)表示训练数据中样本(x,y)出现的频数,v(X = x)表示训练数据中输入x出现的频数,N表示训练样本容量。

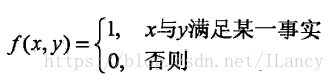

用特征函数(feature function) f(x,y)描述输入x和输出Y之间的某一个事实。其定义是

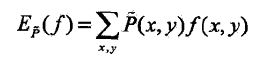

特征函数f(x,y)关于经验分布P~(X,Y)的期望值,用EP~(f)表示:

特征函数f(x,y)关于模型P(Y|X)与经验分布P~(X)的期望值,用EP(f)表示,

约束条件为

6.2.3 最大熵模型学习

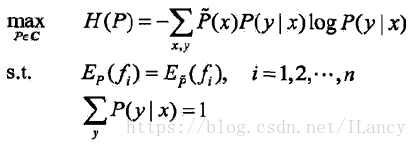

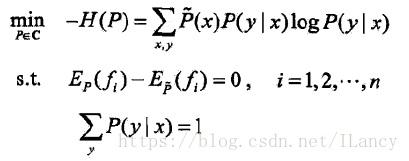

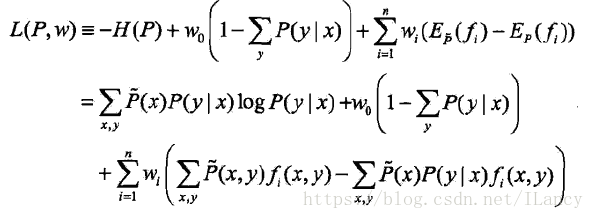

最大熵模型的学习过程就是求解最大熵模型的过程,可以形式化为约束最优化问题:

将约束最优化的原始问题转换为无约束最优化的对偶问题。通过求解对偶问题求原解始问题。

6.2.4 极大似然估计

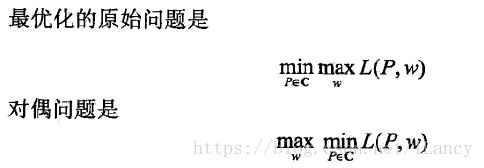

最大熵模型学习中的对偶函数极大化等价于最大熵模型的极大似然估计,最大熵模型的学习问题就转换为具体求解对数似然函数极大化或对偶函数极大化的问题。

对数似然函数为:

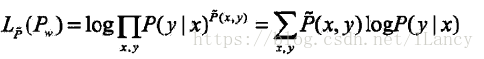

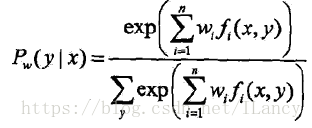

最大熵模型的一般形式为:

6.3 模型学习的最优化算法

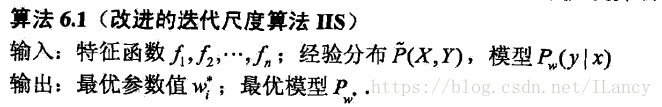

基于改进的迭代尺度法(improved iterative scaling, IIS)的最大熵模型学习算法

IIS的想法是假设最大嫡模型当前的参数向量是w=(w1,w2, ..., wn)T,我们希望找到一个新的参数向量w + sigmal =(w1+sigmal1, ..., wn+sigmaln)T,使得模型的对数似然函数值增大。如果能有这样一种参数向量更新的方法:w-->w + sigma,那么就可以重复使用这一方法,直至找到对数似然函数的最大值。

6.3.2 拟牛顿法

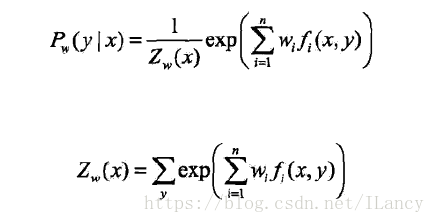

对于最大熵而言:

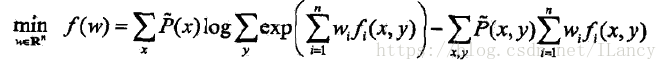

目标函数:

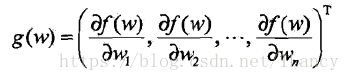

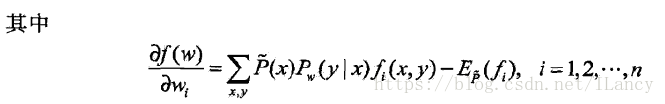

梯度:

拟牛顿算法:

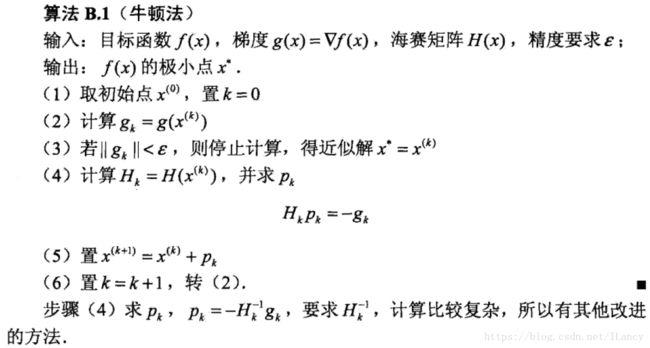

补充一个牛顿算法: