第三章 图像到图像的映射(python)

文章目录

- 3.1 单应性变换

- 3.1.1 直接线性变换算法

- 3.1.2 仿射变换

- 3.2 图像扭曲

- 3.2.1图像中的图像

- 3.2.2 分段仿射扭曲

- 3.3 创建全景图

- 3.3.1 RANSAC

- 3.3.2 稳健的单应性矩阵估计,图像拼接

3.1 单应性变换

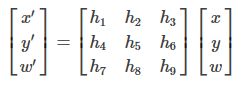

单应性变换是将一个平面内的点映射到另一个平面内的二维投影变换。在这里平面是指图像或者三维中的平面表面。单应性变换H,按照下面的方程映射二维的点(齐次坐标一一下):

点的齐次坐标是依赖于其尺度定义的,所以 x=[x,y,w]=[αx,αy,αw]=[x/w,y/w,1] 都表示同一个二维点。因此,单应性矩阵H也仅仅依赖尺度定义,所以,单应性矩阵具有8个独立的自由度。通常使用w=1来归一化点,这样点具有唯一的图像坐标x,y。这个额外的坐标使得我们可以简单地使用一个矩阵来表示变换。

单应性变换的推导(摘自https://www.cnblogs.com/ml-cv/p/5871052.html)

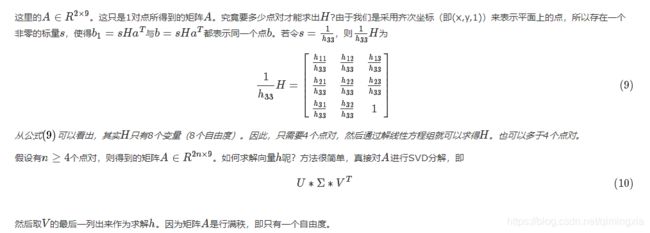

矩阵的一个重要作用是将空间中的点变换到另一个空间中。这个作用在国内的《线性代数》教学中基本没有介绍。要能形像地理解这一作用,比较直观的方法就是图像变换,图像变换的方法很多,单应性变换是其中一种方法,单应性变换会涉及到单应性矩阵。单应性变换的目标是通过给定的几个点(通常是4对点)来得到单应性矩阵。假设单应性矩阵为:

矩阵的一个重要作用是将空间中的点变换到另一个空间中。这个作用在国内的《线性代数》教学中基本没有介绍。要能形像地理解这一作用,比较直观的方法就是图像变换,图像变换的方法很多,单应性变换是其中一种方法,单应性变换会涉及到单应性矩阵。单应性变换的目标是通过给定的几个点(通常是4对点)来得到单应性矩阵。假设单应性矩阵为:

上面的矩阵HH会将一幅图像上的一个点的坐标a=(x,y,1)映射成另一幅图像上的点的坐标b=(x1,y1,1),但H是未知的。通常需要根据在同一平面上已知的一些点对(比如a,b)来求H。 假设已知点对(a,b),则有下面的公式:

定义一个函数来实现对点的归一化和转换齐次坐标的功能

def normalize(points):

""" 在齐次坐标意义下,对点集进行归一化,使最后一行为 1 """

for row in points:

row /= points[-1]

return points

def make_homog(points):

""" 将点集(dim×n 的数组)转换为齐次坐标表示 """

return vstack((points,ones((1,points.shape[1]))))

在进行点和变换地处理时,我们会按照列优先的原则存储这些点。因此,n个二维点集将会存储为齐次坐标意义下的一个3*n数组。

在这些投影变换中,有一些特别重要的变换。

仿射变换:

保持了w=1,不具有投影变换所具有的变形能力。仿射变换包含了一个可逆矩阵A和一个平移向量t。仿射变换可以用于很多应用,比如图像扭曲。

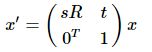

相似变换:

是一个包含尺度变化的二维刚体变换上式中的向量s指定了变换的尺度,R是角度为sita的旋转矩阵,t任然是一个平移向量。如果s=1,那么该变换能够保持距离不变。此时的变换为刚体变换。

3.1.1 直接线性变换算法

单应性矩阵可以由两幅图像中对应点对计算出来。一个完全映射变换具有8个自由度。根据对应点对可以写出两个方程,分别对应于x,y坐标。因此,计算单应性矩阵H需要4个对应点对。

DLT(直接线性变换)是给定4个或者更多对应点对矩阵,来计算单应性矩阵H的算法.

![]()

其中A是一个具有对应点对二倍数量行数的矩阵.将这些对应点对方程的系数堆叠到一个矩阵中.我们可以使用SVD算法找到H的最小二乘解.

def H_from_points(fp,tp):

""" Find homography H, such that fp is mapped to tp

using the linear DLT method. Points are conditioned

automatically. """

if fp.shape != tp.shape:

raise RuntimeError('number of points do not match')

# condition points (important for numerical reasons)

# --from points--

m = mean(fp[:2], axis=1)

maxstd = max(std(fp[:2], axis=1)) + 1e-9

C1 = diag([1/maxstd, 1/maxstd, 1])

C1[0][2] = -m[0]/maxstd

C1[1][2] = -m[1]/maxstd

fp = dot(C1,fp)

# --to points--

m = mean(tp[:2], axis=1)

maxstd = max(std(tp[:2], axis=1)) + 1e-9

C2 = diag([1/maxstd, 1/maxstd, 1])

C2[0][2] = -m[0]/maxstd

C2[1][2] = -m[1]/maxstd

tp = dot(C2,tp)

# create matrix for linear method, 2 rows for each correspondence pair

nbr_correspondences = fp.shape[1]

A = zeros((2*nbr_correspondences,9))

for i in range(nbr_correspondences):

A[2*i] = [-fp[0][i],-fp[1][i],-1,0,0,0,

tp[0][i]*fp[0][i],tp[0][i]*fp[1][i],tp[0][i]]

A[2*i+1] = [0,0,0,-fp[0][i],-fp[1][i],-1,

tp[1][i]*fp[0][i],tp[1][i]*fp[1][i],tp[1][i]]

U,S,V = linalg.svd(A)

H = V[8].reshape((3,3))

# decondition

H = dot(linalg.inv(C2),dot(H,C1))

# normalize and return

return H / H[2,2]

对这些点进行归一化操作,使其均值为0,方差为1.因为算法的稳定性取决于坐标的表示情况和部分数值计算的问题,所以归一化操作非常重要.然后,使用对应点对来构造矩阵A.最小二乘解即为矩阵SVD分解后所得到矩阵V的最后一行.该行经过变形后得到矩阵H.然后对这个矩阵进行处理和归一化,返回输出.

3.1.2 仿射变换

由于仿射变换具有 6 个自由度,因此我们需要三个对应点对来估计矩阵 H。通过将

最后两个元素设置为 0,即 h7=h8=0,仿射变换可以用上面的 DLT 算法估计得出。

下面的代码通过使用对应点对来计算仿射变换矩阵

def Haffine_from_points(fp,tp):

""" Find H, affine transformation, such that

tp is affine transf of fp. """

if fp.shape != tp.shape:

raise RuntimeError('number of points do not match')

# condition points

# --from points--

m = mean(fp[:2], axis=1)

maxstd = max(std(fp[:2], axis=1)) + 1e-9

C1 = diag([1/maxstd, 1/maxstd, 1])

C1[0][2] = -m[0]/maxstd

C1[1][2] = -m[1]/maxstd

fp_cond = dot(C1,fp)

# --to points--

m = mean(tp[:2], axis=1)

C2 = C1.copy() #must use same scaling for both point sets

C2[0][2] = -m[0]/maxstd

C2[1][2] = -m[1]/maxstd

tp_cond = dot(C2,tp)

# conditioned points have mean zero, so translation is zero

A = concatenate((fp_cond[:2],tp_cond[:2]), axis=0)

U,S,V = linalg.svd(A.T)

# create B and C matrices as Hartley-Zisserman (2:nd ed) p 130.

tmp = V[:2].T

B = tmp[:2]

C = tmp[2:4]

tmp2 = concatenate((dot(C,linalg.pinv(B)),zeros((2,1))), axis=1)

H = vstack((tmp2,[0,0,1]))

# decondition

H = dot(linalg.inv(C2),dot(H,C1))

return H / H[2,2]

类似于DLT算法,这些点需要经过预处理和去处理化操作。

3.2 图像扭曲

对图像块应用仿射变换,我们将其称为图像扭曲(或者仿射扭曲)。

扭曲操作可以使用SciPy 工具包中的 ndimage 包来简单完成。命令:

transformed_im = ndimage.affine_transform(im,A,b,size)

使用一个线性变换 A 和一个平移向量 b 来对图像块应用仿射变换。选项参数 size 可以用来指定输出图像的大小。默认输出图像设置为和原始图像同样大小。

将仿射变换后的输出图像与原始图像对比,发现结果中丢失的像素用零来填充。

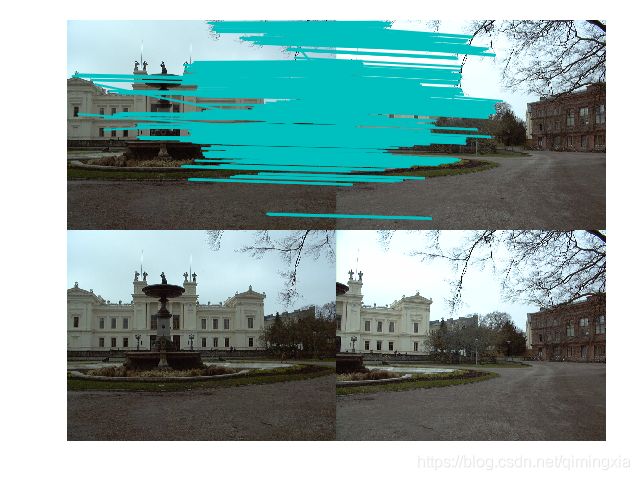

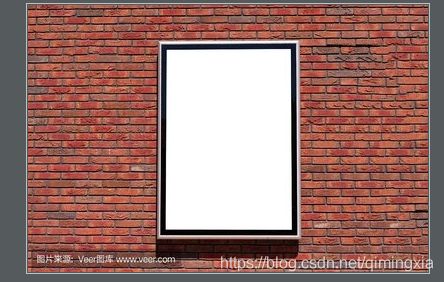

3.2.1图像中的图像

仿射扭曲的一个简单例子是,将图像或者图像的一部分放置在另一幅图像中,使得它们能够和指定的区域或者标记物对齐。

使用仿射变换将一幅图像放置到另一幅图像中

from PIL import Image

from pylab import *

from PCV.geometry import warp

im1 = array(Image.open('ggp.jpg').convert('L'))

im2 = array(Image.open('ggpp.jpg').convert('L'))

tp = array([[140, 260, 260, 140], [50, 50, 200, 200], [1, 1, 1, 1]])

im3 = warp.image_in_image(im1, im2, tp)

figure()

gray()

imshow(im3)

axis('equal')

axis('off')

show()

将扭曲的图像和第二幅图像融合,我们就创建了 alpha 图像。该图像定义了每个像素从各个图像中获取的像素值成分多少。这里我们基于以下事实,扭曲的图像是在扭曲区域边界之外以 0 来填充的图像,来创建一个二值的 alpha 图像。严格意义上说,我们需要在第一幅图像中的潜在 0 像素上加上一个小的数值,或者合理地处理这些 0 像素。注意,这里我们使用的图像坐标是齐次坐标意义下的。

对于四点曲面映射,不适宜使用同一个仿射变换将全部四个角点变换到他们的目标位置。当使用仿射变换时,有一个技巧,对于三个点,仿射变换可以将一幅图像进行扭曲,使这三对对应点对可以完美地匹配上。这是因为,仿射变换具有 6 个自由度,三个对应点对可以给出 6 个约束条件(对于这三个对应点对,x 和 y 坐标必须都要匹配)。所以,如果你真的打算使用仿射变换将图像放置到公告牌上,可以将图像分成两个三角形,然后对它们分别进行扭曲图像操作。

3.2.2 分段仿射扭曲

三角形图像块的仿射扭曲可以完成角点的精确匹配。分段仿射扭曲:给定任意图像的标记点,通过将这些点进行三角剖分,然后使用仿射扭曲来扭曲每个三角形,我们可以将图像和另一幅图像的对应标记点扭曲对应。对于任何图形和图像处理库来说,这些都是最基本的操作。

为了三角化这些点,我们经常使用狄洛克三角剖分方法。

随机二维点集的狄洛克三角部分示例:

# -*- coding: utf-8 -*-

from scipy.spatial import Delaunay

from numpy import *

from scipy import *

from PIL import *

import homography

import homography

import warp

from scipy import ndimage

#仿射扭曲im1到im2的例子

im1 = array(Image.open('jimei/jimei9.jpg').convert('L'))

subplot(141)

title('jimei1')

axis('off')

imshow(im1)

im2 = array(Image.open('jimei/jimei5.jpg').convert('L'))

subplot(142)

title('jimei2')

axis('off')

imshow(im2)

#选定一些目标点,tp是映射目标位置

tp = array([[0,205,205,0],[500,500,300,300],[1,1,1,1]])

im3 = warp.image_in_image(im1,im2,tp)

#figure()

#gray()

subplot(143)

title('change')

#axis('equal')

axis('off')

imshow(im3)

show()

#下面是三角形仿射

# 选定im1角上的一些点

m,n = im1.shape[:2]

fp = array([[0,m,m,0],[0,0,n,n],[1,1,1,1]])

# 第一个三角形

tp2 = tp[:,:3]

fp2 = fp[:,:3]

# 计算 H

H = homography.Haffine_from_points(tp2,fp2)

#计算H,fp映射到tp,其中tp是映射目标位置

#扭曲操作,直接使用Scipy工具包来完成

im1_t = ndimage.affine_transform(im1,H[:2,:2],

(H[0,2],H[1,2]),im2.shape[:2])

#H[:2,:2]是因为仿射仅取H的前两列

# 三角形的alpha

alpha = warp.alpha_for_triangle(tp2,im2.shape[0],im2.shape[1])

im3 = (1-alpha)*im2 + alpha*im1_t

# 第二个三角形

tp2 = tp[:,[0,2,3]]

fp2 = fp[:,[0,2,3]]

# 计算 H

H = homography.Haffine_from_points(tp2,fp2)

im1_t = ndimage.affine_transform(im1,H[:2,:2],

(H[0,2],H[1,2]),im2.shape[:2])

# 三角形的alpha图像

alpha = warp.alpha_for_triangle(tp2,im2.shape[0],im2.shape[1])

im4 = (1-alpha)*im3 + alpha*im1_t

subplot(144)

imshow(im4)

axis('off')

show()

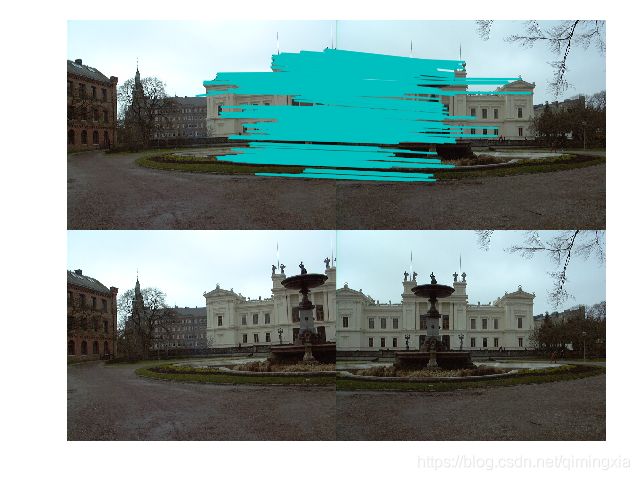

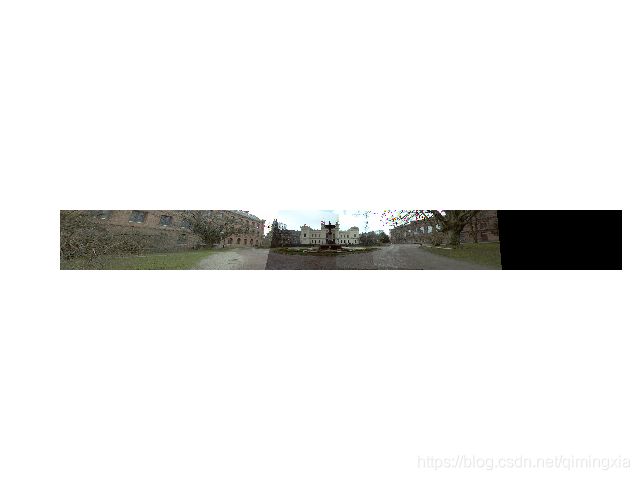

3.3 创建全景图

在同一位置(即图像的照相机位置相同)拍摄的两幅或者多幅图像是单应性相关的。我们经常使用该约束将很多图像缝补起来,拼成一个大的图像来创建全景图像。

3.3.1 RANSAC

RANSAC 是“RANdom SAmple Consensus”(随机一致性采样)的缩写。该方法是用来找到正确模型来拟合带有噪声数据的迭代方法。给定一个模型,例如点集之间的单应性矩阵,RANSAC 基本的思想是,数据中包含正确的点和噪声点,合理的模型应该能够在描述正确数据点的同时摒弃噪声点。

RANSAC 的标准例子:用一条直线拟合带有噪声数据的点集。简单的最小二乘在该例子中可能会失效,但是 RANSAC 能够挑选出正确的点,然后获取能够正确拟合的直线。

RANSAC基本思想描述如下:

①考虑一个最小抽样集的势为n的模型(n为初始化模型参数所需的最小样本数)和一个样本集P,集合P的样本数#§>n,从P中随机抽取包含n个样本的P的子集S初始化模型M;

②余集SC=P\S中与模型M的误差小于某一设定阈值t的样本集以及S构成S*。S认为是内点集,它们构成S的一致集(Consensus Set);

③若#(S)≥N,认为得到正确的模型参数,并利用集S*(内点inliers)采用最小二乘等方法重新计算新的模型M*;重新随机抽取新的S,重复以上过程。

④在完成一定的抽样次数后,若未找到一致集则算法失败,否则选取抽样后得到的最大一致集判断内外点,算法结束。

import numpy

import scipy # use numpy if scipy unavailable

import scipy.linalg # use numpy if scipy unavailable

## Copyright (c) 2004-2007, Andrew D. Straw. All rights reserved.

## Redistribution and use in source and binary forms, with or without

## modification, are permitted provided that the following conditions are

## met:

## * Redistributions of source code must retain the above copyright

## notice, this list of conditions and the following disclaimer.

## * Redistributions in binary form must reproduce the above

## copyright notice, this list of conditions and the following

## disclaimer in the documentation and/or other materials provided

## with the distribution.

## * Neither the name of the Andrew D. Straw nor the names of its

## contributors may be used to endorse or promote products derived

## from this software without specific prior written permission.

## THIS SOFTWARE IS PROVIDED BY THE COPYRIGHT HOLDERS AND CONTRIBUTORS

## "AS IS" AND ANY EXPRESS OR IMPLIED WARRANTIES, INCLUDING, BUT NOT

## LIMITED TO, THE IMPLIED WARRANTIES OF MERCHANTABILITY AND FITNESS FOR

## A PARTICULAR PURPOSE ARE DISCLAIMED. IN NO EVENT SHALL THE COPYRIGHT

## OWNER OR CONTRIBUTORS BE LIABLE FOR ANY DIRECT, INDIRECT, INCIDENTAL,

## SPECIAL, EXEMPLARY, OR CONSEQUENTIAL DAMAGES (INCLUDING, BUT NOT

## LIMITED TO, PROCUREMENT OF SUBSTITUTE GOODS OR SERVICES; LOSS OF USE,

## DATA, OR PROFITS; OR BUSINESS INTERRUPTION) HOWEVER CAUSED AND ON ANY

## THEORY OF LIABILITY, WHETHER IN CONTRACT, STRICT LIABILITY, OR TORT

## (INCLUDING NEGLIGENCE OR OTHERWISE) ARISING IN ANY WAY OUT OF THE USE

## OF THIS SOFTWARE, EVEN IF ADVISED OF THE POSSIBILITY OF SUCH DAMAGE.

def ransac(data,model,n,k,t,d,debug=False,return_all=False):

"""fit model parameters to data using the RANSAC algorithm

This implementation written from pseudocode found at

http://en.wikipedia.org/w/index.php?title=RANSAC&oldid=116358182

{{{

Given:

data - a set of observed data points

model - a model that can be fitted to data points

n - the minimum number of data values required to fit the model

k - the maximum number of iterations allowed in the algorithm

t - a threshold value for determining when a data point fits a model

d - the number of close data values required to assert that a model fits well to data

Return:

bestfit - model parameters which best fit the data (or nil if no good model is found)

iterations = 0

bestfit = nil

besterr = something really large

while iterations < k {

maybeinliers = n randomly selected values from data

maybemodel = model parameters fitted to maybeinliers

alsoinliers = empty set

for every point in data not in maybeinliers {

if point fits maybemodel with an error smaller than t

add point to alsoinliers

}

if the number of elements in alsoinliers is > d {

% this implies that we may have found a good model

% now test how good it is

bettermodel = model parameters fitted to all points in maybeinliers and alsoinliers

thiserr = a measure of how well model fits these points

if thiserr < besterr {

bestfit = bettermodel

besterr = thiserr

}

}

increment iterations

}

return bestfit

}}}

"""

iterations = 0

bestfit = None

besterr = numpy.inf

best_inlier_idxs = None

while iterations < k:

maybe_idxs, test_idxs = random_partition(n,data.shape[0])

maybeinliers = data[maybe_idxs,:]

test_points = data[test_idxs]

maybemodel = model.fit(maybeinliers)

test_err = model.get_error( test_points, maybemodel)

also_idxs = test_idxs[test_err < t] # select indices of rows with accepted points

alsoinliers = data[also_idxs,:]

if debug:

print 'test_err.min()',test_err.min()

print 'test_err.max()',test_err.max()

print 'numpy.mean(test_err)',numpy.mean(test_err)

print 'iteration %d:len(alsoinliers) = %d'%(

iterations,len(alsoinliers))

if len(alsoinliers) > d:

betterdata = numpy.concatenate( (maybeinliers, alsoinliers) )

bettermodel = model.fit(betterdata)

better_errs = model.get_error( betterdata, bettermodel)

thiserr = numpy.mean( better_errs )

if thiserr < besterr:

bestfit = bettermodel

besterr = thiserr

best_inlier_idxs = numpy.concatenate( (maybe_idxs, also_idxs) )

iterations+=1

if bestfit is None:

raise ValueError("did not meet fit acceptance criteria")

if return_all:

return bestfit, {'inliers':best_inlier_idxs}

else:

return bestfit

def random_partition(n,n_data):

"""return n random rows of data (and also the other len(data)-n rows)"""

all_idxs = numpy.arange( n_data )

numpy.random.shuffle(all_idxs)

idxs1 = all_idxs[:n]

idxs2 = all_idxs[n:]

return idxs1, idxs2

class LinearLeastSquaresModel:

"""linear system solved using linear least squares

This class serves as an example that fulfills the model interface

needed by the ransac() function.

"""

def __init__(self,input_columns,output_columns,debug=False):

self.input_columns = input_columns

self.output_columns = output_columns

self.debug = debug

def fit(self, data):

A = numpy.vstack([data[:,i] for i in self.input_columns]).T

B = numpy.vstack([data[:,i] for i in self.output_columns]).T

x,resids,rank,s = scipy.linalg.lstsq(A,B)

return x

def get_error( self, data, model):

A = numpy.vstack([data[:,i] for i in self.input_columns]).T

B = numpy.vstack([data[:,i] for i in self.output_columns]).T

B_fit = scipy.dot(A,model)

err_per_point = numpy.sum((B-B_fit)**2,axis=1) # sum squared error per row

return err_per_point

def test():

# generate perfect input data

n_samples = 500

n_inputs = 1

n_outputs = 1

A_exact = 20*numpy.random.random((n_samples,n_inputs) )

perfect_fit = 60*numpy.random.normal(size=(n_inputs,n_outputs) ) # the model

B_exact = scipy.dot(A_exact,perfect_fit)

assert B_exact.shape == (n_samples,n_outputs)

# add a little gaussian noise (linear least squares alone should handle this well)

A_noisy = A_exact + numpy.random.normal(size=A_exact.shape )

B_noisy = B_exact + numpy.random.normal(size=B_exact.shape )

if 1:

# add some outliers

n_outliers = 100

all_idxs = numpy.arange( A_noisy.shape[0] )

numpy.random.shuffle(all_idxs)

outlier_idxs = all_idxs[:n_outliers]

non_outlier_idxs = all_idxs[n_outliers:]

A_noisy[outlier_idxs] = 20*numpy.random.random((n_outliers,n_inputs) )

B_noisy[outlier_idxs] = 50*numpy.random.normal(size=(n_outliers,n_outputs) )

# setup model

all_data = numpy.hstack( (A_noisy,B_noisy) )

input_columns = range(n_inputs) # the first columns of the array

output_columns = [n_inputs+i for i in range(n_outputs)] # the last columns of the array

debug = False

model = LinearLeastSquaresModel(input_columns,output_columns,debug=debug)

linear_fit,resids,rank,s = scipy.linalg.lstsq(all_data[:,input_columns],

all_data[:,output_columns])

# run RANSAC algorithm

ransac_fit, ransac_data = ransac(all_data,model,

50, 1000, 7e3, 300, # misc. parameters

debug=debug,return_all=True)

if 1:

import pylab

sort_idxs = numpy.argsort(A_exact[:,0])

A_col0_sorted = A_exact[sort_idxs] # maintain as rank-2 array

if 1:

pylab.plot( A_noisy[:,0], B_noisy[:,0], 'k.', label='data' )

pylab.plot( A_noisy[ransac_data['inliers'],0], B_noisy[ransac_data['inliers'],0], 'bx', label='RANSAC data' )

else:

pylab.plot( A_noisy[non_outlier_idxs,0], B_noisy[non_outlier_idxs,0], 'k.', label='noisy data' )

pylab.plot( A_noisy[outlier_idxs,0], B_noisy[outlier_idxs,0], 'r.', label='outlier data' )

pylab.plot( A_col0_sorted[:,0],

numpy.dot(A_col0_sorted,ransac_fit)[:,0],

label='RANSAC fit' )

pylab.plot( A_col0_sorted[:,0],

numpy.dot(A_col0_sorted,perfect_fit)[:,0],

label='exact system' )

pylab.plot( A_col0_sorted[:,0],

numpy.dot(A_col0_sorted,linear_fit)[:,0],

label='linear fit' )

pylab.legend()

pylab.show()

if __name__=='__main__':

test()

使用RANSAC算法用一条直线拟合来包含噪声数据点集

优点:能在包含大量外群的数据中准确地找到模型参数,并且参数不受到外群影响。

缺点:计算参数时没有一个最大运算时间的顶限,也就是说在迭代次数被限制的情况下,得出来的参数结果有可能并不是最优的,甚至可能不符合真实内群。所以设定 RANSAC参数的时候要根据应用考虑“准确度与效率”哪一个更重要,以此决定做多少次迭代运算。设定与模型的最大误差阈值也是要自己调,因应用而异。还有一点就是RANSAC只能估算一个模型。

3.3.2 稳健的单应性矩阵估计,图像拼接

我们在任何模型中都可以使用 RANSAC 模块。在使用 RANSAC 模块时,我们只需要在相应 Python 类中实现 fit() 和 get_error() 方法,剩下就是正确地使用 ransac.py。我们这里使用可能的对应点集来自动找到用于全景图像的单应性矩阵。

from PCV.localdescriptors import sift

from PIL import Image

from pylab import *

featname = ['D:\\pinjie\\Univ'+str(i+1)+'.sift' for i in range(5)]

imname = ['D:\\pinjie\\Univ'+str(i+1)+'.jpg' for i in range(5)]

l = {}

d = {}

for i in range(5):

sift.process_image(imname[i],featname[i])

l[i],d[i] = sift.read_features_from_file(featname[i])

matches = {}

for i in range(4):

matches[i] = sift.match(d[i+1],d[i])

估计出图像间的单应性矩阵(使用 RANSAC 算法),现在我们需要将所有的图像扭曲到一个公共的图像平面上。通常,这里的公共平面为中心图像平面(否则,需要进行大量变形)。一种方法是创建一个很大的图像,比如图像中全部填充 0,使其和中心图像平行,然后将所有的图像扭曲到上面。由于我们所有的图像是由照相机水平旋转拍摄的,因此我们可以使用一个较简单的步骤:将中心图像左边或者右边的区域填充0,以便为扭曲的图像腾出空间。

拼接图像的代码如下:

# -*- coding: utf-8 -*-

from pylab import *

from numpy import *

from PIL import Image

# If you have PCV installed, these imports should work

from PCV.geometry import homography, warp

from PCV.localdescriptors import sift

"""

This is the panorama example from section 3.3.

"""

# 设置数据文件夹的路径

featname = ['D:\\pinjie\\Univ' + str(i + 1) + '.sift' for i in range(5)]

imname = ['D:\\pinjie\\Univ' + str(i + 1) + '.jpg' for i in range(5)]

# 提取特征并匹配使用sift算法

l = {}

d = {}

for i in range(5):

sift.process_image(imname[i], featname[i])

l[i], d[i] = sift.read_features_from_file(featname[i])

matches = {}

for i in range(4):

matches[i] = sift.match(d[i + 1], d[i])

# 可视化匹配

for i in range(4):

im1 = array(Image.open(imname[i]))

im2 = array(Image.open(imname[i + 1]))

figure()

sift.plot_matches(im2, im1, l[i + 1], l[i], matches[i], show_below=True)

# 将匹配转换成齐次坐标点的函数

def convert_points(j):

ndx = matches[j].nonzero()[0]

fp = homography.make_homog(l[j + 1][ndx, :2].T)

ndx2 = [int(matches[j][i]) for i in ndx]

tp = homography.make_homog(l[j][ndx2, :2].T)

# switch x and y - TODO this should move elsewhere

fp = vstack([fp[1], fp[0], fp[2]])

tp = vstack([tp[1], tp[0], tp[2]])

return fp, tp

# 估计单应性矩阵

model = homography.RansacModel()

fp, tp = convert_points(1)

H_12 = homography.H_from_ransac(fp, tp, model)[0] # im 1 to 2

fp, tp = convert_points(0)

H_01 = homography.H_from_ransac(fp, tp, model)[0] # im 0 to 1

tp, fp = convert_points(2) # NB: reverse order

H_32 = homography.H_from_ransac(fp, tp, model)[0] # im 3 to 2

tp, fp = convert_points(3) # NB: reverse order

H_43 = homography.H_from_ransac(fp, tp, model)[0] # im 4 to 3

# 扭曲图像

delta = 2000 # for padding and translation用于填充和平移

im1 = array(Image.open(imname[1]), "uint8")

im2 = array(Image.open(imname[2]), "uint8")

im_12 = warp.panorama(H_12,im1,im2,delta,delta)

im1 = array(Image.open(imname[0]), "f")

im_02 = warp.panorama(dot(H_12,H_01),im1,im_12,delta,delta)

im1 = array(Image.open(imname[3]), "f")

im_32 = warp.panorama(H_32,im1,im_02,delta,delta)

im1 = array(Image.open(imname[4]), "f")

im_42 = warp.panorama(dot(H_32,H_43),im1,im_32,delta,2*delta)

figure()

imshow(array(im_42, "uint8"))

axis('off')

show()

对于通用的 geometric_transform() 函数,我们需要指定能够描述像素到像素间映射的函数。在这个例子中,transf() 函数就是该指定的函数。该函数通过将像素和 H 相乘,然后对齐次坐标进行归一化来实现像素间的映射。通过查看H 中的平移量, 我们可以决定应该将该图像填补到左边还是右边。当该图像填补到左边时,由于目标图像中点的坐标也变化了,所以在“左边”情况中,需要在单应性矩阵中加入平移。简单起见,我们同样使用 0 像素的技巧来寻找 alpha 图。