一致性算法

一致性算法

Basic Paxos

通过一个决议分为两个阶段:

-

prepare阶段:

- proposer选择一个提案编号n并将prepare请求发送给acceptors中的一个多数派;

- acceptor收到prepare消息后,如果提案的编号大于它已经回复的所有prepare消息(回复消息表示接受accept),则acceptor将自己上次接受的提案回复给proposer,并承诺不再回复小于n的提案;

-

批准阶段:

- 当一个proposer收到了多数acceptors对prepare的回复后,就进入批准阶段。它要向回复prepare请求的acceptors发送accept请求,包括编号n和根据P2c决定的value(如果根据P2c没有已经接受的value,那么它可以自由决定value)。

- 在不违背自己向其他proposer的承诺的前提下,acceptor收到accept请求后即批准这个请求。

Multi-Paxos

Paxos的典型部署需要一组连续的被接受的值(value),作为应用到一个分布式状态机的一组命令。如果每个命令都通过一个Basic Paxos算法实例来达到一致,会产生大量开销。

如果Leader是相对稳定不变的,第1阶段就变得不必要。 这样,系统可以在接下来的Paxos算法实例中,跳过的第1阶段,直接使用同样的Leader。

为了实现这一目的,在同一个Leader执行每轮Paxos算法时,提案编号 I 每次递增一个值,并与每个值一起发送。Multi-Paxos在没有故障发生时,将消息延迟(从propose阶段到learn阶段)从4次延迟降低为2次延迟。

Multi-Paxos 没有失败的情况

在下面的图中,只显示了基本Paxos协议的一个实例(或“执行”)和一个初始Leader(Proposer)。注意,Multi-Paxos使用几个Basic Paxos的实例。

Client Proposer Acceptor Learner

| | | | | | | --- First Request ---

X-------->| | | | | | Request

| X--------->|->|->| | | Prepare(N)

| |<---------X--X--X | | Promise(N,I,{Va,Vb,Vc})

| X--------->|->|->| | | Accept!(N,I,V)

| |<---------X--X--X------>|->| Accepted(N,I,V)

|<---------------------------------X--X Response

| | | | | | |

式中V = (Va, Vb, Vc) 中最新的一个。

跳过阶段1时的Multi-Paxos

在这种情况下,Basic Paxos的后续实例(由I+1表示)使用相同的Leader,因此,包含在Prepare和Promise的阶段1(Basic Paxos协议的这些后续实例)将被跳过。注意,这里要求Leader应该是稳定的,即它不应该崩溃或改变。

Client Proposer Acceptor Learner

| | | | | | | --- Following Requests ---

X-------->| | | | | | Request

| X--------->|->|->| | | Accept!(N,I+1,W)

| |<---------X--X--X------>|->| Accepted(N,I+1,W)

|<---------------------------------X--X Response

| | | | | | |

ZAB

ZAB协议是Multi-Paxos协议的变形,也是只有一个Leader能够接收写操作请求。

ZAB协议中主要有两种模式,第一是消息广播模式;第二是崩溃恢复模式。

消息广播模式

- 客户端发起一个写操作请求。

- Leader服务器将客户端的request请求转化为事务proposql提案,同时为每个proposal分配一个全局唯一的ID,即ZXID。

- leader服务器与每个follower之间都有一个队列,leader将消息发送到该队列。

- follower机器从队列中取出消息处理(写入本地事务日志中)完毕后,向leader服务器发送ACK确认。

- leader服务器收到半数以上的follower的ACK后,即认为可以发送commit。

- leader向所有的follower服务器发送commit消息。

崩溃恢复模式

- zookeeper集群中为保证任何所有进程能够有序的顺序执行,只能是leader服务器接受写请求,即使是follower服务器接受到客户端的请求,也会转发到leader服务器进行处理。

- 如果leader服务器发生崩溃,则zab协议要求zookeeper集群进行崩溃恢复和leader服务器选举。

- ZAB协议崩溃恢复要求满足如下2个要求:

- 确保已经被leader提交的proposal必须最终被所有的follower服务器提交。

- 确保丢弃已经被leader出的但是没有被提交的proposal。

- 根据上述要求,新选举出来的leader不能包含未提交的proposal,即新选举的leader必须都是已经提交了的proposal的follower服务器节点。同时,新选举的leader节点中含有最高的ZXID。这样做的好处就是可以避免了leader服务器检查proposal的提交和丢弃工作。

- leader服务器发生崩溃时分为如下场景:

- leader在提出proposal时未提交之前崩溃,则经过崩溃恢复之后,新选举的leader一定不能是刚才的leader。因为这个leader存在未提交的proposal。

- leader在发送commit消息之后,崩溃。即消息已经发送到队列中。经过崩溃恢复之后,参与选举的follower服务器(刚才崩溃的leader有可能已经恢复运行,也属于follower节点范畴)中有的节点已经是消费了队列中所有的commit消息。即该follower节点将会被选举为最新的leader。剩下动作就是数据同步过程。

投票流程

自增选举轮次

Zookeeper规定所有有效的投票都必须在同一轮次中。每个服务器在开始新一轮投票时,会先对自己维护的logicClock进行自增操作。

初始化选票

每个服务器在广播自己的选票前,会将自己的投票箱清空。该投票箱记录了所收到的选票。例:服务器2投票给服务器3,服务器3投票给服务器1,则服务器1的投票箱为(2, 3), (3, 1), (1, 1)。票箱中只会记录每一投票者的最后一票,如投票者更新自己的选票,则其它服务器收到该新选票后会在自己票箱中更新该服务器的选票。

发送初始化选票

每个服务器最开始都是通过广播把票投给自己。

接收外部投票

服务器会尝试从其它服务器获取投票,并记入自己的投票箱内。如果无法获取任何外部投票,则会确认自己是否与集群中其它服务器保持着有效连接。如果是,则再次发送自己的投票;如果否,则马上与之建立连接。

判断选举轮次

收到外部投票后,首先会根据投票信息中所包含的logicClock来进行不同处理

- 外部投票的logicClock大于自己的logicClock。说明该服务器的选举轮次落后于其它服务器的选举轮次,立即清空自己的投票箱并将自己的logicClock更新为收到的logicClock,然后再对比自己之前的投票与收到的投票以确定是否需要变更自己的投票,最终再次将自己的投票广播出去。

- 外部投票的logicClock小于自己的logicClock。当前服务器直接忽略该投票,继续处理下一个投票。

- 外部投票的logickClock与自己的相等。进行选票PK。

选票PK

选票PK是基于(self_id, self_zxid)与(vote_id, vote_zxid)的对比

- 外部投票的logicClock大于自己的logicClock,则将自己的logicClock及自己的选票的logicClock变更为收到的logicClock

- 若logicClock一致,则对比二者的vote_zxid,若外部投票的vote_zxid比较大,则将自己的票中的vote_zxid与vote_myid更新为收到的票中的vote_zxid与vote_myid并广播出去,另外将收到的票及自己更新后的票放入自己的票箱。如果票箱内已存在(self_myid, self_zxid)相同的选票,则直接覆盖

- 若二者vote_zxid一致,则比较二者的vote_myid,若外部投票的vote_myid比较大,则将自己的票中的vote_myid更新为收到的票中的vote_myid并广播出去,另外将收到的票及自己更新后的票放入自己的票箱

统计选票

如果已经确定有过半服务器认可了自己的投票(可能是更新后的投票),则终止投票。否则继续接收其它服务器的投票。

更新服务器状态

投票终止后,服务器开始更新自身状态。若过半的票投给了自己,则将自己的服务器状态更新为LEADING,否则将自己的状态更新为FOLLOWING

Raft

演示:https://raft.github.io/

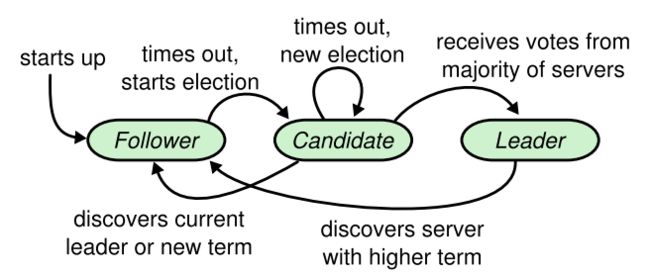

raft协议中,一个节点任一时刻处于以下三个状态之一:

- leader

- follower

- candidate

给出状态转移图能很直观的直到这三个状态的区别

Server states. Followers only respond to requests from other servers.

If a follower receives no communication, it becomes a candidate and initiates an election.

A candidate that receives votes from a majority of the full cluster becomes the new leader.

Leaders typically operate until they fail.

选举过程详解

上面已经说过,如果follower在election timeout内没有收到来自leader的心跳,(也许此时还没有选出leader,大家都在等;也许leader挂了;也许只是leader与该follower之间网络故障),则会主动发起选举。步骤如下:

- 增加节点本地的 current term ,切换到candidate状态

- 投自己一票

- 并行给其他节点发送 RequestVote RPCs

- 等待其他节点的回复

在这个过程中,根据来自其他节点的消息,可能出现三种结果:

- 收到majority的投票(含自己的一票),则赢得选举,成为leader

- 被告知别人已当选,那么自行切换到follower

- 一段时间内没有收到majority投票,则保持candidate状态,重新发出选举

第一种情况,赢得了选举之后,新的leader会立刻给所有节点发消息,广而告之,避免其余节点触发新的选举。在这里,先回到投票者的视角,投票者如何决定是否给一个选举请求投票呢,有以下约束:

- 在任一任期内,单个节点最多只能投一票

- 候选人知道的信息不能比自己的少(AppendEntries,先比较logTerm,再比较logIndex)

- first-come-first-served 先来先得

第二种情况,比如有三个节点A B C。A B同时发起选举,而A的选举消息先到达C,C给A投了一票,当B的消息到达C时,已经不能满足上面提到的第一个约束,即C不会给B投票,而A和B显然都不会给对方投票。A胜出之后,会给B,C发心跳消息,节点B发现节点A的term不低于自己的term,知道有已经有Leader了,于是转换成follower。

第三种情况,没有任何节点获得majority投票,出现了平票 split vote的情况。这个时候大家都在等啊等,直到超时后重新发起选举。如果出现平票的情况,那么就延长了系统不可用的时间(没有leader是不能处理客户端写请求的),因此raft引入了randomized election timeouts来尽量避免平票情况。同时,leader-based 共识算法中,节点的数目都是奇数个,尽量保证majority的出现。

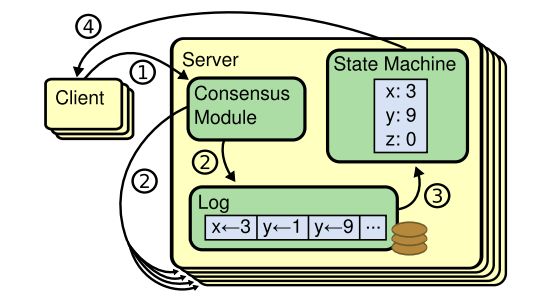

log replication

请求完整流程

当系统(leader)收到一个来自客户端的写请求,到返回给客户端,整个过程从leader的视角来看会经历以下步骤:

- leader append log entry

- leader issue AppendEntries RPC in parallel

- leader wait for majority response

- leader apply entry to state machine

- leader reply to client

- leader notify follower apply log

这里有两个词:commit(committed),apply(applied),前者是指日志被复制到了大多数节点后日志的状态;而后者则是节点将日志应用到状态机,真正影响到节点状态。

log matching

log匹配特性, 就是说如果两个节点上的某个log entry的log index相同且term相同,那么在该index之前的所有log entry应该都是相同的。

leader会维护一个nextIndex[]数组,记录了leader可以发送每一个follower的log index,初始化为eader最后一个log index加1, 前面也提到,leader选举成功之后会立即给所有follower发送AppendEntries RPC(不包含任何log entry, 也充当心跳消息),那么流程总结为:

- leader 初始化nextIndex[x]为 leader最后一个log index + 1

- AppendEntries里prevLogTerm prevLogIndex来自 logs[nextIndex[x] - 1]

- 如果follower判断prevLogIndex位置的log term不等于prevLogTerm,那么返回 false,否则返回True

- leader收到follower的恢复,如果返回值是True,则nextIndex[x] -= 1, 跳转到2。 否则

- 同步nextIndex[x]后的所有log entries

leader完整性:如果一个log entry在某个任期被提交(committed),那么这条日志一定会出现在所有更高term的leader的日志里面。这个跟leader election、log replication都有关。

- 一个日志被复制到majority节点才算committed

- 一个节点得到majority的投票才能成为leader,而节点A给节点B投票的其中一个前提是,B的日志不能比A的日志旧。下面的引文指处了如何判断日志的新旧

上面两点都提到了majority:commit majority and vote majority,根据Quorum,这两个majority一定是有重合的,因此被选举出的leader一定包含了最新的committed的日志。

raft与其他协议(Viewstamped Replication、mongodb)不同,raft始终保证leade包含最新的已提交的日志,因此leader不会从follower catchup日志,这也大大简化了系统的复杂度。

为了防止前任日志提交后被覆盖,某个leader选举成功之后,不会直接提交前任leader时期的日志,而是通过提交当前任期的日志的时候“顺手”把之前的日志也提交了,在任期开始的时候发立即尝试复制、提交一条空的log

总结

raft将共识问题分解成两个相对独立的问题,leader election,log replication。流程是先选举出leader,然后leader负责复制、提交log(log中包含command)

为了在任何异常情况下系统不出错,即满足safety属性,对leader election,log replication两个子问题有诸多约束

leader election约束:

- 同一任期内最多只能投一票,先来先得

- 选举人必须比自己知道的更多(比较term,log index)

log replication约束:

- 一个log被复制到大多数节点,就是committed,保证不会回滚

- leader一定包含最新的committed log,因此leader只会追加日志,不会删除覆盖日志

- 不同节点,某个位置上日志相同,那么这个位置之前的所有日志一定是相同的

- Raft never commits log entries from previous terms by counting replicas.