系统搭建之前必须要有 java运行环境、关闭防火墙、集群之间要互相ping通!

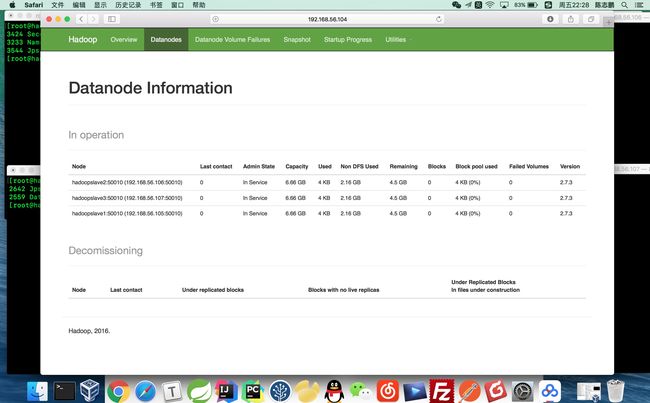

我的机器有1个NameNode节点,3个DataNode节点

ip:192.168.56.104 NameNode

192.168.56.105 DataNode1

192.168.56.106 DataNode2

192.168.56.107 DataNode3

还有就是一些简单的Linux命令要会使用,下面开始搭建步骤。

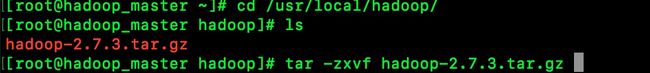

1、解压hadoop

2,配置hadoop的java运行环境

hadoop的java运行环境

编辑hadoop-env.sh这个文件 配置上java的环境地址

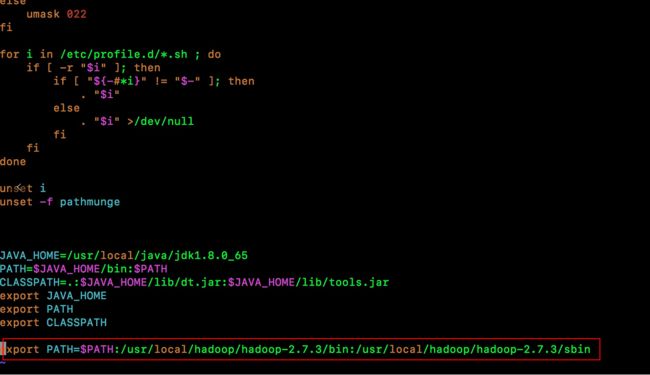

3、在Linux中配置hadoop环境

vim /etc/profile

为了在Linux环境中能使用hadoop命令 编辑profile加入以下以下环境变量。

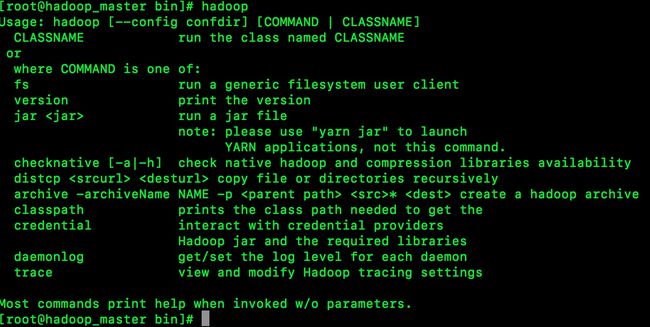

wq 保存后 输入hadoop 按回车出现以下内容安装完毕

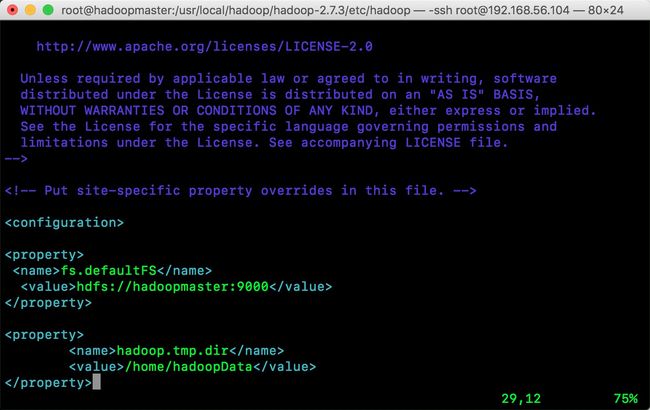

4、每台hadoop节点都必须要配上自己所属NameNolde,并且设置DataNode数据存放的地方

编辑core-site.xml

vim hadoop/hadoop-2.7.3/etc/hadoop/core-site.xm

5、为了方便启动使用SSH免密登录、这里不多讲可以参考以下链接

SSH免密登录教程:http://www.jb51.net/article/94599.html

为了能使用一个命令启动整个HDFS集群,修改slaves文件

vim hadoop/hadoop-2.7.3/etc/hadoop/slaves

(大家注意!!!:我这里是错误的! HDFS域名不能有下划线,这是昨天截的图所以没改)

这里主要是在NameNode 配置属于他的DataNode,这些域名要通过修改hosts文件 说简单点换成IP也行。

6、在NameNode节点格式化HDFS

输入命令 hdfs namenode -format

修改 hdfs-site.xml 文件

vim hdfs-site.xml

在configuration标签里加入以下内容:

6、启动HDFS集群

输入命令:start-dfs.sh

等待一下下整个集群就能成功了,如果启动失败可以再logs文件夹中查看失败日志

如果能成功启动 输入命令:jps你会看到节点都能起来如下:

又或者可以打开游览器输入 NameNode的ip端口为:50070

比如我访问:http://192.168.56.104:50070,你会看到NameNode带着3个DataNode

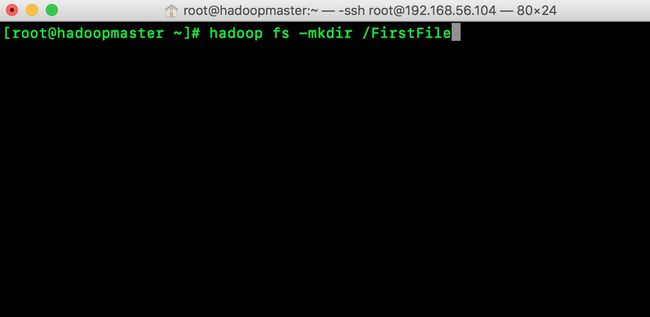

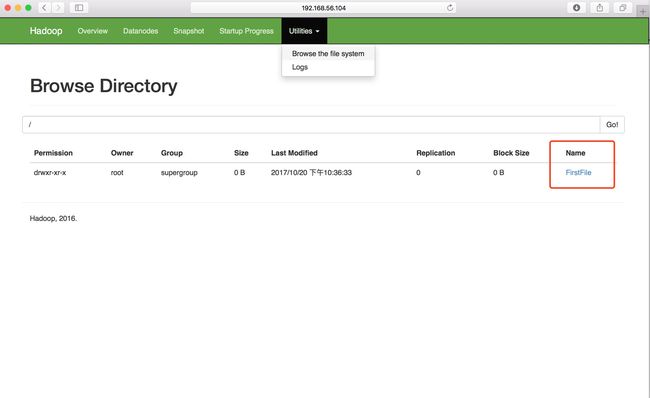

7、创建文件

NameNode节点输入:hadoop fs -mkdir /FirstFile

你会看见多了一个你刚刚创建的文件

8、上传文件到HDFS系统中

NameNode节点输入:hadoop fs -put/要上传的文件路径 /HDFS文件存放路径

你会看到这个文件已经分块上传到了HDFS系统中了。

当然啦 还有很多很多的命令,我也是刚刚初学,用到的的时候可以查文档。