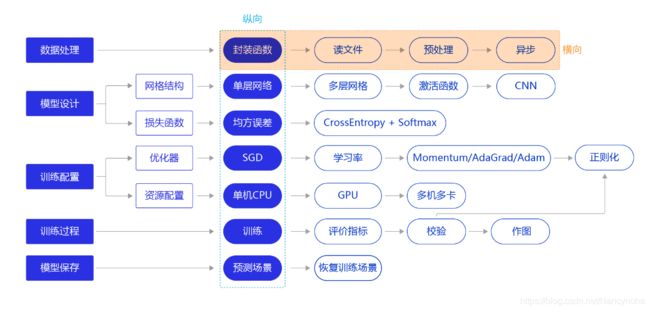

百度飞桨坚持21天深度学习架构训练营之MNIST手写识别之【数据处理】

手写识别之数据处理

- 概述

- 1.读入数据并划分数据集

- 2.训练样本乱序、生成批次数据

- 3.校验数据有效性

- 机器校验

- 人工校验

- 封装数据读取与处理函数

概述

在工业实践中,我们面临的任务和数据环境千差万别,通常需要自己编写适合当前任务的数据处理程序,一般涉及如下三个环节:

- 读入数据并划分数据集

- 生成批次数据并训练样本集乱序

- 校验数据有效性

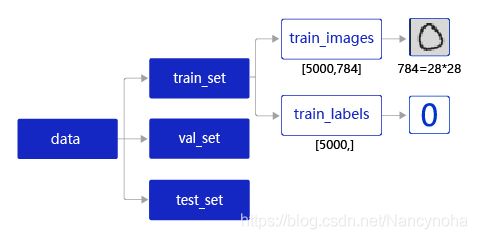

1.读入数据并划分数据集

在实际应用中,保存到本地的数据存储格式多种多样,如MNIST数据集以json格式存储在本地。

# 声明数据集文件位置

datafile = './work/mnist.json.gz'

print('loading mnist dataset from {} ......'.format(datafile))

# 加载json数据文件

data = json.load(gzip.open(datafile))

print('mnist dataset load done')

# 读取到的数据区分训练集,验证集,测试集

train_set, val_set, eval_set = data

# 数据集相关参数,图片高度IMG_ROWS, 图片宽度IMG_COLS

IMG_ROWS = 28

IMG_COLS = 28

# 打印数据信息

imgs, labels = train_set[0], train_set[1]

print("训练数据集数量: ", len(imgs))

# 观察验证集数量

imgs, labels = val_set[0], val_set[1]

print("验证数据集数量: ", len(imgs))

# 观察测试集数量

imgs, labels = val= eval_set[0], eval_set[1]

print("测试数据集数量: ", len(imgs))

loading mnist dataset from ./work/mnist.json.gz ......

mnist dataset load done

训练数据集数量: 50000

验证数据集数量: 10000

测试数据集数量: 10000

2.训练样本乱序、生成批次数据

imgs, labels = train_set[0], train_set[1]

print("训练数据集数量: ", len(imgs))

# 获得数据集长度

imgs_length = len(imgs)

# 定义数据集每个数据的序号,根据序号读取数据

index_list = list(range(imgs_length))

# 读入数据时用到的批次大小

BATCHSIZE = 100

# 随机打乱训练数据的索引序号

random.shuffle(index_list)

# 定义数据生成器,返回批次数据

def data_generator():

imgs_list = []

labels_list = []

for i in index_list:

# 将数据处理成期望的格式,比如类型为float32,shape为[1, 28, 28]

img = np.reshape(imgs[i], [1, IMG_ROWS, IMG_COLS]).astype('float32')

label = np.reshape(labels[i], [1]).astype('float32')

imgs_list.append(img)

labels_list.append(label)

if len(imgs_list) == BATCHSIZE:

# 获得一个batchsize的数据,并返回

yield np.array(imgs_list), np.array(labels_list)

# 清空数据读取列表

imgs_list = []

labels_list = []

# 如果剩余数据的数目小于BATCHSIZE,

# 则剩余数据一起构成一个大小为len(imgs_list)的mini-batch

if len(imgs_list) > 0:

yield np.array(imgs_list), np.array(labels_list)

return data_generator

训练数据集数量: 50000

打印第一个batch的维度

# 声明数据读取函数,从训练集中读取数据

train_loader = data_generator

# 以迭代的形式读取数据

for batch_id, data in enumerate(train_loader()):

image_data, label_data = data

if batch_id == 0:

# 打印数据shape和类型

print("打印第一个batch数据的维度:")

print("图像维度: {}, 标签维度: {}".format(image_data.shape, label_data.shape))

break

打印第一个batch数据的维度:

图像维度: (100, 1, 28, 28), 标签维度: (100, 1)

3.校验数据有效性

在实际应用中,原始数据可能存在标注不准确、数据杂乱或格式不统一等情况。因此在完成数据处理流程后,还需要进行数据校验,一般有两种方式:

- 机器校验:加入一些校验和清理数据的操作。

- 人工校验:先打印数据输出结果,观察是否是设置的格式;再从训练的结果验证数据处理和读取的有效性。

机器校验

如下代码所示,如果数据集中的图片数量和标签数量不等,说明数据逻辑存在问题,可使用 assert 语句校验图像数量和标签数据是否一致。

imgs_length = len(imgs)

assert len(imgs) == len(labels), \

"length of train_imgs({}) should be the same as train_labels({})".format(len(imgs), len(label))

人工校验

人工校验是指打印数据输出结果,观察是否是预期的格式。实现数据处理和加载函数后,我们可以调用它读取一次数据,观察数据的shape和类型是否与函数中设置的一致。

# 声明数据读取函数,从训练集中读取数据

train_loader = data_generator

# 以迭代的形式读取数据

for batch_id, data in enumerate(train_loader()):

image_data, label_data = data

if batch_id == 0:

# 打印数据shape和类型

print("打印第一个batch数据的维度,以及数据的类型:")

print("图像维度: {}, 标签维度: {}, 图像数据类型: {}, 标签数据类型: {}".format(image_data.shape, label_data.shape, type(image_data), type(label_data)))

break

打印第一个batch数据的维度,以及数据的类型:

图像维度: (100, 1, 28, 28), 标签维度: (100, 1), 图像数据类型: , 标签数据类型:

封装数据读取与处理函数

整套流程实现为:

def load_data(mode='train'):

datafile = './work/mnist.json.gz'

print('loading mnist dataset from {} ......'.format(datafile))

# 加载json数据文件

data = json.load(gzip.open(datafile))

print('mnist dataset load done')

# 读取到的数据区分训练集,验证集,测试集

train_set, val_set, eval_set = data

if mode=='train':

# 获得训练数据集

imgs, labels = train_set[0], train_set[1]

elif mode=='valid':

# 获得验证数据集

imgs, labels = val_set[0], val_set[1]

elif mode=='eval':

# 获得测试数据集

imgs, labels = eval_set[0], eval_set[1]

else:

raise Exception("mode can only be one of ['train', 'valid', 'eval']")

print("训练数据集数量: ", len(imgs))

# 校验数据

imgs_length = len(imgs)

assert len(imgs) == len(labels), \

"length of train_imgs({}) should be the same as train_labels({})".format(len(imgs), len(label))

# 获得数据集长度

imgs_length = len(imgs)

# 定义数据集每个数据的序号,根据序号读取数据

index_list = list(range(imgs_length))

# 读入数据时用到的批次大小

BATCHSIZE = 100

# 定义数据生成器

def data_generator():

if mode == 'train':

# 训练模式下打乱数据

random.shuffle(index_list)

imgs_list = []

labels_list = []

for i in index_list:

# 将数据处理成希望的格式,比如类型为float32,shape为[1, 28, 28]

img = np.reshape(imgs[i], [1, IMG_ROWS, IMG_COLS]).astype('float32')

label = np.reshape(labels[i], [1]).astype('float32')

imgs_list.append(img)

labels_list.append(label)

if len(imgs_list) == BATCHSIZE:

# 获得一个batchsize的数据,并返回

yield np.array(imgs_list), np.array(labels_list)

# 清空数据读取列表

imgs_list = []

labels_list = []

# 如果剩余数据的数目小于BATCHSIZE,

# 则剩余数据一起构成一个大小为len(imgs_list)的mini-batch

if len(imgs_list) > 0:

yield np.array(imgs_list), np.array(labels_list)

return data_generator

下面定义一层神经网络,利用定义好的数据处理函数,完成神经网络的训练

#数据处理部分之后的代码,数据读取的部分调用Load_data函数

# 定义网络结构,同上一节所使用的网络结构

class MNIST(fluid.dygraph.Layer):

def __init__(self):

super(MNIST, self).__init__()

self.fc = Linear(input_dim=784, output_dim=1, act=None)

def forward(self, inputs):

inputs = fluid.layers.reshape(inputs, (-1, 784))

outputs = self.fc(inputs)

return outputs

# 训练配置,并启动训练过程

with fluid.dygraph.guard():

model = MNIST()

model.train()

#调用加载数据的函数

train_loader = load_data('train')

optimizer = fluid.optimizer.SGDOptimizer(learning_rate=0.001, parameter_list=model.parameters())

EPOCH_NUM = 10

for epoch_id in range(EPOCH_NUM):

for batch_id, data in enumerate(train_loader()):

#准备数据,变得更加简洁

image_data, label_data = data

image = fluid.dygraph.to_variable(image_data)

label = fluid.dygraph.to_variable(label_data)

#前向计算的过程

predict = model(image)

#计算损失,取一个批次样本损失的平均值

loss = fluid.layers.square_error_cost(predict, label)

avg_loss = fluid.layers.mean(loss)

#每训练了200批次的数据,打印下当前Loss的情况

if batch_id % 200 == 0:

print("epoch: {}, batch: {}, loss is: {}".format(epoch_id, batch_id, avg_loss.numpy()))

#后向传播,更新参数的过程

avg_loss.backward()

optimizer.minimize(avg_loss)

model.clear_gradients()

#保存模型参数

fluid.save_dygraph(model.state_dict(), 'mnist')