论文笔记Deformable Siamese Attention Networks for Visual Object Tracking

论文笔记Deformable Siamese Attention Networks for Visual Object Tracking

- 1. 论文标题及来源

- 2. 拟解决问题

- 3. 解决方法

- 3.1 算法流程

- 3.2 Deformable Siamese Attention Module

- 3.4 主要公式

- 3.3 Region Refinement Module

- 4. 实验结果

- 4.1 OTB100

- 4.2 VOT2016 & VOT2018

- 4.3 UAV123

- 4.4 LaSOT

- 4.5 TrackingNet

- 4.6 Ablation Study

- 5. 总结

1. 论文标题及来源

Deformable Siamese Attention Networks for Visual Object Tracking, CVPR, 2020

下载地址:https://openaccess.thecvf.com/content_CVPR_2020/papers/Yu_Deformable_Siamese_Attention_Networks_for_Visual_Object_Tracking_CVPR_2020_paper.pdf

2. 拟解决问题

a. 模板不会在线更新

b. 搜索区域和模板的特征通过孪生网络单独计算

3. 解决方法

3.1 算法流程

该算法整体流程较简单,上图是其网络结构。它的流程如下

a. 将模板和搜索区域输入骨干网络(Resnet-50)中提取特征

b. 通过DSA(deformable siamese attention)模块增强Resnet-50的第3-5层特征

c. 将第3-5层特征分别输入SiamRPN中得到响应图

d. 将得到的响应图进行加权融合,得到最终的响应图(与SiamRPN++一致)

e. 通过该响应图得到分类得分和回归偏移

f. 根据回归偏移得到proposals

g. 将所有的proposal依次输入Region Refinement,得到一个更好的bbox和mask

在步骤g中应该是能进行批量化操作的,但是没想明白怎么进行批量化操作的,欢迎大佬指教

3.2 Deformable Siamese Attention Module

在该模块中,作者加入了自注意力模块(包括空间自注意力机制和通道自注意力机制)和交叉注意力模块。上图是其特征融合方式,输入是Resnet-50输出的特征图(包括模板和搜索区域),输出是融合后的特征图(包括模板和搜索区域)。

融合流程及维度变换如下:

a. 输入来自骨干网络特定层的特征,记为X(C, H, W)

b. 以搜索区域分支为例,对于空间自注意力机制,对X使用1x1卷积得到query features,记为Q(C’, H, W),通过reshape得到 Q ‾ ( C ′ , N ) , N = H ∗ W \overline{Q}(C', N),N=H * W Q(C′,N),N=H∗W

c. 对X使用1x1卷积得到key features,记为K(C’, H, W),通过reshape得到 K ‾ ( C ′ , N ) , N = H ∗ W \overline{K}(C', N),N=H * W K(C′,N),N=H∗W

d. 空间自注意力特征图 A ( N , N ) = s o f t m a x c o l ( Q ‾ T K ‾ ) A(N, N)=softmax_{col}(\overline{Q}^T \overline{K}) A(N,N)=softmaxcol(QTK),通过矩阵相乘的方式即可得到指定维度的空间自注意力特征图

e. 对X使用1x1卷积和reshape操作得到value features,记为 V ‾ ( C , N ) \overline{V}(C, N) V(C,N)

f. 对X使用reshape操作得到 X ‾ ( C , N ) \overline{X}(C, N) X(C,N)

g. 空间自注意力机制融合后的特征记为 X 1 ( C , N ) = α V ‾ A + X ‾ X_1(C, N) = \alpha \overline{V} A + \overline{X} X1(C,N)=αVA+X,通过reshape操作即可得到空间自注意力模块输出的特征图

h. 同理可得到通道注意力模块和交叉注意力模块输出的特征图,值得注意的是,该交叉注意力模块将模板和搜索区域的特征融合,这些模块的维度处理方式与空间注意力机制类似(矩阵乘法和reshape)

i. 将这些注意力机制模块输出的特征图相加并使用可变形卷积得到最终的搜索区域特征图

j. 同理得到模板分支的最终特征图

3.4 主要公式

损失函数: L = L r p n − c l s + λ 1 L r p n − r e g + λ 2 L r e f i n e − b o x + λ 3 L r e f i n e − m a s k L = L_{rpn-cls} + \lambda_1 L_{rpn-reg} + \lambda_2 L_{refine-box} + \lambda_3 L_{refine-mask} L=Lrpn−cls+λ1Lrpn−reg+λ2Lrefine−box+λ3Lrefine−mask

λ 1 = 0.2 , λ 2 = 0.2 , λ 3 = 0.1 \lambda_1 = 0.2, \lambda_2 = 0.2, \lambda_3 = 0.1 λ1=0.2,λ2=0.2,λ3=0.1

3.3 Region Refinement Module

通过特征融合模块融合多阶段SiamRPN输出的响应图,特征融合模块中还接受了来自前两层的特征,对于尺寸问题,可以采用上采样、下采样或者1x1卷积。然后使用可变形的RoI pooling使模板特征更准确。

4. 实验结果

4.1 OTB100

4.2 VOT2016 & VOT2018

4.3 UAV123

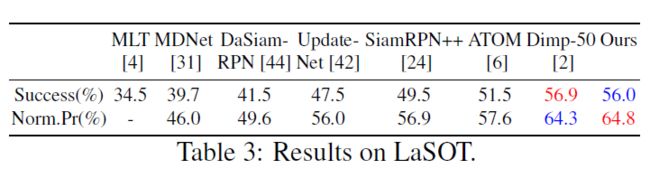

4.4 LaSOT

4.5 TrackingNet

4.6 Ablation Study

从这些消融分析实验可以看出,加上了注意力机制模块后,它的效果提升非常明显

5. 总结

该论文使用自注意力机制和交叉注意力机制模块,通过可变形卷积融合这些模块输出的特征,取得了非常显著的效果,并且通过候选区域校正模块进行提升定位精确度。

疯狂吐槽:这边论文的特征融合手段简直是绝了。