OPENCV3.0 双目立体标定

这里是在上一篇单目标定的基础上拓展来的进行双目标定的程序。

在这个程序里面,默认是先对两个摄像头分别进行了单目标定的,也就是说相机的内参数和畸变向量是知道了的。

所以在进行标定的时候,参数选择的是CALIB_USE_INTRINSIC_GUESS。

此程序依然是使用系统自带的标定的图片,其路径在opencv的安装目录下:opencv\sources\samples\data。

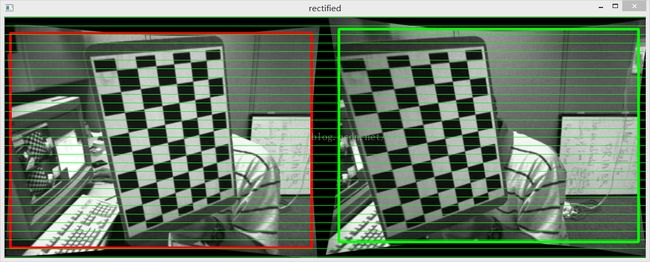

本程序最终的输出图像为

上图就是左右相机的图像经过行对准之后的结果。

具体的代码如下:

// stereoCalibration.cpp : 定义控制台应用程序的入口点。

//

//在进行双目摄像头的标定之前,最好事先分别对两个摄像头进行单目视觉的标定

//分别确定两个摄像头的内参矩阵,然后再开始进行双目摄像头的标定

//在此例程中是先对两个摄像头进行单独标定(见上一篇单目标定文章),然后在进行立体标定

#include "stdafx.h"

#include

#include

#include "cv.h"

#include

#include

using namespace std;

using namespace cv;

const int imageWidth = 640; //摄像头的分辨率

const int imageHeight = 480;

const int boardWidth = 9; //横向的角点数目

const int boardHeight = 6; //纵向的角点数据

const int boardCorner = boardWidth * boardHeight; //总的角点数据

const int frameNumber = 13; //相机标定时需要采用的图像帧数

const int squareSize = 20; //标定板黑白格子的大小 单位mm

const Size boardSize = Size(boardWidth, boardHeight); //

Size imageSize = Size(imageWidth, imageHeight);

Mat R, T, E, F; //R 旋转矢量 T平移矢量 E本征矩阵 F基础矩阵

vector rvecs; //旋转向量

vector tvecs; //平移向量

vector> imagePointL; //左边摄像机所有照片角点的坐标集合

vector> imagePointR; //右边摄像机所有照片角点的坐标集合

vector> objRealPoint; //各副图像的角点的实际物理坐标集合

vector cornerL; //左边摄像机某一照片角点坐标集合

vector cornerR; //右边摄像机某一照片角点坐标集合

Mat rgbImageL, grayImageL;

Mat rgbImageR, grayImageR;

Mat Rl, Rr, Pl, Pr, Q; //校正旋转矩阵R,投影矩阵P 重投影矩阵Q (下面有具体的含义解释)

Mat mapLx, mapLy, mapRx, mapRy; //映射表

Rect validROIL, validROIR; //图像校正之后,会对图像进行裁剪,这里的validROI就是指裁剪之后的区域

/*

事先标定好的左相机的内参矩阵

fx 0 cx

0 fy cy

0 0 1

*/

Mat cameraMatrixL = (Mat_(3, 3) << 532.782, 0, 532.904,

0, 342.505, 233.876,

0, 0, 1);

Mat distCoeffL = (Mat_(5, 1) << -0.28095, 0.0255745, 0.00122226, -0.000137736, 0.162946);

/*

事先标定好的右相机的内参矩阵

fx 0 cx

0 fy cy

0 0 1

*/

Mat cameraMatrixR = (Mat_(3, 3) << 532.782, 0, 532.904,

0, 342.505, 233.876,

0, 0, 1);

Mat distCoeffR = (Mat_(5, 1) << -0.28095, 0.0255745, 0.00122226, -0.000137736, 0.162946);

/*计算标定板上模块的实际物理坐标*/

void calRealPoint(vector>& obj, int boardwidth, int boardheight, int imgNumber, int squaresize)

{

// Mat imgpoint(boardheight, boardwidth, CV_32FC3,Scalar(0,0,0));

vector imgpoint;

for (int rowIndex = 0; rowIndex < boardheight; rowIndex++)

{

for (int colIndex = 0; colIndex < boardwidth; colIndex++)

{

// imgpoint.at(rowIndex, colIndex) = Vec3f(rowIndex * squaresize, colIndex*squaresize, 0);

imgpoint.push_back(Point3f(rowIndex * squaresize, colIndex * squaresize, 0));

}

}

for (int imgIndex = 0; imgIndex < imgNumber; imgIndex++)

{

obj.push_back(imgpoint);

}

}

void outputCameraParam(void)

{

/*保存数据*/

/*输出数据*/

FileStorage fs("intrinsics.yml", FileStorage::WRITE);

if (fs.isOpened())

{

fs << "cameraMatrixL" << cameraMatrixL << "cameraDistcoeffL" << distCoeffL <<"cameraMatrixR" << cameraMatrixR << "cameraDistcoeffR" << distCoeffR;

fs.release();

cout << "cameraMatrixL=:" << cameraMatrixL <